Il filmato virale del dietro le quinte della versione live-action di “One Piece” è stato in realtà creato dall’intelligenza artificiale. Ecco come replicarlo in 4 passaggi.

Riesci a capire cosa c'è di falso in questo filmato dietro le quinte?

▲ Rumi, Zoey e Mira del gruppo femminile di cacciatrici di demoni Huntrix, e Jinu e Mystery del gruppo maschile Saja Boys. Link al video: https://youtube.com/shorts/WpjfwHqg1R0

Nel video, gli attori indossano costumi squisiti, interagiscono con lo staff sul set e si preparano per le riprese; le telecamere, le luci, gli attori e gli assistenti sono tutti impegnati.

È stata questa clip "trapelata" di 35 secondi a diventare rapidamente virale sui social media e il video correlato su YouTube è stato riprodotto oltre 10 milioni di volte.

Solo alla fine alcuni utenti hanno scoperto che l'intero set non esisteva affatto e che il video era stato realizzato interamente da un'intelligenza artificiale. Inoltre, era riuscito a ingannare con successo i fan di tutto il web.

Gli attuali video realizzati con l'intelligenza artificiale non dovrebbero essere solo in grado di girare brevi scene drammatiche, ma anche di catturare il dietro le quinte della troupe.

Il motivo della sua viralità, oltre all'assenza di un'intelligenza artificiale riconoscibile, è la popolarità della proprietà intellettuale stessa. Si tratta della serie animata "K-Pop Demon Hunters", presentata in anteprima su Netflix a giugno e diventata un successo globale, segnando il primo successo al botteghino di Netflix nei cinema.

I creatori hanno sfruttato questa popolarità e hanno prodotto una serie di cosiddetti video dietro le quinte. Gli attori in questi video hanno uno stile quasi identico ai personaggi dell'animazione, come se fossero davvero usciti dall'animazione.

Quando ho visto questo video per la prima volta, ho pensato che fosse reale, per non parlare dei fan entusiasti che discutevano se Netflix, vista la popolarità del cartone animato, stesse segretamente preparando una versione live-action. La verità è stata svelata: questo video era interamente generato dall'intelligenza artificiale.

▲ https://youtube.com/shorts/zZ8SmIbijGY

La fonte del video è Fantasoner, un blogger su YouTube con oltre 80.000 follower. Quasi tutti i suoi contenuti video aggiornati sono generati dall'intelligenza artificiale.

Molti internauti hanno commentato questi video dicendo: "È così reale che fa paura", ma alcuni fan che attendevano con ansia la versione live-action sono rimasti delusi quando hanno scoperto che si trattava di intelligenza artificiale.

Dopo che il video della visita dell'IA di "K-Pop Demon Hunters" è diventato virale, questo blogger ha aggiornato un gran numero di video "reali" dietro le quinte dell'IA e il numero di visualizzazioni è stato buono.

Come il video dietro le quinte del film live-action "One Piece".

▲ https://youtube.com/shorts/Ro4m0qWLPo4

Un commentatore ha addirittura affermato: "Se One Piece di Netflix fosse interpretato dalle persone presenti nel video dell'IA, sarebbe un enorme successo".

▲ Poster della versione live-action di One Piece, lanciata su Netflix due anni fa

Dietro le quinte del film live-action "Demon Slayer: Mugen Castle".

▲ https://youtube.com/shorts/-4n6Rgv6vtg

L'attacco dei giganti

▲ https://youtube.com/shorts/JvoSqO1Me6Q

L'uomo con la motosega

▲ https://youtube.com/shorts/D3qJdTwYE9g

Si può dire che questi adattamenti live-action di anime classici abbiano pienamente soddisfatto le aspettative dei fan, trasformando le fantasie di tutti in scene di vita reale.

Dopotutto, solo pochi giorni fa, un regista di Netflix ha confermato in un'intervista che il K-Pop Devil Hunter non avrà una versione live-action perché "lo stile e gli elementi comici dell'opera originale sono molto adatti all'animazione; è difficile immaginare questi personaggi nel mondo reale, sembrerebbe troppo realistico".

Ma ora è l'intelligenza artificiale a dover immaginare tutte queste cose inimmaginabili.

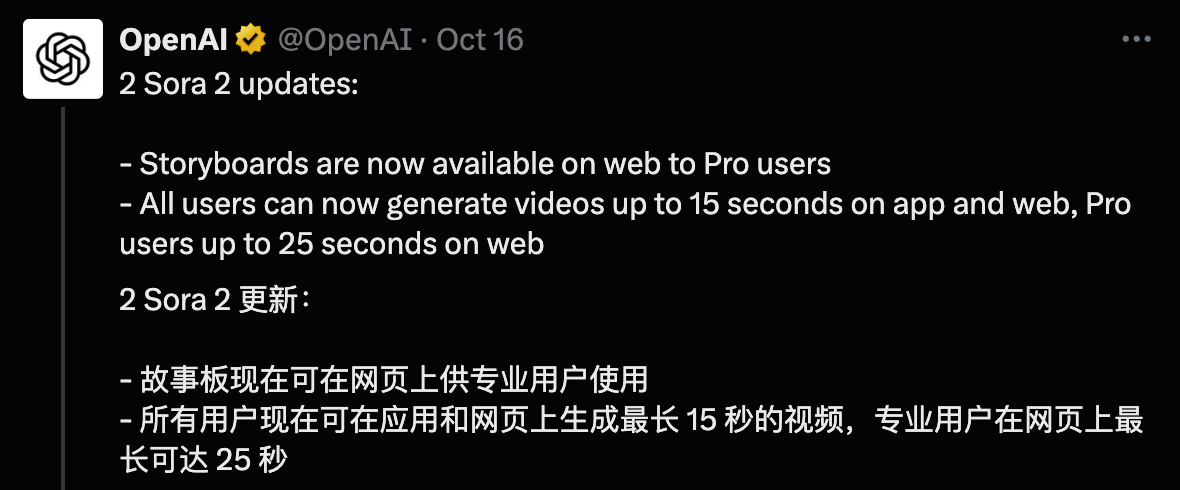

Da un lato, il modello di generazione video di Google Veo è stato appena aggiornato alla versione 3.1, che converte i materiali esistenti in video e aggiunge audio e strumenti di editing avanzati; dall'altro lato, Sora 2 ha annunciato che il tempo di generazione per gli utenti comuni sarà esteso a 15 secondi, mentre per gli utenti Pro raggiungerà i 25 secondi, e introduce anche una funzionalità storyboard.

Questi strumenti stanno riducendo costantemente il confine tra realtà e immaginazione. Abbiamo utilizzato anche nano banana, Veo 3.1 e Sora per cercare di generare un video di intelligenza artificiale dietro le quinte altrettanto realistico.

Promemoria: il contenuto è condiviso solo per scopi creativi. Si prega di utilizzare l'IA legalmente e nel rispetto delle normative, di rispettare il copyright originale e di non abusare dei video realizzati con l'IA.

Rivelati i filmati dietro le quinte della versione live-action di Nezha

Abbiamo scoperto che scegliere il tema giusto è fondamentale affinché questi video diventino virali. Immagini familiari possono inconsciamente renderci meno diffidenti nei confronti dei segnali legati all'intelligenza artificiale .

Abbiamo riassunto questo processo pratico secondo la strategia del blogger @AIWarper su X.

Seleziona un personaggio → Scegli un IP che sia familiare a tutti ma che non sia ancora stato adattato in una versione live-action.

Genera immagini fisse → Utilizza nano banana per generare foto di "attori" e "set".

Genera video → Utilizza Veo 3.1 (dal primo fotogramma al video) o Sora 2 (dall'annata al video) per generare clip dinamiche.

Modifica e sintesi → Aggiungi suono ambientale dal vivo, musica di sottofondo e correzione del colore, quindi modifica in uno stile "trapelato".

Quindi il primo passo è decidere cosa vogliamo riprendere.

Ad esempio, se c'è un'opera anime che ti piace molto, ma non è ancora stata adattata in un film o in una versione live-action, puoi tranquillamente considerarla come un casting per un romanzo che ti piace.

Qui abbiamo scelto "Nezha". Dato che tutti producono opere di animazione straniere, sceglieremo un classico IP nazionale.

Fase 2: Generare "immagini fisse" di personaggi (Strumento: nano banana)

In generale, è più facile trovare una persona reale che interpreti il cosplay del personaggio . Invia una foto del cosplayer con gli abiti del personaggio a nano banana, con la dicitura "Una foto spontanea di un'attrice sul set, completamente in costume, seduta su una sedia. Sta discutendo le battute con il regista, con uno schermo verde sullo sfondo".

Dato che non ci sono immagini di cosplay, potremmo valutare di far generare prima un "attore" a nano banana.

Estrai costume -> Trova un attore (o generane uno) -> Posiziona costume -> Posiziona l'attore che indossa il costume del personaggio sul luogo delle riprese

I suggerimenti per i prompt sono gli stessi che abbiamo condiviso in precedenza per il gioco del coltivatore malvagio. Prova a usare parole chiave come aspetto, acconciatura, stile di abbigliamento, umore e illuminazione. Ad esempio, "Una donna cinese di 20 anni con lunghi capelli neri e uno sguardo determinato, che indossa una giacca argentata futuristica e un'illuminazione sensibile alla luce".

Fonte dell'immagine: https://x.com/AIWarper/status/1971982288805417005

Poi, facciamo vestire l'attore con gli abiti del personaggio dell'anime. Il processo qui consiste nell'utilizzare la nano banana per estrarre gli abiti nella Figura 1, quindi generare una foto dell'attore che indossa gli abiti nella Figura 2. Utilizziamo quindi gli stessi prompt di prima per generare una foto del personaggio nella Figura 4 sul set.

A seconda della situazione è possibile aggiungere dettagli specifici, ad esempio non è necessario che venga visualizzato lo schermo verde.

Qui abbiamo trovato un'immagine fissa di Shen Gongbao e abbiamo utilizzato la nano banana per generare l'immagine di un uomo con addominali scolpiti (abbiamo trovato noi stessi un attore, ovviamente, uno bello) e gli abbiamo fatto indossare gli abiti del personaggio.

▲Completa le parole di richiesta, dalla Figura 1 alla Figura 2: Estrai i vestiti di questo personaggio animato; Figura 3: Genera un bell'uomo cinese con otto muscoli addominali, di circa 20 anni e un'altezza di 185 cm; Figura 2 + Figura 3 alla Figura 4: Fai indossare alla persona nella Figura 3 i vestiti nella Figura 2;

Figure 4 e 5: Riprese spontanee reali sul set. L'impostazione generale della scena e l'atmosfera: un grande studio davanti a uno schermo verde, con impianti di cavi, ventilatori e macchine del fumo in fase di test. Metà del set è costituito da rocce create in computer grafica e metà da una piattaforma di pietra finta. L'illuminazione è una fredda luce verde chiave con fiamme rosso-arancio che si riflettono sullo sfondo (richiamando gli effetti fiamma di Nezha). Si possono vedere cavi, ventilatori, bracci della telecamera e monitor sul set che mostrano le riprese più recenti. Stato del personaggio: l'attore (il personaggio nell'immagine caricata) indossa il suo elaborato costume nero e oro, mentre si sta truccando e pettinando, la cui messa a punto non è ancora completa. Sulla fronte e sulle tempie vengono applicati dei patch per gli effetti speciali. È seduto sul bordo di una piattaforma rialzata, sussurrando al regista l'"angolo di sghignazzo" del personaggio e il ritmo dei suoi movimenti. Il truccatore usa un piccolo pennello per ritoccare gli angoli degli occhi, mentre il team degli effetti speciali regola gli effetti di luce sulla fronte. Sullo sfondo, qualcuno sta preparando l'attrezzatura metallica: il braccio si solleva lentamente e le corde si tendono.

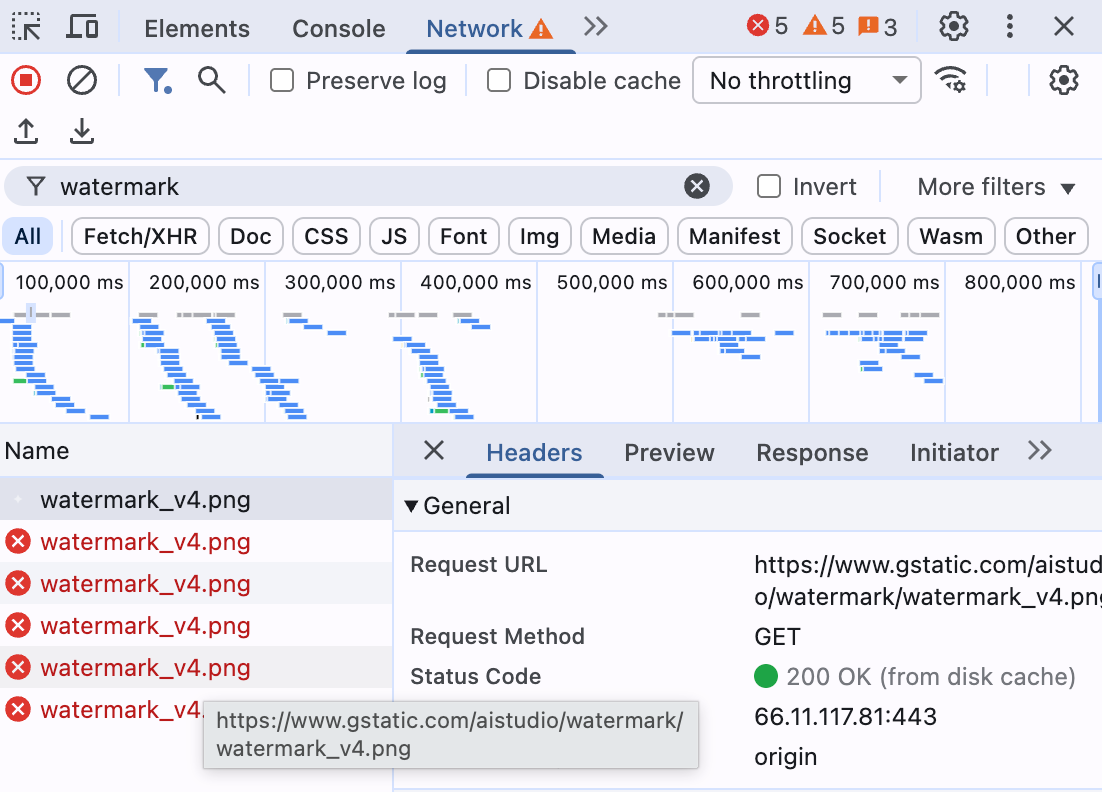

Ecco un piccolo consiglio : se in seguito non vuoi ritagliare o rimuovere la filigrana Gemini nell'angolo in basso a destra, puoi procedere in due modi:

1. Metodo F12 del browser: utilizza Google AI Studio. Apri la Modalità Sviluppatore del browser (F12), fai clic su Rete e inserisci "filigrana" nel campo Filtro. Tieni aperto l'ispettore e genera le immagini normalmente finché non appare un collegamento con una filigrana. Fai clic con il pulsante destro del mouse e seleziona Blocca. Le immagini successive saranno prive di filigrana.

Dopo aver bloccato l'accesso al dominio, le immagini generate da AI Studio non conterranno più la filigrana Gemini. Tuttavia, gli utenti dovranno comunque rispettare le normative sull'utilizzo delle immagini Gemini e indicare che le immagini o i video in questione sono generati dall'intelligenza artificiale quando li distribuiscono online.

2. Metodo API: è anche possibile ottenere immagini senza filigrane utilizzando direttamente l'API del modello nano banana e richiamandola tramite strumenti come Cherry Studio.

Abbiamo utilizzato Nano Banana per generare diverse immagini degli attori sul set e i risultati sono stati molto realistici. Dopo aver ottenuto le foto sul set, abbiamo continuato a utilizzare Veo 3.1 o Sora per convertire le immagini in video.

Tuttavia, Sora 2 presenta attualmente un problema: non supporta il caricamento di immagini realistiche di persone. Questo è probabilmente il modo di OpenAI di rispondere alle recenti critiche contro Sora 2 per aver generato vari video parodia.

Il terzo passaggio consiste nell'inserire l'immagine nel modello di generazione video.

Inizialmente abbiamo provato a utilizzare Veo 3.1 per generarlo. Le parole di input sono state controllate in pochi secondi, ottenendo un controllo perfetto dell'obiettivo.

▲ Segnale: Un video dal set reale, con la troupe che si prepara per le riprese. 0:00–0:04 (Preparazione della scena) Inquadratura con zoom grandangolare, il cameraman segue, con la telecamera puntata sull'attore. Sullo sfondo, possiamo vedere assistenti che spostano oggetti di scena, macchine del fumo che testano la nebbia e regolazioni dei cavi. 0:04–0:08 (Primo piano del personaggio) Il truccatore si sta truccando le sopracciglia. L'attore alza lo sguardo verso il regista, sorride e dice: "Questa volta sarò un po' più sinistro". Il regista annuisce, indicando la posizione della telecamera con uno storyboard. La telecamera trema leggermente e si sentono le voci degli attori.

Proseguendo con lo stesso procedimento, possiamo ottenere foto e video del dietro le quinte di Ao Bing e Nezha. Montandoli insieme, possiamo affermare in modo convincente: "Il casting per il film live-action di Nezha è stato finalizzato e le riprese del dietro le quinte sono state pubblicate".

Infine, aggiungi la musica nel software di editing, esegui alcune semplici modifiche e ottieni il prodotto finito.

Ogni passaggio prevede l'estrazione di carte, e più dettagliate sono le istruzioni, migliori saranno i risultati. Il più delle volte, dipende dall'"umore" del modello.

Il nostro suggerimento è di aggiungere " Riprese dietro le quinte dal set del film live-action " prima delle parole chiave generate dal video. Dopo un confronto approfondito, il modello sarà in grado di gestirlo meglio.

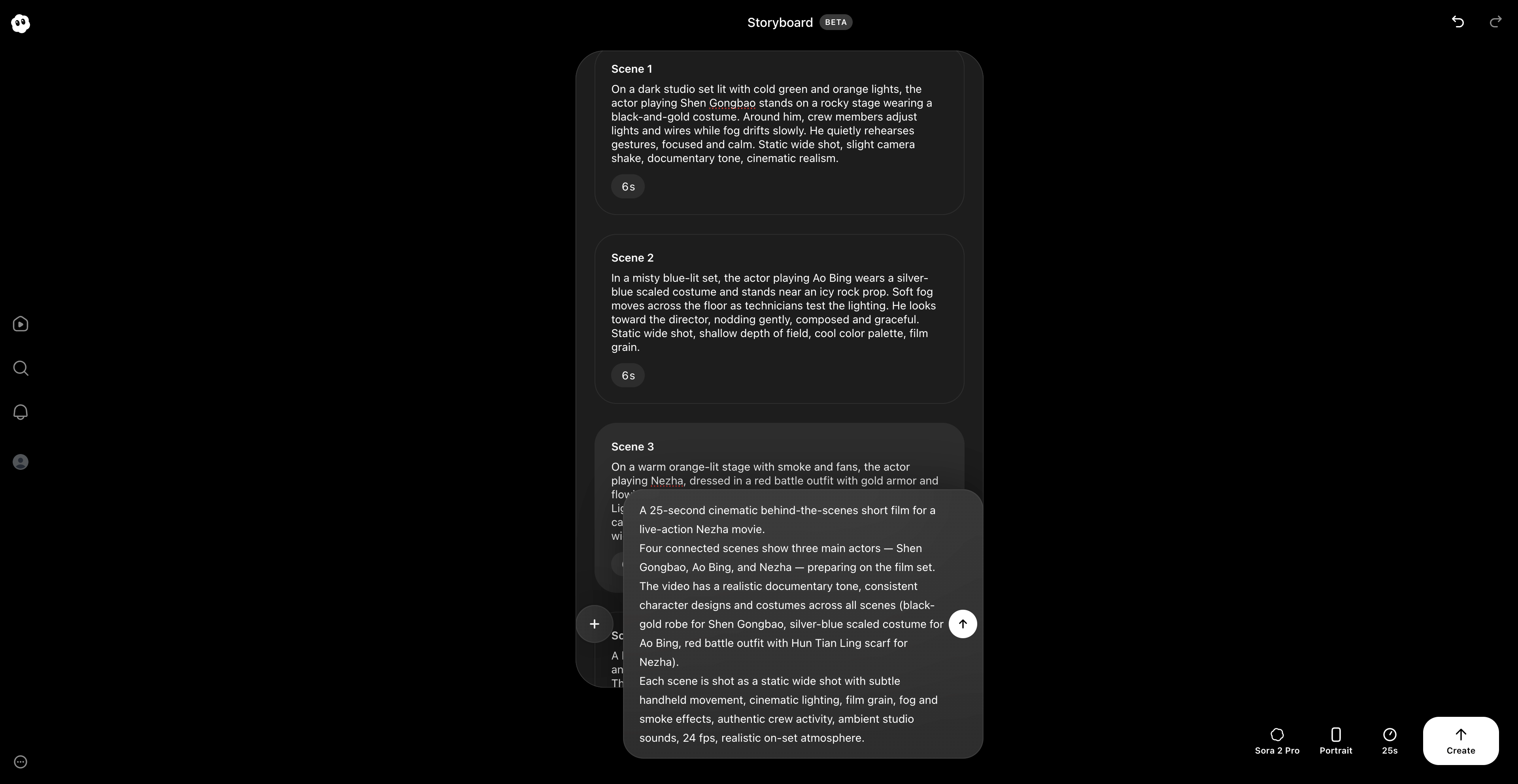

Per quanto riguarda la situazione in cui Sora 2 non riusciva a gestire personaggi realistici, abbiamo provato a usare le "Guest Stars" e la funzionalità storyboard aggiornata di Sora 2 per generarli direttamente inserendo parole di prompt.

▲ Funzione storyboard Sora, che può creare più scene e modificare la durata di ciascuna scena

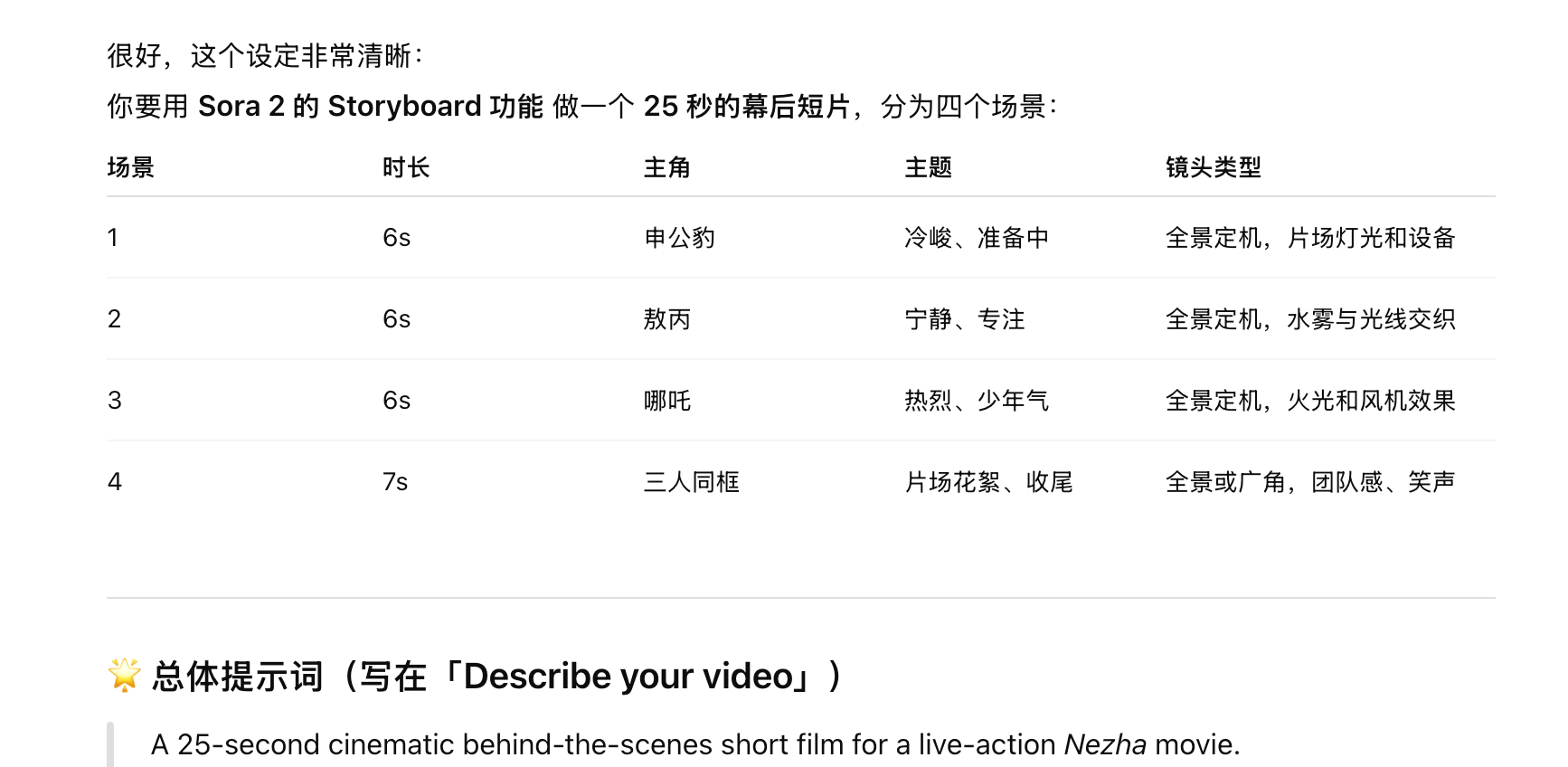

Qui abbiamo creato 4 scene. Le prime tre sono riprese dietro le quinte di Shen Gongbao, Ao Bing e Nezha, ciascuna della durata di 6 secondi. L'ultima è un video dietro le quinte dei tre attori insieme, della durata di 7 secondi, per un totale di esattamente 25 secondi.

▲Le parole richieste vengono completate da ChatGPT

La caratteristica unica di Sora è il suo ambiente generale, che ricorda più un vero set cinematografico. Veo 3.1, d'altra parte, è limitato dall'input del fotogramma iniziale, il che gli lascia un margine limitato per l'espressione creativa. Pertanto, l'immagine di input iniziale è uno dei passaggi più cruciali per ottenere un elevato grado di realismo nel video risultante della visita al set.

Al momento, gli iscritti a ChatGPT Pro non vedranno più la filigrana di Sora quando utilizzano Sora, sia con il modello Sora 2 che con quello Sora 2 Pro. Questo facilita ulteriormente la diffusione di questi video generati dall'intelligenza artificiale sui social media.

Sembra che ogni tanto diventi virale un video di intelligenza artificiale, dai vlog sui viaggi nel tempo in prima persona, ai filmati delle telecamere di sorveglianza notturne, al Re delle nevi contro l'Oriental Pearl Tower, agli adattamenti classici di vari film e serie televisive, fino ai filmati odierni dietro le quinte dell'intelligenza artificiale.

Sembra che la nostra accettazione dei video basati sull'intelligenza artificiale aumenterà gradualmente con ogni nuovo video.

Penso che con più momenti "Wow, si può giocare così!", i video basati sull'intelligenza artificiale diventeranno gradualmente il nostro nuovo strumento di espressione creativa, proprio come le fotocamere stanno iniziando a sostituire i pennelli.

Per riprodurre il video nell'articolo, vai al link originale

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFaner: iFaner (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.