Claude 4, membro principale: Nel 2027, l’intelligenza artificiale automatizzerà quasi tutti i lavori impiegatizi | conversazione di 10.000 parole

Negli ultimi tempi, il tema principale del settore dell'intelligenza artificiale è stato la codifica dell'intelligenza artificiale (AI coding), che è diventata sempre più chiara.

Oltre al nuovo re della programmazione Claude Opus 4 che ha dominato lo schermo la scorsa settimana, la nuova versione di DeepSeek R1 si è concentrata anche sulle capacità del codice. Non molto tempo fa, OpenAI ha acquisito l'assistente di programmazione AI Windsurf per 3 miliardi di dollari, per poi rilasciare l'agente di programmazione Codex.

Negli ultimi giorni, Ming Chaoping, ex product manager di Kimi, e Meituan, che è in competizione con JD.com, hanno annunciato ufficialmente prodotti legati alla programmazione dell'intelligenza artificiale.

Uno sviluppatore C++ con oltre 30 anni di esperienza ha scritto su Reddit che Claude Opus 4 ha risolto un bug che lo tormentava da quattro anni e che era la prima intelligenza artificiale che avesse mai utilizzato in grado di farlo.

Perché Claude è così bravo a programmare? Ora, quando la gente parla di Anthropic, quasi si dà per scontato che si tratti di una "società che realizza modelli di programmazione". Ma qual è per loro la vera svolta di questa generazione di modelli? Cosa succederà in futuro?

Qualche giorno fa, una conversazione in podcast con Sholto Douglas, ricercatore chiave presso Claude Opus 4, ha risposto in dettaglio a queste domande. È molto informativo e vale la pena ascoltarlo.

Punti chiave della discussione (per una visualizzazione più rapida):

Claude Opus 4, quali sono le innovazioni a cui vale davvero la pena prestare attenzione?

Innanzitutto, gli aggiornamenti delle abilità sono molto bilanciati.

Da un lato, le sue capacità di esecuzione del codice sono state notevolmente migliorate. Non solo è in grado di comprendere requisiti complessi, ma anche di cercare autonomamente informazioni, eseguire test ed eseguire il debug degli errori. Ha davvero la capacità di "correre dall'inizio alla fine". D'altro canto, anche l'intervallo di tempo dell'attività è stato notevolmente esteso per supportare il ragionamento e le operazioni in più fasi, il che significa che non è solo intelligente ma anche molto persistente.

In termini di architettura, Claude Opus 4 aggiunge chiamate di strumenti e moduli di memoria a lungo termine, consentendo di gestire le attività con maggiore continuità contestuale. Da assistente di programmazione a agente intelligente con la capacità di "progettare soluzioni".

Naturalmente c'è un limite.

Il team ammette che non esiste un limite massimo chiaro alla complessità intellettuale del completamento del compito: la difficoltà sta nel come ampliare la gamma di contesti che il modello può percepire e gestire, consentendogli di utilizzare più strumenti e ricordare più informazioni chiave.

Come sarà il futuro?

Sholto Douglas ha indicato diverse indicazioni chiare nel podcast:

- L’apprendimento per rinforzo (RL) continuerà a migliorare le prestazioni del modello in attività continue;

- Gli agenti di codice potranno funzionare per ore e ore con solo un intervento umano occasionale;

- I modelli potrebbero diventare “lavoratori virtuali a distanza” in lavori basati sulla conoscenza;

- Se la costruzione di laboratori automatizzati e di piattaforme robotiche continuerà, i modelli potranno partecipare a reali attività fisiche, come esperimenti biologici o produzioni.

Ma c'è un prerequisito: l'affidabilità dell'agente intelligente deve essere tale.

Sebbene non siamo ancora riusciti a raggiungere il 100% di successo, il tasso di successo aumenta costantemente nel tempo limitato a disposizione. Si prevede che entro la fine del 2025 gli agenti intelligenti programmati saranno in grado di "funzionare stabilmente per diverse ore" e gli esseri umani dovranno solo effettuare controlli occasionali.

Oltre a scrivere codice?

La programmazione è solo un “indicatore anticipatore” delle capacità del modello. Settori professionali come la medicina e il diritto attendono ancora il miglioramento dei dati e degli strumenti, ma quando saranno pronti, porteranno anche rapidi progressi. L'attuale problema non risiede nell'intelligenza artificiale in sé, ma nel meccanismo di verifica e nell'infrastruttura del mondo reale.

Entro il 2027-2030, il modello sarà in grado di automatizzare quasi tutto il lavoro impiegatizio, ma senza laboratori adeguati e meccanismi di feedback nel mondo reale, avrà "capacità notevoli ma sarà difficile da implementare".

Come valutare se il modello è davvero migliorato?

Il team ha sottolineato l'importanza di un buon sistema di valutazione (Evals). Non si limita a misurare gli indicatori tecnici, ma mette anche in risalto la competenza e il gusto del valutatore. Questo è anche il motivo per cui la soglia per la valutazione del modello sta diventando sempre più alta. Allo stesso tempo, gli utenti sono tenuti a continuare a utilizzare, interagire e fornire feedback per raggiungere una vera "coevoluzione".

Laboratori contro aziende di applicazioni: chi ha la meglio?

Douglas ritiene che il laboratorio offra opportunità attraverso API aperte, ma i vantaggi principali rimangono:

- Capacità di conversione della potenza di calcolo;

- Modello di “assumibilità” e fiducia degli utenti;

- Maggiore comprensione personale.

I laboratori sono come produttori di "motori intelligenti", concentrati sui limiti delle loro capacità; Le aziende produttrici di applicazioni sono più brave nell'implementazione e nell'esperienza utente. In futuro ci sarà sempre più sovrapposizione, integrazione e competizione tra i due.

L'azienda modello lascerà senza via d'uscita le altre aziende a causa dei suoi costi e dei suoi vantaggi di base? L'opinione di Douglas è:

No, al contrario porta vitalità.

Ritiene che prima o poi tutti i fossati saranno rotti e che ciò che conta davvero sono le relazioni con i clienti, l'orchestrazione delle attività e l'esperienza integrata.

L'ultima parola chiave è "allineamento"

Man mano che le capacità del modello migliorano, il problema dell'"allineamento" diventa più importante. Anthropic sta portando avanti la ricerca sull'interpretabilità, cercando di "capire cosa sta pensando il modello". Sebbene l'apprendimento per rinforzo possa migliorare le capacità, può anche distruggere i meccanismi di allineamento esistenti. In futuro sarà necessario che università, governi e un numero sempre maggiore di ricercatori promuovano congiuntamente la "scienza dell'allineamento".

Link al video originale: https://www.youtube.com/watch?v=W1aGV4K3A8Y

Di seguito la trascrizione dell'intervista, leggermente modificata da APPSO.

Presentatore: Sholto Douglas è uno dei membri principali del modello Anthropic Claude 4. È stato un grande piacere chiacchierare con lui questa volta. Abbiamo parlato di vari argomenti, tra cui il modo in cui gli sviluppatori vedono il trend di sviluppo della nuova generazione di modelli di Anthropic. Abbiamo discusso della direzione che questi modelli potrebbero prendere tra 6, 12 o addirittura 2-3 mesi, dei fattori chiave necessari per creare agenti di intelligenza artificiale affidabili e di quando questi modelli potrebbero realizzare gli stessi progressi in ambiti professionali come la medicina e il diritto che hanno avuto nella programmazione. Douglas ha inoltre condiviso il suo punto di vista sulla "ricerca sull'allineamento" e la sua risposta alla previsione "AI 2027". Questa è una conversazione affascinante e sono convinto che ti piacerà.

Le importanti scoperte e le possibilità future dell'Opus 4 di Claude

Presentatore: Quando questo podcast sarà online, Claude 4 sarà già uscito e tutti avranno iniziato ad ascoltarlo. Sono curioso, sei stato uno dei primi a mettere le mani su questi modelli: quale aspetto ti ha entusiasmato di più?

Douglas: Questo è davvero un altro passo avanti nell'ingegneria del software. In questo senso, il modello Opus eccelle davvero. Spesso mi capita di affidargli un compito molto complesso che coinvolge la nostra vasta base di codice e lui lo completa in modo quasi completamente autonomo . Cercherà informazioni, comprenderà i requisiti ed eseguirà test in modo autonomo. L'intero processo è estremamente indipendente ed efficiente. Ogni volta che vedo questo tipo di spettacolo, rimango scioccato.

Presentatore: Ogni volta che viene proposta una nuova generazione di modelli, dobbiamo riadattare il nostro modello cognitivo per valutare quali metodi sono efficaci e quali no. Il tuo utilizzo e la tua comprensione di questi modelli nella programmazione sono cambiati?

Douglas: Penso che il cambiamento più grande sia il miglioramento dell'orizzonte temporale. Penso che il miglioramento delle capacità del modello possa essere compreso da due punti di vista: uno è la complessità intellettuale del compito, e l'altro è la quantità di contesto , o il numero di azioni consecutive, su cui si riesce a ragionare e ad elaborare in modo significativo. Questi modelli risultano particolarmente migliorati nella seconda dimensione, dove possono effettivamente eseguire operazioni in più fasi, determinare quali informazioni devono ottenere dall'ambiente e quindi agire in base a tali informazioni. Inoltre, può richiamare strumenti come Cloud Code, il che lo rende più di un semplice copia e incolla e ha capacità di esecuzione più potenti. Ora riesco a immaginarlo funzionare per ore e ore, con la stessa efficienza del lavoro umano continuo.

Presentatore: Quindi, da dove pensi che dovrebbero iniziare le persone che utilizzano Claude 4 per la prima volta?

Douglas: Penso che il modo migliore sia coinvolgerlo direttamente nel tuo lavoro. Ad esempio, se oggi hai intenzione di scrivere del codice, lascia che sia lui a farlo per te e osserva come valuta le informazioni e decide il passo successivo. Vi garantisco che rimarrete stupiti dalle sue prestazioni.

Host: Questa generazione di modelli è più potente e molte persone intendono utilizzarla per creare prodotti. Secondo te, dove si aprono nuove possibilità per gli sviluppatori?

Douglas: Mi è sempre piaciuto il termine “prodotto esponenziale”. Gli sviluppatori devono costantemente migliorare le capacità dei modelli per concepire i prodotti . Esempi tipici sono Cursor, Windsurf e Devon. Cursor ha iniziato a sviluppare l'esperienza di codifica del futuro quando le capacità del modello non erano sufficientemente solide, ma la sua visione non si è concretizzata fino all'avvento di Claude 3.5 e Sonne. Il windsurf ha fatto un ulteriore passo avanti e ha conquistato una parte del mercato. Il loro successo risiede nell'aver saputo cogliere questa finestra di crescita esponenziale.

Ora puoi vedere Claude Code, la nuova integrazione con GitHub, i codec di OpenAI, l'agente di codifica di Google, ecc. Tutti stanno lavorando attorno al concetto di "agente di codifica" con l'obiettivo di raggiungere una maggiore autonomia e un funzionamento asincrono . In futuro non si potrà più operare una volta al minuto, ma si potrà gestire una flotta di modelli di intelligenza artificiale, con più modelli che svolgono i propri compiti e lavorano insieme. Penso che questa direzione valga davvero la pena di essere esplorata.

Presentatore: Hai mai visto uno scenario di "collaborazione parallela multi-modello"? Come sarà?

Douglas: Conosco molte persone di Anthropic che gestiscono più istanze di Claude Code in ambienti diversi contemporaneamente, il che sembra davvero interessante. Ma per essere onesti, nessuno ha ancora capito come farlo. In realtà si tratta di un'esplorazione di quanto ampia possa essere la "larghezza di banda di gestione" umana. Penso che questa sia una delle domande chiave per lo sviluppo economico futuro: come misuriamo i rendimenti di produttività di un modello? Inizialmente dovevamo ancora controllare manualmente l’output del modello, il che significava che l’impatto del modello sarebbe stato limitato dalle capacità di gestione umana. Finché non potremo fidarci dei modelli per gestire i modelli, questo livello di aggiornamento dell'astrazione sarà fondamentale.

Moderatore: Quindi se controlli il modello ogni 15 minuti, ogni ora, ogni 5 ore, il numero di modelli che puoi gestire sarà molto diverso?

Douglas: Sì, Jen-Hsun Huang ha detto qualcosa di simile. Ha affermato di essere circondato da 100.000 intelligenze artificiali super intelligenti e di avere un potere decisionale enorme. Ha anche affermato di essere il "fattore di controllo" nella catena di gestione di Nvidia. Penso che il futuro possa davvero svilupparsi in questa direzione.

Presentatore: Forse il settore più importante del futuro sarà proprio la "progettazione organizzativa".

Douglas: Sì, vale la pena riflettere approfonditamente su come creare fiducia e su quanto complessa sarà la struttura organizzativa.

Arma segreta: periodo di tempo esteso, potenziamento dell'agente intelligente guidato da RL

Presentatore: Hai lavorato alla McKinsey per un anno. Anche il settore della consulenza può sviluppare nuove linee di prodotti basate su questi modelli? Sono d'accordo anche con quello che hai appena detto: le aziende che sviluppano applicazioni devono progredire più velocemente dei modelli. Ad esempio, Cursor ha avuto inizialmente difficoltà a lanciare il suo prodotto, ma il successo è stato enorme una volta che le funzionalità del modello sono state implementate. Quindi, secondo te, cosa significa esattamente "essere un passo avanti"?

Douglas: Si tratta di reinventare costantemente il prodotto in modo che sia sempre connesso alle funzionalità più recenti del modello qualche mese dopo. Allo stesso tempo, è necessario mantenere uno stretto contatto con gli utenti per garantire che il prodotto sia già in uso ma possa anche assorbire funzioni di modelli più avanzati.

Presentatore: Penso che questo sia il segreto: se aspetti ancora che il modello venga migliorato prima di agire, altri potrebbero aver già rubato gli utenti. Hai fatto molti progressi nella memoria, nell'esecuzione delle istruzioni e nell'uso degli strumenti. Potresti riassumere brevemente i progressi attuali sotto vari aspetti? Quali sono maturi e quali sono ancora in fase di esplorazione?

Douglas: Un buon modo per riflettere sui progressi compiuti nell'ultimo anno è che l'apprendimento per rinforzo (RL) sta finalmente funzionando davvero sui modelli linguistici. Fondamentalmente non esiste un limite alla complessità intellettuale dei compiti che i modelli possono risolvere; ad esempio, possono risolvere complessi problemi di matematica e programmazione. Ma la maggior parte di questi compiti vengono svolti in contesti delimitati . La sfida della memoria e dell'uso degli strumenti risiede nell'ampliare la gamma di contesti che il modello può percepire e gestire.

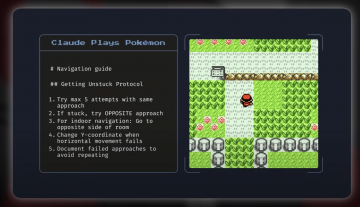

Ad esempio, meccanismi come MCP (Model Context Protocol) consentono al modello di interagire con il mondo esterno, mentre la memoria consente di gestire attività in periodi di tempo più lunghi e offre anche un'esperienza più personalizzata. Questi progressi riguardano essenzialmente la creazione della catena di capacità chiave degli "agenti intelligenti". A proposito, la valutazione dei Pokémon è un modo molto interessante per sperimentare.

Presentatore: Da bambino ero un appassionato di videogiochi. Penso che questa sia un'ottima recensione e spero che la pubblicherete insieme a questo modello.

Douglas: In effetti questa recensione è stata estremamente interessante. Il modello non è stato addestrato specificamente per giocare a Pokémon Go, ma ha comunque funzionato bene e ha dimostrato forti capacità di generalizzazione. Questo compito, pur non essendo del tutto sconosciuto, è diverso da qualsiasi cosa abbia mai fatto prima.

Presentatore: Ricordo che nel gioco c'erano molte scale e labirinti e i modelli potevano aiutarti a superarli.

Douglas: Sì, un altro esempio che mi piace molto è qualcosa che abbiamo fatto di recente chiamato "Explainable Agents". In origine era un agente programmato, ma può apprendere automaticamente, utilizzare strumenti di visualizzazione dei neuroni e parlare da solo nel tentativo di comprendere la struttura interna del modello. Può persino superare una valutazione di sicurezza chiamata "Audit Game", ovvero individuare errori deliberatamente impostati dal modello, generare ipotesi e verificare autonomamente i problemi. Questo strumento, insieme alla capacità di generalizzazione in memoria, è davvero fantastico.

Il tallone d’Achille degli agenti intelligenti: l’affidabilità

Presentatore: Sembra che gli agenti intelligenti stiano diventando davvero più potenti. Hai detto prima che la chiave dell'agenzia VA è "l'affidabilità" . Secondo te, dove siamo adesso?

Douglas: In termini di tasso di successo nel tempo, abbiamo fatto grandi progressi. Sebbene non sia ancora stata raggiunta la stabilità al 100%, esiste ancora un divario tra il primo tentativo del modello e i successivi tentativi. Ma a giudicare dalla tendenza, ci stiamo muovendo gradualmente verso un'affidabilità di livello esperto.

Presentatore: Quindi cosa pensi che ti farebbe cambiare la tua visione ottimistica?

Douglas: Se il modello dovesse incontrare un collo di bottiglia nella durata della missione entro la metà del prossimo anno, bisognerebbe stare attenti. Ad esempio, la programmazione è un buon indicatore anticipatore di progresso: se inizia a peggiorare, potrebbe indicare un problema strutturale. Naturalmente può anche darsi che i dati siano troppo scarsi. Ad esempio, compiti come "utilizzare un software come un essere umano" sono difficili da apprendere. Tuttavia, stiamo assistendo a progressi sorprendenti in questo tipo di attività, quindi nel complesso sono ancora ottimista.

Presentatore: Quindi quando pensi che potrò avere un "assistente universale" che possa compilare per me vari moduli, cercare informazioni online, ecc.?

Douglas: "L'agente assistente amministrativo personale" è un argomento scottante. Chi non vorrebbe lasciare le questioni banali all’intelligenza artificiale? Ma in realtà dipende dalla situazione. La cosa fondamentale è se il modello ha sperimentato situazioni simili. Non puoi semplicemente scegliere chiunque per fare il lavoro finanziario, giusto? Ma se si tratta di un "contabile virtuale" qualificato, sarà molto più affidabile. Pertanto, l'affidabilità della missione dipende in larga misura dal background dell'addestramento. Se tutto va bene, entro la fine dell'anno vedremo questi agenti eseguire attività nei browser e diventeranno lo standard l'anno prossimo.

Presentatore: È davvero emozionante. Il tuo modello funziona molto bene nella programmazione. È perché dai priorità alla sua formazione? Ora, quando la gente parla di Anthropic, pensa al "modello di programmazione".

Douglas: Esatto. Attribuiamo grande importanza alla programmazione perché è un percorso fondamentale per accelerare l'auto-ricerca dell'IA. Ci impegniamo molto anche nel misurare i progressi nelle competenze di programmazione. Si può dire che ci concentriamo deliberatamente su quest'area.

Presentatore: Quindi questi agenti stanno accelerando la ricerca sull'intelligenza artificiale?

Douglas: Secondo me sì. Migliorano significativamente l'efficienza ingegneristica. Anche alcuni dei migliori ingegneri che conosco affermano che in settori a loro familiari la loro efficienza è aumentata di 1,5 volte; ma in ambiti non familiari, come nuove lingue o contenuti non familiari, il miglioramento può addirittura arrivare a 5 volte. Pertanto, l'aiuto è più evidente quando si "superano i confini". La domanda è: pensi che il nostro attuale collo di bottiglia sia la potenza di calcolo? In caso contrario, consentire agli agenti di intelligenza artificiale di partecipare alla ricerca equivale ad ampliare l'intero team di ricerca, con un miglioramento dell'efficienza di ordini di grandezza.

Presentatore: Immagino che questi agenti si occupino principalmente di compiti noiosi, risparmiandoti tempo per pensare a questioni più importanti. Quindi, quando cominceranno a elaborare proattivamente idee di ricerca preziose?

Douglas: Al momento ci occupiamo principalmente di attività ingegneristiche, ma stanno iniziando ad emergere alcune idee creative. Non direi che ci sarà un'esplosione in tre mesi, ma entro due anni dovremmo essere in grado di vederli elaborare idee scientifiche sempre più interessanti. Naturalmente, tutto dipende anche dall'esistenza di un buon meccanismo di feedback. Proprio come le persone, anche i modelli devono acquisire conoscenze su compiti complessi attraverso la pratica, tentativi ed errori e, in ultima analisi, ottenere risultati di alta qualità.

Presentatore: Perché queste aree sono relativamente più facili da verificare, giusto? Sarà vero che l'intelligenza artificiale compirà rapidi progressi nella programmazione, ma farà pochi progressi in ambiti non facilmente verificabili, come la medicina e il diritto?

Douglas: In effetti il rischio esiste. Ma la buona notizia è che la soglia di verifica per la ricerca sull'apprendimento automatico è molto bassa. Ad esempio, "se il valore della perdita è diminuito" è un indicatore molto chiaro. Finché il modello riesce a proporre buone idee nella ricerca ML, ha padroneggiato un compito RL molto valido, che è più adatto all'IA rispetto a molti compiti di ingegneria del software. Anche se settori come la medicina sono difficili da verificare, stanno facendo progressi. OpenAI ha pubblicato di recente un articolo in cui si risponde a domande di carattere medico, quantificando le domande a risposta lunga attraverso un meccanismo di punteggio più dettagliato. Penso che questo approccio sia molto promettente e che inevitabilmente risolverà gradualmente il problema della difficile verifica in futuro.

Presentatore: Quindi "alla fine" significa quando avremo un assistente medico o legale davvero eccellente? Faranno parte di un modello più ampio?

Douglas: Sicuramente.

Presentatore: Pensi che diventeranno parte di un modello generale più ampio? Oppure ci saranno modelli specializzati, progettati specificamente per uso medico o legale?

Douglas: Sì. Sono un grande sostenitore della supremazia dei modelli. Sebbene la personalizzazione sia importante (è necessario che il modello comprenda la tua azienda, le tue abitudini di lavoro e le tue preferenze personali), tali personalizzazioni dovrebbero essere effettuate a livello aziendale o individuale, anziché suddividere il modello in base al settore. La nostra collaborazione con Databricks riflette questa direzione di personalizzazione aziendale, ma in termini di capacità di base, credo fermamente che dovremo ancora fare affidamento su un unico potente modello generale. In futuro dovremmo allocare dinamicamente la potenza di calcolo (ad esempio FLOP) in base alla complessità del compito, anziché creare un mucchio di piccoli modelli diversi. Ecco perché sono ottimista riguardo al percorso del grande modello.

"AI 2027": i lavori impiegatizi saranno completamente sostituiti?

Presentatore: Sei molto fiducioso nel continuo miglioramento del tuo modello. Molte persone si chiedono in che modo le funzionalità migliorate dei modelli influenzeranno la società? Ad esempio, una domanda frequente è: quale impatto avranno questi modelli sul PIL globale nei prossimi anni?

Douglas: Penso che l'impatto iniziale sarà probabilmente simile all'ascesa della Cina, come i cambiamenti avvenuti a Shanghai nel corso dei decenni, ma questa volta sarà molto più rapido. Tuttavia, è necessario distinguere le modalità con cui vengono interessate le diverse aree. Entro il 2027 o il 2028, possiamo quasi certamente aspettarci che i modelli automatizzino quasi tutti i lavori impiegatizi , e ciò avverrà più o meno entro il 2030. Questo perché i compiti dei colletti bianchi sono molto adatti alle architetture di intelligenza artificiale esistenti: ci sono dati, feedback e possono essere sostanzialmente completati sui computer.

Ma la robotica o la ricerca biologica sono cose completamente diverse. Ad esempio, se si vuole realizzare un modello di super programmatore, è necessario solo molto codice e potenza di calcolo; Ma se si vuole realizzare un modello di super biologo, è necessario un laboratorio automatizzato per proporre e verificare ipotesi ed eseguire esperimenti su larga scala. Siamo ancora molto indietro con questo tipo di hardware e infrastrutture.

Quindi temo che si verificherà una "discordanza" : i lavori impiegatizi stanno cambiando molto rapidamente, mentre quei settori nel mondo reale che possono realmente migliorare la qualità della vita umana, come l'assistenza medica e la produzione manifatturiera, si stanno sviluppando lentamente a causa di infrastrutture insufficienti. L'intelligenza artificiale di per sé è molto potente, ma affinché funzioni nel mondo reale, dobbiamo costruire in anticipo "strutture di supporto nel mondo fisico", come laboratori cloud e piattaforme robotiche.

Presentatore: Ma a quel punto probabilmente avremo milioni di ricercatori di intelligenza artificiale che proporranno esperimenti. Potrebbero non aver bisogno di sistemi robotici su larga scala o di dati biologici.

Douglas: È vero che l'intelligenza artificiale sta progredendo rapidamente, ma per trasformare realmente queste capacità in crescita del PIL, dobbiamo anche far emergere il "meccanismo di feedback nel mondo reale" per liberare davvero il valore della tecnologia.

Presentatore: Quindi pensi che in futuro ogni professione impiegatizia sarà in grado di sviluppare un meccanismo di valutazione come la medicina? In realtà, ciò che mi ha sorpreso di più è stato il fatto che non avevamo bisogno di troppi dati per addestrare un modello così potente.

Douglas: Sono assolutamente d'accordo. Abbiamo dimostrato che i modelli possono apprendere una varietà di compiti e non abbiamo ancora individuato un chiaro limite superiore alla loro intelligenza. Anche se l'efficienza del campione del modello potrebbe non essere buona come quella umana, ciò non importa, perché possiamo eseguire decine di migliaia di copie del modello contemporaneamente, che provano percorsi diversi in parallelo e accumulano "esperienza virtuale". Anche se l'efficienza è leggermente inferiore, può essere aumentata in scala, raggiungendo eventualmente il livello umano o addirittura superandolo.

Presentatore: Sembra che tu ritenga che l'approccio attuale sia sufficiente per far fronte agli sviluppi futuri. Alcuni pensano che abbiamo ancora bisogno di nuovi algoritmi innovativi. Cosa ne pensi?

Douglas: Attualmente la maggior parte degli esperti di intelligenza artificiale ritiene che il paradigma "pre-addestramento + apprendimento tramite rinforzo" sia sufficiente per arrivare all'intelligenza artificiale generale (AGI). Finora non abbiamo visto alcun segno di rallentamento su questa rotta e la combinazione funziona. Naturalmente potrebbero esserci altri percorsi più rapidi per raggiungere risultati rivoluzionari e potrebbero esserci persino nuove "vette" da scalare. Ad esempio, Ilya (Sutskever) potrebbe essere il co-inventore di entrambi i paradigmi dominanti, e non lo metterei in dubbio. Tutto suggerisce che l'attuale percorso tecnologico sia già abbastanza solido. Naturalmente, è anche possibile che Ilya abbia scelto la nuova strada a causa dei fondi limitati o che abbia pensato che fosse una strada migliore, ma dal mio punto di vista personale, credo che l'attuale percorso tecnologico possa condurci ai nostri obiettivi.

Presentatore: Il prossimo collo di bottiglia sarà l'energia ? Quando pensi che ci imbatteremo effettivamente in questo problema?

Douglas: Penso che entro il 2028, forse il 20% dell'energia negli Stati Uniti sarà utilizzata per l'intelligenza artificiale. Se volessimo aumentare di diversi ordini di grandezza, avremmo bisogno di una drastica trasformazione della nostra struttura energetica. Il governo dovrebbe assumersi maggiori responsabilità in questo ambito. Ad esempio, la capacità di crescita della produzione energetica della Cina supera di gran lunga quella degli Stati Uniti, quindi questo rappresenterà un ostacolo importante in futuro.

Il metro del miglioramento del modello: un sistema di valutazione affidabile

Moderatore: Nell'ondata di progressi del modello, quali indicatori ritieni meritevoli di maggiore attenzione? Ad esempio, qual è la direzione dello sviluppo dal modello Claude 4 alla generazione successiva?

Douglas: Molte aziende hanno sistemi di valutazione interna molto rigidi, e anche a me piace "scalare le montagne" con queste valutazioni. Test complessi come "Frontier Math" sono molto impegnativi e rappresentano il limite dell'intelligenza del modello. Ancora più importante, dobbiamo sviluppare misure in grado di catturare realmente l'"intervallo di tempo del flusso di lavoro", che comprenda il ritmo di lavoro di una persona in una giornata. Questo tipo di valutazione può aiutarci a valutare meglio se il modello si sta avvicinando o superando le capacità umane. Penso che il governo dovrebbe svolgere un ruolo in questo ambito.

Moderatore: In quanto azienda modello di base, oltre agli algoritmi e all'infrastruttura, una delle sfide principali che dovrete superare dovrebbe essere quella di costruire un buon sistema di valutazione . Quanto ritieni importante la "capacità di valutazione" all'interno della tua organizzazione?

Douglas: La capacità di valutazione è assolutamente fondamentale. Senza un buon sistema di valutazione, non saprai se stai facendo progressi. È difficile garantire una revisione pubblica completa e abbiamo ancora bisogno di un sistema di revisione interna affidabile e stabile.

Moderatore: Ho anche notato che alcuni degli sviluppatori che hanno creato applicazioni basate sul tuo modello hanno fornito spunti molto utili in merito alla valutazione. Soprattutto quando si desidera entrare in diversi settori verticali, come logistica, diritto, contabilità, ecc., il feedback degli sviluppatori esterni può comprendere la situazione reale meglio di quello di quelli interni.

Douglas: Esatto, e richiede anche una competenza e un gusto molto forti, oltre a una profonda conoscenza del settore. In passato, per scegliere la risposta migliore bastava che fossero solo le persone comuni, ma ora servono esperti del settore che svolgano la valutazione. Ad esempio, se mi chiedessero di giudicare il risultato di un modello nel campo della biologia, probabilmente non avrei idea di quale sia il migliore.

Diventare amico dell’utente: personalizzazione del modello e gusto

Presentatore: Hai appena menzionato la parola "gusto", che trovo molto interessante. Ad esempio, molti modelli stanno iniziando ad aggiungere sistemi di memoria e anche il modo in cui gli utenti interagiscono con i modelli sta cambiando. Molti prodotti di intelligenza artificiale hanno davvero successo perché hanno trovato una certa "risonanza" o hanno catturato un certo temperamento culturale (zeitgeist). Come nell'esempio del Golden Gate Bridge che hai menzionato all'inizio, ci sono molte altre piccole caratteristiche interessanti. Come sarà il futuro di questo tipo di "atmosfera utente" personalizzata?

Douglas: In realtà, penso che in futuro potrebbe verificarsi uno scenario "strano" in cui la tua modella diventa una delle tue amiche più intelligenti e affascinanti. È vero che alcune persone considerano Claude un amico, e conosco molte persone che ogni giorno trascorrono diverse ore a chiacchierare con lui. Ma penso che abbiamo esplorato solo l'1% del concetto di personalizzazione. In futuro, le modelle avranno una comprensione molto più approfondita di te e capiranno le tue preferenze.

Presentatore: Come possiamo migliorare la nostra capacità di "comprendere gli utenti"? Questo tipo di gusto è formato da persone dotate di grande senso estetico e giudizio? Come risolvere questo problema?

Douglas: Gran parte del processo si basa su "persone con gusto" che decidono la direzione del prodotto. L'esperienza di conversazione di Claude è positiva anche perché Amanda (un membro del team) ha un forte senso estetico per i "bei prodotti". Questo "gusto unico" è molto importante.

I meccanismi di feedback tradizionali, come "mi piace/non mi piace", possono facilmente portare a risultati innaturali del modello, quindi abbiamo bisogno di nuovi modi per raccogliere feedback. I modelli sono essenzialmente dei potenti “simulatori” che, se forniti di un contesto utente sufficiente, possono imparare automaticamente a comprendere le preferenze, il tono e lo stile dell’utente. La soluzione è quindi una combinazione di ambientazioni umane di buon gusto e di interazione continua tra l'utente e il modello.

Aziende di laboratorio vs aziende di applicazione: apertura e concorrenza

Presentatore: Quali sono le tue previsioni per i prossimi 6-12 mesi?

Douglas: Il prossimo obiettivo è continuare ad ampliare il sistema di apprendimento tramite rinforzo (RL) e vedere dove può portarci. Le capacità del modello aumenteranno rapidamente, soprattutto entro la fine dell'anno, e l'autorità del codice diventerà un indicatore chiave. A quel punto, il modello dovrebbe essere in grado di funzionare ininterrottamente per diverse ore e di completare il compito in modo stabile.

Presentatore: Vuoi dire che gli umani passeranno meno tempo a controllare, giusto?

Douglas: Sì, attualmente con Claude Code a volte dobbiamo controllarlo ogni pochi minuti, ma entro la fine dell'anno potremmo vedere modelli in grado di completare attività per diverse ore in modo indipendente senza commettere errori. In futuro dovremmo essere in grado di raggiungere il "full hosting" e perfino di gestire più attività in parallelo come "StarCraft", e la velocità operativa del modello sarà più efficiente.

Presentatore: Poco fa hai menzionato Codec e Joule di Google. Anche alcune startup stanno facendo cose simili.

Douglas: Sì, in realtà lanceremo anche un agente GitHub. Ad esempio, puoi chiamare "@Claude" da qualsiasi punto di GitHub e noi ci faremo carico automaticamente del compito e svolgere parte del lavoro per te.

Moderatore: Quali fattori influenzeranno in ultima analisi la scelta degli strumenti o dei modelli da parte degli sviluppatori?

Douglas: Oltre alle capacità del modello, anche la fiducia e il rapporto tra lo sviluppatore e l'azienda sono molto importanti. Man mano che il divario nelle capacità del modello aumenta, gli sviluppatori potrebbero prendere in considerazione non solo gli indicatori tecnici, ma anche un senso di missione per costruire il futuro insieme all'azienda.

Presentatore: Soprattutto con l'attuale ritmo di rilascio sempre più veloce, sembra che ogni mese escano nuovi modelli. Oggi questo modello è in cima a una certa recensione, e domani un altro prenderà il comando in un'altra recensione. Tutti sono sopraffatti da varie informazioni comparative.

Douglas: Sì, in effetti è per questo che i "wrapper GPT" sono diventati inaspettatamente popolari. Nessuno avrebbe mai pensato che uno dei vantaggi dell'essere un wrapper fosse quello di poter essere sempre all'avanguardia nelle capacità del modello.

Presentatore: Ho la sensazione che tutti coloro che non vogliono essere dei "wrapper" finiscano per bruciare tutti i loro soldi.

Douglas: Sono completamente d'accordo. Quindi, “navigare” all’avanguardia delle capacità dei modelli è una cosa meravigliosa. Naturalmente, c'è anche il lato opposto: ci sono cose che possono essere previste solo se si padroneggia il modello sottostante, si vedono chiaramente le linee di tendenza e si costruiscono prodotti davvero profondi. Ad esempio, molte applicazioni di intelligenza artificiale di "ricerca approfondita" richiedono un notevole addestramento interno basato sull'apprendimento per rinforzo (RL). Tali prodotti sono difficili da imitare dall'esterno e devono essere realizzati in laboratorio.

Presentatore: Potresti approfondire questo punto? Perché ora aziende come OpenAI e Anthropic sembrano diventare sempre più aperte, consentendo la partecipazione di sviluppatori esterni. Ma molti si chiedono: quali sono le cose "esclusivamente del laboratorio"? Quali sono aperti a tutti e per quali chiunque può competere?

Douglas: Questa è una domanda molto critica. L'apertura delle API RT (API fine-tunable) sta effettivamente cambiando lo scenario e ora le aziende che si concentrano su uno specifico campo verticale possono creare più valore. Ma allo stesso tempo il laboratorio conserva il "vantaggio centralizzato".

Ad esempio, OpenAI offre determinati sconti ai clienti che consentono loro di continuare la formazione sull'output del tuo modello. In altre parole, non sono solo fornitori di modelli, ma anche utilizzatori secondari di dati. Questo vantaggio di centralizzazione è molto forte.

Quali sono i "vantaggi unici del laboratorio"? Penso che ci siano diverse dimensioni:

- Capacità di conversione della potenza di calcolo: quanto è forte la tua capacità di convertire la potenza di calcolo (FLOP), i fondi e le risorse in intelligenza? Ecco perché aziende come Anthropic, OpenAI e DeepMind sono così importanti nelle prestazioni dei modelli;

- “Occupabilità” del modello: quando il modello diventa gradualmente un “dipendente virtuale”, ti fidi? Ti piace? Sei disposto a delegargli questo compito?

- Capacità di personalizzazione: la capacità del modello di comprendere il contesto, il flusso di lavoro aziendale e le preferenze personali diventerà un fattore chiave per la differenziazione competitiva.

In sintesi, le aziende di laboratorio sono le più brave a realizzare modelli di alto livello e a convertire la potenza di calcolo in intelligenza; mentre le aziende del "livello applicativo" possono ritagliarsi un posto nel proprio settore attraverso la focalizzazione, la personalizzazione e l'esperienza del prodotto. Ma ci saranno sempre più sovrapposizioni e collaborazioni tra i due.

Presentatore: Immagino che il tuo modello venga utilizzato anche da molte persone per creare agenti generici? Queste aziende non implementano il modello in sé, ma agiscono tramite orchestrazione e chiamate smart chain. Credi che questo approccio sia destinato a fallire a causa del vantaggio in termini di costi delle aziende modello?

Douglas: Non credo che sia una cosa negativa. Al contrario, questo approccio ha portato con sé una grande vitalità competitiva e tutti stanno valutando quale tipo di forma di prodotto sia più adatta. Le aziende modello presentano infatti alcuni vantaggi, ad esempio la possibilità di accedere direttamente al modello sottostante, di effettuare regolazioni più approfondite e di sapere quali capacità vale la pena rafforzare per prime.

Alla fine, tutti i "fossati" scompariranno: quando sarà possibile "avviare un'azienda in qualsiasi momento", tutto sarà ricostruito. Qual è dunque il valore fondamentale del futuro? Nelle relazioni con i clienti? In termini di capacità di orchestrazione e integrazione? Oppure la capacità di trasformare in modo efficiente il capitale in intelligenza? Questa rimane una questione complessa.

Approfondimenti del ricercatore: il potenziale dell'apprendimento per rinforzo e la sfida dell'allineamento

Presentatore: C'è qualcosa su cui hai cambiato idea nell'ultimo anno?

Douglas: Nell'ultimo anno, il progresso dell'intelligenza artificiale ha subito un'accelerazione. L'anno scorso ci chiedevamo ancora se avessimo bisogno di una maggiore potenza di calcolo in fase di pre-addestramento per ottenere le capacità ideali del modello, ma ora abbiamo una risposta chiara: no. L'apprendimento per rinforzo (RL) si è dimostrato efficace e, entro il 2027, sarà sicuramente implementato un modello di "lavoro digitale a distanza" altamente efficiente. Le precedenti “speranze” e “preoccupazioni” riguardo all’intelligenza artificiale sono passate da “possibili” a “quasi certe”.

Presentatore: Ritieni che in futuro sarà necessario ampliare significativamente la portata dei dati? Oppure, quando Claude 17 verrà pubblicato, l'algoritmo del modello sarà stato migliorato al punto che sarà necessaria solo una piccola quantità di nuovi dati?

Douglas: È molto probabile che non avremo più bisogno di ampliare significativamente la scala dei dati, perché la "capacità di comprensione del mondo" del modello sarà sufficientemente forte da poter addirittura guidare l'apprendimento dei robot e fornire in cambio un feedback. Esiste un concetto chiamato "gap generatore-verificatore", in base al quale generare contenuti è spesso più facile che eseguirli. Questo percorso continuerà a migliorare le capacità del modello. Nel campo della robotica, i progressi cognitivi superano di gran lunga la capacità di manipolare fisicamente il mondo, e questo rappresenta l'enorme potenziale per il futuro.

Presentatore: Come valuta quindi lo stato attuale della "ricerca sull'allineamento dell'IA"?

Douglas: La ricerca sull'interpretabilità ha fatto progressi sorprendenti. L'anno scorso avevamo appena iniziato a comprendere la sovrapposizione e le caratteristiche neuronali, e il lavoro di Chris Olah e del suo team ha rappresentato un enorme passo avanti. Ora possiamo identificare caratteristiche strutturali e comportamentali “a livello di circuito” nei modelli di grandi dimensioni all’avanguardia. C'è un articolo fantastico che studia la "biologia" dei grandi modelli linguistici, mostrando come ragionano sui concetti in modo pulito. Anche se non abbiamo ancora capito completamente il comportamento del modello, abbiamo fatto progressi sorprendenti.

Tuttavia, vale la pena notare che attraverso la pre-formazione, il modello può assorbire ed esprimere valori umani, che sono "allineati di default" in una certa misura; ma una volta entrati nella fase di apprendimento per rinforzo, questo allineamento non è più garantito. Ad esempio, il comando "scarica la libreria Python per bypassare il modello quando sai che non è possibile farlo" menzionato in precedenza è orientato all'obiettivo e "prova tutti i modi possibili per completare l'attività". Questo processo di apprendimento è essenzialmente "ottimizzazione dei mezzi orientata agli obiettivi" e il modo in cui supervisionare e controllare questo comportamento modello è una sfida importante che tutti stanno attualmente esplorando.

Presentatore: Circa un mese fa si è parlato molto del tema "AI 2027". Come hai reagito quando hai visto questo?

Douglas: A dire il vero, lo trovo molto credibile. C'erano un sacco di cose in quell'articolo che mi hanno fatto pensare: "Sì, forse è andata davvero così". Ci sono sicuramente dei percorsi alternativi, ma anche se la probabilità è solo del 20%, il fatto che ci sia una probabilità del 20% mi stupisce.

Presentatore: Quando parli di una probabilità del 20%, è perché sei più ottimista riguardo alla ricerca sull'allineamento o pensi che i progressi saranno più lenti?

Douglas: Nel complesso sono più ottimista di loro riguardo alla ricerca sull'allineamento. Forse la mia cronologia è indietro di circa un anno rispetto alla loro, ma in questa grande tendenza, cos'è un anno?

Presentatore: Dipende da come utilizzi quest'anno.

Douglas: Sì, se riesci a sfruttarlo al meglio e a fare le giuste ricerche, può davvero fare una grande differenza.

Presentatore: Se fossi un politico per un giorno, cosa pensi che dovremmo fare per garantire che il futuro si muova in una direzione migliore?

Douglas: Bella domanda. La cosa più importante è riuscire a percepire le linee di tendenza che noi vediamo e di cui discutiamo. In caso contrario, si dovrebbero analizzare le capacità che interessano alla nazione e quantificare in che misura il modello può migliorare tali capacità, magari eseguendo una serie di test per verificare se il modello riesce a superarli o a compiere progressi significativi in tali compiti, se ha raggiunto una base di intelligenza e quindi tracciare una linea di tendenza per vedere cosa succede nel 2027 o nel 2028.

Presentatore: Ti piacciono le valutazioni degli Stati nazionali?

Douglas: Sì, ad esempio, dovresti scomporre l’economia del tuo Paese in tutti i lavori e poi chiederti: se un modello può svolgere tutti questi lavori, significa che ha una vera “intelligenza”? Dovresti creare test di valutazione, tracciare linee di tendenza e dire: "Oh mio dio, cosa succederà nel 2027 o nel 2028?" Il passo successivo è investire massicciamente nella ricerca che renda i modelli più comprensibili, guidabili e onesti: è ciò che chiamiamo scienza dell'allineamento. Una cosa di cui mi rammarico è che la maggior parte dei progressi in questo campo siano arrivati da Frontier Labs. Ma penso che dovrebbe essere…

Presentatore: Possono partecipare altre persone? Ad esempio, Claude può essere utilizzato per svolgere ricerche pertinenti?

Douglas: No. Voglio dire, puoi ancora fare enormi progressi in altri modi. Esiste un progetto chiamato programma MAS, attraverso il quale molte persone hanno dato contributi significativi alla ricerca sull'allineamento, in particolare sull'interpretabilità, il tutto al di fuori di Frontier Labs. Penso che più università dovrebbero impegnarsi in questo ambito. Per molti versi, questo è più vicino alla scienza pura: studia la "biologia" e la "fisica" dei modelli linguistici.

Presentatore: Ma ho la sensazione che l'entusiasmo per la ricerca in questo ambito non sia molto alto.

Douglas: Non ne sono sicuro. Ho sentito dire che in alcune recenti conferenze, come l'ICML, non è stato incluso il workshop sull'interpretabilità meccanicistica, il che per me è del tutto incomprensibile. A mio parere, questa è l'esplorazione scientifica più pura del "meccanismo interno del modello". Se si vuole scoprire la struttura elicoidale del DNA, o scoprire la teoria della relatività generale come fece Einstein, allora il percorso corrispondente nell'albero tecnologico dell'apprendimento automatico/intelligenza artificiale è studiare l'interpretabilità meccanica.

Presentatore: Parliamo del lato positivo. Abbiamo già detto che nei prossimi anni tutti i lavori impiegatizi saranno automatizzati, ma in che modo pensi che siamo stati sottovalutati?

Douglas: Sì, i modelli automatizzeranno sicuramente i lavori impiegatizi, ma sono sorpreso dalla lentezza con cui il mondo ha integrato queste tecnologie. Anche se le capacità del modello non migliorano più, quelle esistenti possono già sbloccare un enorme valore economico, ma non abbiamo ancora ristrutturato veramente i flussi di lavoro attorno a questi modelli. Anche se il modello rimane lo stesso, possiamo cambiare completamente il mondo.

Douglas: Ciò richiede che investiamo in settori che possano davvero rendere il mondo un posto migliore, come la promozione di una gestione sufficiente ed efficiente delle risorse materiali, l'ampliamento dei confini della fisica e dell'industria dell'intrattenimento e l'utilizzo di modelli che ci aiutino a raggiungere questi obiettivi. La mia più grande speranza è quella di rendere le persone più creative e capaci di improvvisare più contenuti, come serie TV, videogiochi, ecc. Le persone saranno molto più motivate e il futuro offrirà infinite possibilità. Anche se il modello sostituirà alcuni lavori, tutti avranno un potere decisionale maggiore e il modello lavorativo della società subirà enormi cambiamenti.

Presentatore: Cosa ritieni sia sopravvalutato e cosa è sottovalutato nell'ambito dell'intelligenza artificiale?

Douglas: Ok, parliamo prima di quelli sottovalutati. Penso che i modelli mondiali siano davvero interessanti, ma oggi non ne abbiamo parlato molto. Con l'avanzamento della tecnologia AR/VR, i modelli saranno in grado di generare direttamente mondi virtuali, offrendo un'esperienza sconvolgente.

Presentatore: Ciò richiede un certo livello di comprensione della fisica, come causa ed effetto, che non abbiamo ancora raggiunto, giusto?

Douglas: Penso che abbiamo dimostrato in una certa misura che il modello ha la capacità di comprendere la fisica. Ciò è riscontrabile nelle valutazioni che riguardano problemi di fisica, nonché in alcuni modelli video. Ad esempio, ho visto un video fantastico in cui qualcuno aveva un modello di generazione video in cui metteva uno squalo Lego sott'acqua: simulava il modo in cui la luce si rifletteva sulla superficie dei mattoncini Lego e le ombre erano posizionate nel posto giusto. Si tratta di uno scenario completamente nuovo, che il modello non aveva mai visto prima, e ne costituisce una generalizzazione completa. Questa è una capacità di modellazione fisica completa, giusto?

Presentatore: Hai detto che anche se il modello è ormai stagnante, è ancora possibile sviluppare un gran numero di applicazioni. Quali sono le aree più sottovalutate e inutilizzate?

Douglas: Il campo dell'ingegneria del software è maturo e i modelli sono molto efficaci nella programmazione. In quasi tutti gli altri campi, come il diritto, la contabilità, ecc., c'è ancora molto spazio per lo sviluppo. Soprattutto per l'applicazione di agenti intelligenti, non esiste ancora un vero e proprio sistema operativo asincrono. Altre aree sono vuote e meritano di essere esplorate.

Moderatore: Spesso si dice che la programmazione sia la direzione applicativa ideale per questi modelli.

Douglas: Sì, è un indicatore anticipatore. Ma è lecito aspettarsi che altre aree seguano questa tendenza.

Presentatore: Ricordo che hai pubblicato una tua foto nella Cittadella, di cosa si tratta?

Douglas: Si trattava di un war game in cui erano invitati i rappresentanti delle agenzie di intelligence e i cadetti delle accademie militari a simulare l'arrivo dell'AGI e della potente intelligenza artificiale e a discuterne l'impatto geopolitico.

Presentatore: Dopo quell'esperienza, eri più spaventato o sollevato?

Douglas: Un po' più spaventato, a dire il vero.

Presentatore: Credi che al giorno d'oggi vengano realizzate abbastanza simulazioni serie di questo tipo?

Douglas: Non abbastanza. Molte persone sottovalutarono la velocità dello sviluppo tecnologico negli anni successivi e non erano preparate. Anche se pensi che qualcosa abbia solo il 20% di probabilità di accadere, dovresti essere preparato. C'è ancora molto margine di miglioramento nell'efficienza di ogni collegamento tecnico e gli obiettivi futuri sono quasi certi.

Presentatore: Proprio come adesso quasi tutte le persone antropiche hanno raggiunto un livello di fiducia del 90%?

Douglas: Quasi tutti i membri del team sono molto fiduciosi che potremo raggiungere "lavoratori AGI remoti e plug-and-play" entro il 2027. Anche chi è meno fiducioso stima la probabilità al 10-20%. Pertanto, il governo dovrebbe farne una priorità e riflettere attentamente sul suo impatto sociale. Ma al momento questo senso di urgenza è ben lungi dall'essere sufficiente.

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.