Dopo aver utilizzato questo sequel spirituale di Google Camera, ho la sensazione che la fotografia con il cellulare dovrebbe essere così

Sei anni fa ho iniziato il mio viaggio come fotografo, salendo a bordo di un Airbus 320 della IndiGo diretto in India con la mia macchina fotografica Sony in mano.

Oggi, sei anni dopo, la fotografia con i cellulari sta invadendo il campo dell'imaging tradizionale a una velocità straordinaria e la linea di prodotti del mercato delle fotocamere sta gradualmente convergendo verso strumenti utili in ambito professionale o articoli di moda.

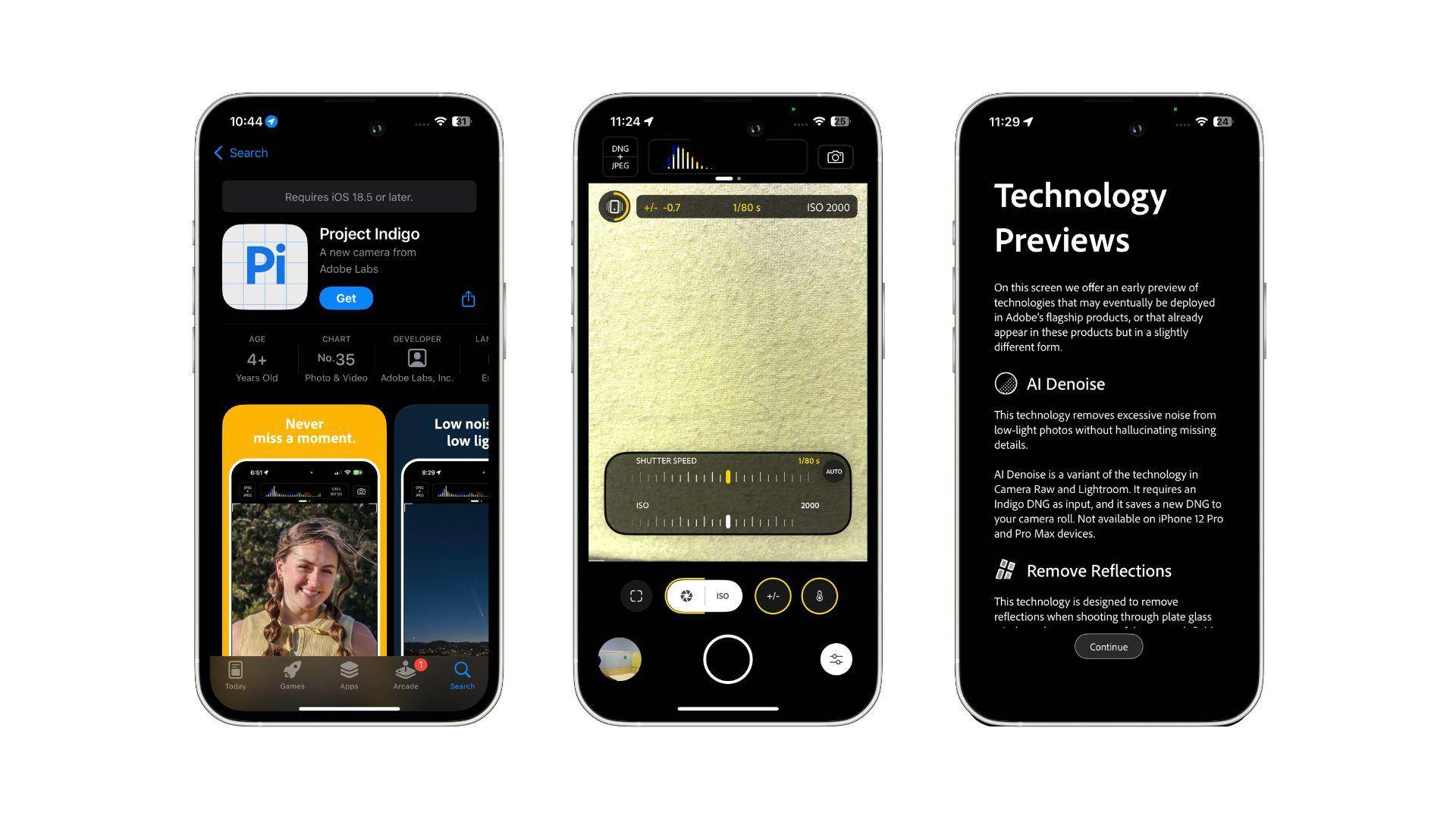

In quel periodo, un altro "Indigo" catturò la mia attenzione: Project Indigo di Adobe, un'app di elaborazione immagini completamente diversa.

Porta l'acclamata esperienza di fotografia computazionale di Google Camera sull'iPhone nella sua forma originale, consentendomi di dare un'occhiata a quanto sia potente il limite massimo della fotografia computazionale.

Un'app per fotocamera a prova di futuro, ma un'anteprima

Dando una rapida occhiata, potrebbe risultare difficile capire che si tratta di un'app di imaging.

L'icona dell'applicazione Project Indigo non presenta alcun elemento grafico. Segue invece il consueto schema di design di Adobe, posizionando le prime lettere delle due parole che compongono il nome sull'icona e l'immagine di base è una griglia di 16 quadrati incorniciata da linee blu.

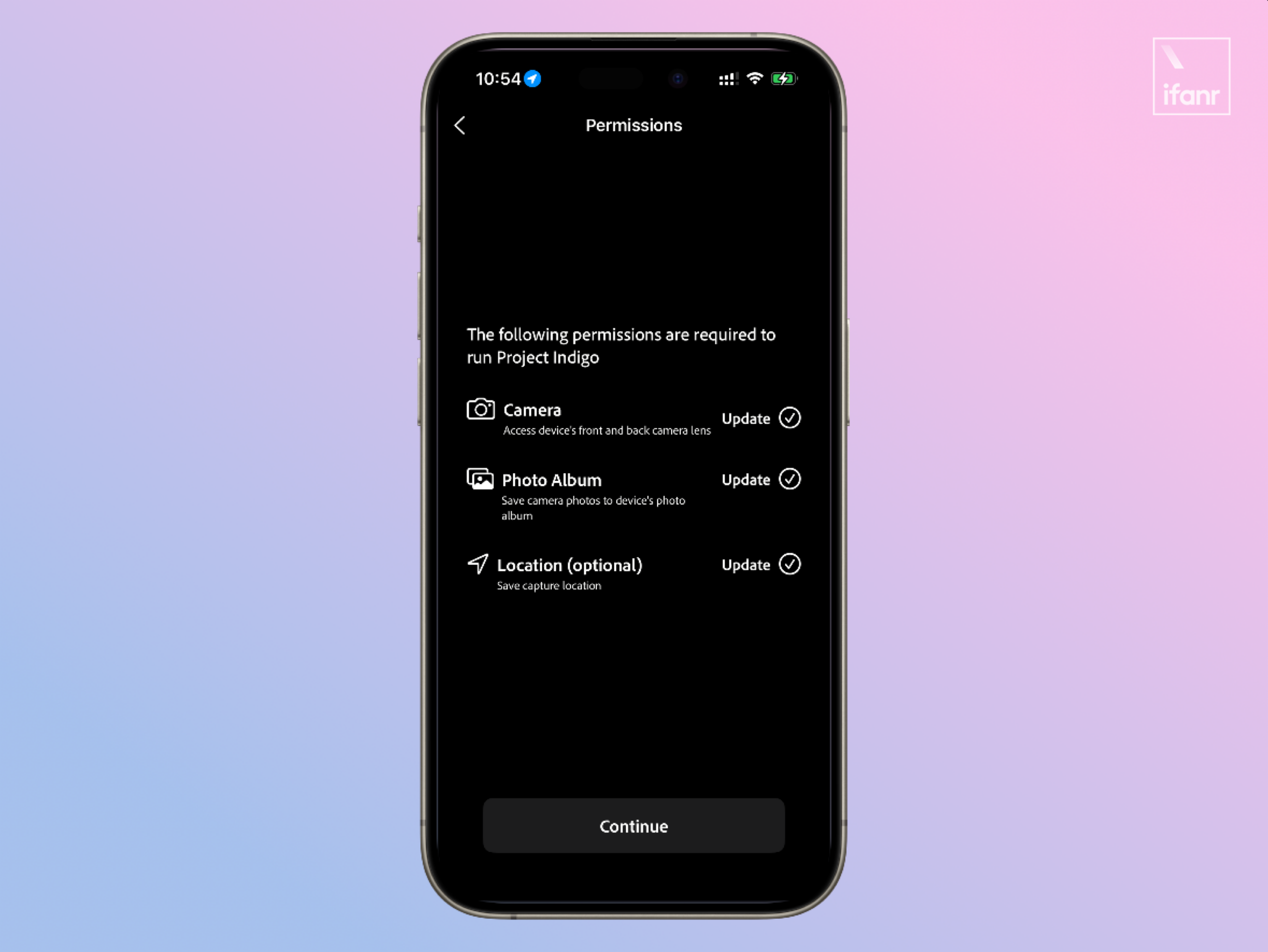

Accedendo a Project Indigo (di seguito denominato Indigo), la prima cosa che si vede è la familiare interfaccia di richiesta di autorizzazione. Questa app di imaging richiede un totale di tre autorizzazioni:

- Autorizzazioni di controllo della telecamera

- Autorizzazioni di accesso all'album

- Autorizzazioni per le informazioni sulla posizione

La mancanza di diritti di accesso al microfono indica che Project Indigo è un'app che fornisce esclusivamente immagini statiche e che la ripresa video, più in linea con le tendenze di Internet, non è il suo obiettivo.

Una volta completata la richiesta di autorizzazione, Indigo ti mostrerà l'interfaccia utente principale e le funzioni di questa app di imaging. Saltiamo rapidamente questo passaggio e passiamo direttamente all'interfaccia principale dell'applicazione.

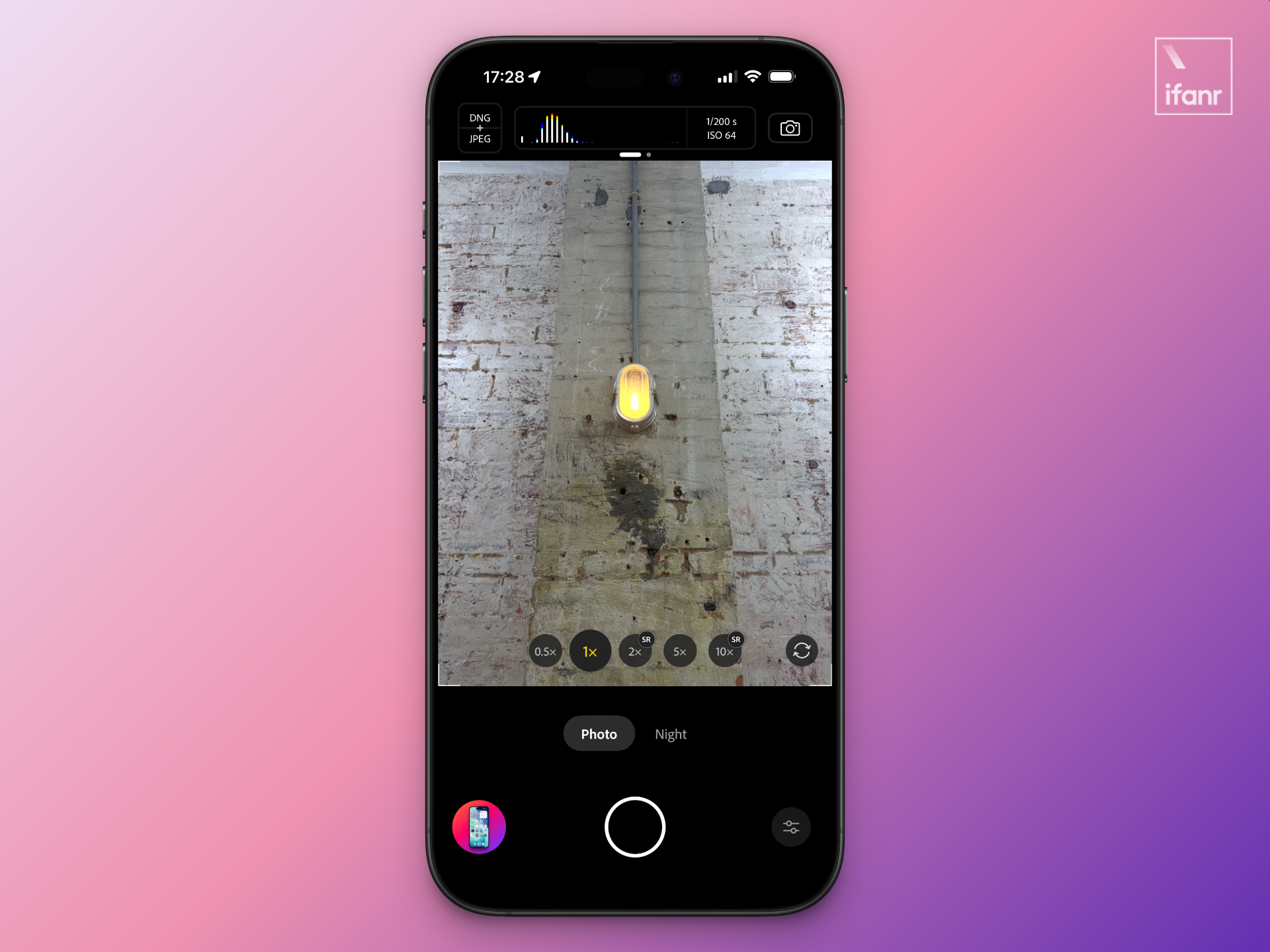

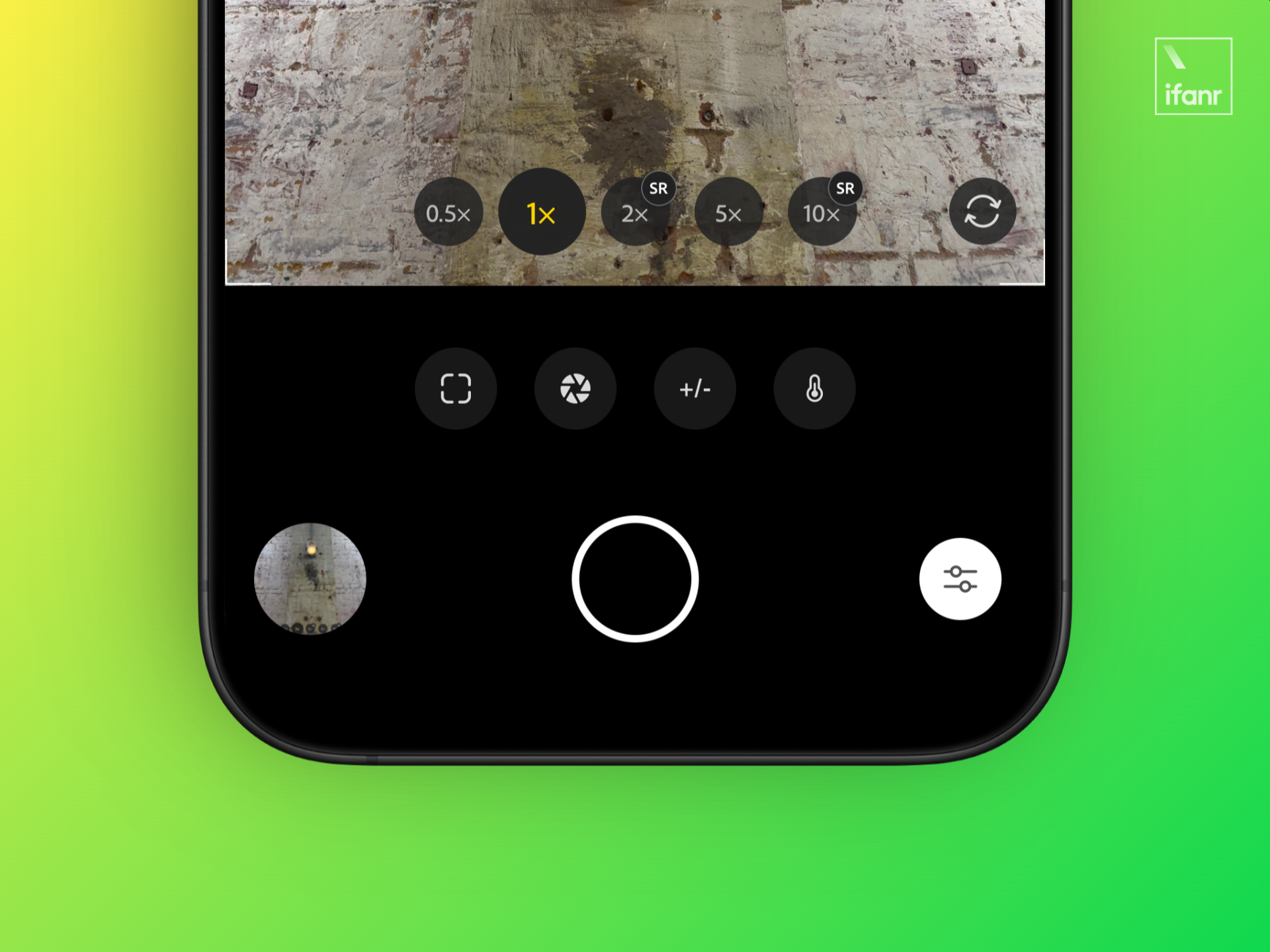

L'interfaccia di scatto principale di Project Indigo non segue il design di iOS 26, ma fornisce quante più informazioni e controlli possibili, consentendo agli operatori di avere il massimo controllo sugli effetti fotografici.

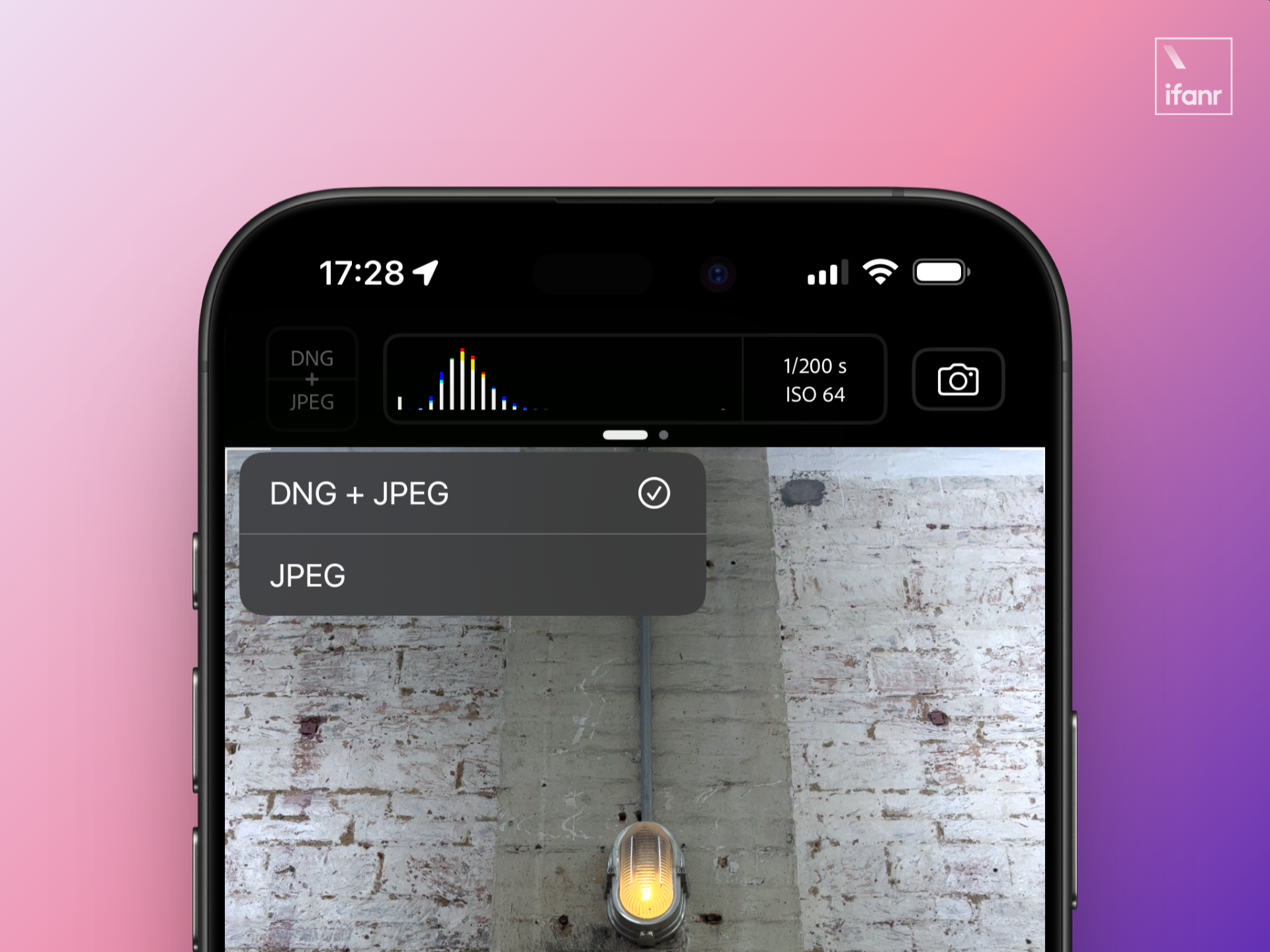

Partendo dall'alto, è suddiviso in tre parti: formato immagine, istogramma e parametri di esposizione, e modalità di scatto. Il formato immagine consente di scegliere se scattare foto in formato JPEG o DNG+JPEG.

Il formato JPEG è un formato di diffusione comune, adatto alla pubblicazione diretta su Internet o sui social media dopo lo scatto, mentre il secondo è un formato fotografico RAW che registra informazioni dettagliate dell'immagine, può offrire un enorme spazio di post-produzione e non è adatto alla diffusione diretta.

L'istogramma e i parametri di esposizione nella parte centrale superiore mostrano chiaramente l'esposizione corrente nel mirino e la combinazione di tempo di posa e sensibilità. Questa parte può anche essere fatta scorrere per accedere al menu secondario. In questo menu è possibile controllare alcuni comandi ausiliari di inquadratura e scatto, come il conto alla rovescia, la griglia del mirino, l'indicatore di sovraesposizione del livello o delle alte luci. Da qui è anche possibile accedere a tutte le impostazioni dell'applicazione Indigo.

A destra è visualizzata la modalità di scatto corrente. Le impostazioni di Indigo non sono complicate e sono divise in due sole modalità: foto e scena notturna.

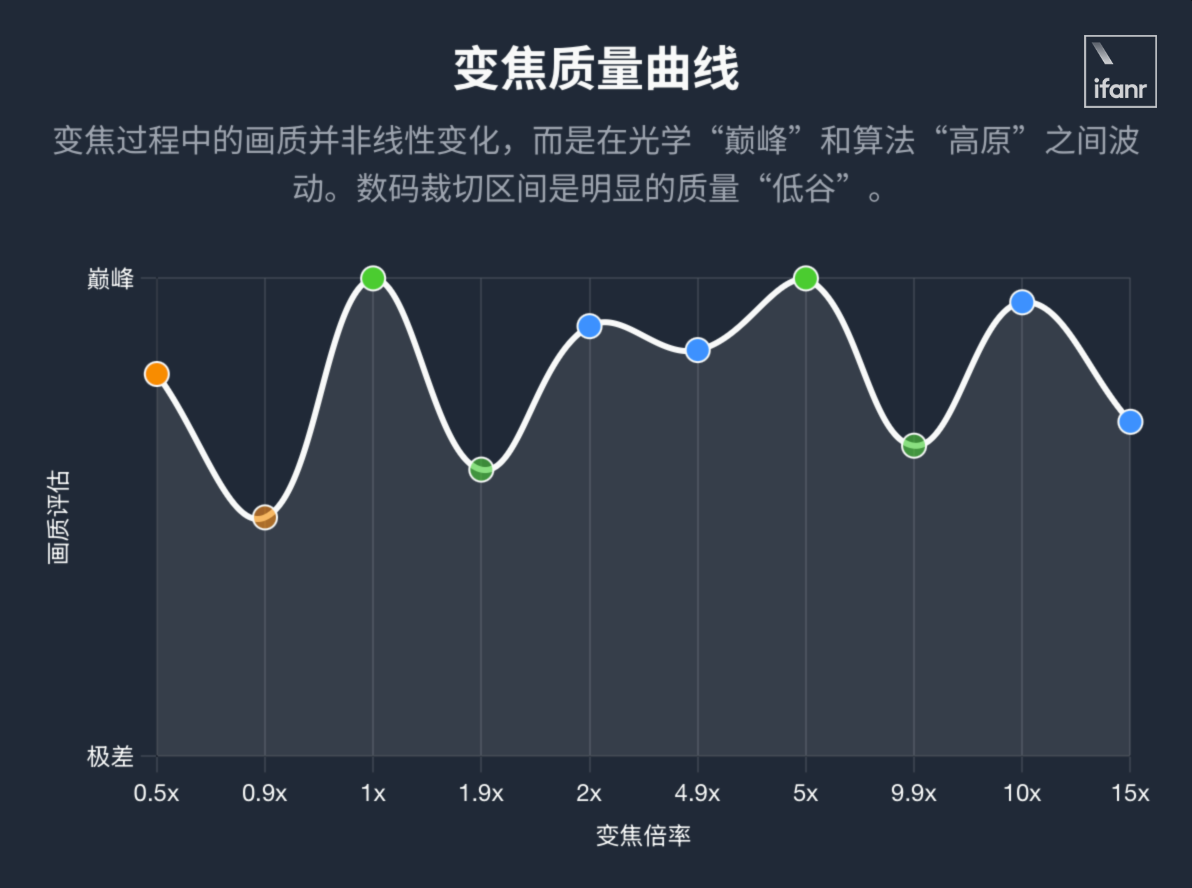

Spostando lo sguardo verso la metà inferiore dello schermo, nella parte inferiore del mirino si trova la familiare barra di selezione della lunghezza focale. Prendendo come esempio il mio iPhone 16 Pro, Indigo offre cinque opzioni: 0,5×, 1×, 2×, 5× e 10×.

È molto evidente che la parola SR sia indicata sulle due lunghezze focali 2× e 10×. Dal manuale ufficiale, apprendiamo che il nome completo di SR è "Multi-frame super-resolution". Il 2× basato sulla fotocamera principale 1× e il 10× basato sulla 5× otterranno una nitidezza paragonabile a quella delle lunghezze focali ottiche con il supporto di questa tecnologia.

Come suggerisce il nome, il principio tecnico alla base della tecnologia multi-frame super-resolution è che, dopo aver premuto il pulsante di scatto, il telefono scatta immediatamente un numero considerevole di foto e poi utilizza un algoritmo specifico per unire decine di foto e generare immagini ricche di dettagli e con basso rumore.

▲ È molto imbarazzante, la foto proviene da Xiaohongshu @KERICH誠

Nei test effettivi, ho scoperto che la tecnologia super-risoluzione multi-frame funziona da 2× a 4,9× e lo stesso vale per 10× e oltre.

Vale a dire che nel Progetto Indigo, le attività di imaging di ciascuna lunghezza focale sono ulteriormente suddivise:

- 0,5×-1×: Ritaglio digitale basato sull'obiettivo ultragrandangolare nativo;

- 1×-1,9×: ritaglio digitale basato sulla fotocamera principale nativa;

- 2×-4,9×: Ritaglio ottico basato sulla tecnologia super-risoluzione multi-frame;

- 5×-9,9×: ritaglio digitale basato sull'obiettivo teleobiettivo 5× nativo;

- 10× e oltre: ritaglio quasi ottico basato sulla tecnologia di super risoluzione multi-frame.

Dopo aver osservato l'abbagliante layout delle lunghezze focali, rivolgiamo la nostra attenzione alla parte inferiore. Le modalità Foto e Scena Notturna sono posizionate orizzontalmente tra il layout delle lunghezze focali e il pulsante di scatto. Qui è possibile passare rapidamente da una modalità all'altra per adattarsi a diverse scene di scatto. Tuttavia, c'è una duplicazione con il selettore di modalità in alto a destra, che sembra un po' uno spreco di spazio nell'interfaccia utente.

Più in basso si trova il pulsante di scatto più importante. A sinistra del pulsante di scatto si trova l'album in cui verranno salvate le foto scattate per la successiva fusione. Qui si può vedere che diverse foto vengono fuse sullo sfondo. Da qui è anche possibile accedere a Lightroom per ulteriori modifiche alle foto.

Il lato destro è la modalità manuale più professionale, in cui è possibile personalizzare i parametri che influiscono direttamente sull'immagine finale, come la temperatura del colore, la distanza di messa a fuoco, la velocità dell'otturatore e la sensibilità.

Dopo aver letto l'impaginazione, ero molto curioso di conoscere le effettive prestazioni di scatto di Project Indigo e di vedere quale diversa comprensione questa vecchia azienda focalizzata sul campo dell'imaging avesse per l'imaging mobile.

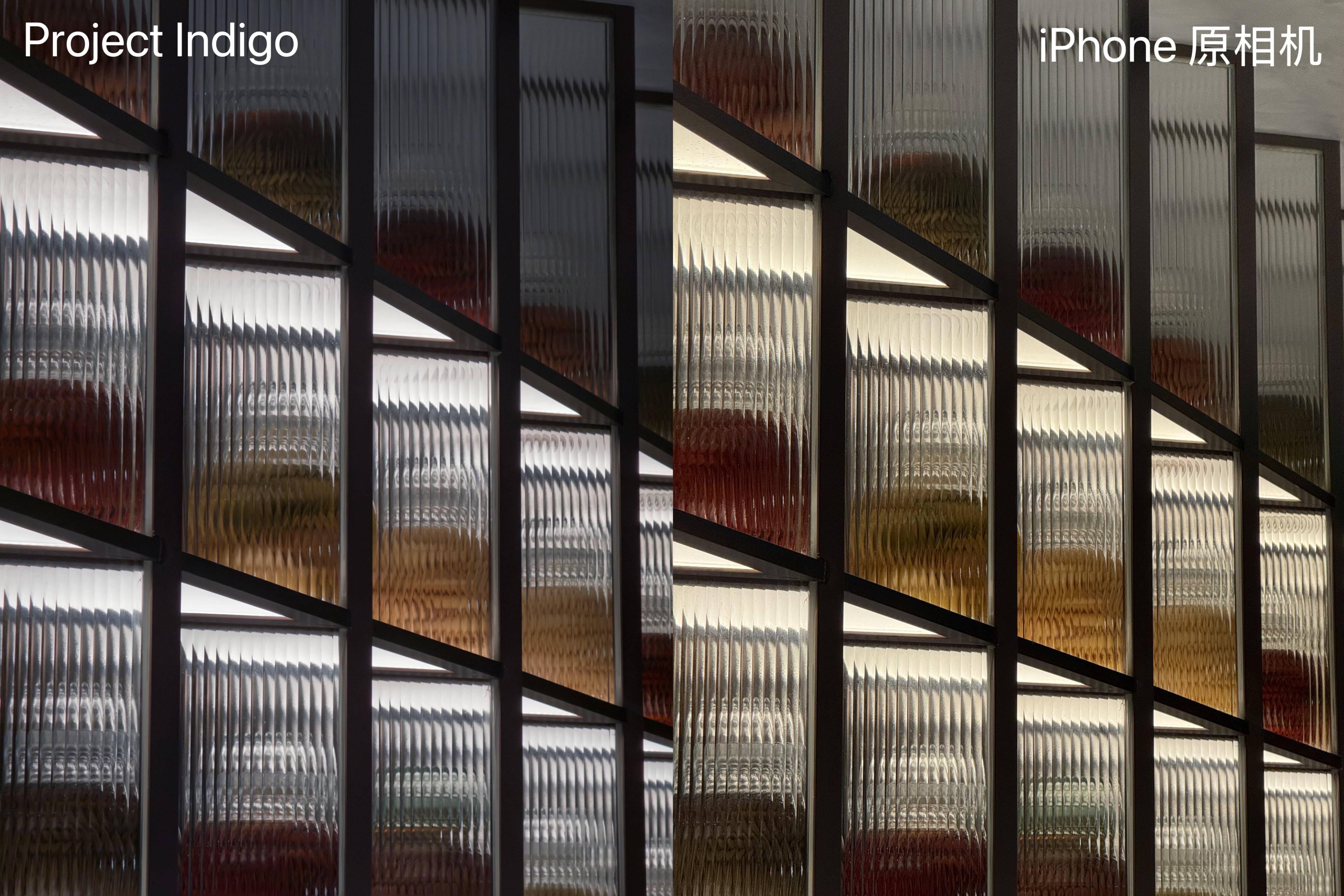

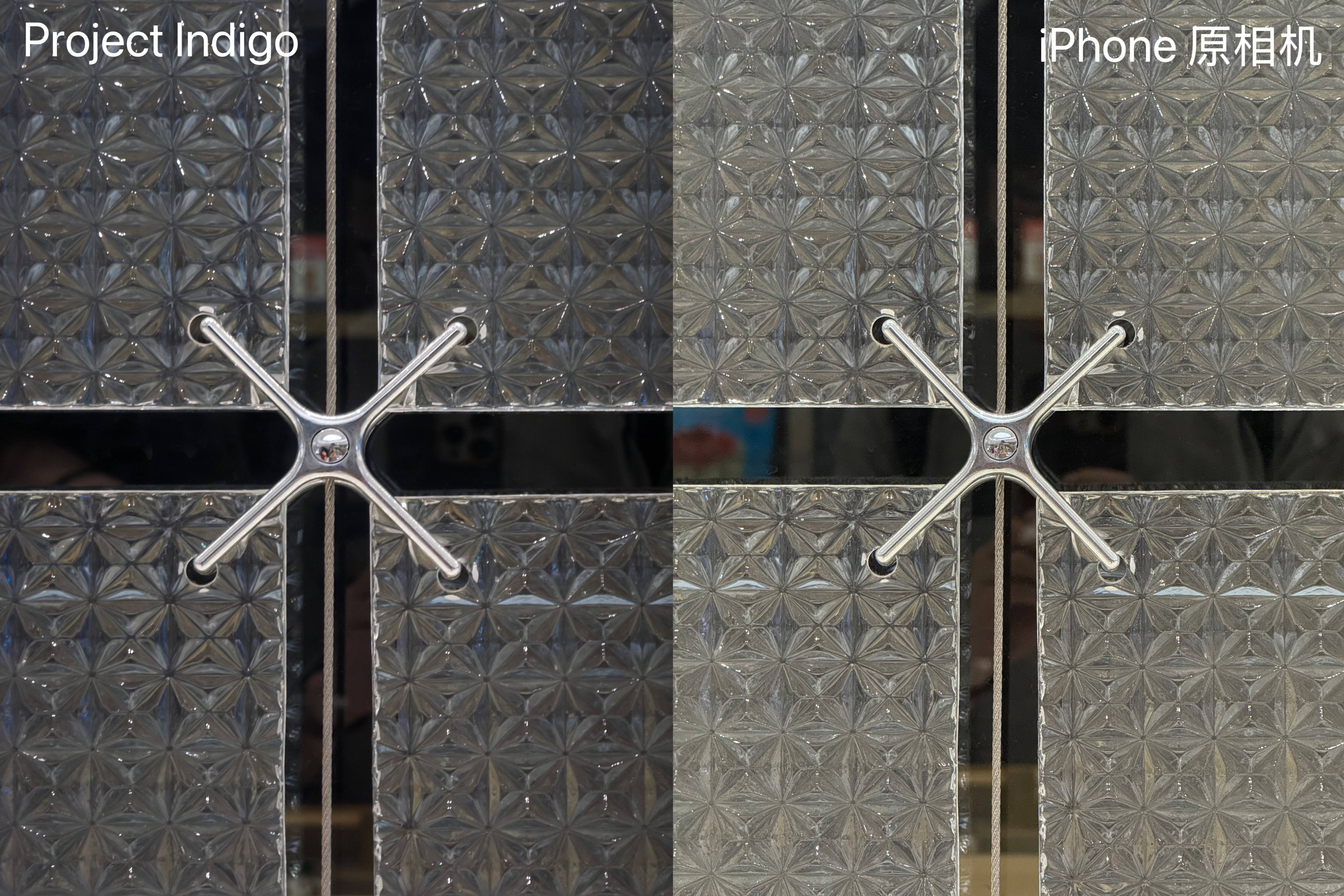

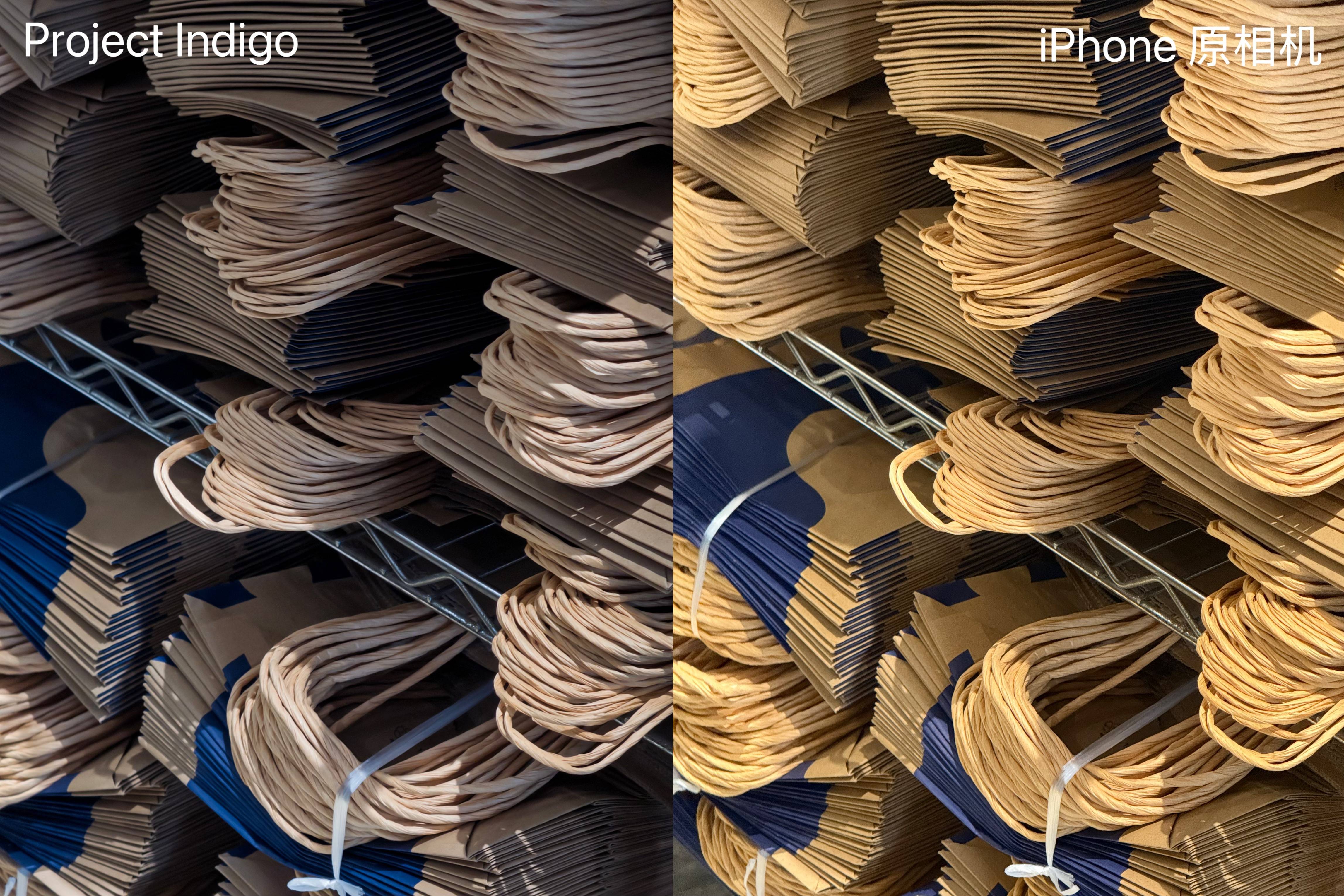

Vorrei innanzitutto concludere. Project Indigo è completamente diverso dalla fotocamera nativa dell'iPhone per due aspetti principali. Basato sullo stesso hardware, l'effetto immagine di Project Indigo è più accattivante e la transizione tra luce e ombra è più in linea con ciò che si vede a occhio nudo, senza la sensazione di luminosità eccessiva dell'iPhone.

A giudicare dall'istogramma, i pixel del Progetto Indigo sono più concentrati nella metà sinistra e l'immagine tende a essere più scura, il che è più in linea con la zona di comfort dell'occhio umano, più stimolante per la risonanza emotiva umana e più in linea con le profonde abitudini di espressione artistica.

Un altro aspetto è che le immagini di Project Indigo presentano una minore nitidezza e frammentazione, ma grazie alla sintesi di un numero considerevole di fotogrammi multipli, la nitidezza non risulta eccessivamente attenuata. Dopo aver ingrandito, i bordi degli oggetti e del testo nell'immagine mantengono comunque una relativa nitidezza, mantenendo un certo grado di leggibilità.

Oltre a rendere più naturale la transizione tra luci e ombre e a risolvere il problema dei bordi netti, Project Indigo presenta anche un'ottimizzazione non facile da notare: l'immagine originale della fotocamera dell'iPhone può facilmente mostrare un rumore sottile e denso dopo aver ingrandito, ma Project Indigo gestisce molto bene questo rumore di fondo e l'immagine può comunque rimanere nitida anche dopo aver ingrandito.

Nel complesso, Project Indigo eccelle nei dettagli delle immagini, nella nitidezza, nella soppressione del rumore e nella resa cromatica, mostrando una tendenza estetica più naturale e armoniosa e riproducendo più fedelmente ciò che vede l'occhio nudo.

Si può affermare che il debutto di Project Indigo abbia risolto tutti i problemi per cui l'iPhone è attualmente criticato, come l'eccessiva nitidezza, la curva di luminosità innaturale e i dettagli delle immagini pieni di rumore di fondo. Ha persino ampliato i limiti della lunghezza focale disponibile per iPhone, ma non vi consiglio di provarlo subito.

Il motivo è che questa app presenta ancora molti problemi: ad esempio, occasionalmente compaiono bordi neri nella parte inferiore delle foto e le foto scattate assumono una colorazione rosso-violacea una volta modificate nell'album. Allo stesso tempo, il calore generato e il consumo energetico durante l'intero processo di scatto sono significativamente superiori rispetto alla fotocamera nativa del sistema.

Secondo il feedback degli sviluppatori di Project Indigo sui social media, i problemi relativi ai bordi neri e alla dominante di colore sono dovuti principalmente all'adattamento incompleto del sistema, che è un bug tipico della fase beta;

Le cause del calore e del consumo energetico sono più profonde. Indigo utilizza una pipeline di elaborazione delle immagini completamente diversa da quella dell'iPhone, quindi non può contattare l'ISP nativo di Apple. Tutti i calcoli multi-frame e le attività di fusione delle immagini vengono eseguiti quasi direttamente sul processore, il che comporta naturalmente un carico hardware maggiore.

Infatti, Adobe ti ha già ricordato tutto questo prima che tu aprissi il software: ricordi l'icona con lo sfondo bianco e il wireframe blu?

Questo progetto, che ricorda un progetto ingegneristico, indica chiaramente che il Progetto Indigo si sta ancora concentrando sugli algoritmi e sui framework di fotografia computazionale di base e che si tratta di un esperimento guidato dalla tecnologia piuttosto che di un prodotto finito completamente funzionale adatto alla distribuzione.

Allo stesso tempo, l'origine del Progetto Indigo determina anche che la sua esperienza utente non è decisamente abbastanza buona: si tratta di un progetto lanciato dal team Nextcam nell'ambito del framework Adobe Labs, che è il campo di prova e l'incubatore di Adobe per le tecnologie future, focalizzato sulla sollevazione di domande e sulla verifica di idee piuttosto che sulla fornitura di endpoint.

▲ La maggior parte delle applicazioni qui sono incubate da Adobe Labs

L'origine e il futuro della fotografia computazionale

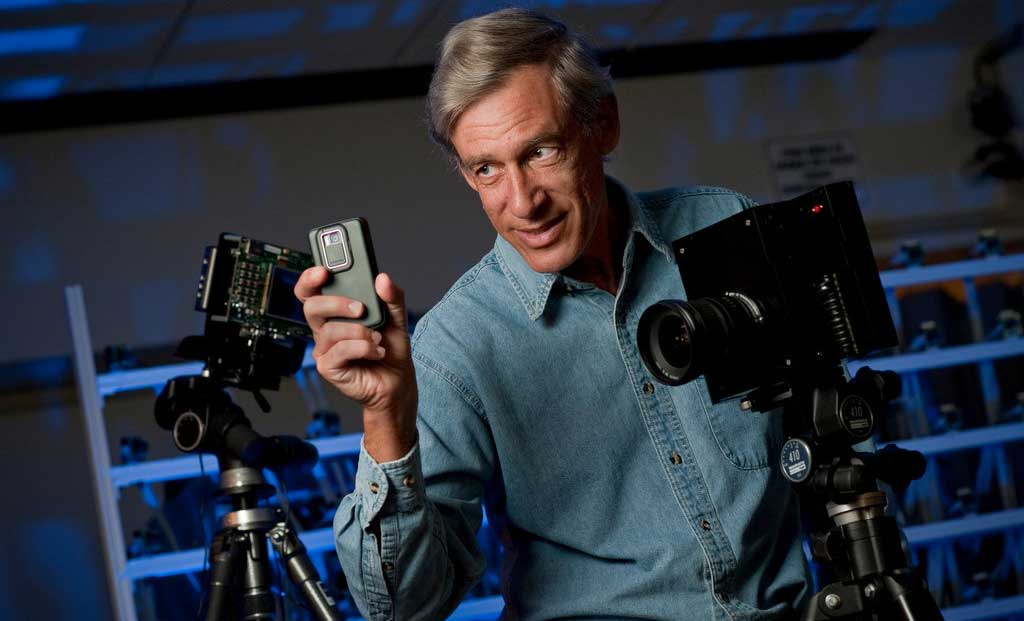

Sebbene il lancio del Progetto Indigo sia attribuito ad Adobe, un'azienda che opera da tempo nel campo dell'imaging, c'è un nome degno di nota nel team Nextcam che ha lanciato Indigo: Marc Levoy.

Se hai vissuto l'epoca in cui il sistema operativo Android per l'imaging non era ancora stato lanciato e Google Camera era popolare, allora potresti non avere familiarità con il nome Marc Levoy: sia i primi Pixel che Google Camera, famosa per i suoi algoritmi, sono capolavori ideati da lui.

▲Marc Levoy

La filosofia di Levoy affonda le sue radici nella sua formazione accademica, in un mondo molto diverso dalla tradizionale fotografia ottica: la computer grafica.

Già durante i suoi studi di dottorato, la tecnologia di rendering volumetrico da lui sperimentata per prima gettò le basi per la logica fondamentale del suo lavoro successivo: attraverso il calcolo, una serie di sezioni di dati 2D (come le scansioni TC) venivano ricostruite in un insieme tridimensionale. Questo fu il prototipo della logica fondamentale della sintesi multi-frame e della ricostruzione delle immagini che in seguito applicò alla fotografia mobile.

Durante il suo insegnamento alla Stanford University, Levoy ha ulteriormente gettato solide basi teoriche per la fotografia computazionale: l'articolo "Light Field Rendering", di cui è coautore insieme ai colleghi, sostiene che le fotocamere dovrebbero registrare non solo l'intensità della luce, ma anche la sua direzione, consentendo operazioni rivoluzionarie come la rimessa a fuoco dopo lo scatto.

Vi suona familiare? La fotocamera Lytro, ormai un ricordo del passato, è una fedele seguace di questo percorso.

Nel 2004, Levoy ha ridefinito e reso popolare il termine "fotografia computazionale" in un corso di Stanford, interpretando la connotazione più ampia del termine da un'altra prospettiva:

La fotografia computazionale è una tecnica che mira a migliorare o ampliare le capacità della fotografia digitale, producendo una foto ordinaria che è impossibile scattare con una macchina fotografica tradizionale.

Dieci anni dopo, Levoy entrò ufficialmente in Google e guidò il team a concentrarsi sulla fotografia mobile. Le sue prime idee trovarono finalmente realizzazione qui: un gruppo di fotogrammi con esposizione estremamente breve viene ottenuto tramite scatto continuo ad alta velocità, e poi vengono utilizzati algoritmi per allineare, unire e ridurre il rumore. Infine, viene calcolata una foto con una qualità pura e un'ampia gamma dinamica che supera di gran lunga la qualità di ogni singolo fotogramma.

Una teoria che richiede enormi capacità di calcolo ed è in qualche modo eccessivamente idealistica, dopo essere stata sintetizzata e perfezionata, è stata implementata con una potenza di calcolo accessibile a dispositivi comuni, ed è finalmente finita nelle mani di centinaia di milioni di utenti. Il grido di dieci anni fa ha finalmente trovato eco.

▲ Marc Levoy con in mano Pixel 3

I protagonisti sono poi i familiari Pixel e le loro celebri funzionalità. Innanzitutto, l'HDR+, che rivoluziona completamente le prestazioni di imaging dei telefoni cellulari in condizioni di luce complesse. Grazie alla tecnologia di sintesi multi-frame, mantiene i dettagli delle alte luci e presenta con chiarezza anche i livelli di buio.

La modalità Ritratto, invece, utilizza un algoritmo per ottenere un effetto di sfocatura dello sfondo paragonabile a quello di una reflex digitale su una singola fotocamera. Questa è la perfetta incarnazione del concetto di riduzione dimensionale; e la modalità Scena Notturna porta questo concetto all'estremo. Può combinare fino a 15 fotogrammi, ciascuno con un'esposizione fino a 16 secondi, in una foto notturna luminosa e nitida. Il suo effetto era senza pari nel campo dell'imaging mobile dell'epoca.

Queste caratteristiche, basate sulla tecnologia di sintesi multi-frame, non solo hanno permesso al Pixel con una sola fotocamera di superare le prestazioni dei telefoni con doppia fotocamera come iPhone e Samsung, vincendo numerosi riconoscimenti come il miglior telefono con fotocamera dell'anno, ma hanno anche reso il termine fotografia computazionale una formula vincente per l'imaging mobile.

Molti anni dopo, quando a Levoy, che era già entrato in Adobe, fu chiesto del rapporto tra fotografia computazionale e creazione artistica, la sua filosofia era chiara e risoluta:

Non esiste la "fotografia diretta". La gamma dinamica della luce nel mondo reale supera di gran lunga il limite di ciò che qualsiasi sensore può registrare. Anche l'occhio umano è un motore di fotosensibilità adattiva. Le scene che le persone vedono sono state elaborate soggettivamente dal cervello, quindi qualsiasi sistema di imaging digitale deve regolare i colori e i toni registrati, e queste regolazioni sono inevitabilmente soggettive.

Levoy non è timido riguardo al prodotto, ed è persino sorprendentemente onesto, affermando che per diversi anni le immagini Pixel sono state create secondo la sua filosofia e la sua estetica:

Adoro i dipinti di Caravaggio, quindi lo stile delle immagini da Pixel 2 a Pixel 4 tende a essere scuro e ad alto contrasto.

▲ L'opera di Caravaggio "Cena in Emmaus"

Questa filosofia si è estesa a tutta la carriera di Levoy, fino a quando non ha lasciato Google per entrare in Adobe. Possiamo ancora vedere questo stile dai toni scuri su Project Indigo, che è completamente diverso dalla strategia di imaging della fotocamera originale dell'iPhone, che si concentra su mezzitoni e alte luci.

Naturalmente, da un lato si tratta di una preferenza estetica, dall'altro è inscindibile dai requisiti dell'algoritmo. La soluzione attuale di Project Indigo consiste nello scattare più foto leggermente sottoesposte per preservare i dettagli e i colori delle alte luci, per poi ridurre il rumore scuro tramite sintesi multi-frame. Le foto sintetizzate secondo questa logica tendono a essere più scure.

A questo punto, chi è interessato può già scoprire un Easter egg a lungo termine: sia esteticamente che tecnicamente, Project Indigo può essere visto come la continuazione spirituale di Pixel. La cosa più interessante è che questa fantastica app è attualmente disponibile solo per iOS.

Non è forse questa una sorta di ortodossia di Google nei confronti di Apple?

Non lasciare che gli algoritmi si prendano il merito delle foto

L'unica costante è il cambiamento; la fortuna non dura mai per sempre.

Fotografia computazionale, termine che agli albori simboleggiava tecnologia e progresso, nel periodo successivo ha subito un declino.

Dopo il lancio di Pixel, Google Camera è diventata la fotocamera nativa di Pixel, cessando gradualmente di esistere come app separata. La difficoltà di adattamento è aumentata drasticamente. Inoltre, il continuo miglioramento degli smartphone nazionali ha gradualmente attirato l'attenzione di tutti e ha ottenuto un riconoscimento, distogliendo l'attenzione da Google Camera.

![]()

▲ A partire dalla classica serie Pixel 8 con "occhi laser", Pixel Camera ha iniziato l'integrazione del sistema

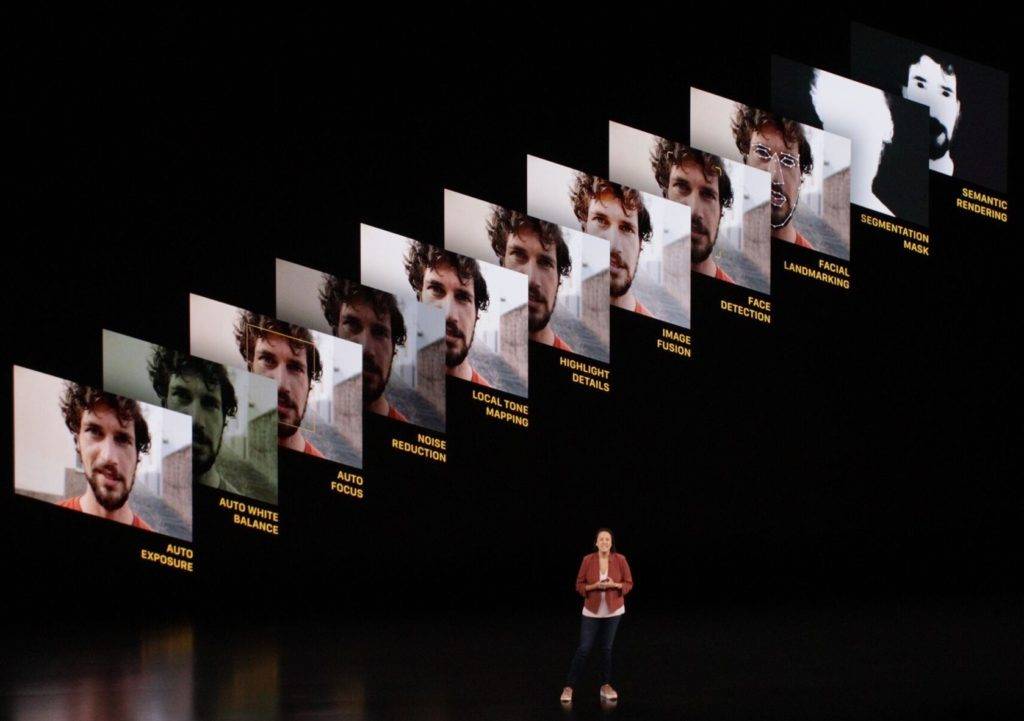

D'altra parte, Apple, che detiene metà dell'ecosistema della telefonia mobile, ha introdotto completamente la tecnologia Deep Fusion nella serie iPhone 11. Utilizza anche la tecnologia multi-frame stacking, ma ha ricevuto recensioni contrastanti.

Per quanto riguarda l'iPhone senza Deep Fusion, sebbene l'effetto sia naturale, ne risente in termini di qualità dell'immagine, e alla fine è stato gradualmente eliminato nei successivi aggiornamenti del processore.

▲ La familiare Deep Fusion è qui

Da allora, il termine "fotografia computazionale" ha iniziato ad associarsi sempre più negativamente: le foto sono fortemente macchiate, eccessivamente nitide e presentano una forte frammentazione dell'immagine. Questi aggettivi visivi scomodi sono gradualmente diventati le sue etichette stereotipate.

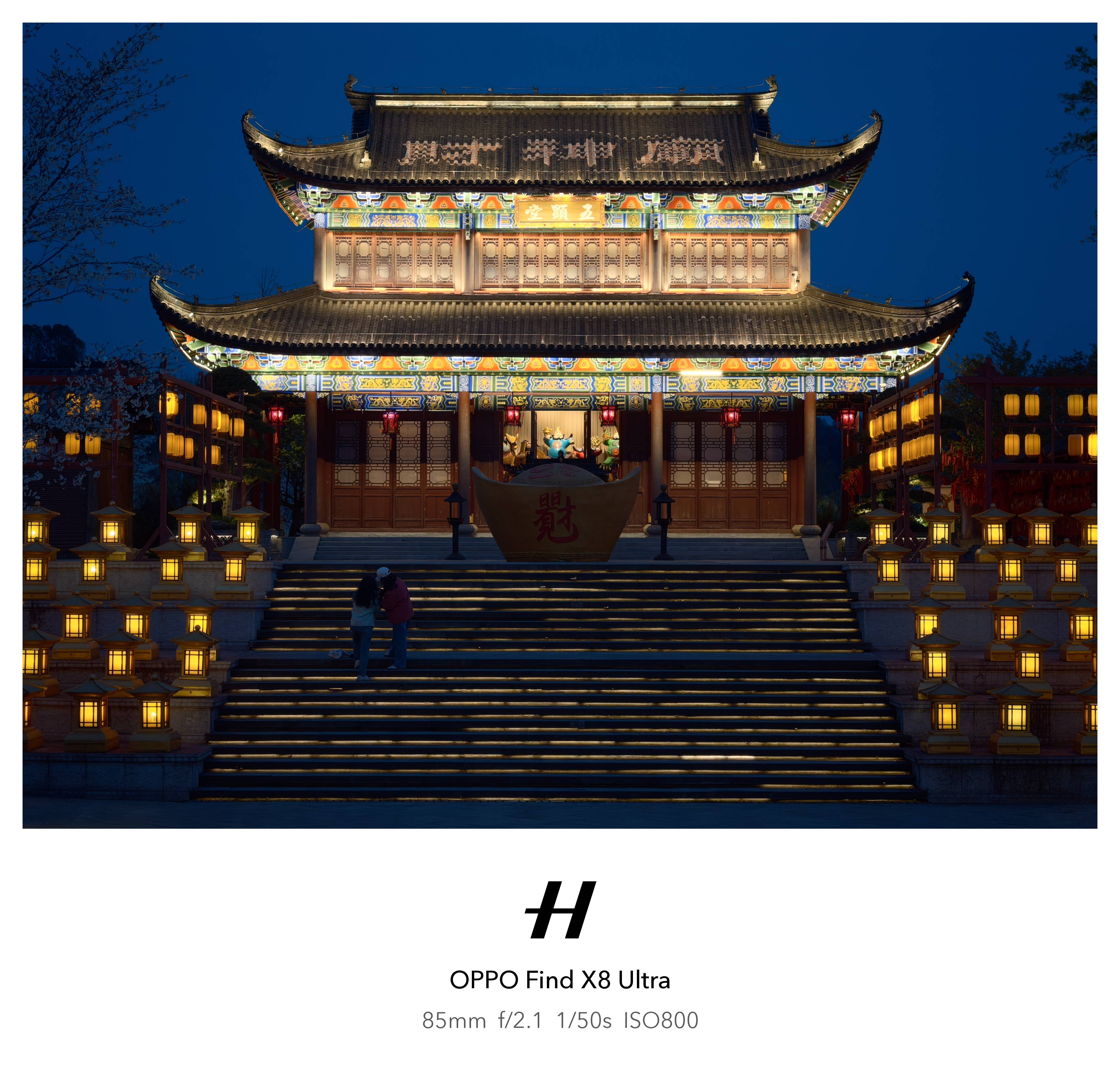

Quest'anno le cose sono cambiate. Sull'OPPO Find X8 Ultra, è presente una "Master Mode" che si dice sia stata pensata appositamente per i fotografi. Il suo stile di imaging è più sobrio e delicato rispetto alla fotografia computazionale tradizionale: sopprime efficacemente il senso di frammentazione causato dalla nitidezza digitale, pur mantenendo una curva di luminosità più naturale.

È però un po' deplorevole che, pur ricercando l'aspetto, la sensazione e la morbidezza, la nitidezza della modalità Master non venga mantenuta, la chiarezza dei bordi degli oggetti diminuisca e la qualità dell'immagine manchi di solidità.

L'approccio di Project Indigo è più radicale. Persegue l'algoritmo di spremere le prestazioni all'estremo e sintetizzare decine di foto in una sola volta, eliminando completamente l'impatto negativo dei calcoli sul film finito, lasciando il calcolo solo durante il processo. Il risultato finale è una foto dall'aspetto naturale, con luminosità lineare e nitidezza online.

Si può dire che questa è la migliore app di imaging che abbia mai visto, capace di distinguere gli algoritmi dai prodotti finiti.

In ultima analisi, i nostri dubbi sulla fotografia computazionale nascono in realtà dal nostro disgusto per le evidenti "tracce di elaborazione" presenti nelle foto.

Sì, gli algoritmi sono davvero importanti e lavorano duramente, ma ciò che la gente vuole è semplicemente una bella foto, come ha detto Marc Levoy, che non richiede attrezzature professionali ma può produrre risultati inaspettati solo tramite calcoli.

Piuttosto che un pezzo di carta con un algoritmo scritto sopra che si prende il merito.

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.