Costretto a ritirare GPT-5.2 in caso di emergenza, come ha fatto Gemini 3 a invertire la rotta? | Il Chief AI Architect di Google svela per la prima volta i segreti.

"Questa è davvero una bella storia di sfavoriti."

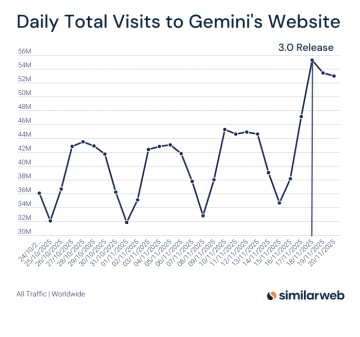

Il lancio di Gemini 3 nelle prime ore del 19 novembre ha infranto la consueta tranquillità. Nel giorno del lancio, ha registrato oltre 54 milioni di visite a livello globale, stabilendo un nuovo record per la piattaforma.

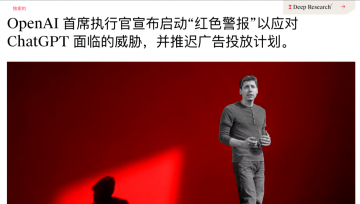

Il ritorno trionfale di Google ha suscitato scalpore anche tra i suoi concorrenti. Secondo The Information, di fronte all'incessante offensiva di Google, il CEO di OpenAI, Sam Altman, ha annunciato con urgenza in una nota interna questo lunedì che l'azienda era entrata in stato di "codice rosso", preparandosi a mobilitare tutte le risorse strategiche per potenziare significativamente le capacità di ChatGPT.

Secondo quanto riportato da The Verge, che cita fonti a conoscenza della questione, OpenAI prevede di rilasciare il modello GPT-5.2 già la prossima settimana, un passo avanti significativo rispetto al piano originale di fine dicembre.

Ciò non solo conferma indirettamente l'imponente presenza del Gemini 3, ma rende anche la conversazione che ne seguirà ancora più significativa.

Di recente, Koray Kavukcuoglu, CTO di DeepMind e nuovo capo architetto dell'intelligenza artificiale di Google, è apparso nel programma di interviste di Logan Kilpatrick, dove ha affermato: "Una volta eravamo dei seguaci, ma l'innovazione è l'unica via d'uscita".

Punti salienti in sintesi:

1. Koray Kavukcuoglu sottolinea che l'ottimizzazione di Gemini si concentra sulle seguenti aree chiave:

- Le istruzioni seguono questo principio : assicurarsi che il modello comprenda e soddisfi accuratamente le esigenze specifiche dell'utente, anziché generare contenuti in modo arbitrario.

- Internazionalizzazione : potenziare le capacità di supporto multilingue per garantire un'esperienza di alta qualità agli utenti di tutto il mondo.

- Capacità di agenti e strumenti : il modello non solo può utilizzare in modo naturale i nostri strumenti e funzioni esistenti, ma può anche scrivere i propri strumenti.

2. Gemini 3 è un "modello di collaborazione per l'intero team di Google". Vi hanno contribuito team provenienti da tutto il mondo, tra cui Europa e Asia, tra cui non solo il team di DeepMind, ma anche team di vari dipartimenti di Google.

3. Con il progresso tecnologico, l'architettura e i concetti dei modelli di testo e dei modelli di immagine stanno convergendo sempre di più. In passato, le loro architetture differivano significativamente, ma ora stanno diventando più simili. Questo è un risultato naturale dell'evoluzione tecnologica: tutti stanno esplorando soluzioni più efficienti, i loro concetti si stanno gradualmente unificando e, infine, si sta formando un percorso di sviluppo comune.

Collegamento video:

Di seguito la trascrizione e la traduzione del contenuto completo. (L'ordine è stato modificato.)

Il benchmarking è solo il primo passo; il feedback degli utenti è il secondo.

Logan Kilpatrick : Ciao a tutti, bentornati alle Note di rilascio. Sono Logan Kilpatrick del team DeepMind. Oggi sono onorato di avere con me Koray, CTO di DeepMind e nuovo Chief AI Architect di Google. Koray, grazie per essere qui con noi e non vedo l'ora di approfondire la discussione con te.

Koray Kavukcuoglu : Anch'io non vedo l'ora. Grazie per l'invito!

Logan Kilpatrick : Certo, il Gemini 3 è stato lanciato. Avevamo la sensazione che questo modello avrebbe funzionato bene e i risultati dei benchmark sono stati davvero impressionanti, ma il feedback effettivo degli utenti dopo averlo effettivamente ricevuto…

Koray Kavukcuoglu : Questo è il test finale. Il benchmarking è solo il primo passo; abbiamo anche svolto molti test successivi, inclusa la partecipazione di tester fidati all'esperienza di pre-rilascio. Possiamo quindi affermare che si tratta di un modello eccellente, con funzionalità eccezionali. Sebbene non sia perfetto, il feedback degli utenti mi ha davvero soddisfatto.

Sembra che il modello piaccia davvero a tutti, e sono tutti ugualmente interessati alle parti che troviamo interessanti. Finora, le cose stanno andando bene e tutto procede senza intoppi.

Logan Kilpatrick : Sì, ne parlavamo proprio ieri, e l'argomento principale era la rapidità con cui lo sviluppo dell'IA è progredito. Ripensando alla conferenza I/O dell'anno scorso, quando abbiamo lanciato Gemini 2.5, ascoltando le dimostrazioni e le discussioni di Serge sul futuro dell'IA, ho avuto la sensazione che la versione 2.5 fosse già il modello più avanzato, un'innovazione in molteplici ambiti. E ora, Gemini 3.0 ha raggiunto un altro traguardo. Sono curioso, la discussione sulla possibilità di continuare questo progresso è ancora in corso; cosa ne pensi attualmente?

Koray Kavukcuoglu : Sono molto fiducioso nei progressi e nella ricerca attuali. Essendo in prima linea nella ricerca, scoprirai che ogni campo è pieno di entusiasmo per l'innovazione: dai dati, alla pre-formazione, alla messa a punto, in ogni fase emergono molte nuove idee e innovazioni.

In definitiva, tutto si riduce a innovazione e creatività. Quando la nostra tecnologia può avere un impatto reale sul mondo reale ed è ampiamente utilizzata, riceviamo più feedback, la nostra portata si espande e questo, a sua volta, genera più ispirazione.

Inoltre, credo che i problemi futuri saranno più complessi e diversificati, il che comporterà nuove sfide, ma queste sfide sono positive e ci spingeranno verso l'intelligenza generale.

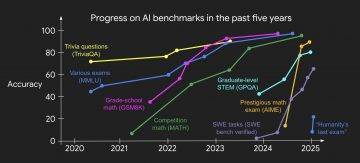

A volte, se si considerano solo uno o due benchmark, si potrebbe avere la sensazione che il progresso abbia rallentato, ma è normale. I benchmark vengono stabiliti quando emerge una determinata sfida tecnica. Con il progredire della tecnologia, non sono più sinonimo di tecnologia all'avanguardia, ed è allora che è necessario stabilire nuovi benchmark.

Questo è comune nel campo dell'apprendimento automatico: il benchmarking e lo sviluppo di modelli si completano a vicenda. Il benchmarking guida l'iterazione del modello e solo avvicinandosi all'attuale frontiera possiamo definire l'obiettivo successivo e quindi formulare un nuovo benchmark.

Logan Kilpatrick : Sono completamente d'accordo. Ad esempio, nei primi test di benchmark HLE, tutti i modelli raggiungevano solo un'accuratezza dell'1-2%, mentre gli ultimi modelli di DeepMind ora raggiungono circa il 40%, il che è sorprendente. I test di benchmark ArcGIS inizialmente non avevano quasi nessun modello in grado di gestirli, ma ora l'accuratezza supera anche il 40%.

Tuttavia, alcuni benchmark statici hanno effettivamente superato la prova del tempo, come GPQA Diamond. Sebbene al momento sia possibile migliorarne l'accuratezza solo di circa l'1%, è ancora ampiamente utilizzato e potrebbe essere prossimo alla saturazione.

Koray Kavukcuoglu : Questi benchmark presentano effettivamente molti problemi complessi che non abbiamo ancora completamente superato, ma hanno comunque un valore di test. Prendiamo ad esempio il GPQA: non abbiamo bisogno di perseguire un tasso di accuratezza assoluta superiore al 90%, poiché siamo già vicini a tale obiettivo, quindi il numero di problemi irrisolti sta naturalmente diminuendo.

Pertanto, è fondamentale trovare nuove frontiere e stabilire nuovi parametri di riferimento. Il benchmarking è un modo per misurare i progressi, ma non rappresenta un allineamento perfetto. Idealmente, i due aspetti sarebbero perfettamente allineati, ma in realtà non potranno mai coincidere perfettamente.

Per me, il criterio più importante per misurare il progresso è: il nostro modello è ampiamente utilizzato nel mondo reale? Scienziati, studenti, avvocati e ingegneri lo usano per risolvere problemi? Le persone lo usano per scrivere, inviare e ricevere e-mail e così via? Il vero progresso, semplice o complesso che sia, risiede nella sua capacità di creare continuamente maggiore valore per gli utenti in più ambiti e scenari. Il benchmarking è semplicemente uno strumento che ci aiuta a quantificare questo progresso.

Logan Kilpatrick : Ho una domanda che non è esattamente controversa: Gemini 3 ha ottenuto risultati eccezionali in numerosi test di benchmark, è stato lanciato simultaneamente su tutti i prodotti Google e gli ecosistemi dei partner e ha ricevuto feedback molto positivi dagli utenti. Guardando al prossimo importante lancio del modello Google, quali aspetti ritieni che dobbiamo migliorare? Ad esempio, "Speriamo di fare meglio in X, Y e Z", oppure dovremmo prima goderci i frutti del successo di Gemini 3?

Koray Kavukcuoglu : Penso che possiamo avere entrambe le cose. Dovremmo goderci il momento; dopotutto, il giorno del rilascio merita di essere festeggiato e il team dovrebbe essere orgoglioso dei propri risultati. Ma allo stesso tempo, vediamo chiaramente che il modello presenta carenze in vari ambiti: la sua capacità di scrittura non è perfetta e la sua capacità di codifica ha margini di miglioramento.

Soprattutto nell'azione degli agenti e nella codifica, c'è ancora ampio margine di miglioramento, che è anche l'area di crescita più interessante. Dobbiamo identificare le aree di ottimizzazione e poi continuare a migliorare. Credo che abbiamo fatto progressi considerevoli: per il 90-95% degli utenti che si occupano di codifica (siano essi ingegneri del software o creativi che cercano di sviluppare prodotti), Gemini 3 è probabilmente il miglior strumento disponibile, ma ci sono effettivamente alcuni scenari che richiedono ulteriore ottimizzazione.

Da "creativo" a "pratico"

Logan Kilpatrick : Cosa ne pensi dell'"ottimizzazione graduale"? Ad esempio, da Gemini 2.5 a 3.0, o in altre iterazioni di versione, quali sono le nostre priorità di ottimizzazione? Con così tanti test di benchmark disponibili oggi, come scegliamo la direzione di ottimizzazione, che si tratti dell'intera serie Gemini o specificamente della versione Pro?

Koray Kavukcuoglu : Credo che ci siano diverse aree chiave cruciali. La prima è la conformità alle istruzioni . Il modello deve comprendere e soddisfare accuratamente le esigenze degli utenti, piuttosto che fornire risposte casuali, un aspetto che abbiamo sempre sottolineato. La seconda è l'internazionalizzazione . L'attività di Google si estende a livello globale e vogliamo che gli utenti di tutto il mondo possano utilizzare questo modello.

Logan Kilpatrick : In effetti, ho parlato con Tulsi stamattina e mi ha detto che questo modello funziona eccezionalmente bene su alcuni linguaggi in cui in precedenza avevamo avuto difficoltà.

Koray Kavukcuoglu : È davvero fantastico. Quindi dobbiamo continuare a concentrarci su queste aree, che potrebbero non essere all'avanguardia ma sono cruciali per l'interazione con l'utente. Come ho detto prima, dobbiamo ricevere feedback dagli utenti.

In ambiti più tecnici, anche le chiamate di funzione, le chiamate di strumenti, le azioni degli agenti e le capacità del codice sono estremamente importanti.

Le chiamate di funzione e di strumento possono migliorare notevolmente l'effetto moltiplicatore intelligente di un modello: il modello può non solo utilizzare in modo naturale gli strumenti e le funzioni esistenti, ma anche scrivere i propri strumenti. In sostanza, il modello stesso è uno strumento.

Le competenze di programmazione sono importanti non solo perché il nostro team è composto da numerosi ingegneri, ma anche perché il codice è il fondamento del mondo digitale. Che si tratti di sviluppo software o di trasformare un'idea in realtà, il codice è indispensabile. Permette di integrare profondamente i modelli in molti aspetti della vita delle persone.

Ad esempio, sono molto ottimista riguardo al "vibe coding". Molte persone sono creative ma non hanno la capacità di dare vita alle proprie idee. Il vibe coding permette loro di passare dalla "creatività" alla "praticità": basta scrivere le proprie idee e l'applicazione corrispondente apparirà davanti a voi, e il più delle volte funzionerà perfettamente.

Questo ciclo chiuso dall'idea al prodotto è fantastico: dà a più persone l'opportunità di diventare creatori.

Logan Kilpatrick : Fantastico! È il perfetto punto di forza per AI Studio, e monteremo questa clip e la pubblicheremo online. Un argomento importante che hai menzionato è stato il lancio simultaneo della piattaforma Google Anti-gravity con il rilascio di Gemini 3. Dal punto di vista del modello, quanto ritieni sia importante questa architettura di prodotto per migliorarne la qualità? Ovviamente, è strettamente correlata all'utilizzo degli strumenti e alle capacità di programmazione.

Koray Kavukcuoglu : Per me, questo è fondamentale. La piattaforma in sé è davvero entusiasmante, ma dal punto di vista del modello, è una strada a doppio senso. In primo luogo, il modello può ricevere feedback dagli utenti finali (ingegneri del software) integrandosi direttamente con loro, il che aiuta a chiarire la direzione in cui il modello necessita di miglioramenti, e questo è fondamentale per noi.

Come Gemini e AI Studio, la piattaforma Anti-gravity è un altro esempio. Questi prodotti ci permettono di entrare in contatto con gli utenti e di ottenere feedback reali, il che rappresenta una risorsa enorme. Sebbene la piattaforma Anti-gravity sia un partner chiave per il lancio solo da poco tempo, il suo feedback ha svolto un ruolo decisivo nei preparativi del lancio nelle ultime due o tre settimane.

Lo stesso vale per la ricerca di modalità di intelligenza artificiale, da cui abbiamo ricevuto un'enorme quantità di feedback. Il benchmarking ci aiuta a far progredire l'intelligenza in campi come la scienza e la matematica, ma comprendere i casi d'uso nel mondo reale è altrettanto importante: i modelli devono essere in grado di risolvere problemi reali.

Gemini 3, un modello per la collaborazione completa del team Google.

Logan Kilpatrick : In qualità di nuovo Chief AI Architect, le tue responsabilità vanno oltre la semplice garanzia di modelli eccellenti; guidi anche i team di prodotto nell'implementazione di tali modelli e nella creazione di esperienze utente straordinarie su tutti i prodotti Google. Il lancio simultaneo di Gemini 3 su tutti i prodotti Google il giorno stesso del lancio è stata una grande sorpresa per gli utenti e ci auguriamo che in futuro copra ancora più prodotti. Dal punto di vista di DeepMind, questa collaborazione tra team aggiunge ulteriore complessità? Dopotutto, un anno e mezzo fa, le cose erano probabilmente molto più semplici.

Koray Kavukcuoglu : Ma il nostro obiettivo è costruire intelligenza, giusto? Molti mi chiedono se ci sia un conflitto tra essere sia CTO che Chief AI Architect, ma per me questi due ruoli sono essenzialmente la stessa cosa.

Per creare intelligenza, è necessario che questa si realizzi attraverso l'interazione tra prodotti e utenti. Il mio obiettivo principale è garantire che tutti i prodotti Google utilizzino la tecnologia più avanzata. Non siamo un team di prodotto, ma piuttosto sviluppatori di tecnologie. Siamo responsabili dello sviluppo di modelli e tecnologie. Naturalmente, abbiamo anche le nostre opinioni sui prodotti, ma soprattutto forniamo supporto tecnico nel miglior modo possibile, collaborando con i team di prodotto per creare i migliori prodotti nell'era dell'intelligenza artificiale.

Questa è una nuova era, in cui le nuove tecnologie stanno ridefinendo le aspettative degli utenti, il comportamento dei prodotti e il modo in cui le informazioni vengono fornite. Pertanto, spero di guidare questa evoluzione tecnologica all'interno di Google, collaborando con tutti i team di prodotto. Questo non è solo vantaggioso per i prodotti e gli utenti, ma anche cruciale per noi stessi.

Solo avvicinandoci agli utenti possiamo comprendere le loro esigenze e ottenere feedback autentici, che rappresentano la forza trainante fondamentale dell'iterazione dei modelli. È così che sviluppiamo l'Intelligenza Artificiale Generale (AGI): crescendo insieme agli utenti attraverso i nostri prodotti.

Logan Kilpatrick : Sono completamente d'accordo. Questa potrebbe essere la didascalia del tuo tweet! Credo anche che stiamo essenzialmente sviluppando l'Intelligenza Artificiale Generale (AGI) insieme ai nostri clienti e partner: non si tratta di una ricerca isolata in un laboratorio, ma di uno sforzo collaborativo con il mondo intero.

Koray Kavukcuoglu : Penso che questo sia anche un "sistema di test affidabile": stiamo sempre più dando importanza al pensiero ingegneristico. Questo pensiero è importante perché un sistema ben progettato è più robusto e sicuro.

Quando realizziamo prodotti concreti, ci basiamo ampiamente sul concetto di "test attendibili", che si riflette nella nostra attenzione alla sicurezza e alla privacy: rendiamo la sicurezza e la privacy principi fondamentali fin dall'inizio, anziché aggiungerli in un secondo momento.

Che si tratti di pre-formazione, perfezionamento o screening dei dati, tutti i membri del team devono tenere in considerazione la sicurezza. Disponiamo certamente di team dedicati alla sicurezza e alla privacy che forniscono supporto tecnico pertinente, ma preferiamo che tutti i membri del team Gemini siano profondamente coinvolti, integrando sicurezza e privacy in ogni fase di sviluppo. Questi team fanno anche parte del team di perfezionamento.

Pertanto, quando si iterano i modelli e si rilasciano versioni candidate, non ci limitiamo a fare riferimento ai risultati dei test di benchmark come GPQA e HLE, ma esaminiamo anche rigorosamente le metriche di sicurezza e privacy. Questa mentalità ingegneristica è fondamentale.

Logan Kilpatrick : Sono pienamente d'accordo. Questo è anche in linea con la cultura aziendale di Google; dopotutto, il lancio del modello Gemini è un'impresa colossale che richiede un lavoro di squadra globale.

Koray Kavukcuoglu : Parlando di Gemini 3, penso che la caratteristica più degna di nota sia che si tratta di un "modello per la collaborazione completa del team di Google".

Logan Kilpatrick : Possiamo esaminare i dati rilevanti. Questo è probabilmente uno dei progetti con il maggior numero di partecipanti nella storia, proprio come il programma Apollo della NASA. È un progetto globale di grandi dimensioni.

Koray Kavukcuoglu : Esatto, è globale.

Logan Kilpatrick : È incredibile che tutti i team di Google siano stati coinvolti.

Koray Kavukcuoglu : Hanno contribuito team da tutto il mondo, tra cui Europa e Asia, non solo del team DeepMind, ma anche di vari dipartimenti di Google. È stato un enorme sforzo collettivo: pubblicarlo contemporaneamente alla modalità AI e all'app Gemini non è stata un'impresa facile.

Questi team di prodotto hanno collaborato a stretto contatto con noi durante la fase di sviluppo del modello, il che ci ha permesso di lanciarlo simultaneamente su tutte le piattaforme il giorno stesso del rilascio. Il termine "pieno coinvolgimento di Google" si riferisce non solo ai team direttamente coinvolti nella creazione del modello, ma anche a tutti i team che hanno svolto i rispettivi compiti e contribuito in modo discreto.

Nano Banana, un nome spontaneo, miscelato naturalmente.

Logan Kilpatrick : Un altro argomento che mi interessa sono i modelli di media generativi: sebbene ci siano sempre stati di interesse, in passato non hanno mai occupato un posto di rilievo. Tuttavia, con il lancio dei modelli Veo 3, Veo 3.1 e Nano Banana, abbiamo ottenuto un grande successo nell'implementazione dei prodotti.

Sono curioso: come vedi il ruolo dei modelli video generativi nel perseguimento dell'Intelligenza Artificiale Generale (AGI)? A volte ho la sensazione che i modelli video sembrino estranei all'AGI, ma a un esame più attento, implicano la comprensione del mondo e delle leggi della fisica, quindi i due aspetti dovrebbero essere interconnessi.

Koray Kavukcuoglu : 10-15 anni fa, i modelli generativi si concentravano principalmente sul dominio delle immagini perché a quel tempo potevamo osservare meglio il processo di generazione delle immagini e comprendere il mondo e le leggi fisiche era anche l'obiettivo principale dei modelli di generazione delle immagini.

L'esplorazione dei modelli generativi da parte di Google risale a 10 anni fa, o anche prima. Quando ero dottorando, tutti lavoravano su modelli di immagini generative, come le reti neurali convoluzionali pixel (Pixel CNN). In seguito, ci siamo resi conto che i progressi nel dominio del testo sarebbero stati ancora più rapidi.

Tuttavia, l'importanza dei modelli di immagine è tornata a essere evidente. DeepMind ha da tempo accumulato una profonda competenza tecnica nei modelli di immagini, video e audio, rendendo l'integrazione di queste tecnologie con i modelli di testo una progressione naturale.

Abbiamo sempre posto l'accento sulla multimodalità, sia in input che in output. Con il progresso tecnologico, le architetture e i concetti dei modelli di testo e dei modelli di immagine stanno convergendo sempre di più. In passato, le loro architetture differivano significativamente, ma ora stanno diventando sempre più simili. Non si tratta di qualcosa che abbiamo deliberatamente promosso, ma piuttosto di un risultato naturale dell'evoluzione tecnologica: tutti stanno esplorando soluzioni più efficienti, i loro concetti si stanno gradualmente unificando e, infine, si è delineato un percorso di sviluppo comune.

Il valore fondamentale di questa fusione risiede nel fatto che i modelli testuali possiedono una conoscenza approfondita del mondo, mentre i modelli di immagini lo comprendono da una prospettiva diversa. Combinando i due, il modello riesce a comprendere meglio l'intento dell'utente e a creare risultati più sorprendenti.

Logan Kilpatrick : Ho un'altra domanda su Nano Banana: pensi che dovremmo dare a tutti i modelli dei nomi interessanti? Potrebbe essere d'aiuto?

Koray Kavukcuoglu : Non necessariamente. Credo che i nomi debbano nascere spontaneamente, non essere scelti deliberatamente. Ad esempio, non abbiamo scelto intenzionalmente il nome Gemini 3.

Logan Kilpatrick : Se la Gemini 3 non si chiamasse così, come la chiameresti? Sarebbe un nome buffo?

Koray Kavukcuoglu : Non lo so, non sono bravo a dare nomi alle cose. In realtà, i nostri modelli Gemini hanno nomi in codice interni, alcuni dei quali sono addirittura generati dal modello Gemini stesso, ma Nano Banana no; non è stato generato dal modello.

C'è una storia dietro questo nome, che credo sia già stata resa pubblica. Credo che finché il nome nasce in modo naturale e spontaneo, sia sufficiente. È significativo che il team che sviluppa il modello possa provare un legame emotivo con il nome.

Il nome "Nano Banana" è stato mantenuto perché lo abbiamo usato durante i test e piaceva a tutti; si è diffuso spontaneamente. Penso che sia difficile creare deliberatamente nomi così naturali attraverso un processo. Se ne avete uno, usatelo; altrimenti, va bene anche un nome standard.

Logan Kilpatrick : Parliamo di Nano Banana Pro, un modello di generazione di immagini all'avanguardia basato su Gemini 3 Pro. Ho sentito dire che, dopo aver completato Nano Banana, il team ha scoperto che l'aggiornamento alla versione Pro ha migliorato significativamente le prestazioni in scenari più dettagliati, come il rendering del testo e la comprensione della conoscenza del mondo. Cosa ne pensi di questo sviluppo?

Koray Kavukcuoglu : Questa è proprio una manifestazione dell'integrazione di diverse tecnologie. Abbiamo sempre detto che ogni versione di Gemini è una famiglia di modelli, come Pro, Flash, ecc., con modelli di dimensioni diverse che impongono compromessi in termini di velocità, precisione e costi. Lo stesso vale per i modelli di generazione delle immagini, il che porta naturalmente a prodotti con posizionamenti diversi.

Basandosi sull'architettura di Gemini 3.0 Pro e combinandola con l'esperienza del modello di prima generazione, il team ha creato un modello di generazione di immagini più potente, ampliandone la scala e ottimizzandone i metodi di ottimizzazione, il che è piuttosto ragionevole. Il suo principale vantaggio risiede nella gestione di scenari complessi: ad esempio, quando si immette un gran numero di documenti complessi, il modello non solo può rispondere a domande pertinenti, ma anche generare infografiche corrispondenti, con risultati eccellenti. Questa è una dimostrazione della naturale fusione tra multimodalità di input e multimodalità di output, il che è fantastico.

Logan Kilpatrick : Sì, è come una magia! Spero che tutti abbiano visto qualche esempio prima che questo video venga pubblicato; alcuni dei casi condivisi internamente sono davvero sorprendenti.

Koray Kavukcuoglu : Sono assolutamente d'accordo! Quando vedi un modello in grado di presentare enormi quantità di testo e concetti complessi in un'immagine chiara e intuitiva, rimani davvero stupito. È una dimostrazione diretta delle capacità del modello.

Logan Kilpatrick : E ci sono molti dettagli che vale la pena apprezzare. Ho un'altra domanda correlata: lo scorso dicembre, Tulsi ha promesso che avremmo rilasciato un checkpoint unificato per il modello Gemini. Ciò che hai appena descritto significa che siamo ormai molto vicini a quell'obiettivo?

Koray Kavukcuoglu : Storicamente, l'architettura dei modelli generativi è stata coerente…

Logan Kilpatrick : Quindi immagino che il nostro obiettivo sia proprio questo: integrare davvero queste funzionalità in un modello, ma nella realtà ci sono sicuramente degli ostacoli. Puoi spiegarlo da una prospettiva macro?

Koray Kavukcuoglu : Come ho detto prima, tecnologia e architettura stanno convergendo, e questa convergenza è una tendenza inevitabile, ma deve essere verificata. Non possiamo basarci su ipotesi soggettive; dobbiamo seguire il metodo scientifico: formulare ipotesi, condurre test e osservare i risultati. A volte ha successo, a volte fallisce, ma questo è il processo del progresso tecnologico.

Ci stiamo avvicinando gradualmente al nostro obiettivo e credo che nel prossimo futuro vedremo un modello più unificato, ma ciò richiederà molta innovazione.

In realtà, questo è piuttosto difficile: lo spazio di output del modello è cruciale perché è direttamente correlato alla qualità del segnale appreso. Attualmente, i nostri segnali appresi provengono principalmente da codice e testo, motivo per cui il modello funziona bene in questi ambiti.

La generazione di immagini, tuttavia, è diversa: richiede una qualità estremamente elevata, che richiede non solo la precisione a livello di pixel, ma anche la coerenza del concetto di immagine, ovvero ogni pixel deve conformarsi alla logica dell'immagine complessiva. Ottenere contemporaneamente una buona generazione di testo e immagini è molto difficile. Ma credo che sia assolutamente fattibile; richiede solo di trovare una direzione adeguata per l'innovazione del modello.

Logan Kilpatrick : È davvero entusiasmante! Speriamo che renda anche il nostro lavoro più efficiente, ad esempio grazie a un checkpoint del modello unificato.

Koray Kavukcuoglu : È difficile dirlo, ma è molto probabile.

Tutto si basa sull'apprendimento.

Logan Kilpatrick : Ho un'altra domanda sulla codifica e sull'utilizzo degli strumenti. Ripensando allo sviluppo di Gemini: la versione 1.0 si concentrava sul calcolo multimodale, mentre la versione 2.0 ha iniziato a costruire l'infrastruttura. Nonostante i nostri rapidi progressi, perché non abbiamo raggiunto fin dall'inizio lo stato dell'arte nell'utilizzo degli strumenti per agenti nel dominio multimodale? Dopotutto, Gemini 1.0 ha costantemente aperto la strada al calcolo multimodale.

Koray Kavukcuoglu : Non credo che fosse intenzionale. A dire il vero, credo che sia strettamente correlato a quanto l'ambiente di sviluppo del modello sia vicino al mondo reale. Più è vicino alla realtà, meglio riesce a comprendere le reali esigenze dell'utente.

Lo sviluppo di Gemini è anche un processo di passaggio dalla "ricerca pura" al "pensiero ingegneristico" e di profonda integrazione con il prodotto. Google vanta una solida base nella ricerca sull'intelligenza artificiale e vanta numerosi ricercatori di spicco, ma ciò che rende Gemini speciale è il fatto di averci fatto passare dalla "scrittura di articoli e ricerca" allo "sviluppo insieme agli utenti attraverso i prodotti".

Sono orgoglioso del nostro team: quattro o cinque anni fa, la maggior parte di noi, me compreso, si concentrava sulla pubblicazione di articoli e sulla ricerca sull'intelligenza artificiale. Ora siamo all'avanguardia della tecnologia, guidando insieme l'iterazione tecnologica attraverso prodotti e utenti.

Questa trasformazione è notevole: pubblichiamo un nuovo modello ogni sei mesi e lo aggiorniamo ogni mese o mese e mezzo. Credo che sia in questo processo che abbiamo gradualmente migliorato la nostra capacità di utilizzare strumenti basati su agenti intelligenti.

Logan Kilpatrick : Un altro punto interessante: DeepMind vanta ora numerosi prodotti di intelligenza artificiale leader a livello mondiale, come Vibe Coding, AI Studio, Gemini e la piattaforma Anti-gravity. Anche Google ha molti modelli all'avanguardia, come Gemini 3, Nano Banana e Veo. Dieci o anche quindici anni fa, il mondo era completamente diverso.

Sono curioso. Ripensando alla tua carriera, ieri hai detto di essere stato il primo ricercatore di DeepMind nel campo del deep learning, cosa che ha sorpreso me e altri. Da 13 anni fa (2012), quando il deep learning era visto con scetticismo, a oggi, che questa tecnologia alimenta numerosi prodotti ed è una forza trainante fondamentale, cosa ne pensi? Tutto questo era previsto o ti ha sorpreso?

Koray Kavukcuoglu : Penso che questo sia il risultato ideale. Come chiunque intraprenda un dottorato di ricerca, ti convinci che ciò che stai facendo è importante e avrà un impatto significativo: questa era la mia mentalità all'epoca.

Quindi, quando Demi e Shane mi hanno contattato e mi hanno detto che DeepMind era un team focalizzato sullo sviluppo di intelligenza, con il deep learning al centro, ero incredibilmente entusiasta. Il mio amico Carl Greger e io (entrambi provenivamo dal laboratorio di Jan alla New York University) ci siamo uniti a DeepMind nello stesso periodo. All'epoca, le startup focalizzate sul deep learning e sull'intelligenza artificiale erano molto rare, quindi la visione di DeepMind era davvero straordinaria e lavorare lì era incredibilmente entusiasmante. In seguito, ho creato il mio team di deep learning e l'ho visto crescere e prosperare.

Il mio atteggiamento nei confronti del deep learning è sempre stato: basarlo sui principi fondamentali e aderire a una mentalità "basata sull'apprendimento", che è anche la filosofia fondamentale di DeepMind: tutto si basa sull'apprendimento.

Ripensando a questo percorso, dai primi DQN, AlphaGo, AlphaZero e AlphaFold all'attuale Gemini, è un'esperienza davvero emozionante. Abbiamo sempre avuto aspettative positive, ma allo stesso tempo ci sentiamo molto fortunati.

Siamo fortunati a vivere in quest'epoca. Molte persone hanno dedicato la propria vita all'intelligenza artificiale o alle proprie passioni, sperando di assistere a un'esplosione tecnologica, e ora è davvero avvenuta. L'ascesa dell'intelligenza artificiale non è dovuta solo ai progressi nell'apprendimento automatico e nel deep learning, ma è anche inscindibile dallo sviluppo dell'hardware, di Internet e dei dati: tutti questi fattori hanno contribuito alla situazione odierna. Pertanto, sono orgoglioso di aver scelto il campo dell'intelligenza artificiale e mi sento fortunato di vivere in quest'epoca. È davvero entusiasmante.

Logan Kilpatrick : Di recente ho guardato la serie video "The Thinking Game" e ho scoperto la storia di AlphaFold. Non ho vissuto quell'epoca in prima persona, quindi la conosco solo attraverso materiali e racconti di altre persone. Hai partecipato a diversi progetti importanti presso DeepMind. In che modo ritieni che il tuo lavoro attuale differisca da quello passato? Ad esempio, prima hai detto che "abbiamo padroneggiato i metodi per diffondere modelli nel mondo". In che modo questa sensazione è simile o diversa dai tuoi progetti precedenti?

Koray Kavukcuoglu : Come si organizza un team e si coltiva una cultura aziendale che trasformi complessi problemi scientifici e tecnologici in risultati di successo? Credo che abbiamo acquisito molta esperienza da diversi progetti, da DQN, AlphaGo e AlphaZero ad AlphaFold, tutti con un impatto profondo. Abbiamo imparato a organizzare team di grandi dimensioni per lavorare su obiettivi e missioni specifici.

Ricordo che agli albori di DeepMind, 25 persone lavoravano insieme a un progetto per pubblicare un articolo: molti si chiedevano come 25 persone potessero collaborare a un singolo articolo, ma ci riuscimmo. Una collaborazione così ampia è rara nella ricerca scientifica, ma l'abbiamo ottenuta grazie a un'organizzazione efficace. Questa esperienza e questa mentalità si sono evolute nel tempo e sono diventate sempre più importanti.

Negli ultimi due o tre anni abbiamo incorporato anche il pensiero ingegneristico: abbiamo una direzione di sviluppo principale per il modello e abbiamo imparato a esplorare in base a tale direzione principale.

Penso che Deep Think sia un buon esempio: lo abbiamo utilizzato per partecipare a competizioni di alto livello come l'International Mathematical Olympiad (IMO) e l'International Collegiate Programming Contest (ICPC). Queste competizioni presentano problemi estremamente complessi e molti vorrebbero personalizzare un modello appositamente per la competizione, ma abbiamo scelto di sfruttarlo come un'opportunità per ottimizzare il nostro modello esistente.

Crediamo fermamente nella versatilità della tecnologia. Attraverso i concorsi, esploriamo nuove idee, le integriamo in modelli esistenti e, infine, creiamo modelli in grado di partecipare a competizioni di alto livello, che poi rendiamo disponibili a tutti.

Logan Kilpatrick : Questo mi ricorda un parallelo: prima, 25 persone collaboravano a un articolo, ma ora l'elenco dei collaboratori di Gemini 3 potrebbe arrivare a 2.500 persone. Molti potrebbero pensare: "Come è possibile che 2.500 persone siano coinvolte?", ma è vero. Questo modo di risolvere i problemi attraverso una collaborazione su larga scala è davvero sorprendente.

Koray Kavukcuoglu : Questo è molto importante, ed è qui che risiede la forza di Google. Google ha capacità tecniche complete, dalle quali possiamo trarre vantaggio: dai data center, ai chip e alle reti, fino all'implementazione di modelli su larga scala, ci sono esperti in ogni fase.

Tornando al tema del pensiero ingegneristico, questi aspetti sono inscindibili. Quando progettiamo un modello, consideriamo l'hardware su cui verrà eseguito; e quando progettiamo la prossima generazione di hardware, anticipiamo la direzione futura del modello. Questa collaborazione è meravigliosa, ma coordinare così tanti aspetti richiede davvero l'impegno congiunto di migliaia di persone. Dobbiamo riconoscere il valore di questa collaborazione: è davvero straordinaria.

Logan Kilpatrick : Non è un'impresa facile. Tornando alla tradizione di DeepMind: abbiamo sempre adottato un approccio scientifico multidisciplinare, cercando di risolvere una varietà di problemi interessanti. E ora, abbiamo chiaramente dimostrato l'efficacia di questa tecnologia in diversi campi; dobbiamo semplicemente continuare a svilupparla su larga scala. Naturalmente, questo richiede anche innovazione.

Secondo lei, come riesce DeepMind a bilanciare "pura esplorazione scientifica" e "espansione della portata di Gemini" al giorno d'oggi? Ad esempio, il "modello di diffusione di Gemini" è una manifestazione di questo processo decisionale.

Koray Kavukcuoglu : Questa è la domanda più cruciale: trovare un equilibrio tra i due è essenziale.

Molti mi chiedono ora qual è il rischio maggiore per i Gemelli. Ci ho pensato attentamente e la risposta è "la mancanza di innovazione". Non credo assolutamente che abbiamo trovato una "formula universale" da seguire passo dopo passo.

Il nostro obiettivo è sviluppare un'intelligenza generale, che richiede una profonda integrazione con utenti e prodotti. Tuttavia, questo obiettivo rimane di per sé estremamente impegnativo e non disponiamo di soluzioni pronte all'uso. L'innovazione è la forza trainante per raggiungere questo obiettivo.

L'innovazione può assumere diverse scale e direzioni: nell'ambito del progetto Gemini esploriamo nuove architetture, nuove idee e nuovi metodi; nel complesso, Google DeepMind condurrà anche ulteriori esplorazioni interdisciplinari, perché alcune idee potrebbero essere troppo limitate all'interno del progetto Gemini per essere pienamente sviluppate.

Pertanto, Google DeepMind e Google Research devono esplorare insieme varie idee e poi integrarle in Gemini, perché Gemini non è un'architettura, ma un obiettivo: creare un'intelligenza generale in modo che tutti i prodotti Google possano funzionare su questo motore di intelligenza artificiale.

Indipendentemente dall'architettura che adotteremo, continueremo a evolverci e l'innovazione sarà sempre la forza trainante principale. Trovare un equilibrio, o avanzare nell'esplorazione in modi diversi, è fondamentale.

Logan Kilpatrick : Ho una domanda correlata: alla conferenza I/O ho parlato con Sergey e quando si riuniscono così tante persone per lanciare modelli e promuovere l'innovazione, si percepisce una sorta di "calore umano" – lo capisco profondamente. Ero seduto accanto a te in quel momento e ho percepito anch'io il tuo entusiasmo.

Questo è molto significativo per me personalmente perché riflette la cultura generale di DeepMind: una solida base scientifica unita a un'atmosfera di squadra amichevole e inclusiva. Molti potrebbero non rendersi conto dell'importanza di questa cultura e di come influenzi il lavoro. Come team leader, come vedi la manifestazione di questa cultura?

Koray Kavukcuoglu : Innanzitutto, grazie per il complimento; mi imbarazza un po'. Ma credo davvero nel potere del lavoro di squadra e nell'importanza di fidarsi e dare opportunità agli altri. Il lavoro di squadra è fondamentale, ed è qualcosa che ho imparato durante il mio periodo in DeepMind.

Abbiamo iniziato come un piccolo team e abbiamo mantenuto la fiducia reciproca durante tutta la nostra crescita. Credo sia fondamentale creare un ambiente "focalizzato sulla risoluzione di problemi tecnici e scientifici complessi e di grande impatto", ed è ciò che stiamo facendo ora.

Al centro di Gemini c'è la costruzione dell'intelligenza generale, un problema tecnico e scientifico estremamente impegnativo che dobbiamo affrontare con umiltà, mettendoci costantemente in discussione e ottimizzandoci. Spero che anche il team possa percepire questo; sono davvero orgoglioso del nostro team, dei loro sforzi uniti e del loro supporto reciproco.

Mentre parlavo prima con il team nella sala relax, "È dura, siamo tutti esausti, ma questa è la norma quando si sviluppa una tecnologia all'avanguardia. Non abbiamo processi perfetti, ma tutti danno il massimo e si supportano a vicenda". Ciò che rende tutto questo interessante e significativo, e ciò che ci dà il coraggio di affrontare le sfide, è in gran parte "avere un team eccellente", dove tutti lavorano insieme per realizzare il potenziale della tecnologia.

Posso affermare con certezza che l'architettura Large Language Model (LLM) che utilizziamo oggi sarà sicuramente obsoleta tra 20 anni. Pertanto, esplorare continuamente nuove direzioni è la scelta giusta. Google DeepMind, Google Research e l'intera comunità di ricerca accademica devono collaborare per far progredire l'esplorazione in molteplici campi.

Credo che non dovremmo fissarci su "cosa è giusto e cosa è sbagliato". Ciò che conta davvero è la capacità e le prestazioni della tecnologia nel mondo reale.

Logan Kilpatrick : Un'ultima domanda: durante il mio primo anno in Google, ho personalmente avvertito una sensazione di "ritorno di Google". Nonostante il forte vantaggio infrastrutturale di Google, nel campo dell'intelligenza artificiale sembravamo recuperare costantemente terreno. Ad esempio, nelle prime fasi di AI Studio non avevamo utenti (che poi sono cresciuti fino a 30.000), nessun fatturato e anche il modello Gemini era agli albori.

Ora, con l'uscita di Gemini 3, ho ricevuto molti feedback da diverse parti dell'ecosistema, e le persone sembrano finalmente rendersi conto che "l'era dell'intelligenza artificiale di Google è arrivata". Avete mai provato questa sensazione di "ritorno"? Credevate che saremmo potuti arrivare dove siamo oggi? Che impatto avrà questo cambio di ruolo sul team?

Koray Kavukcuoglu : Man mano che il potenziale dei Large Language Model (LLM) diventa sempre più evidente, dico francamente che, pur considerando DeepMind un laboratorio di intelligenza artificiale all'avanguardia, mi rendo anche conto che noi ricercatori non abbiamo investito abbastanza in alcune aree. Questa è una lezione importante per me: dobbiamo ampliare la nostra esplorazione e l'innovazione è fondamentale, piuttosto che limitarci a una singola architettura.

Sono sempre stato onesto con il team: circa due anni e mezzo fa, quando abbiamo iniziato a prendere sul serio i modelli linguistici di grandi dimensioni e abbiamo lanciato il progetto Gemini, eravamo indietro rispetto allo stato dell'arte sotto molti aspetti. C'erano molte cose che non sapevamo e, sebbene avessimo i nostri vantaggi, eravamo effettivamente in una fase di recupero.

Questo processo di recupero è durato a lungo e ora credo che siamo entrati nel gruppo di testa. Sono molto soddisfatto del nostro ritmo di sviluppo, delle dinamiche di squadra e del ritmo collaborativo. Ma dobbiamo affrontare le sfide del precedente percorso di recupero.

Nel processo di recupero, dobbiamo imparare dai punti di forza degli altri, pur continuando a innovare e a trovare soluzioni adatte a noi: che si tratti di tecnologia, modelli, processi o metodi di lavoro di squadra, tutto questo è unico per noi.

Molti dicono: "Google è troppo grande e inefficiente", ma credo che questo possa trasformarsi in un vantaggio. Abbiamo la capacità di realizzare progetti unici e su larga scala, come rendere Gemini disponibile su tutti i prodotti Google contemporaneamente. Sono molto soddisfatto del mio attuale posizionamento, ma questo risultato è stato ottenuto grazie a un apprendimento e a un'innovazione continui. È davvero una storia di "rimonta" straordinaria.

Naturalmente, ci saranno sempre dei paragoni, ma il nostro obiettivo rimane lo stesso: costruire un'intelligenza generale. E vogliamo riuscirci nel modo giusto, dedicando a questo tutti i nostri sforzi e la nostra innovazione.

Logan Kilpatrick : Credo che i prossimi sei mesi saranno entusiasmanti tanto quanto i sei mesi passati, e persino quelli precedenti. Grazie ancora per aver dedicato del tempo a questa intervista, è stata un'esperienza molto piacevole! Spero di poterci risentire prima della conferenza I/O del prossimo anno.

Anche se sembra un'eternità, il tempo volerà sicuramente. Credo che la prossima settimana si terrà una riunione di pianificazione per la conferenza I/O 2026. Congratulazioni ancora a te, al team di DeepMind e a tutti i ricercatori di modelli per il lancio di successo di Gemini 3, Nano Banana Pro e una serie di altri prodotti!

Koray Kavukcuoglu : Grazie! Questo scambio è stato fantastico. Grazie al team per il duro lavoro e grazie per l'invito!

#Benvenuti a seguire l'account WeChat ufficiale di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.