Amazon Web Services presenta la sua gamma più potente di agenti di intelligenza artificiale, in grado persino di progettare razzi.

Come suggerisce il nome, re:Invent non è solo il nome del summit annuale di Amazon Web Services, ma anche il messaggio fondamentale che trasmette ogni anno al mondo esterno: in questo settore, l'unica costante è ribaltare il passato.

Se l'ultimo decennio di re:Invent riguardava come "rimodellare" le risorse informatiche in infrastrutture prontamente disponibili come acqua ed elettricità, quest'anno ha inviato un segnale completamente diverso: nella seconda metà del cloud computing, l'attenzione della competizione si è spostata dalla "fornitura di risorse" alla "fornitura di capacità".

A Las Vegas, Amazon Web Services ha lanciato 25 nuovi prodotti in 10 minuti, nel tentativo di rispondere a una domanda che assilla il settore: perché, dopo due anni di clamore attorno ai modelli su larga scala, la crescita esponenziale delle applicazioni di livello aziendale è stata lenta ad arrivare?

La risposta di Amazon Web Services al mondo è questa: è arrivata l'era dell'intelligenza artificiale agentiva per le aziende.

Versione "Troppo lungo, non letto":

Versione "Troppo lungo, non letto":

• Debutta la famiglia Frontier Agents: vengono introdotti tre agenti all'avanguardia (Kiro Autonomous Agent, Security Agent e DevOps Agent), che introducono un nuovo paradigma di automazione nello sviluppo, nella sicurezza e nelle operazioni del software.

• Ulteriore evoluzione dei chip sviluppati internamente: Amazon ha lanciato ufficialmente i Trainium 3 UltraServer, con un miglioramento delle prestazioni di 4,4 volte. Ha inoltre presentato in anteprima il chip Trainium 4 di nuova generazione, più potente.

• La famiglia di modelli auto-sviluppati è stata completamente aggiornata: è stata rilasciata la famiglia di modelli Amazon Nova 2, che include quattro modelli principali: Lite, Pro, Sonic (voce) e Omni (multimodale), che coprono tutti gli scenari, da quelli leggeri a quelli complessi.

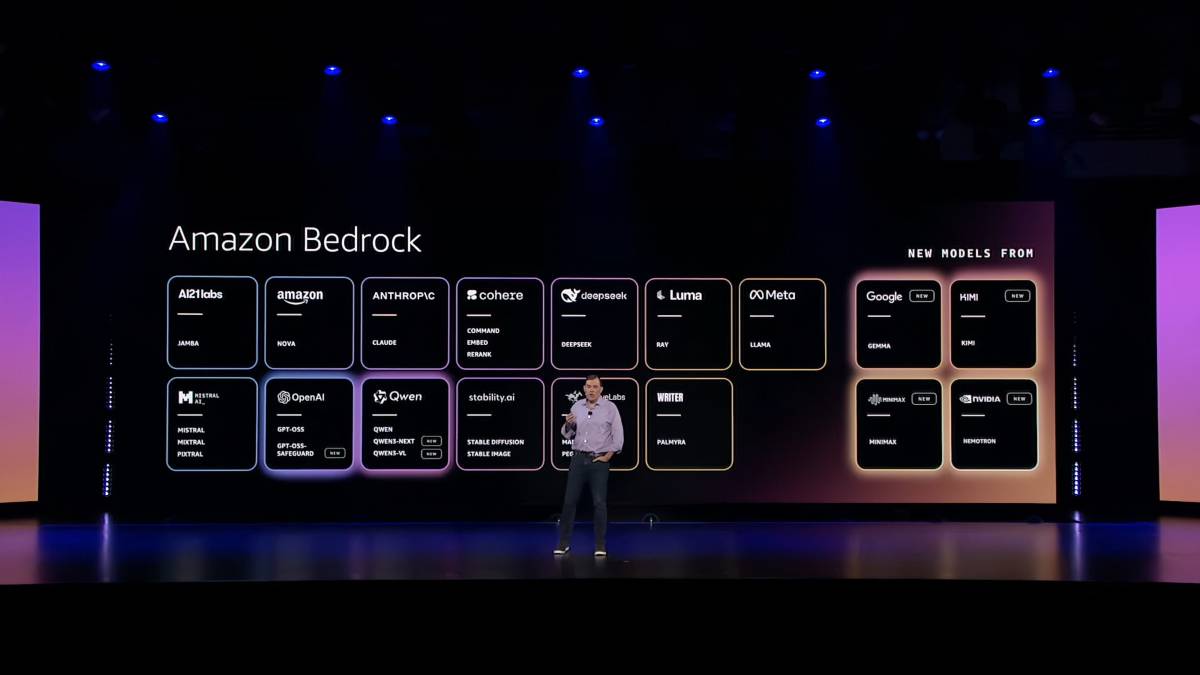

• Amazon Bedrock abbraccia grandi modelli cinesi: la piattaforma Amazon Bedrock si è ulteriormente ampliata, incorporando per la prima volta diversi grandi modelli cinesi di punta, tra cui Kimi, MiniMax e Qwen.

• Una rivoluzione nella personalizzazione dei modelli: è stato lanciato Amazon Nova Forge, che ha introdotto il concetto di "modelli di formazione aperti", che consente alle aziende di incorporare i propri dati nella fase di pre-formazione di un modello di base per creare modelli proprietari profondamente personalizzati.

• Governance del comportamento degli agenti: rilasciare la policy AgentCore e le valutazioni AgentCore per definire i limiti comportamentali per gli agenti di intelligenza artificiale che utilizzano il linguaggio naturale e valutare continuamente la qualità del loro lavoro, risolvendo le sfide di credibilità e controllabilità nelle applicazioni di intelligenza artificiale aziendali.

• L'attenuazione dei confini del cloud: il rilascio di "Amazon AI Factories" consente di distribuire l'infrastruttura di intelligenza artificiale di Amazon Web Services direttamente nei data center dei clienti.

Rimodellare la produttività: trasformare l'intelligenza artificiale da "strumento" a "collega"

Negli ultimi due anni, siamo stati abituati a chiamare l'IA negli ambienti di produzione aziendali Copilot, ma Amazon Web Services ritiene che non sia sufficiente. Copilot, o i tradizionali "assistenti" di IA, richiedono un monitoraggio costante e adattamenti delle istruzioni in base alle loro attività e prestazioni; ciò che le aziende desiderano veramente sono agenti in grado di ricevere obiettivi, pensare in modo indipendente e utilizzare vari strumenti per completare le attività.

Pertanto, negli ultimi anni, il focus principale di Amazon Web Services (AWS) si è spostato dalla fornitura di strumenti alla fornitura di "lavoratori". Al re:Invent di quest'anno, abbiamo visto AWS dedicare gran parte del suo tempo agli agenti di intelligenza artificiale e presentare la sua più grande strategia di distribuzione di agenti di sempre.

Il valore degli agenti IA risiede nelle loro "azioni". Sono una specie completamente nuova, distinta dagli assistenti IA, e sono dotati della capacità di pianificare autonomamente, operare per lunghi periodi ed eseguire compiti complessi in parallelo.

—Swami Sivasubramanian, Vicepresidente di Agentic AI presso Amazon Web Services

Il primo passo per l'implementazione su larga scala di agenti di intelligenza artificiale è progettare "dipendenti digitali" dotati di competenze uniche.

Come manifestazione concreta di questo concetto, sono stati lanciati ufficialmente i Frontier Agent. Tra questi, agenti come Kiro autonomous agent (sviluppatore virtuale), Amazon Security Agent (consulente per la sicurezza) e Amazon DevOps Agent (esperto operativo) sono già stati "sperimentati" in diverse aziende, dimostrando un'eccellente efficienza.

Ad esempio, l'agente autonomo Kiro per sviluppatori virtuali può connettersi a Jira e Slack, comprendere la logica aziendale e gli standard di collaborazione del team e completare attività banali come modifiche tra database e correzioni di bug 24 ore su 24 in modo standardizzato, consentendo ai membri del team di concentrarsi maggiormente sugli aspetti innovativi chiave.

In un caso all'interno di Amazon Web Services, un team di sei persone ha utilizzato Kiro per completare in soli 76 giorni un progetto di refactoring architettonico che normalmente avrebbe richiesto 30 persone e 18 mesi. Durante questo periodo, Kiro ha analizzato autonomamente 15 microservizi, testando e inviando codice quasi interamente "autonomo".

Blue Origin, che ha stretti legami con Amazon, ha coraggiosamente introdotto questo processo nella progettazione dei sistemi aerospaziali: dalla definizione dei requisiti e dalla comunicazione dei materiali all'architettura di sistema più avanzata e alla simulazione fisica, Blue Origin utilizza la sua piattaforma interna BlueGPT per chiamare più agenti a supporto della ricerca e sviluppo, aumentando la velocità di consegna complessiva del 75%.

Dietro le capacità avanzate degli agenti si cela un aggiornamento del "cervello" dei modelli. La famiglia di modelli Amazon Nova, che supporta vari agenti, è stata completamente aggiornata alla sua seconda generazione, tra cui l'economico Amazon Nova 2 Lite, il modello intelligente più potente di Amazon, Amazon Nova 2 Pro, Amazon Nova 2 Sonic incentrato sul dialogo vocale simile a quello umano e il primo modello multimodale veramente unificato del settore, Amazon Nova 2 Omni. Amazon Web Services aderisce alla filosofia secondo cui "nessun singolo modello può dominare tutto" e questa famiglia di modelli diversificata mira a rendere gli agenti più obbedienti e capaci.

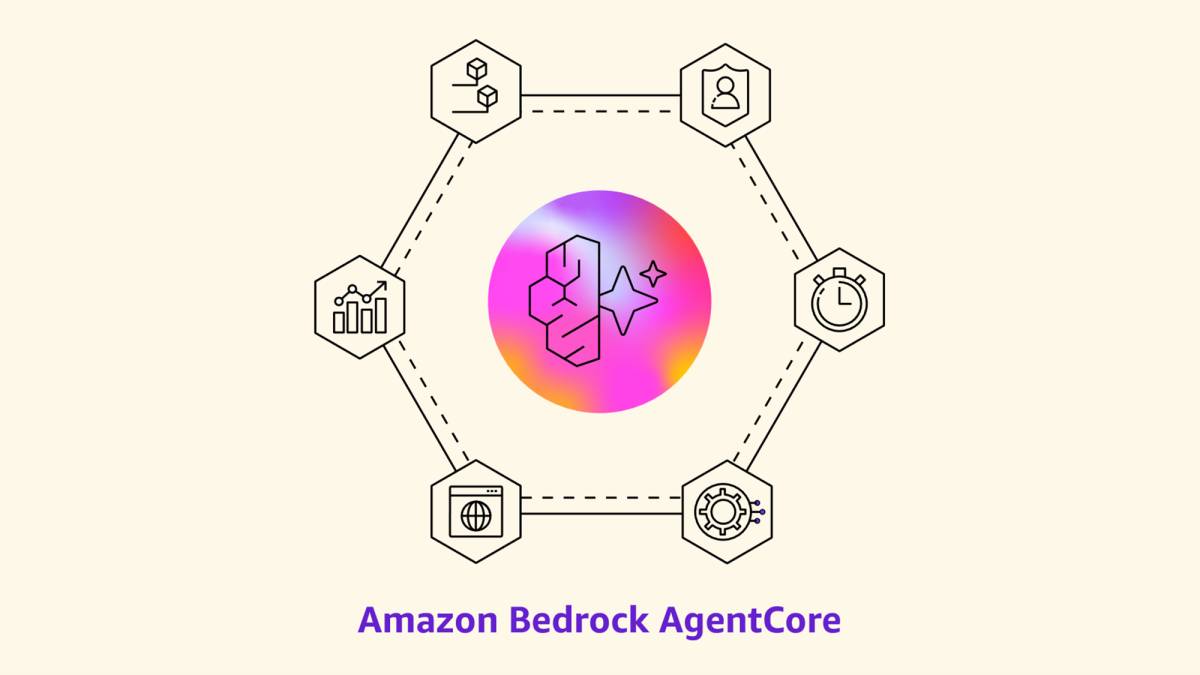

Per incoraggiare le aziende a integrare con sicurezza questi potenti agenti nei loro flussi di lavoro principali, Amazon Web Services ha creato Amazon Bedrock AgentCore, un set completo di meccanismi di governance comportamentale aggiunti alla piattaforma di creazione di Bedrock Agent.

Con la funzionalità AgentCore Policy , i manager possono impostare "linee rosse" inviolabili per gli agenti utilizzando un linguaggio semplice come "vietare rimborsi ai clienti per importi superiori a 1.000 dollari", impedendo che errori di intelligenza artificiale causino perdite significative all'azienda. La funzionalità AgentCore Evaluations offre 13 valutatori integrati per monitorare costantemente la qualità delle prestazioni degli agenti, in modo simile alle valutazioni delle prestazioni. La nuova funzionalità AgentCore Memory introduce la "memoria contestuale", consentendo agli agenti di apprendere dalle esperienze passate e ricordare le preferenze e il contesto degli utenti.

Vale la pena notare che Amazon Web Services (AWS) dimostra anche una notevole inclusività dell'ecosistema. Sulla piattaforma Amazon Bedrock, abbiamo trovato DeepSeek, Kimi, MiniMax e Qwen. Ciò significa che le aziende possono accedere senza problemi alle principali funzionalità del modello di intelligenza artificiale cinese sull'infrastruttura globale di AWS, come Kimi K2, che eccelle nell'inferenza e nell'utilizzo degli strumenti, e MiniMax M2, che si concentra sulla codifica.

Chiaramente, la prossima visione di Amazon Web Services è quella di potenziare l'unità di produttività delle aziende, passando da individui a team ibridi di "persone + agenti", consentendo agli esseri umani di occuparsi solo di problemi veramente importanti e liberando completamente la produttività.

Ristrutturazione dei costi: riduzione dei costi di potenza di calcolo e aumento dell'efficienza, superando il limite minimo dei prezzi.

Trasformare l'intelligenza artificiale in un'infrastruttura come quella dell'acqua e dell'elettricità è sempre stato uno degli argomenti più interessanti del settore. Tuttavia, molti hanno notato che gli attuali costi della potenza di calcolo sembrano troppo elevati, abbastanza alti da soffocare l'innovazione per la maggior parte delle aziende.

Il principale vantaggio competitivo di Amazon Web Services risiede proprio nella sua capacità di ridurre drasticamente i prezzi attraverso il suo sistema completo e le sue eccezionali capacità ingegneristiche.

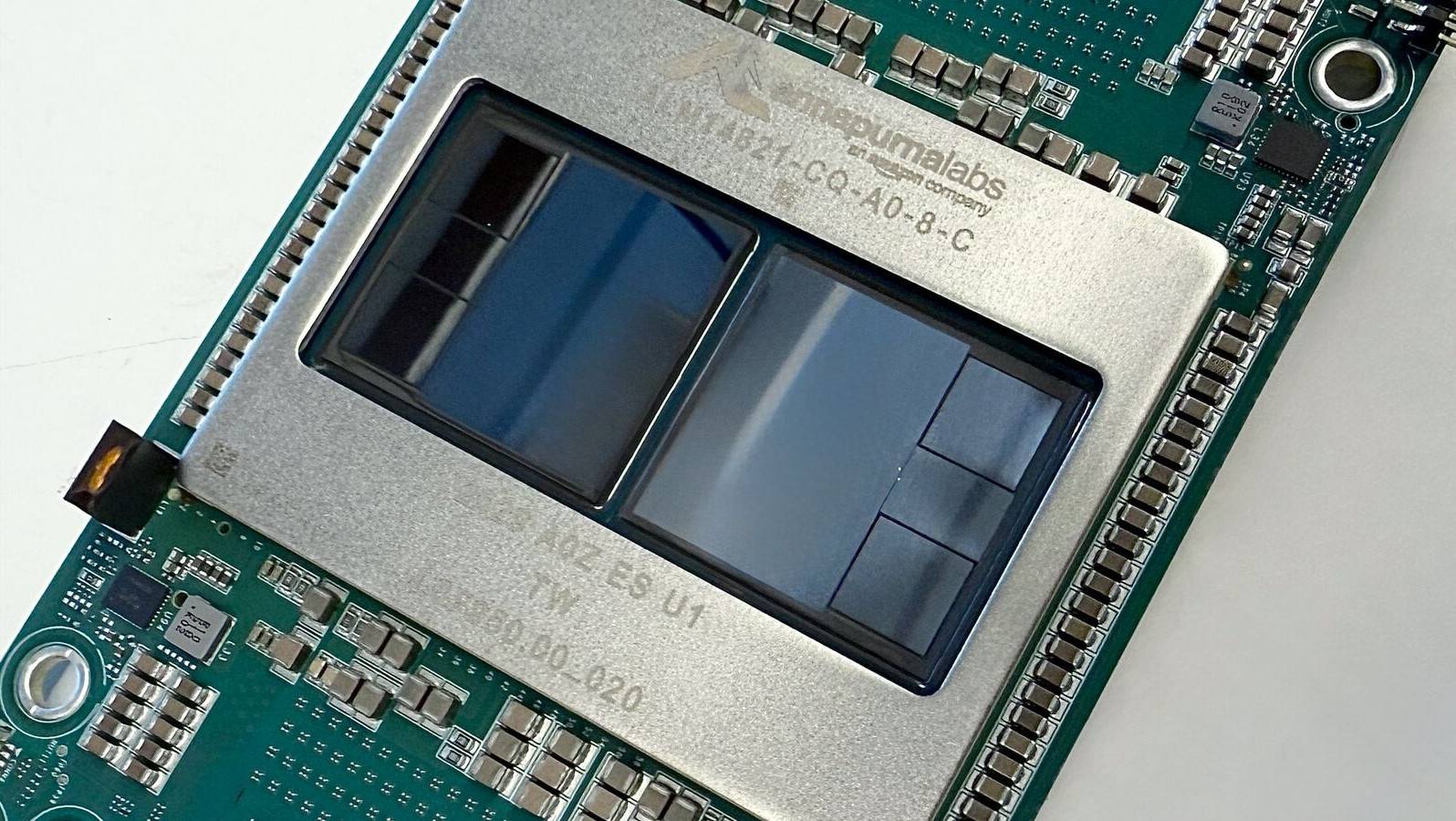

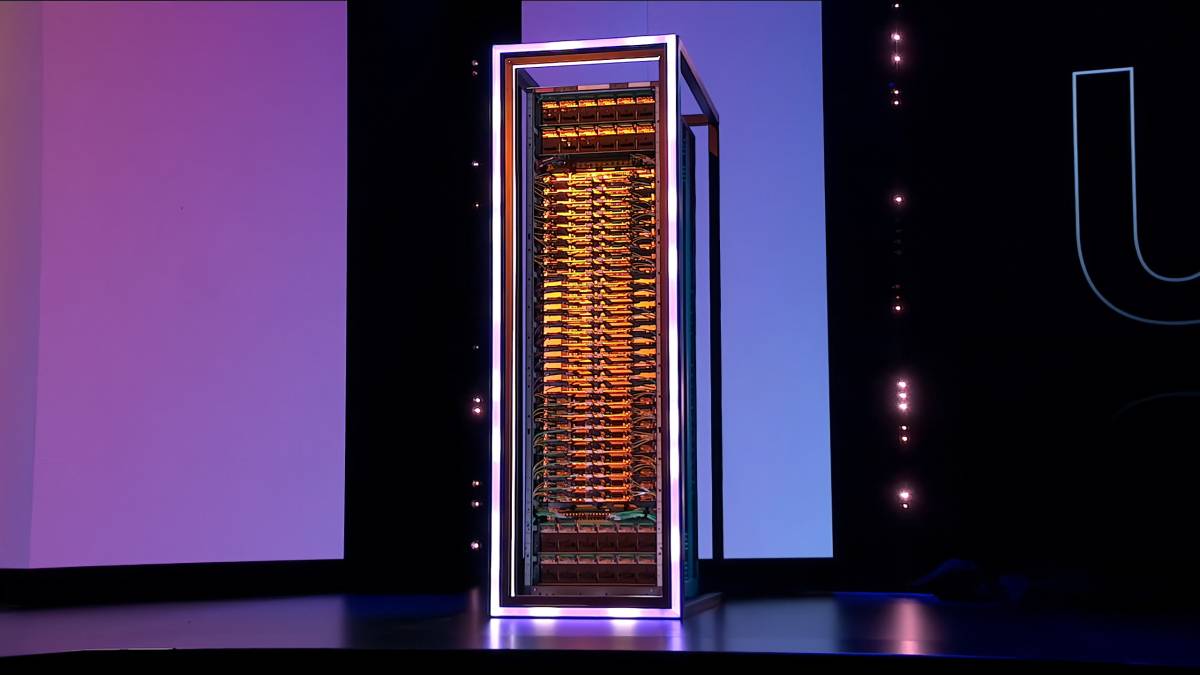

Durante il discorso di apertura del primo giorno, il CEO di Amazon Web Services, Matt Garman, ha annunciato il lancio di Trainium 3 , il primo chip AI da 3 nm nel cloud, e ha anche presentato gli Amazon Trainium 3 UltraServer basati su di esso, che forniscono alle aziende la potenza di calcolo necessaria per l'addestramento e l'inferenza dell'AI.

Gli Amazon Trainium 3 UltraServer, che possono integrare fino a 144 chip Trainium 3 in un unico sistema, offrono una potenza di elaborazione 4,4 volte superiore, una larghezza di banda di memoria 3,9 volte superiore e, soprattutto, un'efficienza energetica superiore del 40% rispetto alla generazione precedente. Ciò significa che le aziende possono generare 5 volte più token con lo stesso consumo energetico.

I chip sviluppati internamente da Amazon Web Services rappresentano il suo punto di forza nel competere con le costose GPU e una promessa per le aziende: far sì che l'addestramento e l'inferenza dell'intelligenza artificiale non siano più appannaggio esclusivo dei giganti. Clienti come Anthropic, Ricoh e Splash Music hanno già ridotto i costi di addestramento del 50% grazie a Trainium.

Inoltre, Amazon Web Services ha annunciato il suo chip di nuova generazione, Trainium 4, che offrirà prestazioni di elaborazione 6 volte superiori a quelle di FP4 e una larghezza di banda di memoria 4 volte superiore, superando la legge di Moore per soddisfare le maggiori esigenze di addestramento di modelli al mondo e ridurre le preoccupazioni relative ai costi per le aziende.

Oltre a migliorare l'efficienza energetica dell'hardware, anche la riduzione del consumo di potenza di calcolo sul lato software è un aspetto cruciale della strategia di economicità delle aziende. A questo proposito, Amazon Web Services ha dimostrato un brillante esempio di sinergia hardware-software:

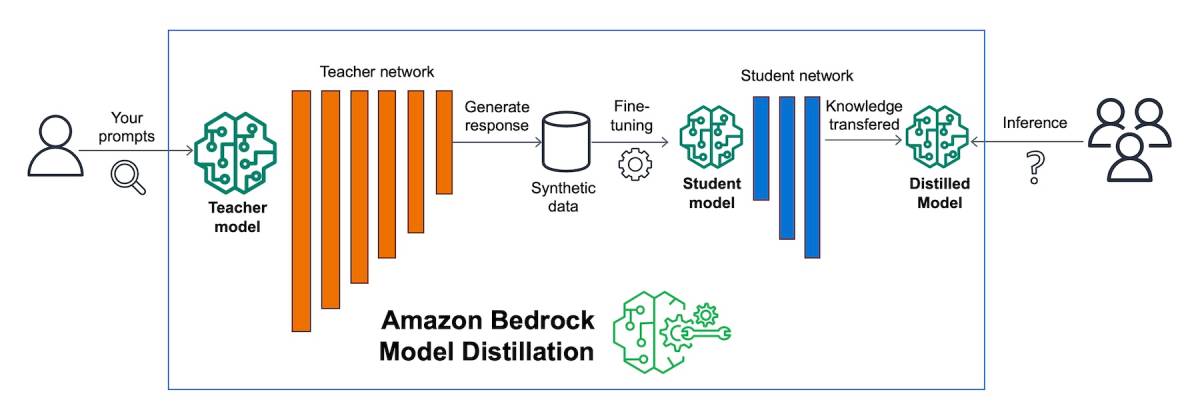

Amazon Web Services ritiene che le aziende non abbiano sempre bisogno di modelli più grandi. Pertanto, il suo nuovo sistema Amazon Bedrock Model Distillation consente alle aziende di utilizzare modelli di grandi dimensioni (insegnanti) per insegnare a modelli più piccoli (studenti), ottenendo prestazioni elevate e simili a un decimo del costo. In combinazione con ottimizzazioni specializzate per enormi quantità di dati utilizzando tecnologie di storage e database come Amazon S3 Tables e Aurora DSQL, Amazon Web Services sta eliminando sistematicamente i costi superflui associati all'intelligenza artificiale.

Tutte le innovazioni nelle applicazioni di livello superiore si basano sul supporto dell'infrastruttura sottostante. Solo quando la potenza di calcolo sarà economica e facilmente reperibile come l'acqua e l'elettricità, l'esplosione delle applicazioni di intelligenza artificiale avrà una base realistica.

Ridefinire i confini: la "consegna porta a porta" supera i limiti di localizzazione delle funzionalità cloud

Per molto tempo, un muro invisibile ha diviso i cloud pubblici dai data center privati. A causa della sovranità dei dati, della bassa latenza o dei requisiti di conformità, molte operazioni aziendali critiche in reparti sensibili non possono essere migrate sul cloud, né possono utilizzare le funzionalità di intelligenza artificiale sopra menzionate.

Amazon Web Services ha deciso di abbattere questo muro.

La nuova soluzione Amazon AI Factories offre una soluzione "indiretta" ingegnosa: se non puoi accedere al cloud, allora ti porterò il cloud a casa.

In altre parole, Amazon Web Services (AWS) può "consegnare" direttamente un rack server completo, inclusi chip Trainium o NVIDIA, al data center di un cliente. Ciò che vendono non sono solo server, ma un ambiente di elaborazione completo gestito da AWS, che offre un'esperienza di cloud pubblico coerente.

AI Factories è particolarmente adatto a clienti sovrani come HUMAIN, un'azienda di intelligenza artificiale controllata dal fondo sovrano saudita (PIF), o a settori altamente regolamentati come la finanza e la sanità. Possono accedere immediatamente a infrastrutture di intelligenza artificiale avanzate utilizzando lo spazio e l'energia dei data center esistenti.

Contemporaneamente, Amazon Web Services ha lanciato Amazon Interconnect , inizialmente in partnership con Google Cloud, abbattendo le barriere fisiche tra i fornitori di servizi cloud. Ciò dimostra il loro approccio pragmatico: riconoscere che il "multi-cloud" è una realtà e colmare proattivamente il divario.

Con questo, Amazon Web Services (AWS) ha completato la sua trasformazione da "fornitore di servizi cloud" a "fornitore di infrastrutture di elaborazione onnipresente". La definizione di cloud non è più limitata ai data center di AWS, ma si estende a qualsiasi ambito in cui i clienti ne abbiano bisogno.

Rimodellare l'esperienza: eliminare il "debito tecnologico" e tornare alla fonte della creazione

Qual è l'obiettivo finale della tecnologia? Liberare l'umanità da compiti noiosi, affinché possa dedicarsi ad attività creative autentiche.

L'ideale sarebbe meraviglioso, ma in realtà molte persone devono dedicare il loro tempo a gestire sistemi obsoleti, più vecchi di loro. Nel campo della pianificazione urbana, esiste un termine chiamato "maledizione delle infrastrutture", che si riferisce al fatto che i progetti infrastrutturali su larga scala nelle fasi iniziali comporteranno enormi costi di manutenzione in futuro e "dirotteranno" le risorse organizzative per mantenere vecchi asset, rendendo impossibile investire in nuove tecnologie, nuove linee o ammodernamenti.

Allo stesso modo, le aziende globali spendono fino a 2,4 trilioni di dollari all'anno in "passività tecniche", come la manutenzione dei sistemi legacy e l'aggiornamento del codice obsoleto. Programmatori e ingegneri operativi detestano questi "lavori sporchi e stancanti" ripetitivi, eppure ne sono intrappolati a causa della realtà.

Al re:Invent, Amazon Web Services ha annunciato che utilizzerà l'intelligenza artificiale per eliminare queste "attività non necessarie".

La nuova versione aggiornata di Amazon Transform è progettata per eliminare queste limitazioni tecnologiche. Sfruttando l'intelligenza artificiale agentica, può aggiornare automaticamente codice obsoleto (come COBOL e versioni precedenti di Java) ai linguaggi più moderni e persino migrare le applicazioni Windows su Linux. Rispetto agli aggiornamenti manuali, la sua velocità di modernizzazione è 5 volte superiore, riducendo tempi e costi dell'80%.

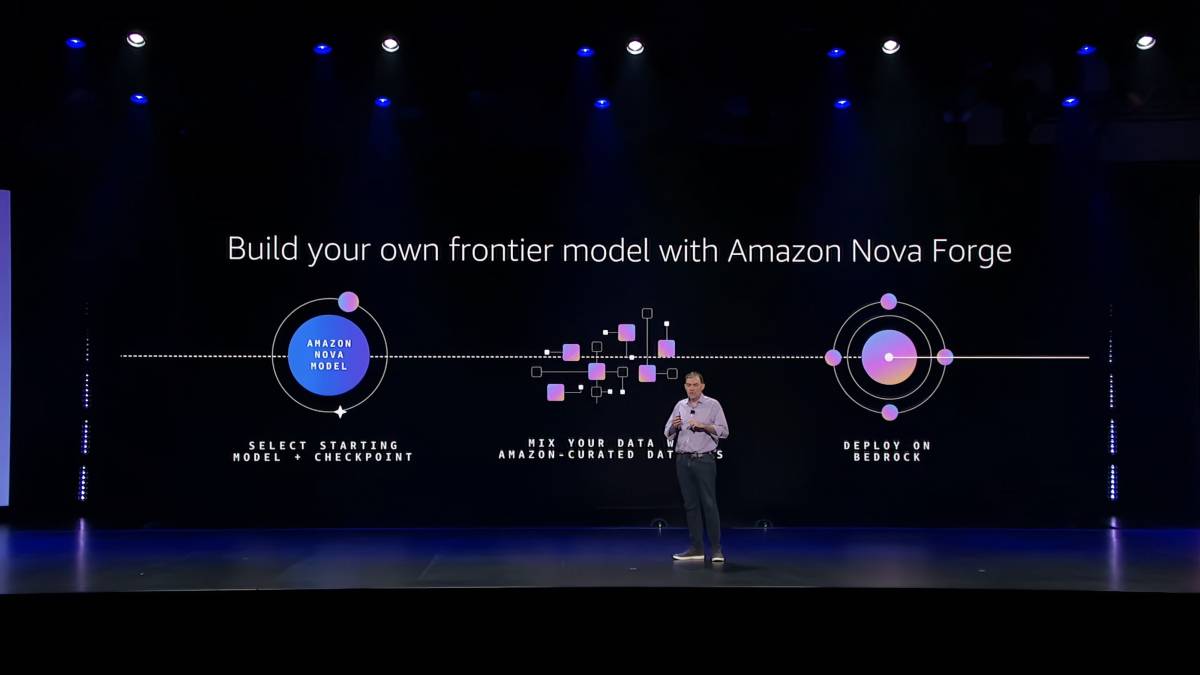

Amazon Nova Forge può anche alleviare il carico di lavoro delle aziende. Introduce il concetto di "modelli open-trained", consentendo alle aziende di integrare i propri dati (come documenti di progettazione del prodotto e casi di errore) con i set di dati generali di Amazon Web Services durante la fase di pre-addestramento del modello. Ciò consente loro di addestrare un modello personalizzato (Novella) che comprende a fondo il proprio business, risolvendo radicalmente il problema della "catastrophic forgetting" tipico del fine-tuning tradizionale. Reddit ha utilizzato con successo questa tecnologia per addestrare un modello personalizzato in grado di identificare con precisione i contenuti inappropriati, semplificando notevolmente l'implementazione e la manutenzione.

Ciò che Amazon Web Services fa in questo caso è spezzare la maledizione, sfruttando l'intelligenza artificiale per ottenere aggiornamenti e manutenzione a basso costo e integrando parti preziose di vecchie risorse in una base di conoscenza proprietaria basata sull'intelligenza artificiale.

Solo quando le aziende non sentono più il peso delle "infrastrutture" possono dedicarsi pienamente all'innovazione aziendale.

Mentre il cloud computing entra nella sua seconda fase, i piani di Amazon Web Services sono appena agli inizi.

Se la prima metà del cloud computing è stata una "rivoluzione infrastrutturale" che ha trasformato l'elaborazione, l'archiviazione e il networking in qualcosa di simile all'acqua e all'elettricità, con al centro la "democratizzazione delle risorse", allora la seconda metà, incentrata sugli agenti di intelligenza artificiale, sta inaugurando una rivoluzione di "democratizzazione delle capacità".

Amazon Web Services sta cercando di comunicare al mercato che la competizione nell'era dell'intelligenza artificiale non riguarda più chi ha i parametri di modello più ampi, ma chi riesce ad abbassare la barriera d'ingresso per l'intelligenza artificiale, a controllare meglio i costi e a gestire i confini in modo più rigoroso.

Questo cambiamento significa che l'attenzione della futura trasformazione digitale aziendale si sta spostando dalla relativamente semplice "gestione dei processi" di spostamento dell'attività sul cloud alla questione della "delega delle capacità" di affidamento degli obiettivi aziendali a innumerevoli agenti di intelligenza artificiale autonomi.

Aiutare le aziende ad affrontare questa sfida di trasformazione è il valore fondamentale che Amazon Web Services (AWS) ha trasmesso al re:Invent 2025: trasformare l'immensa complessità tecnologica e l'incertezza dell'era dell'intelligenza artificiale in un vantaggio competitivo che dia certezza alle aziende.

Quando Matt Garman annunciò 25 aggiornamenti infrastrutturali in soli dieci minuti, dichiarò che non si trattava solo della terrificante efficienza ingegneristica di Amazon Web Services, ma anche di un sistema di intelligenza artificiale industriale rigoroso, pragmatico e potente. Dai chip sviluppati internamente alle basi di modelli multimodali, dai data center che abbattono i confini fisici ai "dipendenti digitali" autonomi, Amazon Web Services ha trasformato la capacità di creare sistemi di intelligenza artificiale complessi – un tempo solo pochi giganti della tecnologia riuscivano a realizzarla – in un servizio standardizzato a cui tutte le aziende possono accedere on demand.

In questa prospettiva, gli strumenti di intelligenza artificiale a disposizione delle imprese diventeranno sempre più numerosi e le barriere all'ingresso si abbasseranno. Di conseguenza, si sta rapidamente avvicinando l'"era del valore", in cui le imprese potranno utilizzare l'intelligenza artificiale per aumentare drasticamente la propria produttività.

#Benvenuti a seguire l'account WeChat ufficiale di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.