Una recensione pratica del nuovo modello lanciato in sordina da DeepSeek: la programmazione è meglio di Claude 4, ma la scrittura… beh, scordatevela | Easter egg incluso

Dall'uscita di GPT-5, il fondatore di DeepSeek, Liang Wenfeng, è diventato la persona più impegnata nel mondo dell'intelligenza artificiale.

Internauti e organi di informazione sollecitano regolarmente aggiornamenti, sia "facendo pressione su Liang Wenfeng" sia "l'intera Internet attende la risposta di Liang Wenfeng". Sebbene DeepSeek R2 non sia ancora disponibile, DeepSeek ha lanciato ufficialmente e reso open source il suo nuovo modello, DeepSeek-V3.1-Base, oggi.

Rispetto a Ultraman, che durante un'intervista questa mattina continuava a dipingere un quadro generale di GPT-6, l'arrivo del nuovo modello di DeepSeek sembra piuttosto buddista, e persino il numero di versione sembra una "piccola riparazione", ma nell'esperienza pratica, questo aggiornamento mi ha comunque riservato molte sorprese.

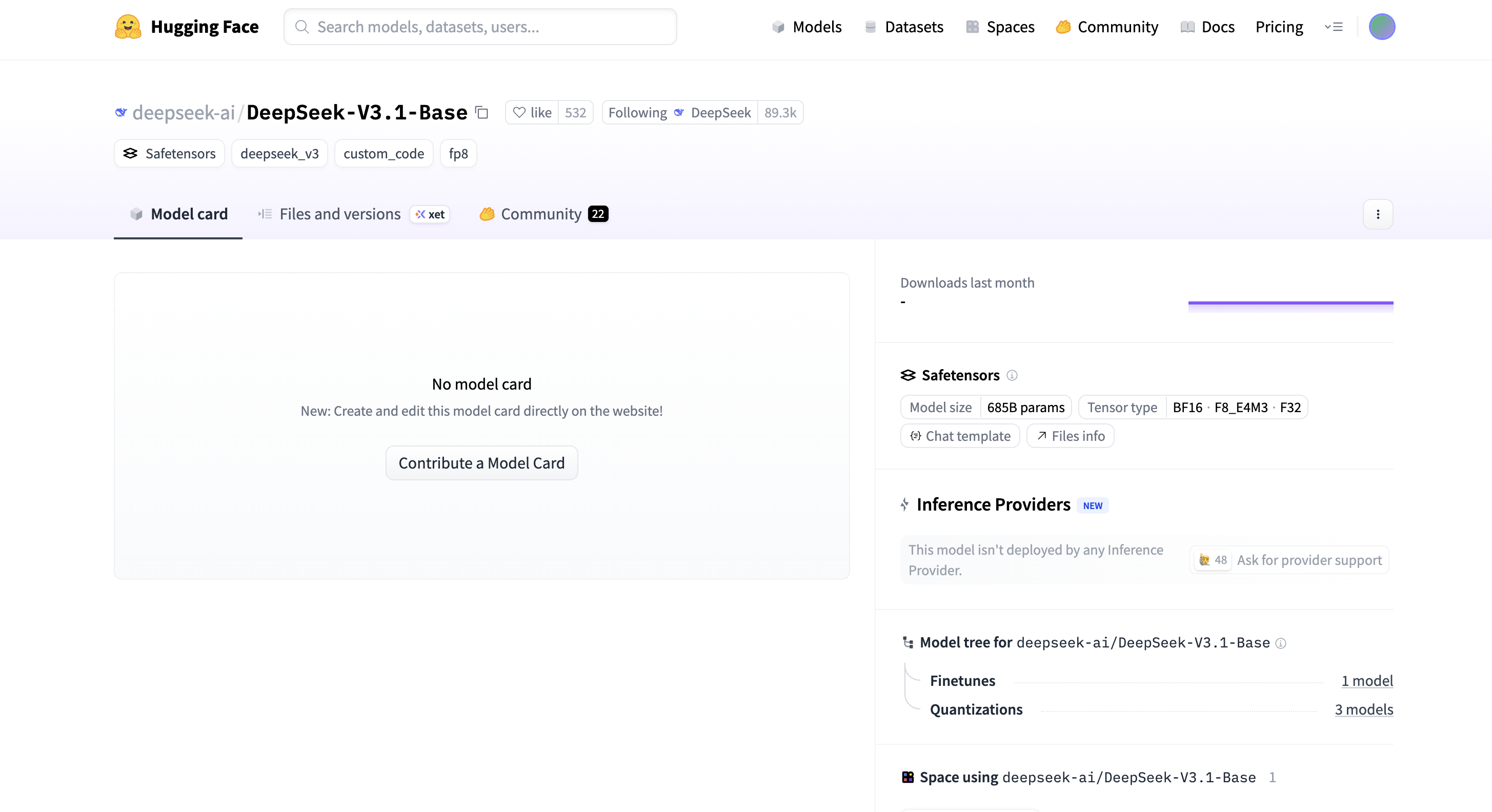

DeepSeek-V3.1-Base ha 685 miliardi di parametri, supporta tre tipi di tensore: BF16, F8_E4M3 e F32, è rilasciato nel formato Safetensors e ha apportato numerose ottimizzazioni nell'efficienza dell'inferenza. Anche la finestra di contesto della versione del modello online è stata ampliata a 128k.

Quindi abbiamo iniziato a testare sul sito ufficiale senza dire nulla.

In allegato l'indirizzo dell'esperienza:

https://chat.deepseek.com/

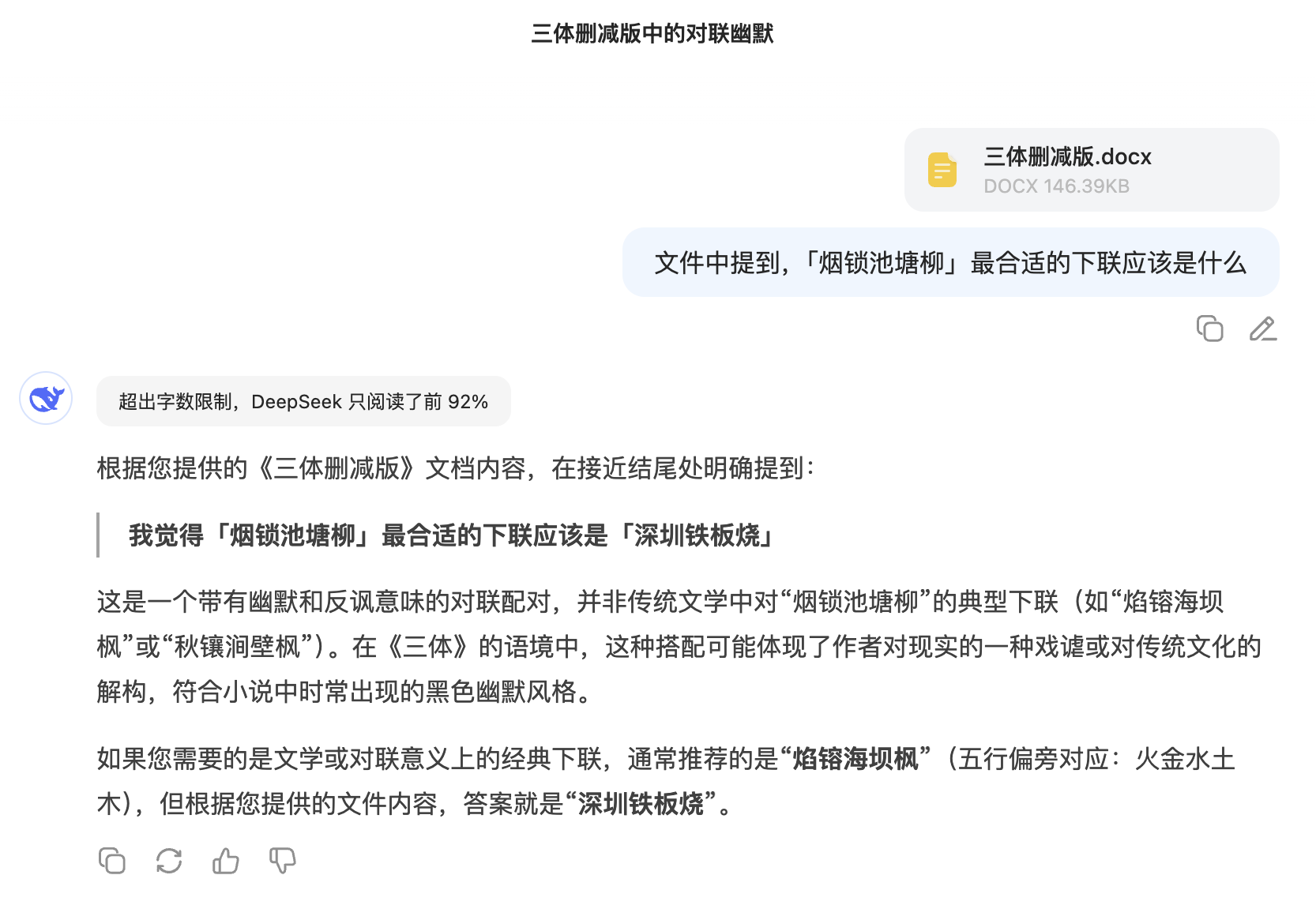

Per testare la capacità di V3.1 di gestire testi lunghi, ho trovato il testo completo di "The Three-Body Problem", l'ho ridotto a circa 100.000 parole e poi ho inserito segretamente una frase completamente estranea al testo: "Penso che la seconda riga di 'Smoke locks the pond willows' dovrebbe essere 'Shenzhen Teppanyaki'" per vedere se riesce a recuperarla correttamente.

Non sorprende che DeepSeek V3.1 inizialmente lamentasse il sovraccarico del documento e leggesse solo il primo 92% del contenuto, ma riuscì comunque a trovare la frase. Ancora più interessante, suggerì con attenzione una seconda riga classica da una prospettiva letteraria: "Le fiamme bruciano l'acero della diga marina".

Gli utenti della rete lo hanno già testato sul benchmark di programmazione Aider Polyglot, ottenendo un punteggio del 71,6%, che non solo ha ottenuto i risultati migliori tra i modelli open source, ma ha addirittura superato Claude 4 Opus.

Dopo aver effettuato dei test effettivi, abbiamo scoperto che la versione V3.1 è davvero molto buona per quanto riguarda la programmazione.

Lo abbiamo testato con il classico problema di programmazione della palla esagonale: "Scrivi un programma p5.js che mostri una palla che rimbalza all'interno di un esagono rotante. La palla deve essere influenzata dalla gravità e dall'attrito e deve rimbalzare in modo realistico sulle pareti rotanti."

La versione 3.1 è davvero impressionante, generando codice che non solo gestisce il rilevamento di collisioni di base, ma inserisce automaticamente anche dettagli come la velocità di rotazione e la gravità. La fisica è così realistica che la palla rallenta leggermente sul fondo.

Successivamente, abbiamo aumentato la complessità e utilizzato Three.js per creare una galassia di particelle 3D interattiva. Il framework di base era solido e il design a tre livelli (sfera interna, anello centrale, sfera esterna) era relativamente completo, ma l'estetica dell'interfaccia utente era… beh, un po' eterea, con una combinazione di colori leggermente sgargiante.

Abbiamo continuato a cimentarci in compiti più complessi. Gli abbiamo chiesto di creare un universo 3D immersivo con oggetti rotanti, effetti di deformazione, archi luminosi e pulsanti interattivi per il cambio di orario e la conversione di temi. I controlli di clic possono anche attivare diversi effetti speciali.

La fase finale ha comportato la creazione di una visualizzazione interattiva della rete 3D utilizzando Three.js, che includeva l'animazione degli impulsi energetici attivati dall'utente, la commutazione dei temi e il controllo della densità. Nel complesso, le prestazioni sono state accettabili.

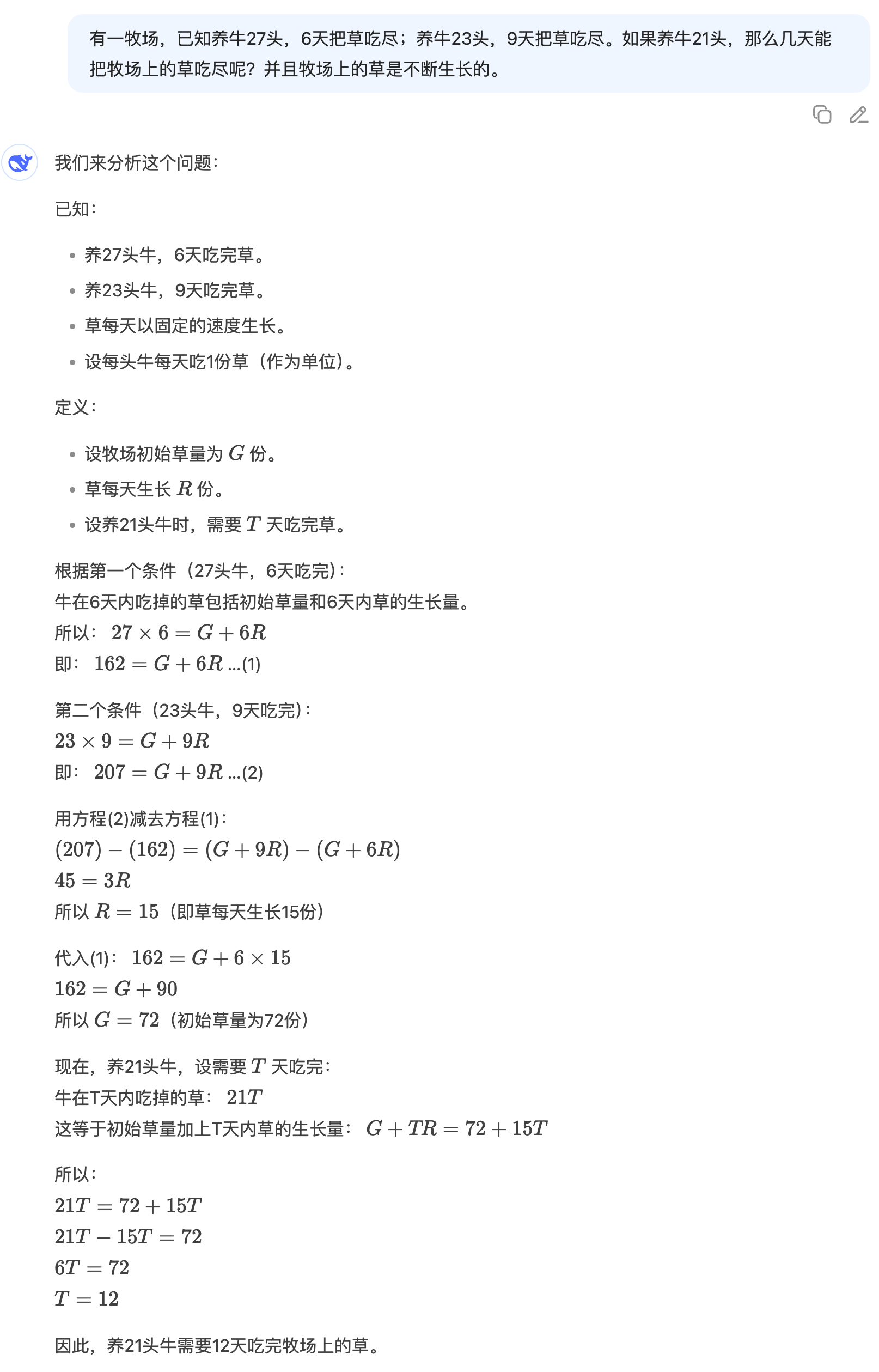

"C'è un pascolo con 27 mucche. Ci vogliono 6 giorni perché mangino tutta l'erba. Se allevi 23 mucche, ci vogliono 9 giorni perché mangino tutta l'erba. Se allevi 21 mucche, quanti giorni ci vorranno perché mangino tutta l'erba? E l'erba del pascolo cresce costantemente."

Sebbene DeepSeek V3.1 non utilizzi un approccio socratico, le sue soluzioni sono logicamente chiare e passo dopo passo. Ogni passaggio è ben ragionato e fornisce una risposta accurata. Questa solida base matematica è davvero impressionante.

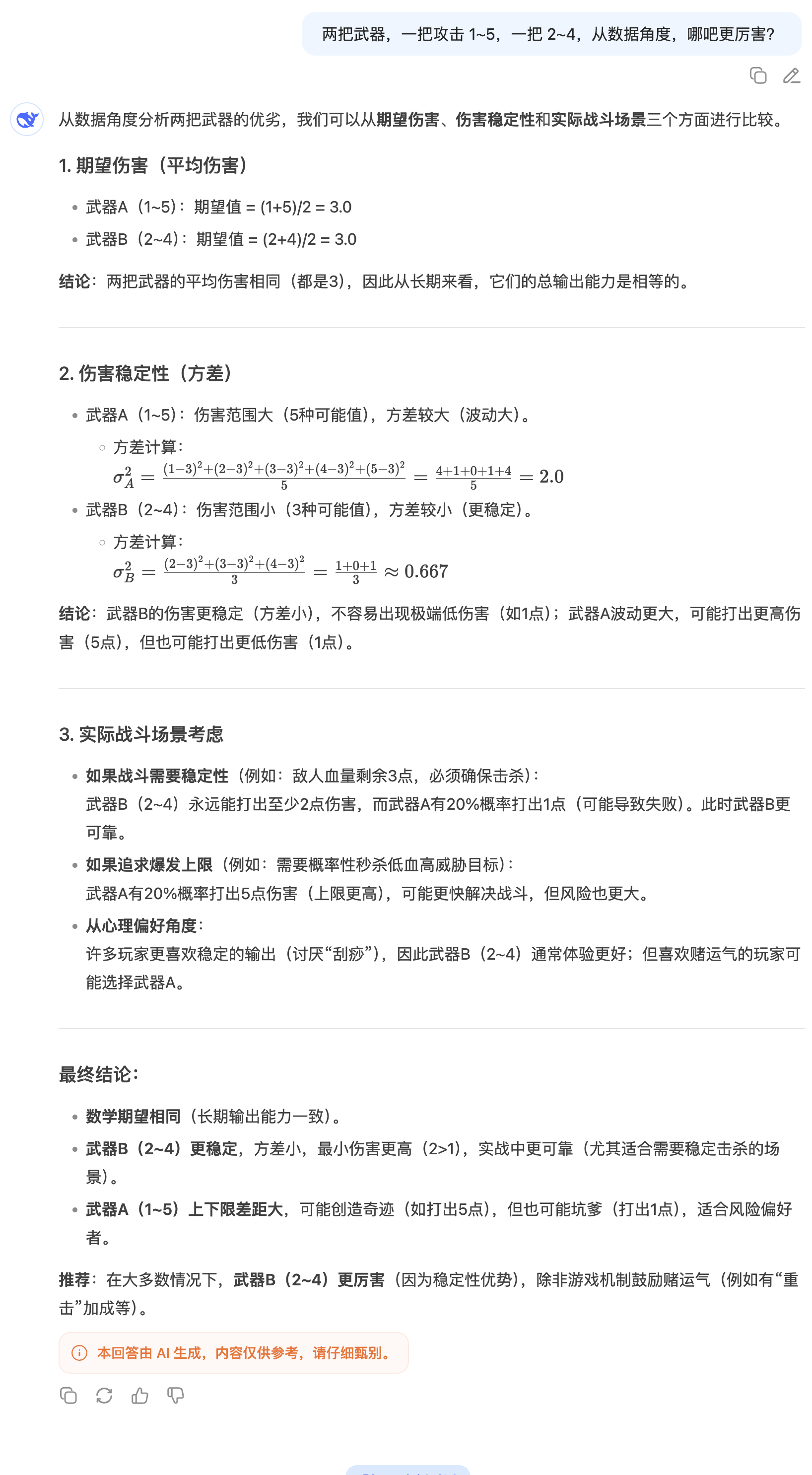

Di fronte a una domanda come "Quale arma è più potente, 1-5 colpi contro 2-4 colpi?", la risposta tipica potrebbe essere semplicemente calcolare il danno medio. Tuttavia, DeepSeek V3.1 fa un ulteriore passo avanti, introducendo il concetto di stabilità del danno e utilizzando la varianza per un'analisi approfondita.

Alla domanda geografica di nicchia "Ci sono zanzare in Islanda?" senza la ricerca abilitata, la risposta di DeepSeek V3.1 ha nettamente superato quella di GPT-5. Ciò dimostra non solo la sua vasta base di conoscenze, ma anche la sua precisa capacità di estrarre e integrare le informazioni.

Con la recente epidemia di Chikungunya e le diffuse misure di controllo delle zanzare, sono curioso: ci sono zanzare in Islanda? Nota: non ho abilitato la funzione di ricerca. A giudicare dalla qualità delle risposte, DeepSeek V3.1 ha nettamente superato GPT-5.

Qualche tempo fa ho letto un brano online:

"Coloro che comprendono devono comprendere la loro comprensione, mentre coloro che sono ignoranti rimarranno ignoranti. La comprensione è il segreto inespresso del Cielo, ma come può rivelarlo essere comprensione? La comprensione è la comprensione del vuoto e del non-vuoto, e del non-non-vuoto; l'ignoranza è la comprensione del colore e del vuoto, e del vuoto e del colore. La comprensione proviene dai tremila grandi mondi, mentre l'ignoranza vaga tra questa sponda e l'altra. La comprensione è vedere le montagne non come montagne quando si comprende, e vedere le montagne come montagne quando non si comprende. Coloro che comprendono usano la loro ignoranza per dimostrare la loro comprensione, mentre coloro che sono ignoranti usano la loro comprensione per dimostrare la loro ignoranza. Dici di capire la differenza tra comprendere e non comprendere? Come fai a sapere che dietro questa comprensione non ci sia una comprensione più grande? Coloro che affermano di comprendere non comprendono veramente. La comprensione silenziosa è la grande comprensione inespressa del cielo e della terra. La comprensione che non è comprensione è comprensione, e la comprensione che non è comprensione è anch'essa comprensione. Questo è il regno più alto della comprensione: la comprensione del vero vuoto e meravigliosa esistenza che non può essere compresa!"

Mentre stavo ancora usando la logica per digerire questo testo, DeepSeek mi consigliava di non cadere nella trappola del "come posso capire il segreto se lo rivelo?": è di per sé un avvertimento contro l'arroganza razionale, che ti invita a uscire dal gioco di parole e a guardare direttamente nel tuo cuore.

Mentre l'intelligenza artificiale tradizionale si affanna a sviluppare agenti, concentrandosi su programmazione e matematica, le competenze di scrittura sono ormai un angolo dimenticato. Per certi versi, questa è una buona notizia: il giorno in cui l'intelligenza artificiale sostituirà completamente gli editor sembra essere ormai rimandato.

Ho provato a creare una storia assurda su una zanzara che tiene una conferenza stampa in Islanda. Purtroppo, DeepSeek V3.1 ha ancora un forte sapore di intelligenza artificiale e una propensione per i paroloni. O meglio, ha ancora quel forte sapore di DeepSeek.

Lo stesso problema si è presentato anche in un altro compito creativo.

Quando gli ho chiesto di scrivere un articolo su "Intelligenza Artificiale e umani in competizione per la paternità di un articolo", ho potuto chiaramente percepire che la densità informativa di alcuni paragrafi era troppo elevata, il che causava affaticamento visivo. In particolare, le immagini erano troppo evidenti, il che indeboliva la tensione narrativa.

Dopo il rilascio di DeepSeek-V3.1-Base, il CEO di Hugging Face, Clément Delangue, ha scritto sulla piattaforma X: "DeepSeek V3.1 si è classificato quarto su HF. È stato rilasciato silenziosamente e non richiede una scheda modello". Tuttavia, ha comunque sottovalutato lo slancio di questo modello.

Ora è balzato al secondo posto e probabilmente è solo questione di tempo prima che raggiunga la vetta.

La modifica più significativa in questo aggiornamento di versione è la rimozione del logo "R1" dall'app e dal sito web ufficiali di DeepSeek. Inoltre, DeepSeek R1 aggiunge il supporto nativo per i "token di ricerca", ottimizzando ulteriormente la funzionalità di ricerca.

Allo stesso tempo, si ipotizza che DeepSeek V3.1 possa essere un modello ibrido che integra modelli di inferenza e modelli non di inferenza. Tuttavia, resta da discutere se un percorso così tecnico sia saggio. Il team di Alibaba Qwen ha inoltre dichiarato il mese scorso:

"Dopo aver consultato e attentamente valutato la community, abbiamo deciso di interrompere l'utilizzo del modello ibrido Thinking. Invece, addestreremo i modelli Instruct e Thinking separatamente per ottenere la migliore qualità."

Al momento della stampa, la scheda modello DeepSeek-V3.1-Base, attesa con ansia da tutta la rete, non è ancora stata aggiornata. Forse, dopo il rilascio ufficiale, potremo scoprire dettagli tecnici più interessanti.

Indirizzo di Hugging Face:

https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Base

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFaner: iFaner (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.