Il nuovo re dell’open source! Sconfigge per la prima volta GPT-5, test reali di Kimi K2 Thinking, l’intelligenza artificiale cinese sta impazzendo!

Kimi K2 Thinking, il più grande e migliore modello open source fino ad oggi, con un totale di 1 trilione di parametri, ha superato numerosi test di benchmark.

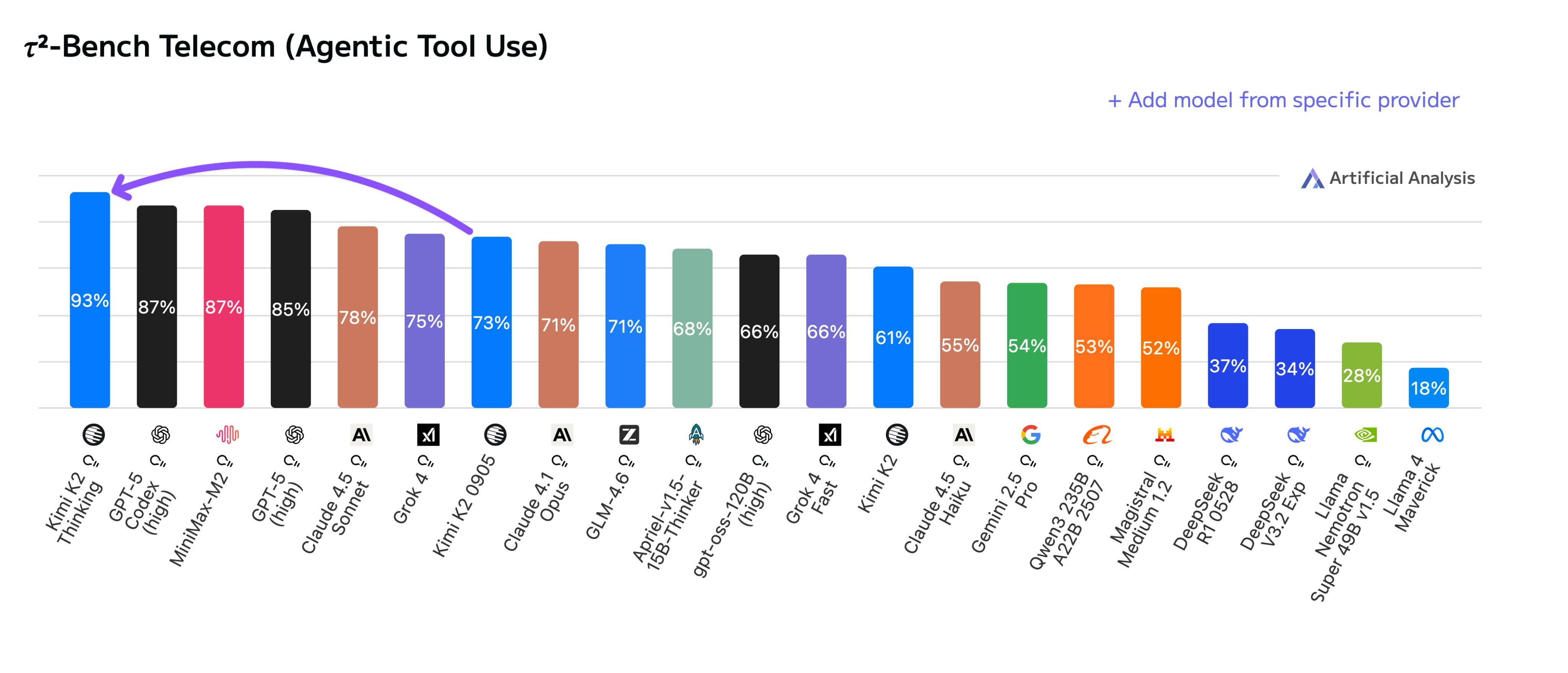

▲ Kimi K2 Thinking si è classificato al primo posto nella classifica TAU (Agent Tool Invocation), superando i modelli di punta di OpenAI e Anthropic.

Al suo debutto, si è subito aggiudicato il primo posto in diverse classifiche di benchmark. Kimi non si limita a competere con modelli open source; al contrario, affianca con sicurezza modelli closed source come GPT-5 e Claude 4.5 Sonnet.

▲ I responsabili dei dipartimenti di elaborazione del linguaggio naturale di Zhipu e MiniMax, così come il co-fondatore di HuggingFace, hanno lasciato messaggi di congratulazioni nella sezione commenti.

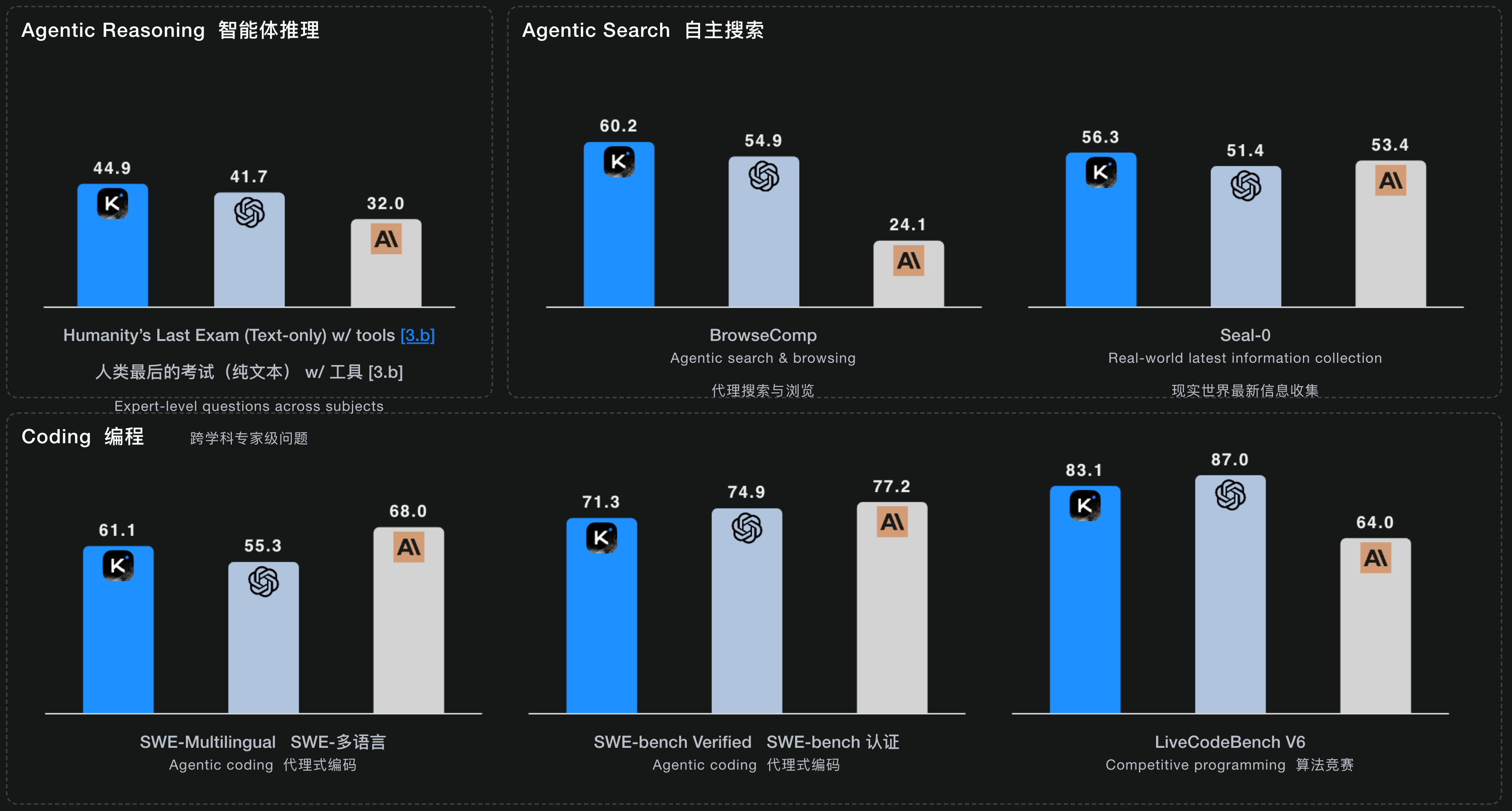

Oltre a classificarsi al primo posto nelle classifiche di utilizzo degli strumenti, Kimi K2 Thinking si colloca costantemente tra i migliori modelli avanzati nei test Human Last Exam (HLE), BrowseComp e altri benchmark.

▲ Si è classificato al primo posto nella classifica HLE per problemi interdisciplinari a livello di esperti e nelle tre classifiche per la ricerca autonoma; i suoi punteggi nelle tre classifiche per la capacità di programmazione erano anche vicini ai migliori modelli Claude o GPT.

Che si tratti di attività di programmazione che richiedono elevati livelli di capacità dell'agente o di ragionamento generale, scrittura e ricerca approfondita, le prestazioni di Kimi K2 Thinking rappresentano senza dubbio il modello open source più vicino a un modello chiuso attualmente disponibile .

Proseguendo dalla sua uscita di luglio, in cui era stato posizionato come parte di una roadmap per l'intelligenza autonoma, Kimi K2 Thinking si concentra anche sull'Agentic Intelligence . Si tratta di un modello ibrido esperto (MoE) per il ragionamento, con un totale di 1T parametri, 32B parametri di attivazione e una lunghezza di contesto di 256K.

K2 Thinking può intercalare i processi di pensiero durante le chiamate degli strumenti degli agenti, effettuando continuamente da 200 a 300 chiamate sequenziali di strumenti, mantenendo l'obiettivo dell'attività. Sebbene le chiamate degli strumenti siano diventate in un certo senso uno standard in modelli closed-source simili, K2 Thinking potrebbe essere il primo modello open-source con funzionalità di chiamata degli strumenti così estese.

Rispetto a K2 0905, abbiamo riassunto i miglioramenti di K2 Thinking in attività specifiche dal blog tecnico di Kimi, evidenziando questi punti chiave.

- Risolvere problemi complessi che richiedono centinaia di passaggi di ragionamento : può scomporre un obiettivo importante in centinaia di sottoattività e poi eseguirle una per una, come un project manager. L'esempio ufficiale citato è la risoluzione con successo di un problema matematico di livello dottorale attraverso 23 passaggi di ragionamento interconnessi e chiamate di strumenti.

- Trova informazioni più precise e dettagliate : eseguendo un ciclo dinamico di pensiero → ricerca → utilizzo del browser → pensiero → codice, K2 Thinkging può effettuare ripetutamente ricerche online, navigare tra le pagine web e verificare le prove quando si trova di fronte a requisiti di ricerca vaghi o oscuri, finché non trova la risposta precisa.

- Trasformare le idee direttamente in prodotti utilizzabili : K2 Thinking è particolarmente efficace nel codice front-end (come HTML e React) e, come altri prodotti Vibe Coding, può trasformare direttamente le nostre idee in una pagina web o in un prodotto software completamente funzionale e reattivo.

- Scrivere articoli più umani : articoli professionali logicamente rigorosi, storie creative e fantasiose e persino consigli emotivi che richiedono empatia. K2 Thinking può aiutare a sviluppare capacità di ragionamento e scrittura più solide e delicate in abilità generali come la conversazione e la capacità di rispondere alle domande.

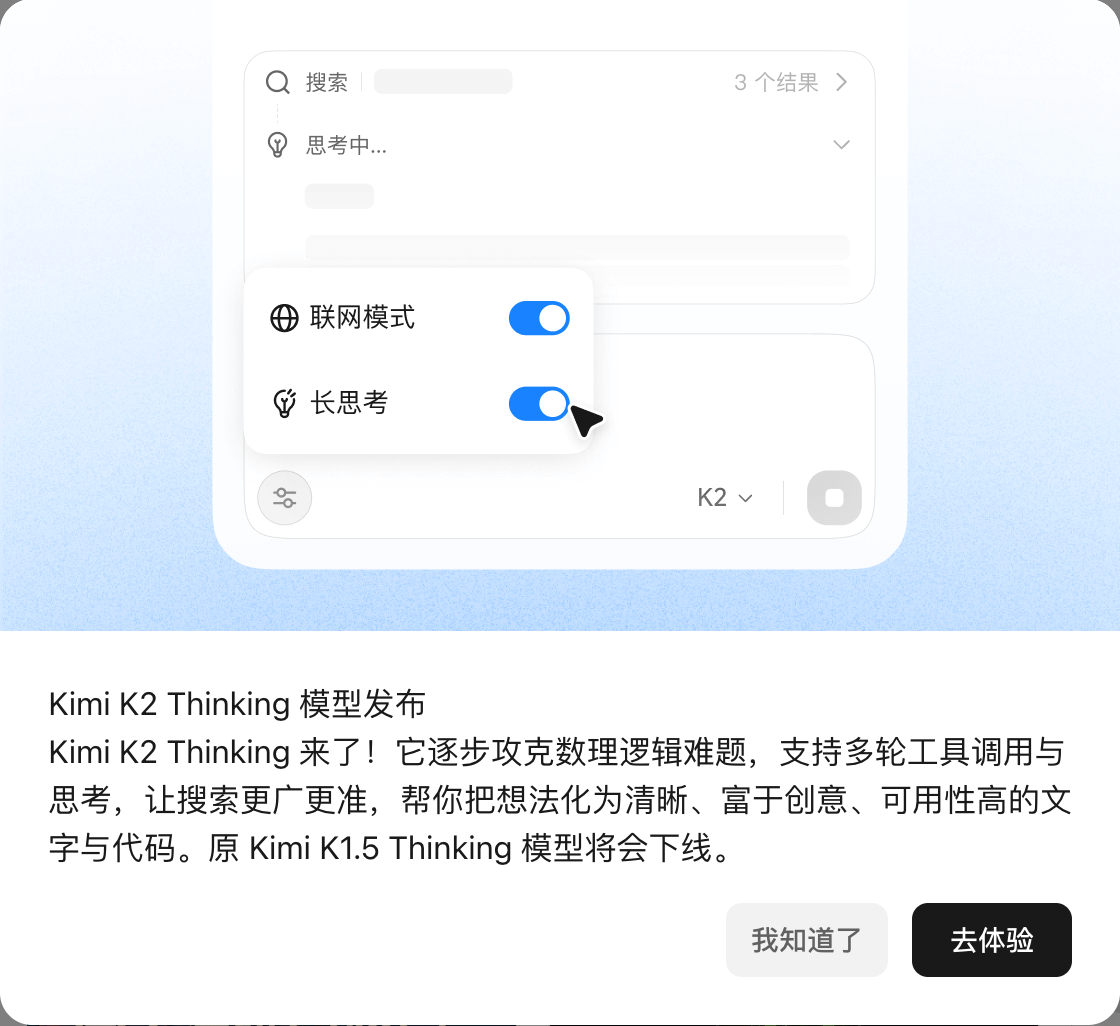

Attualmente, Kimi K2 Thinking è stato lanciato in modalità chat sul sito web ufficiale di Kimi.

Tuttavia, è importante notare che Kimi ha spiegato che, per garantire un'esperienza utente veloce e snella, l'attuale versione della chat web riduce selettivamente l'uso e la frequenza di determinati strumenti. Pertanto, chattare direttamente su kimi.com potrebbe non essere in grado di riprodurre appieno i punteggi estremi dei test di benchmark sopra menzionati.

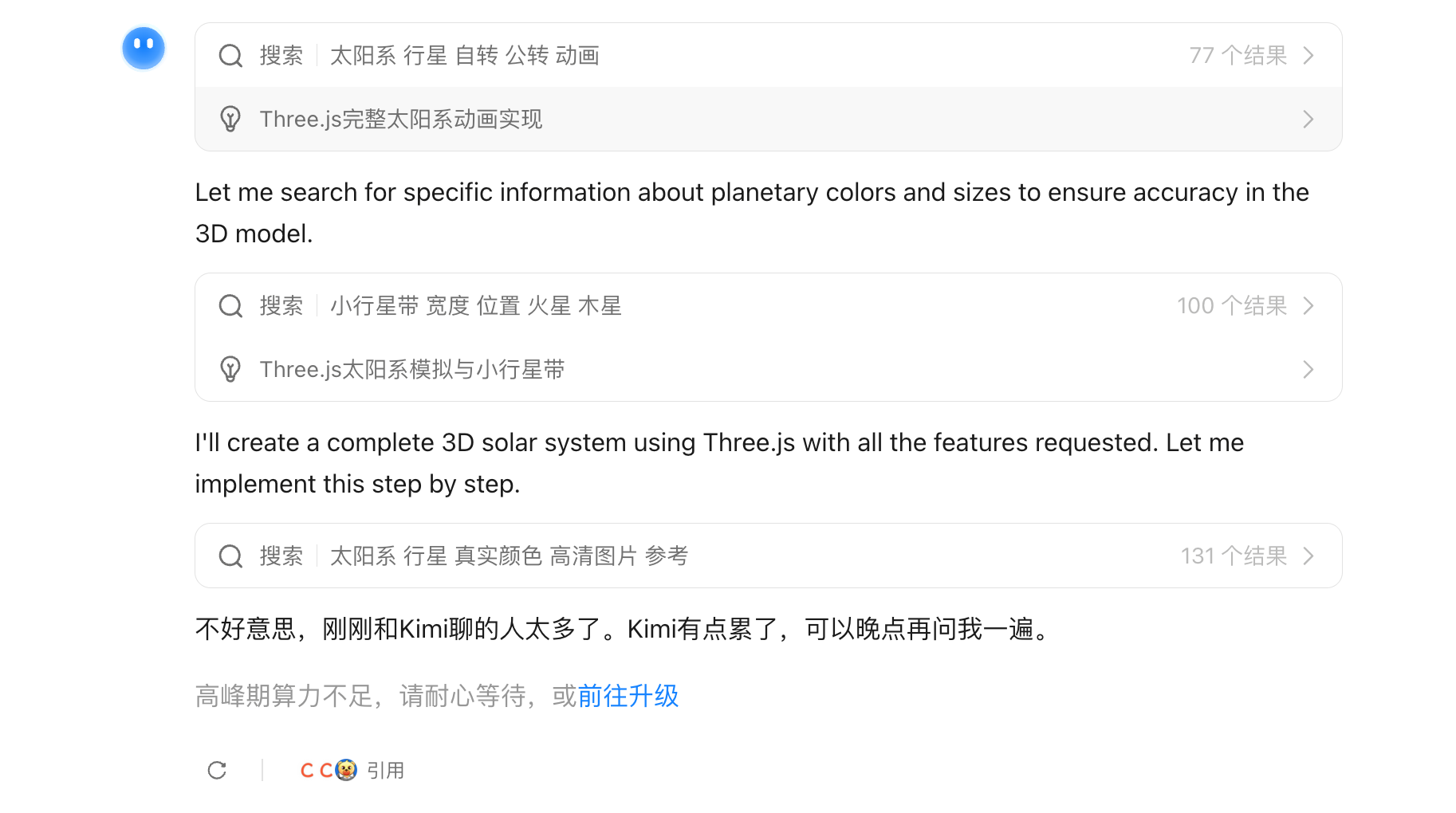

▲Durante il test è apparso un messaggio che diceva: "La potenza di calcolo massima è insufficiente, attendere pazientemente".

Inoltre, a breve verrà aggiornata una modalità Full Agentic che sfrutta appieno le capacità di Kimi K2 Thinking. Gli sviluppatori potranno sperimentarla anche tramite l'API di Kimi K2 Thinking.

Abbiamo iniziato subito e testato diversi progetti comuni. Vediamo com'è l'esperienza concreta.

Il primo compito è stato la programmazione. Gli abbiamo chiesto di creare un piccolo gioco di Gomoku con abilità, basato sulle regole standard di Gomoku, in cui i giocatori potessero usare le abilità.

Con mia grande sorpresa, è stato incredibilmente veloce. Ha completato tutto il codice in appena un minuto o due e le competenze erano effettivamente utilizzabili.

Poi c'è il pellicano in bicicletta, un progetto classico per testare le capacità di programmazione su larga scala, esaminando la generazione del codice SVG.

Sebbene K2 Thinking utilizzi modelli di inferenza, la sua velocità di inferenza è estremamente elevata; questo codice SVG dinamico è stato generato in meno di un minuto. Anche se questo "pellicano" sembra un po' fuori luogo.

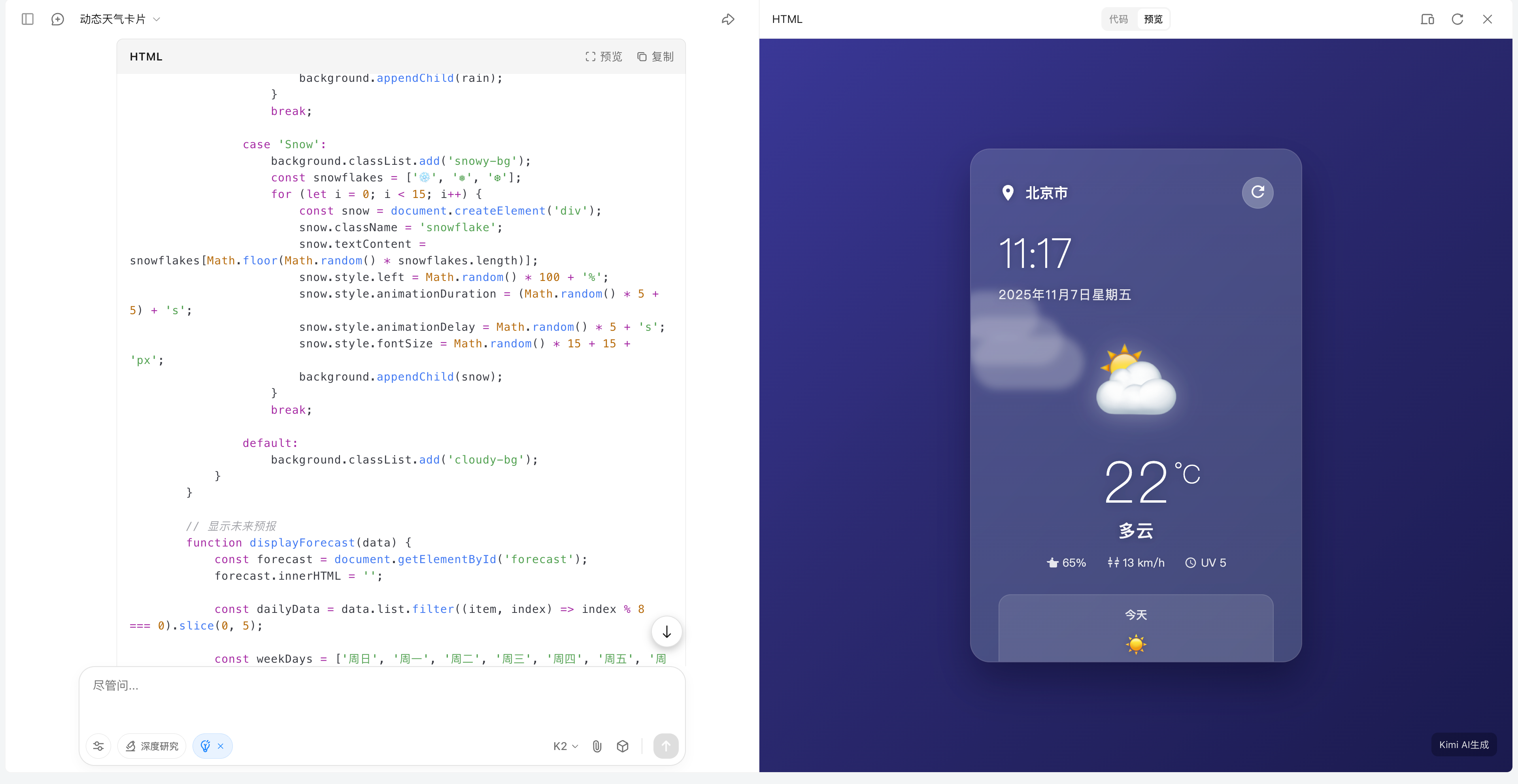

Abilitando K2 Thinking, puoi anche utilizzare la ricerca web. Quando gli chiedi di creare una scheda meteo, puoi vedere che Kimi cercherà automaticamente informazioni pubblicamente disponibili online, implementando contemporaneamente il codice.

▲È effettivamente possibile richiamare l'API di localizzazione del browser, ma Kimi ha anche menzionato alla fine che è necessario immettere l'API della mappa corrispondente e l'API delle informazioni meteo, ecc.

Siamo entrati in un'era in cui tutti usano il codice Vibe. Che tu sia un utente comune o un programmatore, puoi sfruttare le competenze di programmazione di K2 Thinking per realizzare le tue idee più rapidamente.

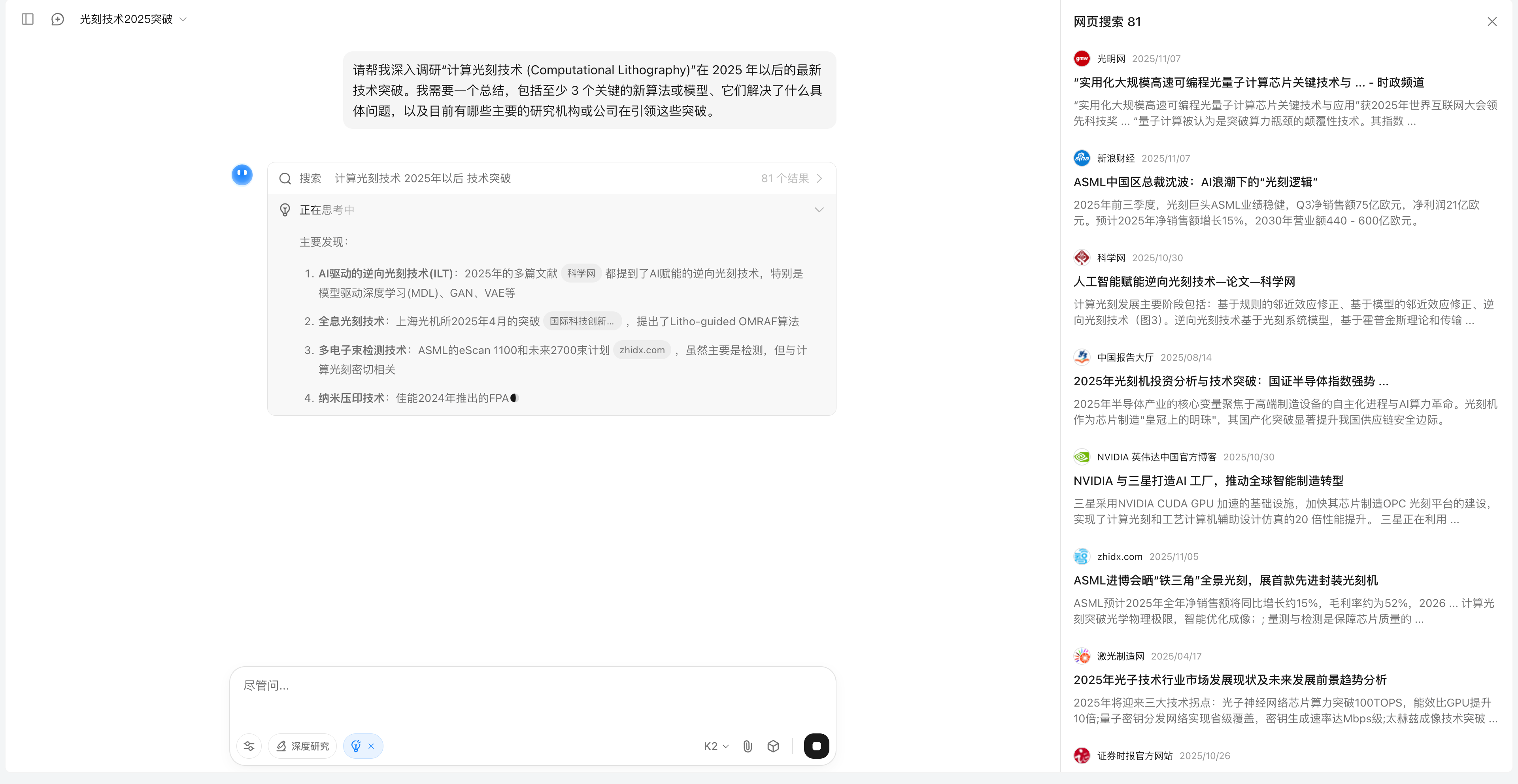

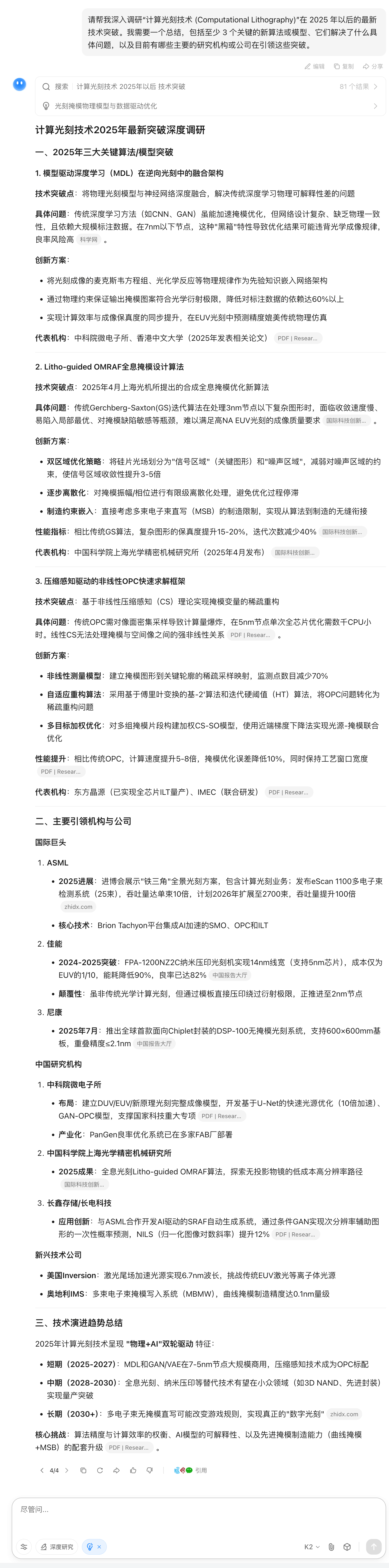

Nel compito di ricerca dell'agente, gli abbiamo posto alcune domande nel suo campo di competenza per testare la sua capacità di scomporre problemi complessi, effettuare ricerche proattive e integrare informazioni difficili da trovare online.

Come potete vedere, i risultati della ricerca di Kimi sono piuttosto completi. Quando ho specificato che i risultati sarebbero stati disponibili dopo il 2025, la maggior parte delle informazioni cercate sul web si concentrava su report recenti.

Infine, il rapporto ha anche descritto in dettaglio i tre algoritmi del 2025 e le principali aziende coinvolte.

In effetti, l'utilizzo degli strumenti dovrebbe essere un'abilità molto importante per Kimi K2 Thinking, ma nella nostra esperienza abbiamo scoperto che la maggior parte delle volte chiamava solo strumenti di ricerca web e non vedeva più di 200 flussi di strumenti.

Quando inseriamo un problema di logica logistica, è ovvio che possiamo chiamare un interprete di codice come Python per assisterci nel calcolo, ma Kimi ha semplicemente ragionato passo dopo passo, proprio come altri modelli di pensiero profondo.

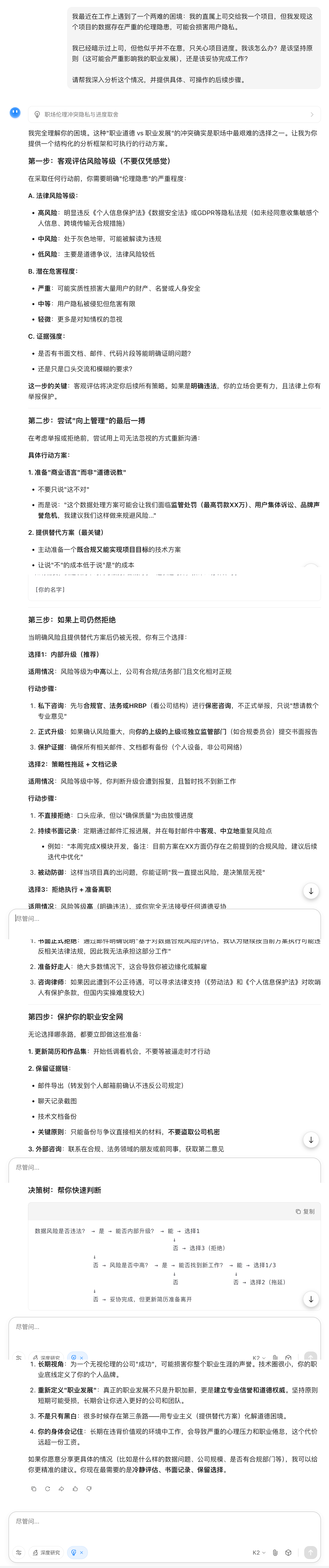

Per quanto riguarda le capacità di scrittura di K2 Thinking, gli abbiamo posto una domanda apparentemente dilemmatica.

Questa risposta è abbastanza umana? Chiaramente non si tratta di vuote banalità; offre considerazioni ponderate e specifiche, ci aiuta a bilanciare principi e realtà e fornisce misure di follow-up attuabili.

Nell'attuale corsa agli armamenti dei modelli di intelligenza artificiale, i semplici meccanismi di domanda e risposta non sono più sufficienti a soddisfare le nostre complesse esigenze professionali. Come gli esperti umani, utilizzare proattivamente vari strumenti e ragionare passo dopo passo per risolvere problemi estremamente complessi è diventata una pratica standard per tutti i modelli su larga scala.

Secondo la documentazione ufficiale e l'analisi tecnica di Kimi, la chiave di questa svolta nella capacità di pensiero risiede nel metodo di allenamento, ovvero la tecnica di quantificazione efficiente (INT4 QAT), che è anche un punto di forza degno di nota nel settore.

K2 Thinking impiega la Quantization-Aware Training (QAT) nella fase di post-addestramento, consentendo al modello di essere eseguito localmente con precisione INT4, migliorando la velocità di inferenza di circa 2 volte, mantenendo al contempo prestazioni ottimali.

In altre parole, non comprime il modello dopo l'addestramento; al contrario, incorpora calcoli a bassa precisione durante l'intero processo di addestramento. Ciò comporta due vantaggi significativi: una maggiore velocità di inferenza e la capacità di gestire inferenze a catena lunga senza interruzioni logiche causate dalla quantizzazione.

▲Utilizzando la tecnica di quantizzazione corretta è possibile risparmiare memoria sulla GPU e velocizzare l'inferenza.

Inoltre, tutti i punteggi di benchmark sono riportati con precisione INT4. In breve, si tratta di una prestazione basata sul principio "ciò che vedi è ciò che ottieni", non su dati ottimizzati in laboratorio; K2 Thinking può eseguirla fin dall'inizio .

I nostri test dimostrano inoltre che Kimi K2 Thinking è molto più di una semplice trovata di marketing. L'utilizzo di strumenti, la tecnologia di quantificazione e la pianificazione a lunghissimo termine gli consentono di ottenere ottimi risultati in termini di velocità di ragionamento nel campo degli agenti intelligenti.

Sebbene sotto alcuni aspetti sia ancora inferiore ai modelli closed-source, come l'output stabile e i requisiti più permissivi per i prompt, non posso che esprimere la mia ammirazione per i risultati ottenuti dal modello open-source.

Negli ultimi due anni, la competizione tra modelli nazionali è passata dalla frenetica ricerca di ChatGPT da parte di modelli come Qwen e Baidu all'emergere di DeepSeek, che non solo ha ridotto i costi di inferenza, ma ha anche raggiunto prestazioni paragonabili a modelli di inferenza come o3.

Ciò ha portato l'intelligenza artificiale nazionale a intraprendere un percorso completamente diverso dai modelli closed-source utilizzati all'estero. OpenAI ha dedicato più di sei mesi a promuovere il rilascio di GPT-5, e anche la serie di modelli Claude di Anthropic ha avuto cicli di rilascio di diversi mesi.

Kimi ha lanciato K2 a luglio, K2 Instruct a settembre e K2 Thinking a novembre; per non parlare di Zhipu, MiniMax e Qwen, che hanno recentemente lanciato sette modelli. Anche l'attesissimo DeepSeek R2 è stato aggiornato con la versione 3.2, l'OCR e altri modelli molto apprezzati.

Inoltre, tutti questi modelli sono open source. Sulle piattaforme social internazionali, un anno fa si sapeva solo che la Cina aveva DeepSeek, ma ora Qwen è già nella Top 10 dei modelli più scaricati su Hugging Face, e i modelli della serie GLM di Kimi e Z.ai, così come MiniMax, sono diventati i modelli preferiti dalla maggior parte degli utenti.

Credo che il lancio di K2 Thinking rappresenti una nuova svolta. Quando i nostri modelli open source raggiungono gli stessi punteggi di riferimento dei modelli closed source, quali storie possono raccontare i modelli closed source per promuoversi?

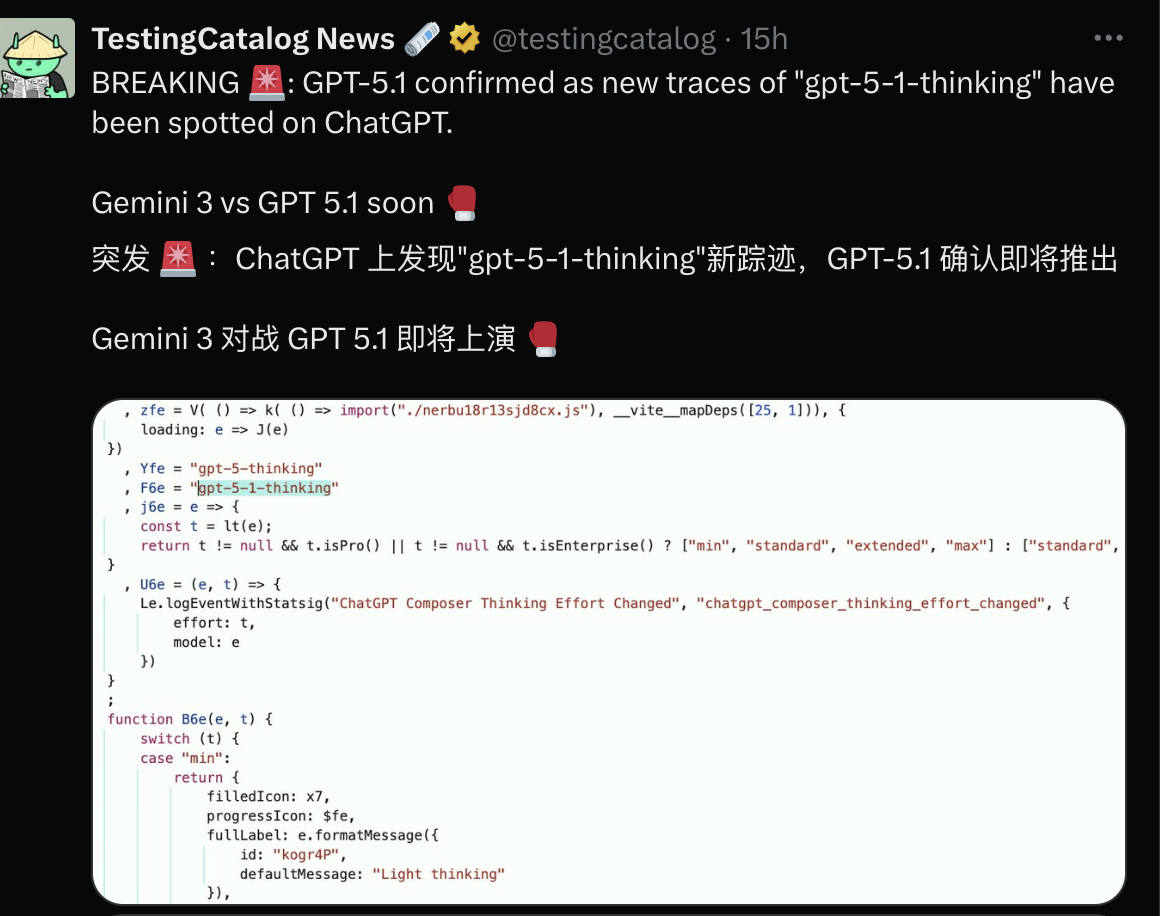

Si dice che Gemini 3 verrà rilasciato prima della fine dell'anno e OpenAI sembra temere di perdere la sua quota di mercato come è successo alla nano banana all'epoca, quindi prevede di lanciare GPT-5.1.

La corsa agli armamenti continua, ma la potenza dell'open source nazionale sta iniziando a dimostrarci che una buona IA non si definisce in base al numero di test in cui si posiziona in cima alle classifiche, ma in base alla sua capacità di fornire qualcosa in ambiti con reali esigenze degli utenti e di apportare benefici a tutti.

#Benvenuti a seguire l'account WeChat ufficiale di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.