La Terra non può più supportare l’intelligenza artificiale, costringendo Google e Nvidia ad andare nello spazio, il che finisce per avvantaggiare Musk.

Google ha appena lanciato ufficialmente la sua missione lunare con data center, con l'obiettivo di concentrare tutta la sua potenza di calcolo nello spazio. Ha dato al progetto un nome accattivante: Project Suncatcher.

L'idea di Google è semplice: invece di competere per le risorse in diminuzione sulla Terra, perché non connettersi direttamente all'energia solare nello spazio? Questa nuova missione lunare ha un solo obiettivo: realizzare un'infrastruttura di intelligenza artificiale scalabile e alimentata a energia solare nello spazio .

Qualche giorno fa, il CEO di OpenAI Altman e il CEO di Microsoft Satya Nadella hanno dichiarato in un podcast che…

Il mio problema oggi non è un problema di fornitura di chip; il fatto è che non ho abbastanza gusci caldi per inserirli.

Sembra proprio Versailles, dopotutto, prima di questa ondata di intelligenza artificiale, pensavamo sempre che la potenza di calcolo fosse tutto.

▲Ultraman e Nadella

Ma come ha detto Ultraman nel programma, il futuro dell'intelligenza artificiale richiede ulteriori innovazioni nel campo energetico. Ordinare troppi chip di intelligenza artificiale è inutile se i data center e l'alimentazione elettrica non riescono a tenere il passo.

Quanto è scandaloso il consumo energetico dell'intelligenza artificiale? Secondo l'Agenzia Internazionale per l'Energia (IEA), entro il 2030, il consumo energetico dell'infrastruttura dati globale dovrebbe essere equivalente al consumo energetico dell'intero Giappone.

Non si tratta solo di elettricità, ma anche di acqua. I dati del World Economic Forum mostrano che un data center da 1 megawatt consuma la stessa quantità di acqua al giorno di circa 1.000 residenti nei paesi sviluppati.

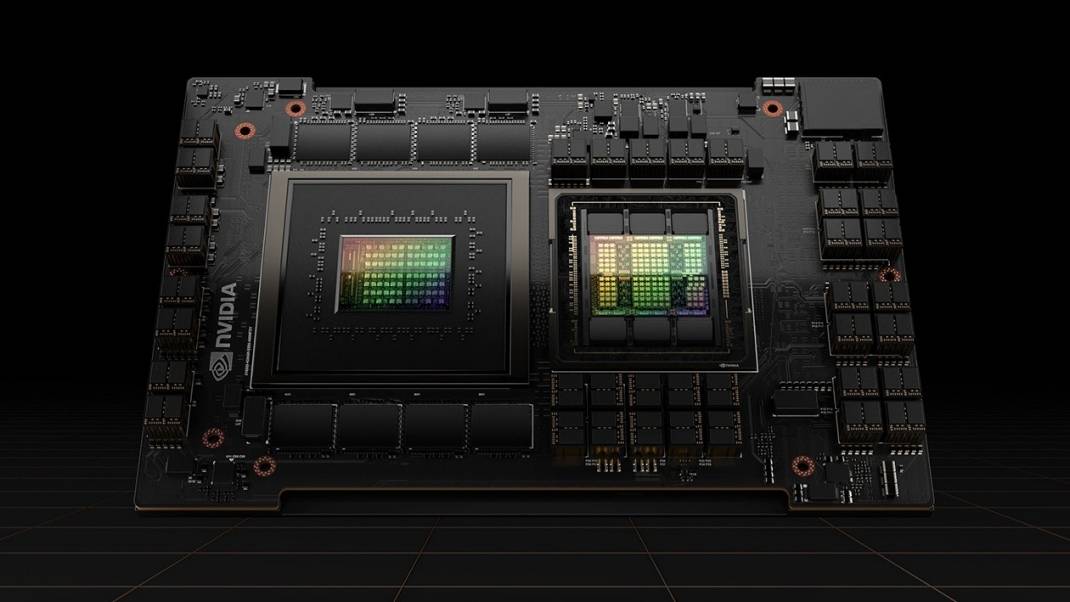

▲Un singolo chip NVIDIA H100 può consumare fino a 700 W di potenza, all'incirca la potenza di un forno a microonde domestico. Un data center utilizza in genere decine di migliaia di schede grafiche H100 in funzione continua.

Negli ultimi cinque anni, tuttavia, la domanda di data center è aumentata vertiginosamente, ma il tasso di crescita ha superato di gran lunga il ritmo con cui è stata pianificata la nuova capacità di generazione di energia.

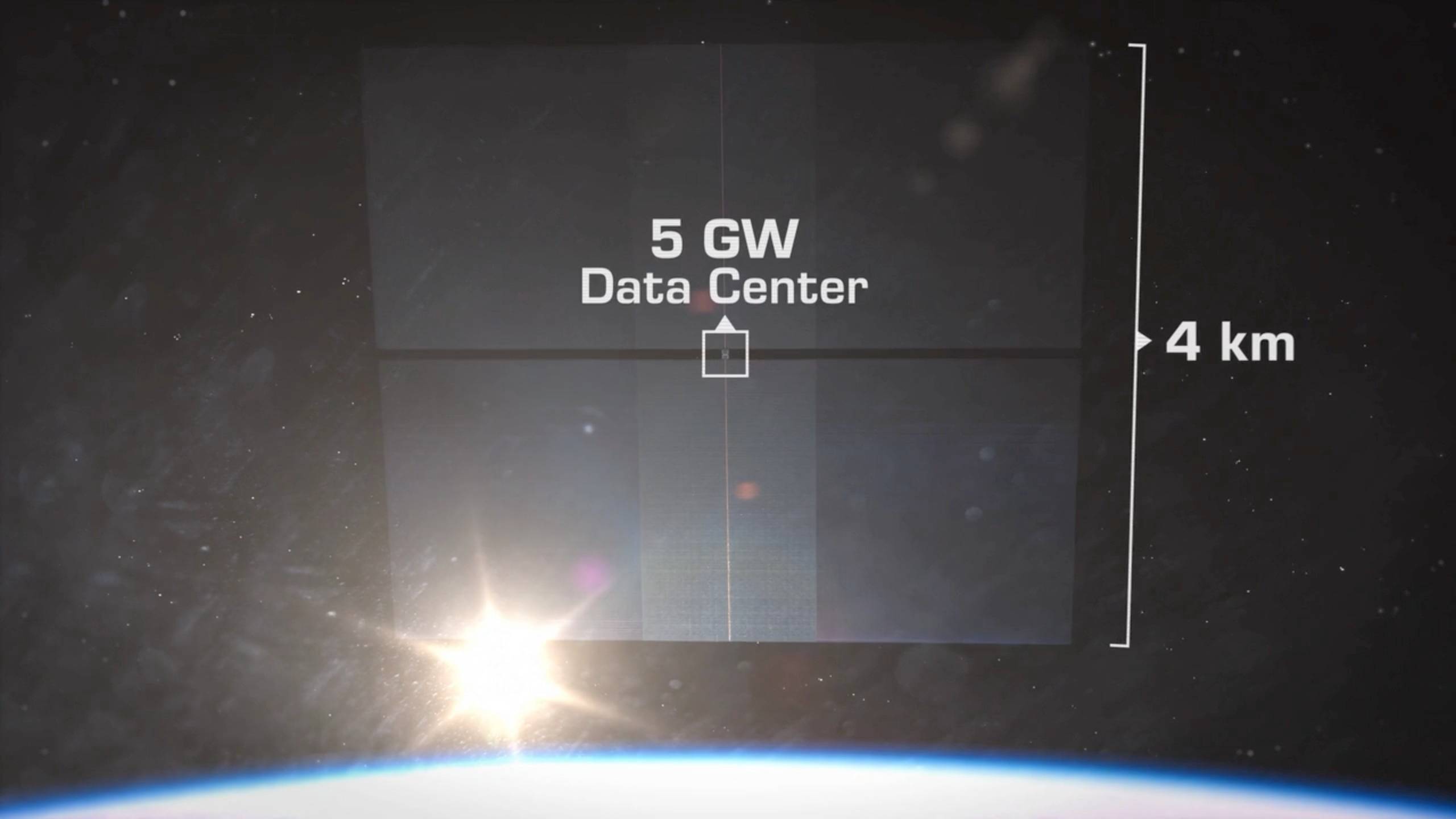

Per affrontare lo stesso problema, Google prevede di lanciare una costellazione di satelliti alimentati a energia solare, dotati di chip TPU sviluppati internamente da Google (utilizzati per l'elaborazione dati, simili alle GPU di Nvidia) per creare un "data center orbitale di intelligenza artificiale" nello spazio .

Lo spazio è necessariamente più economico ed efficiente della Terra?

Perché lo spazio? Il ragionamento di Google è semplice e diretto.

1. 8 volte più efficiente: se un satellite che trasporta un chip si trova nell'orbita corretta, l'efficienza dei suoi pannelli solari è 8 volte superiore a quella della Terra.

2. Alimentazione elettrica ininterrotta 24 ore su 24, 7 giorni su 7: nello spazio non ci sono né oscurità né nuvole, a differenza dei pannelli solari sulla Terra, che possono generare elettricità ininterrottamente.

▲ Musk pubblica una X dicendo che i satelliti AI nello spazio possono proteggere la Terra

3. Consumo di risorse pari a zero: nello spazio, i data center non hanno bisogno di consumare la limitata superficie terrestre o grandi quantità di acqua per il raffreddamento.

▲ Aziende come Apple, Huawei, Tencent e China Mobile hanno inaugurato data center nel Guizhou. Fonte immagine: Xinhua News Agency

I data center di tutto il mondo si stanno sempre più avvicinando a colli di bottiglia energetici. Vengono costruiti in Islanda e Norvegia per il raffreddamento e nel deserto del Nevada per l'elettricità. In Cina, la maggior parte delle grandi aziende localizza i propri data center in località come Guizhou e Zhongwei nel Ningxia, affidandosi all'ambiente per il raffreddamento.

Tuttavia, l'ambiente spaziale è molto più complesso rispetto a quello terrestre. Nel suo articolo di ricerca, Google descrive in dettaglio le sfide che sta attualmente affrontando e i metodi che sta utilizzando per affrontarle.

Per far sì che l'intelligenza artificiale "tocchi il cielo", Google deve risolvere tre sfide principali.

Sfida 1: Una "rete locale" nello spazio?

L'addestramento dell'intelligenza artificiale richiede un numero enorme di chip che lavorano insieme, con requisiti estremamente elevati in termini di larghezza di banda e latenza di connessione. Sulla Terra, possiamo ottenere una trasmissione dati ad alta velocità utilizzando la fibra ottica, ma come possiamo farlo nello spazio?

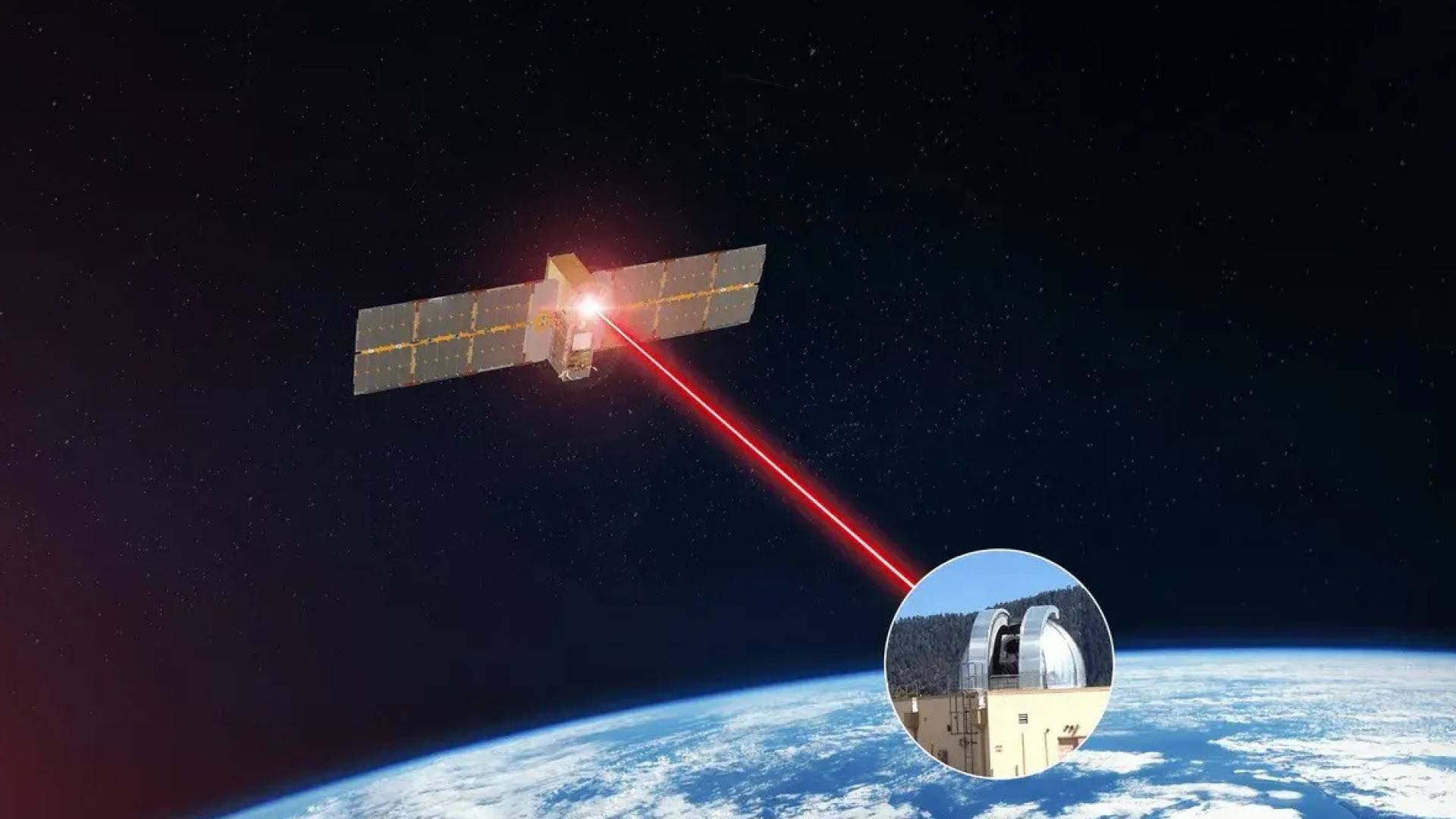

La soluzione di Google: volo in formazione + comunicazione laser.

Hanno in programma di far volare i satelliti "molto vicini tra loro", a una distanza di pochi chilometri o meno l'uno dall'altro.

Nella loro costellazione simulata di 81 satelliti, ogni satellite è dotato di un pannello solare, di un sistema di raffreddamento delle radiazioni e di un modulo di comunicazione ottica ad alta larghezza di banda; e la distanza tra i satelliti varia dinamicamente tra 100 e 200 metri .

A una distanza così ravvicinata, è possibile ottenere un'interconnessione ad alta velocità tramite collegamenti ottici intersatellite in spazio libero (FSO ISL). Google ha rivelato nel suo articolo che la loro dimostrazione ha raggiunto con successo una velocità di trasmissione bidirezionale di 1,6 Tbps .

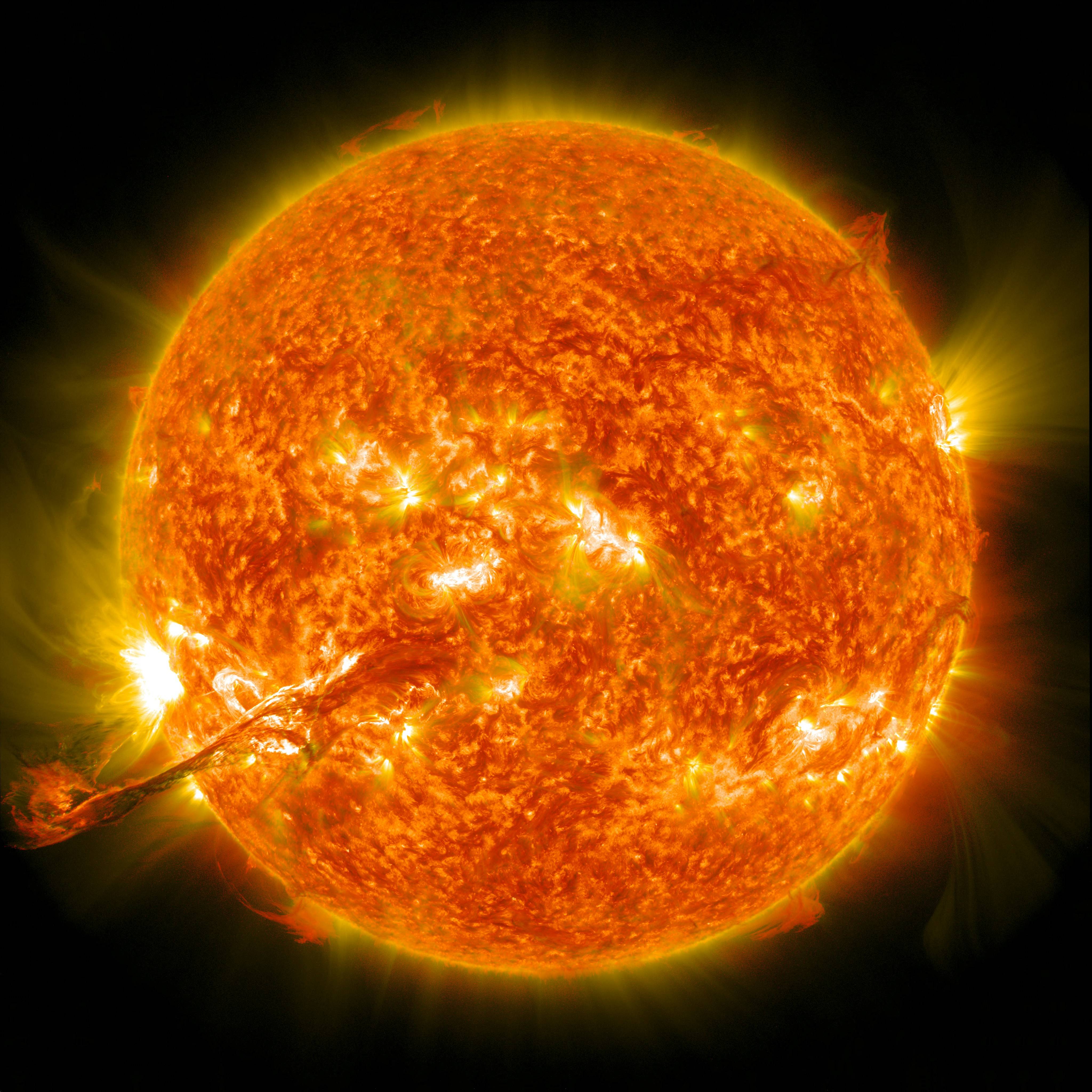

Problema due: "Radiazione" cosmica?

L'ambiente spaziale è estremamente ostile. Sebbene il sole fornisca energia, emette anche particelle ad alta energia (radiazioni) mortali, che possono essere devastanti per i chip più all'avanguardia.

▲ Fonte dell'immagine: NASA

La soluzione di Google: resistere.

Hanno inviato il loro chip Cloud TPU v6e (Trillium) al laboratorio e lo hanno bombardato con un fascio di protoni da 67 MeV.

Il risultato è stato "sorprendentemente resistente alle radiazioni", con la memoria ad alta larghezza di banda (HBM) più sensibile della TPU che ha iniziato a funzionare male solo dopo essere stata esposta a una dose di 2 krad(Si), che è quasi tre volte la dose di radiazioni prevista per la missione quinquennale (750 rad(Si)).

Ciò significa che la TPU di Google può funzionare ininterrottamente nell'orbita terrestre bassa per 5 anni senza subire danni permanenti.

Google prevede di collaborare con Planet per lanciare due prototipi di satelliti entro il 2027, allo scopo di testare ambienti operativi reali .

▲ Sito web ufficiale di Planet, che si concentra principalmente sull'analisi delle immagini satellitari e dei dati terrestri.

Sfida 3: Feedback sui dati

Nello spazio, il trasferimento dei dati tra GPU è rapido ed efficiente, ma anche se i calcoli vengono completati nello spazio, come è possibile trasmettere i dati alla Terra ad alta velocità?

Si tratta di una sfida importante, che Google riconosce nel suo documento e che deve ancora essere risolta.

Problema di latenza : secondo il documento, l'"orbita al tramonto" scelta da Google, pur massimizzando l'energia solare, aumenterà la latenza verso determinate posizioni terrestri.

Collo di bottiglia della larghezza di banda : l'attuale record per la comunicazione ottica "terra-aria" è ancora di 200 Gbps , stabilito dalla NASA nel 2023.

200 Gbps sembrano una velocità impressionante, ma per un data center di intelligenza artificiale spaziale questo canale è ben lungi dall'essere sufficiente.

Tuttavia, al di sopra di tutte queste impegnative difficoltà tecniche (reti locali, radiazioni, comunicazioni terrestri), si trova un ostacolo fondamentale e fatale che determina se tutto ciò che è stato detto finora valga la pena di essere risolto: il costo dell'andare nello spazio .

Questo era l'ostacolo più grande: mandare nello spazio qualcosa che pesava un chilogrammo era più costoso che spedire lo stesso peso in oro.

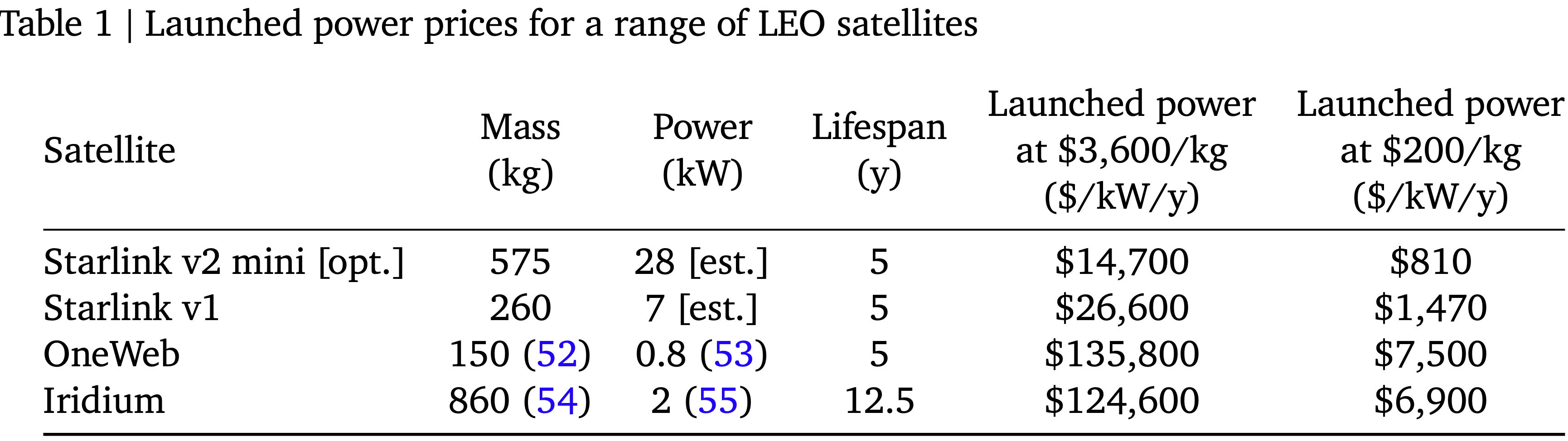

▲ Confronto dei costi di lancio per una gamma di satelliti in orbita terrestre bassa

Google ha calcolato nel suo articolo che se il costo di lancio di SpaceX potesse essere ridotto a 200 dollari al kg (stimato intorno al 2035), il costo unitario dell'energia dei data center spaziali potrebbe essere paragonabile a quello dei data center terrestri, ovvero circa 810 dollari al kW all'anno, sovrapponendosi completamente alla fascia di prezzo dei data center degli Stati Uniti compresa tra 570 e 3000 dollari al kW all'anno.

In altre parole, quando i razzi diventeranno sufficientemente economici, lo spazio sarà più adatto della Terra per costruire centri dati.

Tuttavia, la realtà è che l'attuale prezzo di lancio è più di dieci volte superiore al prezzo ideale.

Chi può realizzare tutto questo? SpaceX

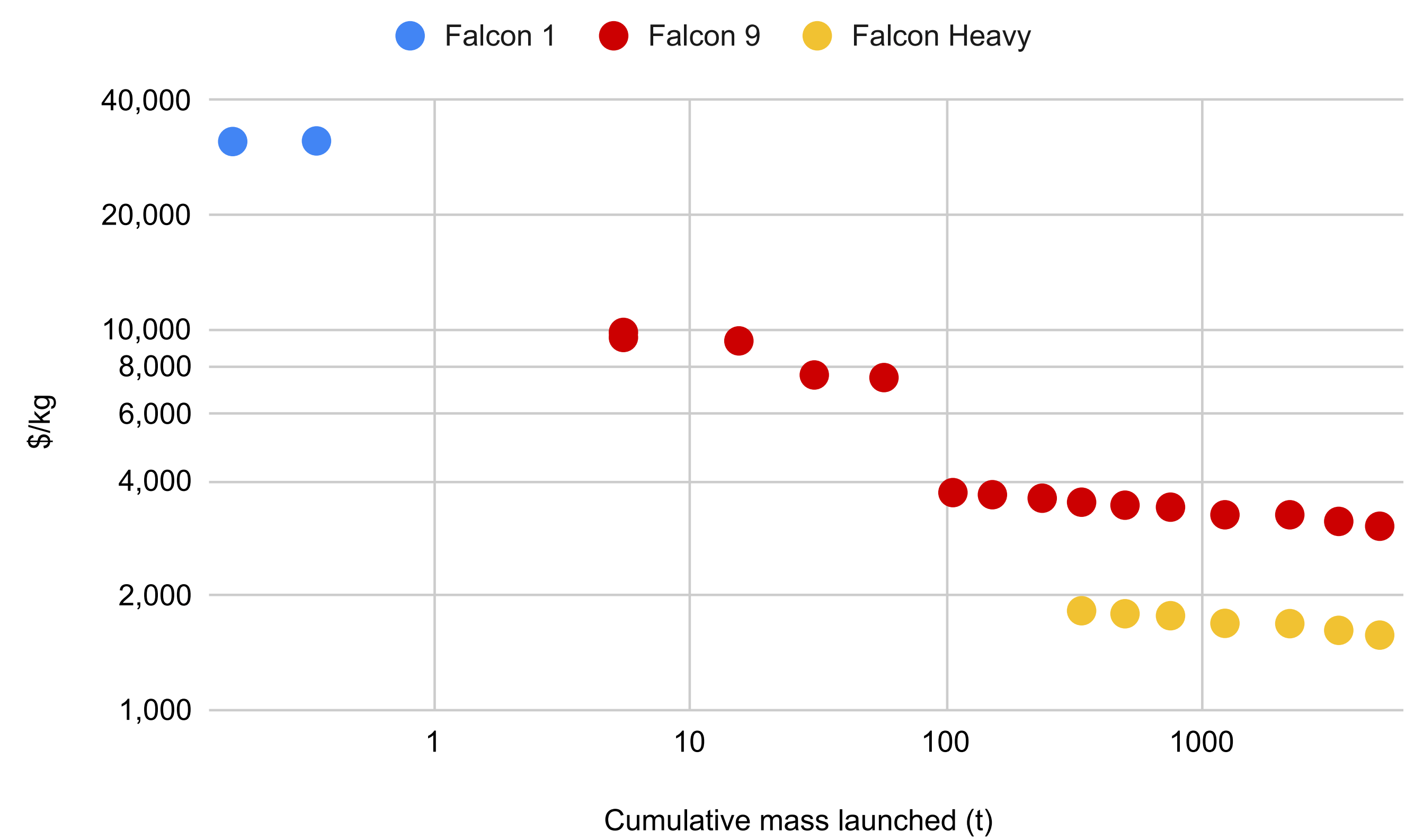

Nel suo articolo, Google ha adottato esplicitamente l'ipotesi della curva di apprendimento di SpaceX: ogni volta che la massa totale del lancio raddoppia, il costo unitario del lancio diminuisce del 20% .

▲ Dal primo lancio riuscito del Falcon 1, la massa del carico utile di SpaceX, calcolata al prezzo più basso realizzato, è gradualmente cambiata per i diversi tipi di razzi.

Dal Falcon 1 al Falcon Heavy, SpaceX ha ridotto i costi di lancio da 30.000 dollari/kg a 1.800 dollari/kg; l'obiettivo per Starship è di 60 dollari/kg con una riutilizzabilità 10 volte superiore e, in casi estremi, potrebbe essere ridotto a 15 dollari/kg.

Ciò significa che è molto probabile che SpaceX diventi l'azienda su cui si baserà il modello economico dei data center spaziali di Google.

Se Nvidia monopolizza le GPU sulla Terra, allora SpaceX potrebbe un giorno monopolizzare la potenza di calcolo nello spazio.

Sulla Terra, Nvidia vende GPU; nello spazio, SpaceX vende orbitali.

Pochi giorni prima che Google pubblicasse il suo documento, il 2 novembre, la potente GPU H100 di Nvidia è stata inviata nello spazio per la "prima volta" .

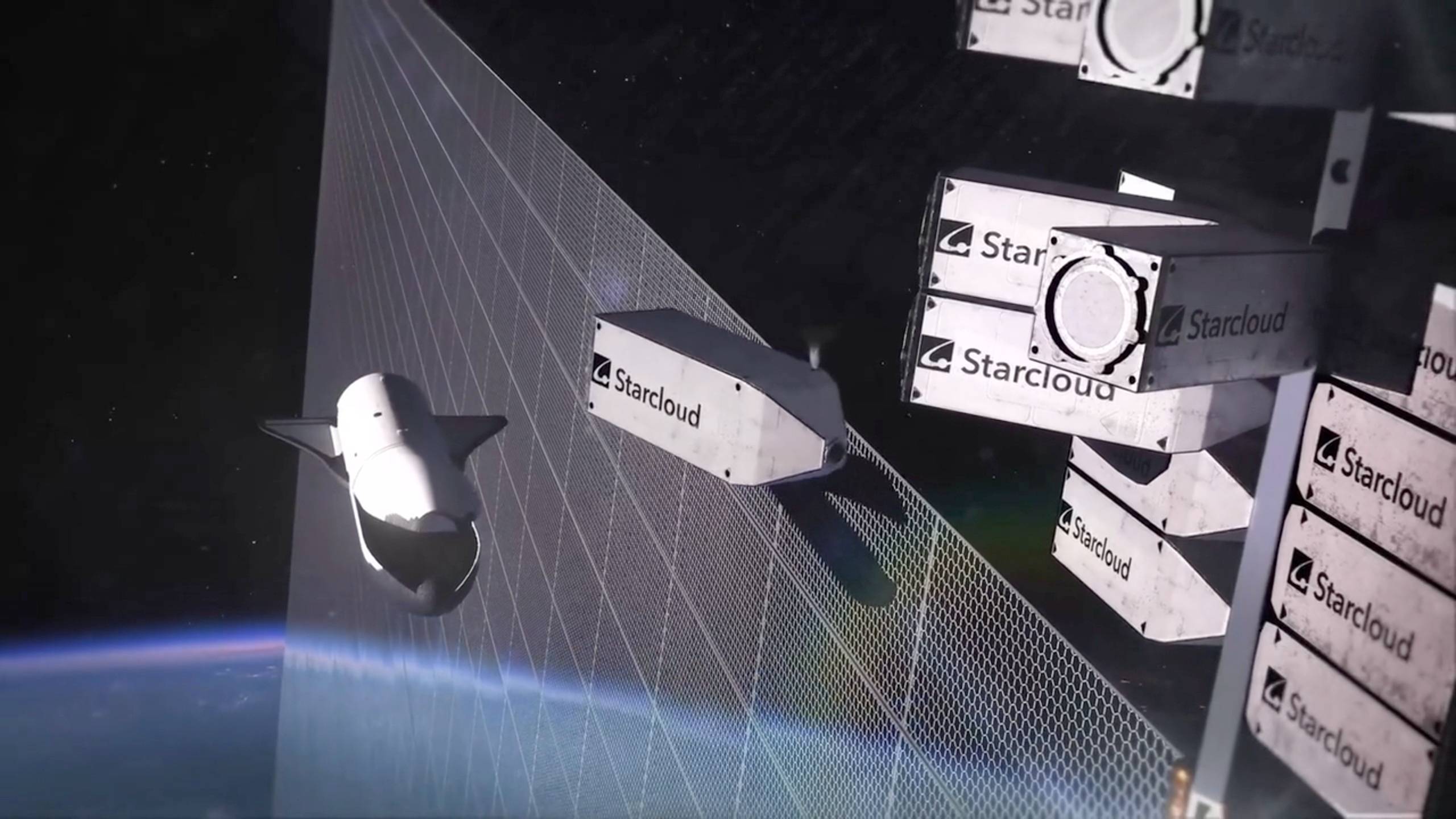

L'H100, trasportato su un satellite da una startup chiamata Starcloud, vanta una potenza di calcolo 100 volte superiore a quella di qualsiasi altro computer spaziale precedente.

▲Starcloud è stata fondata nel 2024 con l'obiettivo iniziale di costruire data center nello spazio e ha ricevuto investimenti da Nvidia, Y Combinator e altri.

La loro missione è più diretta: elaborare dati in tempo reale in orbita. Il CEO di Starcloud ha fatto un esempio: i dati grezzi di un satellite SAR (radar imaging) sono estremamente grandi. Invece di scaricare centinaia di gigabyte di dati grezzi, è meglio analizzarli in orbita utilizzando H100 e inviare solo un risultato di 1 KB , come "una nave si trova in una certa posizione e la sua velocità è così elevata".

Alla domanda su come sia stato possibile realizzare tutto questo, il CEO di Starcloud ha anche indicato Musk: la loro visione si basa interamente sulla "riduzione dei costi apportata da SpaceX Starship" .

Il satellite Starcloud-1, dotato di una GPU NVIDIA H100, è stato lanciato nello spazio tramite il volo Falcon 9 Bandwagon 4 di SpaceX.

Negli ultimi cinque anni, Nvidia ha ripetutamente battuto il suo record di maggiore capitalizzazione di mercato, principalmente perché fornisce le unità di elaborazione (GPU) più potenti; controlla l'ecosistema CUDA (Nvidia General Computing Platform), creando un blocco software; ed è diventata la fonte di potenza di calcolo upstream per tutte le aziende di intelligenza artificiale (OpenAI, Anthropic, Google).

Nell'era della potenza di calcolo spaziale, tutti e tre questi fattori potrebbero essere ridistribuiti e, in quel momento, la potenza di calcolo spaziale sarà il prossimo grande vantaggio.

I limiti dell'intelligenza artificiale potrebbero essere appena iniziati.

#Benvenuti a seguire l'account WeChat ufficiale di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.