Proprio ora, Windows supporta per la prima volta la porta C nell’era dell’intelligenza artificiale! Microsoft coinvolge tre giganti dell’intelligenza artificiale per ridefinire i sistemi operativi

"Il primo agente XX al mondo" sta diventando quasi una caratteristica standard dei prodotti di intelligenza artificiale lanciati sul mercato, e lo si può vedere quasi ogni giorno non appena si aprono gli occhi. Altman ha affermato in un recente discorso che il 2025 sarà un anno di svolta per gli agenti dotati di intelligenza artificiale.

La febbre degli Agent ha contagiato anche l'attuale conferenza per sviluppatori Microsoft Build 2025.

Durante tutta la conferenza stampa, la parola chiave che ricorreva più frequentemente non era IA, né il protagonista dell'anno scorso Copilot, bensì Agente, Agente e Agente.

Ma per Microsoft questa conferenza è chiaramente molto più di un semplice incontro di sviluppatori.

Copilot si sta evolvendo da un singolo prodotto a un hub di funzionalità a livello di sistema operativo. Inoltre, il CEO di Microsoft Satya Nadella ha chiarito: "Oggi abbiamo compiuto un altro passo importante per rendere Windows la migliore piattaforma per l'intelligenza artificiale".

Microsoft aggiunge una "porta USB-C per app AI" a Windows

In questa conferenza, Microsoft ha lanciato diversi aggiornamenti importanti, tra cui MCP ha attirato molta attenzione.

Il cosiddetto MCP, ovvero "Model Context Protocol", è stato originariamente lanciato come open source dall'azienda di intelligenza artificiale Anthropic lo scorso anno.

Si può semplicemente intendere come una "porta USB-C per applicazioni di intelligenza artificiale". Proprio come USB-C unifica le connessioni fisiche di diversi dispositivi, MCP può unificare le "connessioni digitali" affinché i modelli di intelligenza artificiale ottengano informazioni e utilizzino strumenti.

Ciò consentirà a varie applicazioni di intelligenza artificiale o agenti intelligenti di accedere più facilmente all'ecosistema Windows, sfruttando così le risorse di sistema, accedendo ai file e comunicando in modo efficiente.

Ora Windows 11 supporta nativamente il Model Context Protocol (MCP).

L'integrazione di MCP e Windows fornirà un framework standardizzato che consentirà agli agenti di intelligenza artificiale di connettersi alle applicazioni Windows native, consentendo alle applicazioni di partecipare senza problemi alle interazioni degli agenti. Questa funzionalità sarà disponibile nei prossimi mesi per alcuni partner selezionati, al fine di raccogliere feedback.

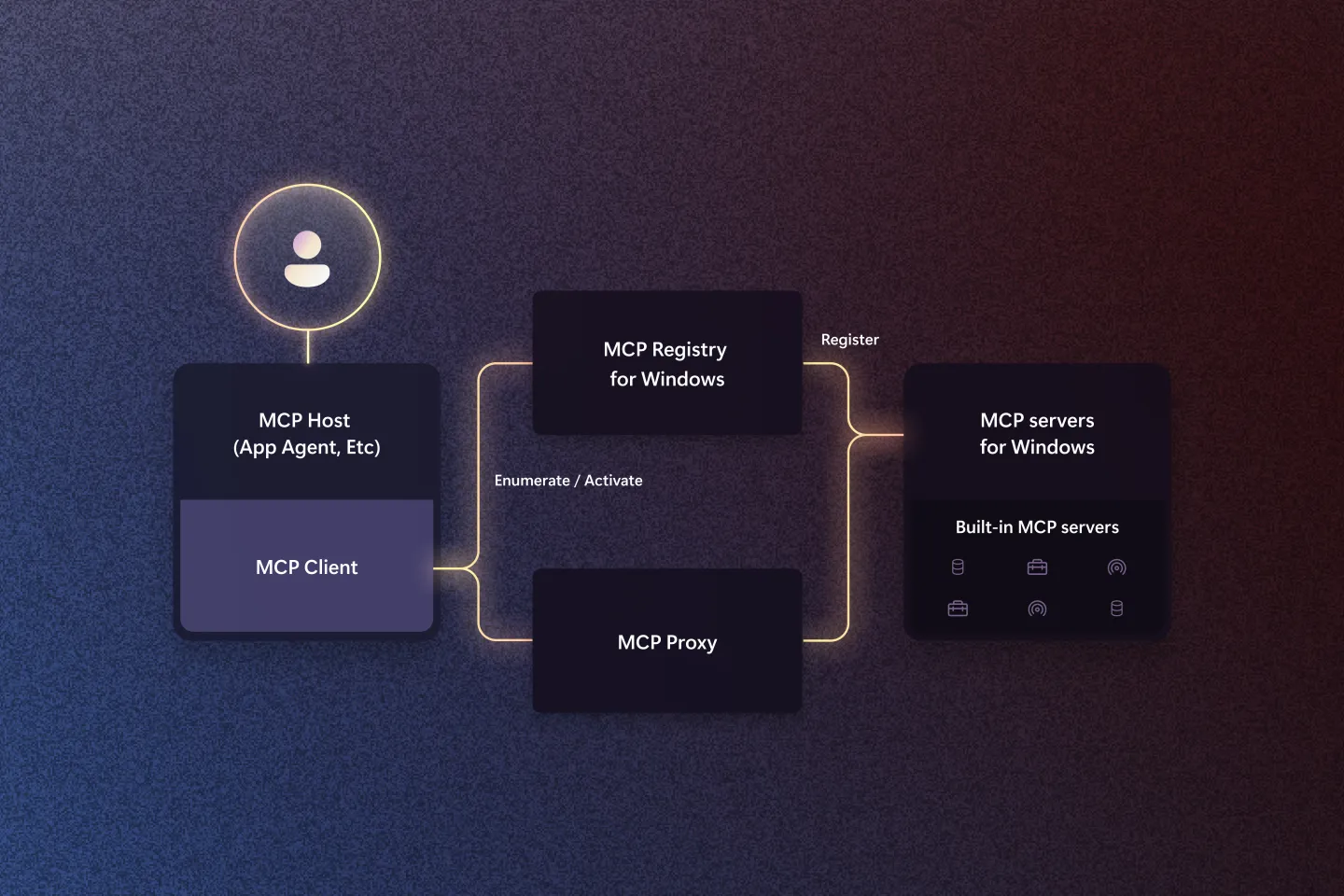

▲Architettura MCP su Windows

Si segnala che, per accelerare la costruzione dell'ecosistema, Microsoft ha collaborato con sviluppatori quali OpenAI, Anthropic, Perplexity, Figma, ecc. per integrare gradualmente le funzionalità MCP in più applicazioni.

In passato, consentire a un modello di intelligenza artificiale di accedere al file system di Windows o di controllare le impostazioni del sistema richiedeva molto sviluppo personalizzato; Dopo l'introduzione di MCP, gli sviluppatori possono incapsulare queste funzionalità come "endpoint di servizio" (server MCP) e consentire agli agenti di scoprirli e chiamarli tramite il registro MCP di Windows.

Microsoft ha sottolineato che questo non solo consentirà agli agenti di intelligenza artificiale di "vedere" più risorse nel sistema operativo, ma sbloccherà anche nuove possibilità di collaborazione con le applicazioni.

Ad esempio, il motore di ricerca AI Perplexity può individuare e richiamare automaticamente i documenti rilevanti nel file system di Windows tramite MCP, senza che l'utente debba selezionare manualmente la directory.

Tutto ciò che l'utente deve fare è inviare una richiesta in linguaggio naturale, come "Trova tutti i file relativi alle mie vacanze", e l'intelligenza artificiale può eseguire automaticamente la ricerca. In futuro, operazioni come la chiamata di dati di rete in Excel e l'individuazione e l'impostazione di parametri nel sistema potranno essere completate automaticamente dall'intelligenza artificiale.

"Vogliamo che Windows si evolva come piattaforma e che alla fine consenta l'integrazione degli agenti nel funzionamento quotidiano del sistema operativo e diventi un modo importante per consentire agli utenti di interagire costantemente con applicazioni e dispositivi", ha affermato Pavan Davuluri, responsabile di Windows, in un'intervista con The Verge.

GitHub Copilot riceve un importante aggiornamento per correggere automaticamente i bug e ottimizzare il codice

Oltre agli aggiornamenti a livello di Windows, Microsoft sta anche incrementando i suoi investimenti nell'"agentizzazione" nel campo dello sviluppo software.

La nuova versione di GitHub Copilot aiuterà gli sviluppatori a svolgere attività quotidiane come il refactoring del codice, il miglioramento della copertura dei test, la correzione delle vulnerabilità e persino l'implementazione di nuove funzionalità. Attualmente questa funzionalità è disponibile in versione di anteprima.

Gli sviluppatori che venivano svegliati a tarda notte dalle chiamate operative ora hanno la possibilità di dormire sonni tranquilli.

GitHub Copilot ora rileva automaticamente le perdite di memoria durante la notte, genera un report diagnostico e invia le correzioni a Copilot. Alla fine, Copilot completerà le correzioni del codice e invierà la richiesta di risarcimento, consentendoti di dormire sonni tranquilli.

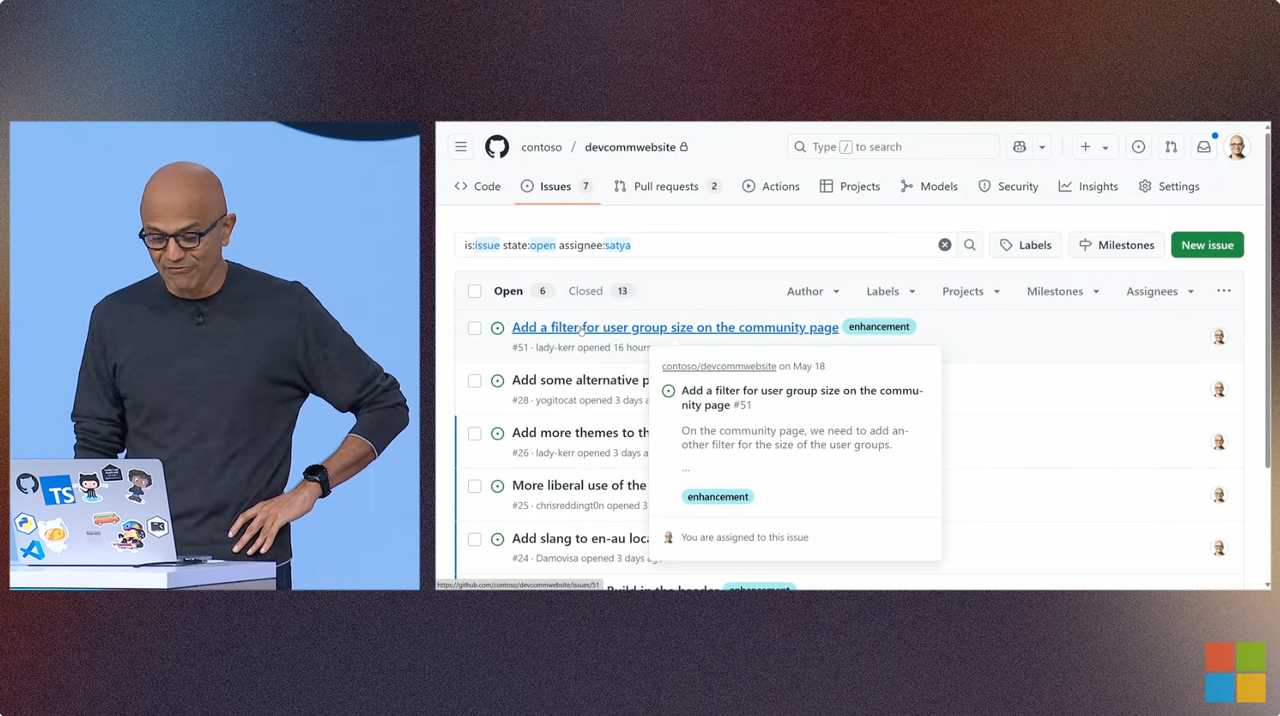

Per sottolineare che l'intelligenza artificiale può davvero funzionare, Nadella lo ha dimostrato anche sul posto.

Ad esempio, quando si desidera utilizzare Copilot per aggiungere filtri a una pagina della community, il programma non solo interpreta accuratamente le istruzioni, ma fornisce anche suggerimenti di ottimizzazione in modo proattivo, come l'aggiunta di elementi filtro piccoli, medi e grandi oppure il raggruppamento e la categorizzazione per categoria.

Nadella deve solo delegare il compito a Copilot, che lo prenderà automaticamente in carico, genererà una richiesta pull e infine svilupperà con successo la funzionalità.

Per i sistemi applicativi di livello aziendale che tradizionalmente presentano elevati costi di manutenzione e lunghi cicli di aggiornamento, in particolare quelli basati su architetture Java e .NET, Microsoft fornisce anche i relativi toolkit di modernizzazione.

Gli sviluppatori possono utilizzare AI Agent per generare automaticamente piani di aggiornamento, analizzare le dipendenze ed eseguire processi di migrazione, riducendo notevolmente il tempo necessario per completare un'attività che normalmente richiederebbe settimane o addirittura mesi a poche ore.

Nonostante si ipotizzasse che Microsoft e OpenAI si stessero allontanando, Nadella ha comunque avuto una videochiamata a distanza con il CEO di OpenAI, Sam Altman.

I due hanno parlato di come gli strumenti di intelligenza artificiale stiano cambiando l'ingegneria del software. Altman ha ricordato che OpenAI ha iniziato a esplorare esperienze di codifica intelligenti fin dal lancio di Codex nel 2021.

Oggi, gli agenti di intelligenza artificiale sono diventati "membri virtuali" dei team di sviluppo, in grado di lavorare in modo indipendente e di eseguire attività in batch. “È anche possibile assegnargli direttamente le correzioni dei bug e in pochi minuti verrà fornita una PR (pull request).”

Parlando dello sviluppo futuro del modello, Altman ha affermato che la fase successiva del modello sarà più affidabile, più automatizzata e più facile da usare. Gli sviluppatori non dovranno più selezionare manualmente i modelli, ma potranno contare su un vero e proprio "processo decisionale automatico + plug and play".

Nadella ha sottolineato che la sfida più grande al momento è la velocità del cambiamento tecnologico. Gli sviluppatori che sapranno interagire in modo approfondito con le nuove tecnologie fin dalle prime fasi otterranno enormi vantaggi.

Il nuovo servizio di Microsoft consente a ogni azienda di creare il proprio Copilot

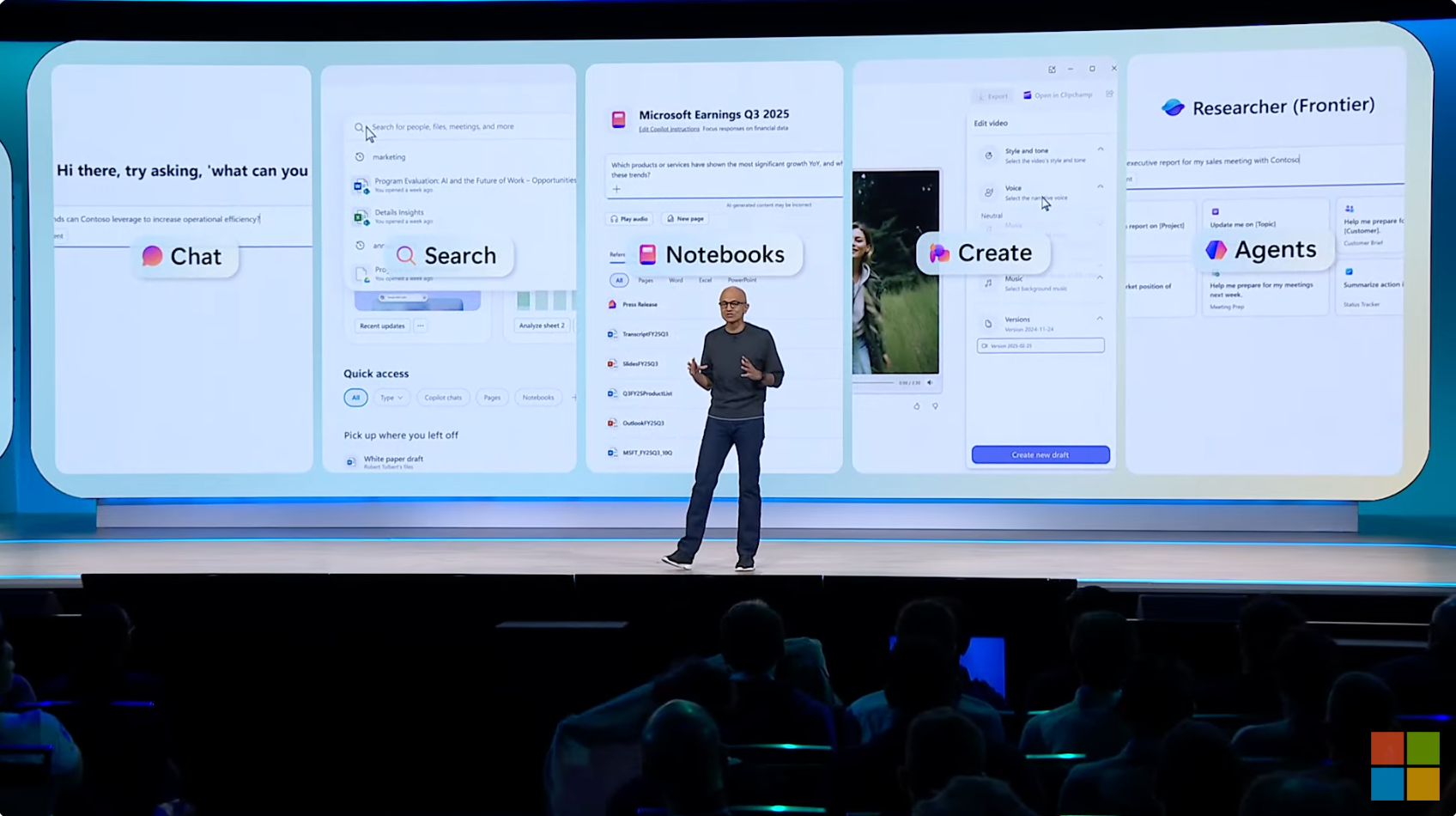

Alla conferenza, Microsoft ha anche illustrato i cinque principali ingressi funzionali di Copilot: Chat, Ricerca, Agente, Notebook e Crea.

Quando sottoponi i tuoi requisiti a Copilot, ti verrà mostrato il processo di pensiero, ovvero il processo di ragionamento della lunga catena di pensiero CoT.

Nella demo live, Copilot Studio può richiamare modelli come GPT-4 o server di terze parti come Docusign per elaborare automaticamente le attività da svolgere nel flusso di lavoro.

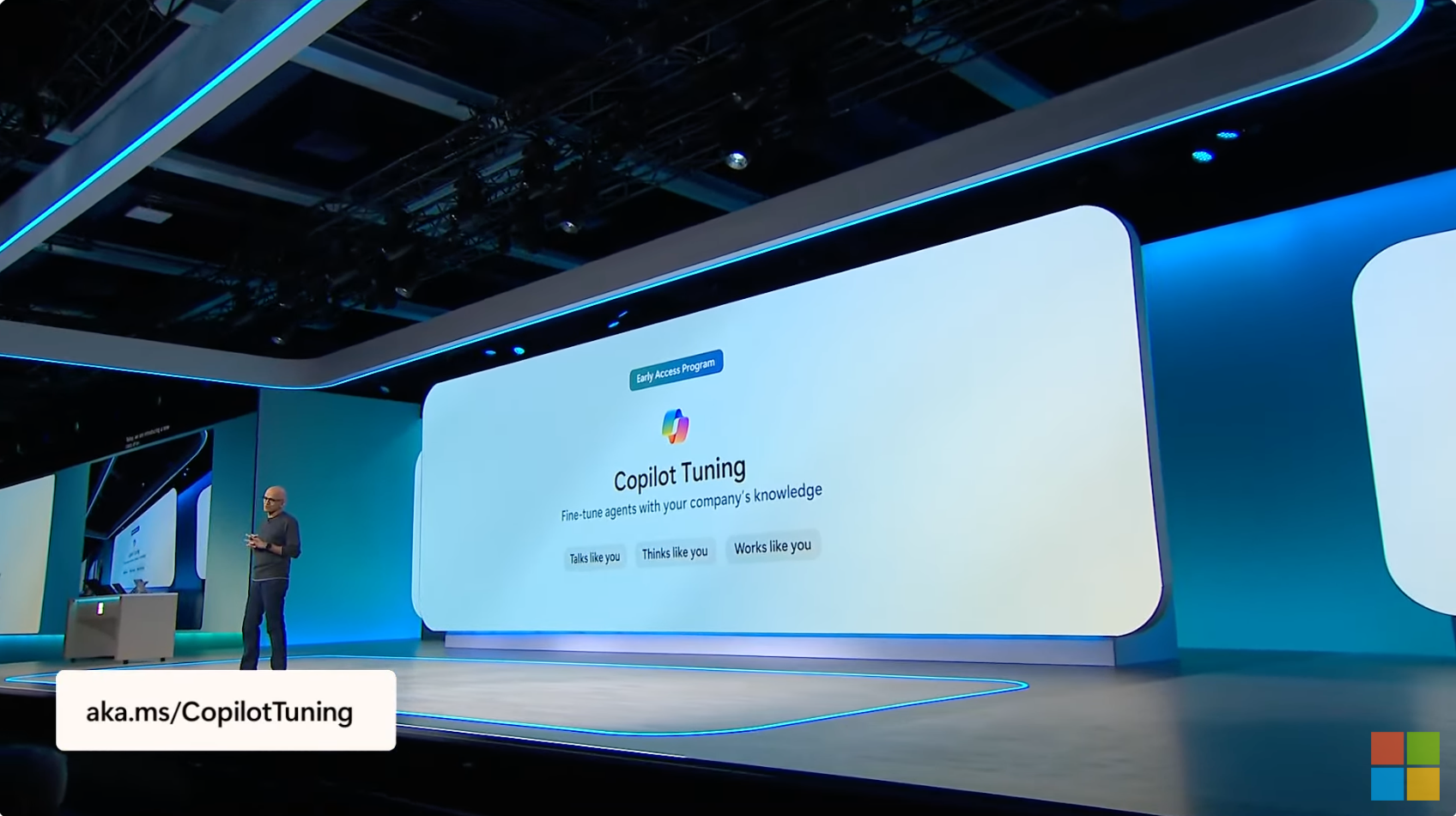

Per gli utenti aziendali, Microsoft ha lanciato il servizio "Copilot Tuning".

Con Microsoft 365 Copilot Tuning, i clienti aziendali possono utilizzare i propri dati per perfezionare i modelli e creare assistenti AI che rispondano meglio alle esigenze interne. Inoltre, per garantire la sicurezza dei dati, questi modelli ottimizzati sono accessibili solo all'interno dell'azienda e le autorizzazioni sottostanti sono controllate dal sistema.

Su questa base, gli sviluppatori possono utilizzare lo strumento Agent Builder di Microsoft 365 Copilot per creare agenti esclusivi.

Ad esempio, uno studio legale può creare un assistente per la redazione di documenti legali che generi documenti di conformità adatti al suo stile aziendale e alla sua terminologia professionale. In un altro esempio, una società di consulenza coinvolta in settori regolamentati come l'aviazione può creare un agente di domande e risposte basato sui documenti normativi accumulati dall'azienda per fornire ai consulenti risposte normative più precise.

Infine, Microsoft ha lanciato anche una piattaforma di aggregazione chiamata "Agent Store".

Come suggerisce il nome, questa nuova piattaforma può essere intesa come un "App Store" per agenti, che presenta vari agenti intelligenti creati da Microsoft, partner e clienti. È possibile esplorare, provare e condividere questi agenti intelligenti in un unico posto e distribuire gli agenti intelligenti appropriati ai colleghi per un utilizzo comune, migliorando così in modo complessivo l'efficienza della collaborazione.

Agent Store è ora ufficialmente lanciato, quindi potresti anche provarlo.

Huang Renxun, Musk e Ultraman sono apparsi tutti insieme e Microsoft ha coinvolto metà del team AI

Anche Azure AI Foundry, la piattaforma di sviluppo intelligenza artificiale di livello aziendale di Microsoft, ha lanciato una serie di aggiornamenti importanti.

La prima cosa che salta all'occhio è che il modello di punta di xAI, Grok 3, è approdato su Azure AI Foundry, offrendo un solido supporto ai servizi aziendali di Microsoft in termini di previsioni finanziarie, supporto alle diagnosi mediche, analisi di documenti legali e assistenza alla ricerca scientifica.

A partire da oggi, Grok 3 è disponibile per una prova gratuita di due settimane in Azure AI Foundry. A partire da giugno, il costo sarà di 15 $ per milione di token per l'output globale e di 16,5 $ per milione di token per l'output all'interno della zona dati.

Inoltre, analogamente all'utilizzo dei modelli OpenAI e Hugging Face su Azure AI Foundry, Grok 3 supporterà anche PTU (provisioned throughput), un metodo di distribuzione più conveniente.

Prima della conferenza Build, il fondatore e CEO di xAI, Musk, ha accettato un'intervista a distanza con Nadella, in cui ha rivelato che il fulcro della ricerca e dello sviluppo del prossimo modello Grok 3.5 è strettamente legato ai principi fondamentali.

Ha affermato: "La chiave è trovare le conoscenze di base della fisica, applicare gli strumenti della fisica nel processo di ragionamento e ricercare la verità con il minimo costo di errore".

Nadella ha fatto un esempio ulteriore: proprio come nella vita reale le auto devono sempre guidare in modo sicuro e corretto, allo stesso modo anche i robot devono svolgere compiti assegnati dagli esseri umani, i quali obbediscono tutti alle leggi della fisica mondiale.

Parlando dei problemi di sicurezza dell'intelligenza artificiale, Musk ha riassunto i suoi pensieri in una frase: "L'onestà è la migliore politica".

Attualmente, più di 1.900 modelli di intelligenza artificiale sono stati integrati in Azure AI Foundry, tra cui vari modelli di risposta, modelli di ragionamento, modelli di attività specifiche, modelli multimodali, ecc., che possono essere utilizzati liberamente dagli sviluppatori.

Oltre ai noti OpenAI e xAI, le aziende associate a Foundry Models ora includono anche Mistral AI, Meta, Black Forest Labs e il player cinese di punta DeepSeek.

Forse questo conferma indirettamente anche che le voci precedenti non erano infondate. Secondo quanto riportato dai media stranieri, Microsoft sta testando modelli di intelligenza artificiale di aziende come Anthropic, DeepSeek, Meta e xAI per esaminarne le prestazioni nel supporto a Copilot.

Vale la pena menzionare che tra i tre ospiti di spicco di questa conferenza Build, l'ultimo a comparire è stato Huang di Nvidia, che aveva appena terminato il suo discorso alla sua fiera Computex.

In una conversazione con il CEO di Microsoft Satya Nadella, Huang ha fornito una cifra sorprendente: la tecnologia progredisce di 40 volte ogni due anni. Ciò significa anche che per tenere il passo con l'evoluzione dell'intelligenza artificiale non è più sufficiente aggiornare l'hardware ogni pochi anni. Per tenere il passo è necessario effettuare "piccoli aggiornamenti ogni anno".

Secondo Nadella, l'investimento a lungo termine di Nvidia nell'ecosistema CUDA e la sua insistenza sulla compatibilità architettonica consentono di riutilizzare gli sforzi degli sviluppatori attraverso le generazioni. Anche i prodotti di qualche anno fa possono trarre vantaggio dagli algoritmi software più recenti.

Huang ha anche aggiunto: Da Hopper a Blackwell, NVIDIA ha ancora una volta ottenuto un balzo in avanti di 40 volte nelle prestazioni, che è indissolubilmente legato all'aggiornamento degli algoritmi, come l'ottimizzazione dell'architettura Transformer e l'iterazione della decodifica predittiva.

Tutto ciò è supportato da un enorme e in continua espansione ecosistema CUDA. Ogni ottimizzazione e miglioramento che gli sviluppatori globali investono in questo ecosistema si diffonderà come un'onda, interessando migliaia di utenti e aziende.

Il futuro di Windows appartiene agli umani, ma anche agli agenti

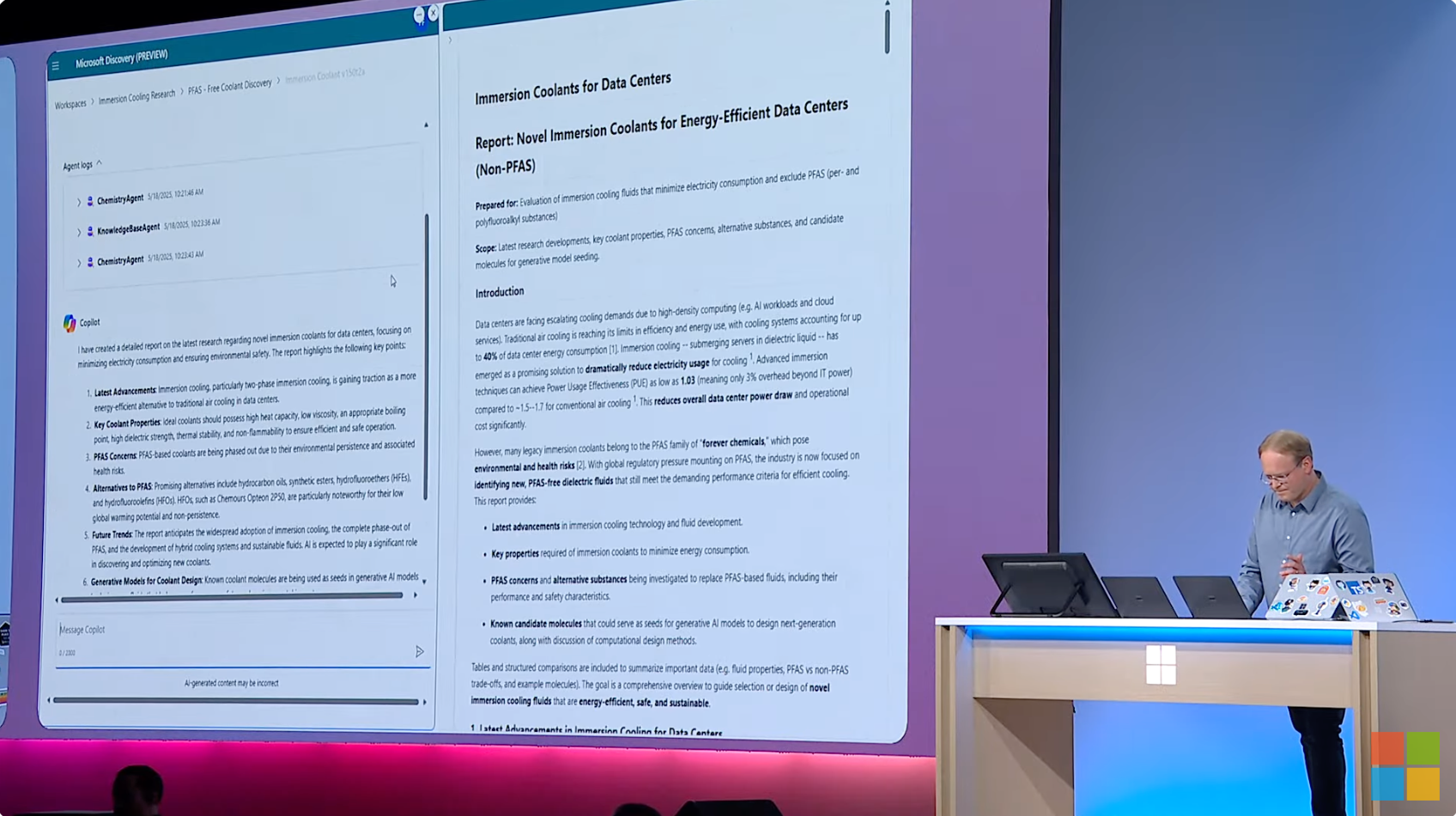

Parlare semplicemente dell'integrazione profonda dell'agente AI in ogni collegamento del flusso di lavoro potrebbe risultare un po' astratto, quindi perché non dare un'occhiata a una dimostrazione dal vivo di John Link, Senior Manager dell'innovazione dei prodotti presso Microsoft?

Ora, il tuo assistente di laboratorio, l'agente scientifico, è seduto accanto a te e tiene in mano un computer. È necessario completare un progetto che prevede tre fasi principali: ragionamento conoscitivo, generazione di ipotesi ed esecuzione di esperimenti.

Nella prima parte del ragionamento conoscitivo, l'agente scientifico chiama prima "ChemistryAgent" e poi "Knowledge BaseAgent" per aiutarti a recuperare, filtrare e integrare le informazioni necessarie per il progetto dall'enorme quantità di informazioni. Infine, l'agente scientifico presenta i risultati del lavoro sotto forma di riepilogo a sinistra e di rapporto completo a destra, e fornisce i link citati dall'agente durante il lavoro.

Nella seconda parte della generazione delle ipotesi, l'agente scientifico assegna il compito al ChemistryAgent, che elabora le ipotesi proposte e aggiorna le nuove idee e i nuovi requisiti in tempo reale. GenChemAgent ha quindi generato un piano di progettazione sperimentale basato su ipotesi.

Nella fase successiva, è possibile utilizzare i dati e il piano per verificare i risultati sperimentali.

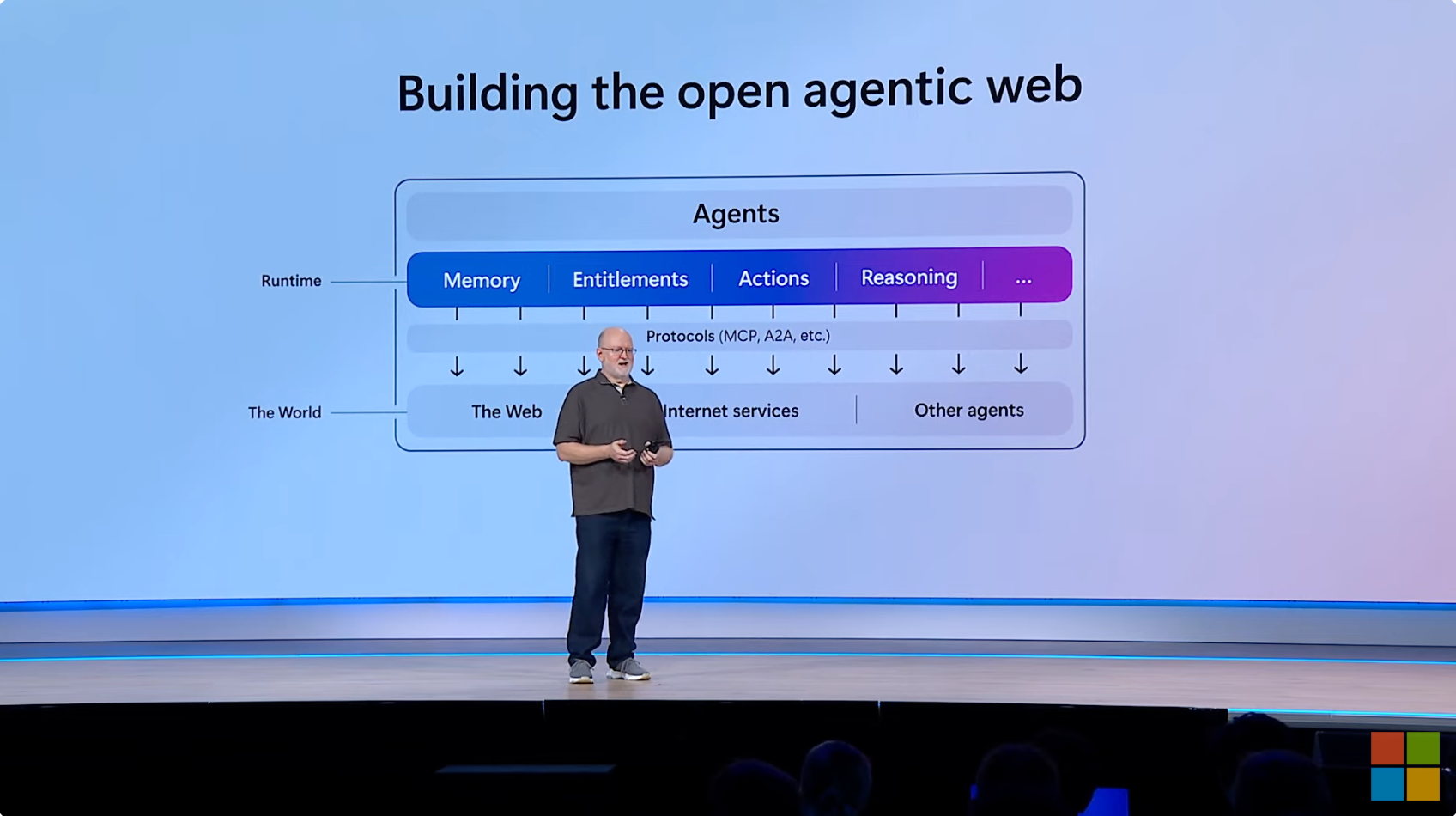

Se Agent deve davvero completare "l'ultimo miglio" delle azioni per conto degli esseri umani, come acquistare biglietti, prenotare hotel, fare esperimenti, ecc., il CTO Kevin Scott ha affermato che è necessario qualcosa di simile a un protocollo per fornire vincoli e supporto, da qui il supporto Microsoft MCP menzionato sopra.

Scott ha in mente altri progetti per la forma finale dell'Agente.

Scott ritiene che ciò che le persone desiderano davvero è un agente dotato di grandi risorse di memoria, in grado di rintracciare e localizzare frammenti di memoria con elevata precisione.

Allo stesso tempo, in futuro, Agent non sarà solo una rete "Agentic" aperta, ma anche un'app di intelligenza artificiale.

Kevin Scott ha affermato che, con l'avanzamento della tecnologia AI, gli agenti saranno in grado di svolgere attività più complesse, interagire con vari servizi e contenuti tramite protocolli aperti e intraprendere lavori collaborativi tra più attività e piattaforme.

Ha spiegato: "Spero che attraverso una sorta di protocollo aperto, tutti gli agenti possano raggiungere una vera interoperabilità, in modo che chiunque disponga di servizi o contenuti possa accedere all'agente in qualche modo e dire: "Ehi, sono qui". E indipendentemente da chi abbia creato l'agente, chiunque possa connettersi a questi contenuti e servizi."

Per supportare il funzionamento di tali agenti, è essenziale una piattaforma di sistema che sia flessibile, potente e facile da integrare.

In altre parole, il segnale inviato da questa conferenza Build è abbastanza chiaro: in futuro Windows non sarà più solo un sistema operativo per gli esseri umani, ma diventerà anche una piattaforma progettata specificamente per gli agenti di intelligenza artificiale.

Autore: Li Chaofan, Xu Yu, Mo Chongyu

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.