Questo generatore di immagini basato sull’intelligenza artificiale ha rilasciato il suo primo modello video: nessuna risoluzione, ma i netizen hanno affermato che l’immagine era sorprendente e ha superato le aspettative | con parole rapide

Nonostante le cause legali per violazione del copyright da parte di Disney e Universal Pictures, Midjourney, veterano del graphic design, non ha rallentato il ritmo. Anzi, ha lanciato il suo primo modello video stamattina presto, sotto pressione.

L'abbinamento dei colori è preciso, la composizione è squisita, le emozioni sono intense e lo stile è ancora attuale.

Midjourney non offre risoluzione o obiettivi lunghi, ma un'atmosfera unica e un'estetica riconoscibile. Midjourney è ambizioso e punta a diventare il "modello mondiale", ma se il design funzionale, attualmente un po' "grezzo", possa spingerlo oltre è ancora un mistero.

La versione con risparmio di flusso è la seguente:

- Dopo aver caricato o generato un'immagine, basta cliccare su "Anima". Per impostazione predefinita, una singola attività produrrà 4 video da 5 secondi, estendibili fino a un massimo di 21 secondi.

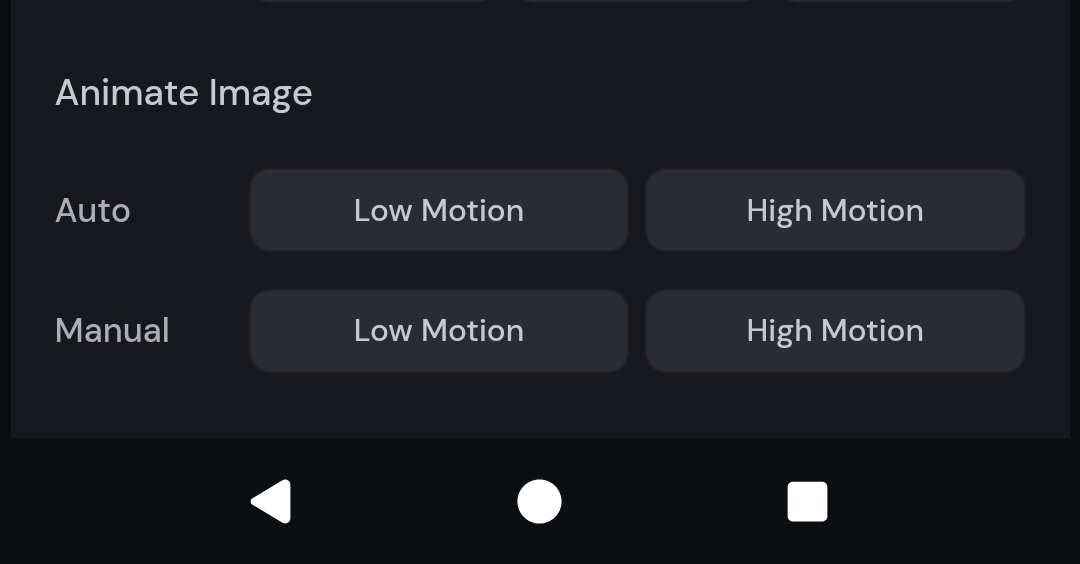

- Supporta modalità manuali e automatiche e gli utenti possono impostare l'effetto di generazione dell'immagine tramite parole di richiesta; fornisce opzioni di movimento basso e movimento alto, adatte rispettivamente per atmosfere statiche o scene fortemente dinamiche

- Il video è incluso negli abbonamenti esistenti ($ 10/mese) e utilizza 8 volte più risorse GPU rispetto alle attività grafiche

- Non supporta l'aggiunta di effetti sonori, l'editing della timeline, le transizioni tra clip o l'accesso alle API. La risoluzione è di soli 480p e il rapporto d'aspetto si adatta automaticamente all'immagine. È ancora una versione preliminare.

- Il modello video è un risultato graduale. In futuro, continueremo a lanciare modelli 3D e sistemi in tempo reale, con l'obiettivo finale di realizzare un modello globale.

Il modello video Midjourney è stato lanciato ufficialmente

Tu segui i tuoi propositi, io mi attengo alla mia iperrealtà.

Midjourney è sempre stata nota per il suo stile visivo fantasy e surreale. A giudicare dai risultati dei test degli utenti attuali, anche il suo modello video prosegue in questa direzione estetica, con uno stile stabile e un'elevata riconoscibilità.

Nel video condiviso dal blogger @EccentrismArt, un ragazzino cade verticalmente da un'altezza elevata. La modellazione del personaggio è semplice e dinamica, come se stesse saltando, cadendo o cadendo in caduta libera in un sogno. Il percorso del movimento è fluido e il baricentro del personaggio è relativamente naturale.

Gli isolati della città sono densamente popolati di luci e gli edifici sembrano inclinarsi e ruotare nello spazio, creando un'illusione visiva di distorsione spaziale, ma la dinamica complessiva dell'edificio non presenta evidenti tremolii o difetti di giunzione generati dall'intelligenza artificiale;

In questo video di una scena in una stazione del tram giapponese, il tram parte e il sole sta per tramontare. La temperatura del colore è ben controllata e la fonte di luce è naturale, creando un ritmo di movimento nell'immobilità e di immobilità nel movimento.

▲Suggerimento: Il treno che passa per la stazione. | @PAccetturo

La silhouette di una donna che indossa una camicia e tiene in mano un documento o un libro. Dietro di lei si vede l'enorme silhouette di una testa umana. Si può notare che la composizione a esposizione multipla/sovrapposizione è gestita in modo molto pulito, con un alone naturale e senza sovraesposizione. Non c'è da stupirsi che il progettista di Perplexity AI, Phi Hoang, abbia affermato che ha superato le aspettative.

Il noto blogger X @nickfloats ha condiviso un video di una ragazza che cammina su una banchina ferroviaria illuminata, con un treno ad alta velocità sullo sfondo. Le divisioni di luci e ombre erano evidenti e l'effetto tridimensionale era forte.

La coesistenza di notte, aurora boreale, neve, luci delle auto, sfocatura da movimento e altri elementi rappresenta una grande sfida per il modello di generazione video. Tuttavia, il modello gestisce con successo l'interferenza di più fonti luminose; le particelle di neve, la sfocatura dovuta alla velocità delle auto e gli effetti di luce lungo la traiettoria sono altamente coerenti.

▲Suggerimento: Subaru blu del Rally Mondiale 2022, in gara nella Finlandia innevata di notte, ripresa d'azione spettacolare, sfocatura di movimento dinamica, neve che vola, aurora boreale nel cielo, fari che illuminano la neve, contrasto elevato, illuminazione cinematografica | @JamianGerard

Indossando le classiche tute spaziali, dietro gli astronauti si estendono numerosi sentieri luminosi colorati, creando l'illusione di "viaggio" o "movimento ad alta velocità" con un forte senso del ritmo visivo.

▲Suggerimento: "Vivi un po', prendi dell'acido e voli via Mi sento come un astronauta nello spazio Non credo che farà i danni che dicono Mi sento come un astronauta nello spazio" | @JamianGerard

Elementi come luci, materiali e movimento dei liquidi sono tutte finestre per testare la capacità del modello di intelligenza artificiale di rappresentare oggetti di natura morta. In questo video, i cubetti di ghiaccio, la panna e il caramello sono dinamici e naturali, e l'etichetta non mostra alcuna distorsione evidente durante la rotazione del bicchiere.

▲Suggerimento: una bevanda di Starbucks, classica tazza alta, macchiato al caramello ghiacciato, glassa di caramello vorticosa, panna montata sopra, condensa sulla tazza, vivace e appetitoso, fotografia di alta qualità, rapporto d'aspetto 1:1. | @JamianGerard

Il senso di profondità prospettica è chiaro, la distanza e la vicinanza sono opportunamente stratificate e anche lo stile realistico è forte.

▲Suggerimento: Seduto nel mezzo della giungla con tanti animali selvatici che si muovono intorno S | @JamianGerard

Nelle strade apocalittiche di New York sono presenti molti dettagli, come auto in fiamme e rovine; secondo i requisiti delle parole chiave, il video generato deve avere una texture da pellicola da 35 mm ed è anche leggermente granuloso nel complesso.

▲Suggerimento: Una strada cittadina al mattino presto, con auto in fiamme e detriti sparsi ovunque. La scena evoca la New York degli anni '90, catturata nello stile del fotografo Jeff Wall, con la grana della pellicola 35mm. | @JamianGerard

La sfera di cristallo fluttua e gira lentamente, il che mette alla prova la stabilità della scena; anche i movimenti della telecamera risultano piuttosto fluidi.

▲Suggerimento: sfera cristallina sospesa e rotante lentamente sopra un campo colorato e calmo, ripresa con steady cam | @JamianGerard

Vale la pena notare che i risultati della generazione dei casi mostrati sopra potrebbero essere il risultato di più round di "estrazione delle carte", ma a giudicare dall'effetto finale, il risultato visivo è già piuttosto impressionante.

L'ambizioso Midjourney sta costruendo il secondo elemento costitutivo del "modello mondiale"

A partire da oggi, gli utenti di Midjourney possono caricare le immagini sul sito web ufficiale (Midjourney.com) oppure utilizzare direttamente le immagini generate dalla piattaforma e cliccare sul pulsante "Animazione" per convertirle in video.

Ogni attività genererà 4 video da 5 secondi e gli utenti potranno estendere qualsiasi segmento fino a 4 volte, aggiungendo 4 secondi ogni volta, per una durata totale fino a 21 secondi. Naturalmente, l'inizio è difficile, e il funzionario ha affermato che la lunghezza e le funzioni saranno ulteriormente ampliate in futuro.

La soglia logica operativa non è elevata. È possibile creare immagini in Midjourney come di consueto, ma ora è necessario un passaggio aggiuntivo per animare l'immagine. Inoltre, è possibile caricare immagini esterne come "fotogramma di partenza" e quindi utilizzare parole chiave per descrivere l'effetto dinamico che si desidera ottenere.

La versione 1 offre alcune impostazioni personalizzate regolabili per consentire agli utenti di avere un controllo più dettagliato sul contenuto dell'immagine.

In modalità Manuale, puoi immettere segnali specifici per impostare automaticamente il modo in cui si muovono gli elementi nel video e come si sviluppa la scena. Tuttavia, se non hai ancora un'idea per i segnali, puoi scegliere l'impostazione Automatica, che genererà automaticamente segnali di movimento e farà muovere le immagini.

In termini di stile creativo, puoi anche scegliere tra due impostazioni di movimento:

- Modalità Low Motion: adatta per scene d'atmosfera, la fotocamera rimane per lo più immobile e il soggetto si muove lentamente o ritmicamente. Lo svantaggio è che a volte potrebbe non esserci alcun movimento (ad esempio, persone che sbattevano le palpebre, vento che soffiava sul paesaggio, ecc.);

- Modalità High Motion: adatta per scene che richiedono un movimento intenso sia dell'obiettivo che del soggetto. Lo svantaggio è che un movimento eccessivo può talvolta causare errori o instabilità nelle immagini.

Per quanto riguarda il prezzo, la funzione video è direttamente integrata nel sistema di abbonamento di Midjourney e il prezzo di partenza è sempre di 10 dollari al mese.

Secondo il blog ufficiale, Midjourney richiede circa 8 volte più tempo GPU per video rispetto alle operazioni di elaborazione delle immagini, ma considerando la possibilità di generare video fino a 20 secondi, il costo medio al secondo è quasi lo stesso della generazione di immagini. Rispetto ai prodotti concorrenti, il suo rapporto qualità-prezzo è al primo posto.

Abbiamo anche utilizzato il motore di ricerca AI per ordinare brevemente i costi di abbonamento di alcuni modelli video tradizionali, a vostra disposizione.

Inoltre, Midjourney sta testando la modalità "Relax Mode" per gli abbonati Pro e superiori, che consente di completare l'attività di generazione a una velocità inferiore, riducendo così il consumo di risorse di elaborazione. Per quanto riguarda gli altri livelli di abbonamento, la tariffazione verrà comunque calcolata in base al tempo di utilizzo della GPU e al livello di abbonamento.

Al momento, ci sono molti punti di cui lamentarsi riguardo al modello video Midjourney. Il più tipico è la mancanza di alcune funzionalità chiave per la creazione professionale.

Innanzitutto, a differenza di Veo 3 di Google o Dream Machine di Luma, il modello video Midjourney non supporta attualmente l'aggiunta automatica di musica di sottofondo o effetti sonori ambientali. Se necessario, l'audio deve comunque essere aggiunto manualmente utilizzando altri strumenti di terze parti.

In secondo luogo, il modello video Midjourney non supporta la modifica della sequenza temporale e le clip video generate sono "jump cut", il che rende impossibile ottenere continuità nella storia e una connessione naturale tra le immagini, rendendo difficile controllare il ritmo della trama o la prefigurazione emotiva.

Inoltre, il modello video Midjourney attualmente non fornisce accesso API.

Ancora più importante, la risoluzione predefinita dei video generati da Midjourney è 480p (definizione standard) e il rapporto d'aspetto del video viene adattato automaticamente in base alle dimensioni originali dell'immagine. Verrà inoltre contrassegnato come 480p quando caricato su altre piattaforme.

▲Nota: Midjourney potrebbe modificare leggermente le proporzioni e le proporzioni del video di output finale potrebbero essere leggermente diverse dall'immagine iniziale.

I funzionari di Midjourney hanno anche ammesso che la versione attuale è ancora in una fase di esplorazione iniziale, concentrandosi su accessibilità, facilità d'uso ed estensibilità.

Il modello video è solo un estratto. Ciò che Midjourney vuole è un sistema di produzione di contenuti più completo.

Secondo il piano ufficiale, l'obiettivo finale è quello di costruire un "modello mondiale", ovvero integrare la generazione di immagini, il controllo dell'animazione, la navigazione spaziale tridimensionale e il rendering in tempo reale.

Si può pensare a questo come a un sistema di intelligenza artificiale in grado di generare immagini in tempo reale: puoi inserire una frase per comandare al protagonista dell'intelligenza artificiale di muoversi nello spazio 3D, la scena ambientale cambierà di conseguenza e potrai interagire con tutto.

Proprio come con i mattoncini, per raggiungere questo obiettivo abbiamo bisogno di un modello di immagine (per generare immagini statiche) → un modello video (per far muovere le immagini) → un modello 3D (per ottenere la navigazione spaziale e il movimento dell'obiettivo) → un modello in tempo reale (per garantire che ogni fotogramma possa rispondere in modo sincrono).

Secondo il piano di prodotto di Midjourney, questi quattro "elementi costitutivi" tecnici saranno forniti nei prossimi 12 mesi e infine integrati in un sistema unificato. Il modello video V1, come risultato graduale, rappresenta il secondo passo verso questo obiettivo finale.

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.