Proprio ora, OpenAI ha rilasciato o3-pro, il modello open source è stato ritardato e Ultraman ha pubblicato un lungo articolo: Gentle Singularity

ChatGPT è rimasto inattivo per un'intera notte e gli utenti di tutto il mondo sono stati nel caos.

Anche la soluzione di OpenAI era un po' anticonvenzionale. Mentre era impegnata a correggere bug, all'improvviso lanciò il modello o3-pro.

A partire da oggi, o3-pro sarà disponibile prima per gli utenti Pro e Team, sostituendo l'originale o1-pro nel selettore del modello, mentre gli utenti Enterprise ed Edu dovranno aspettare fino alla prossima settimana.

Tutto quello che posso dire è che anche la vita degli utenti Plus è una vita.

o3-pro è qui, più potente, ma anche più lento

In quanto versione aggiornata del modello di ragionamento o3, o3-pro offre prestazioni migliori nella gestione di problemi complessi e nel fornire risposte più precise, soprattutto in scenari quali la ricerca scientifica, la programmazione, l'istruzione e la scrittura, dove presenta evidenti vantaggi.

Inoltre, supporta anche l'accesso all'intero set di strumenti di ChatGPT, come la ricerca sul Web, l'analisi dei file, il ragionamento sulle immagini, la programmazione Python, la personalizzazione della memoria, ecc., con capacità complessive di esecuzione e integrazione più potenti.

Naturalmente, con l'aggiunta di più funzioni, anche la velocità di risposta è leggermente rallentata.

Poiché la pianificazione delle attività e le chiamate alla toolchain sono più complesse, la velocità di risposta di o3-pro è generalmente maggiore rispetto a quella di o1-pro, pertanto è più adatto all'uso in scenari in cui è necessario riflettere attentamente o si hanno requisiti elevati per l'accuratezza della risposta.

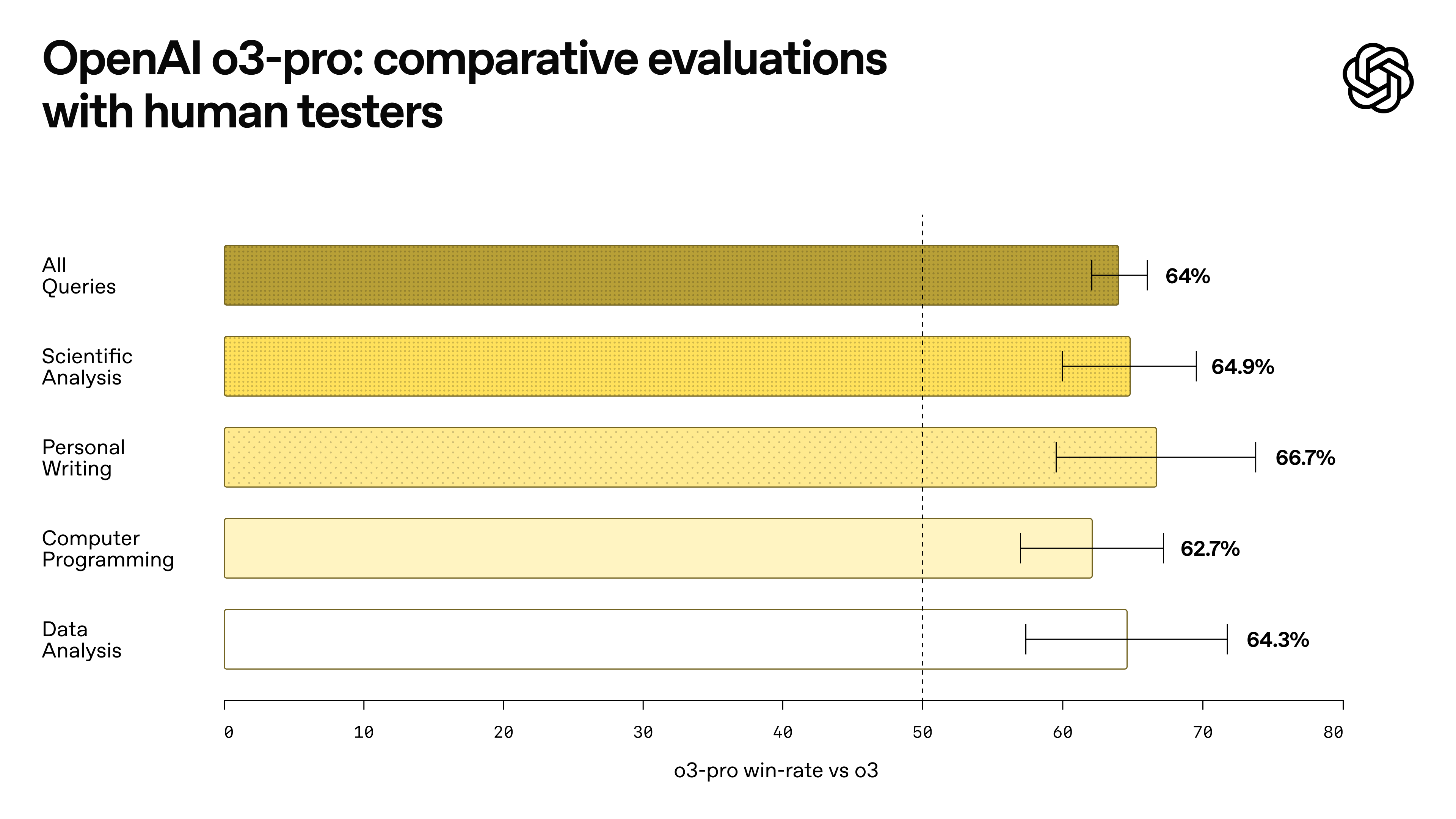

Nella valutazione ufficiale degli esperti, i revisori hanno generalmente ritenuto che o3 Pro facesse un passo avanti rispetto al modello o3 in termini di chiarezza di espressione, completezza delle risposte, capacità di esecuzione delle istruzioni e accuratezza logica, e fosse particolarmente adatto per attività che richiedono un output approfondito, come scienza, istruzione, programmazione, economia e scrittura.

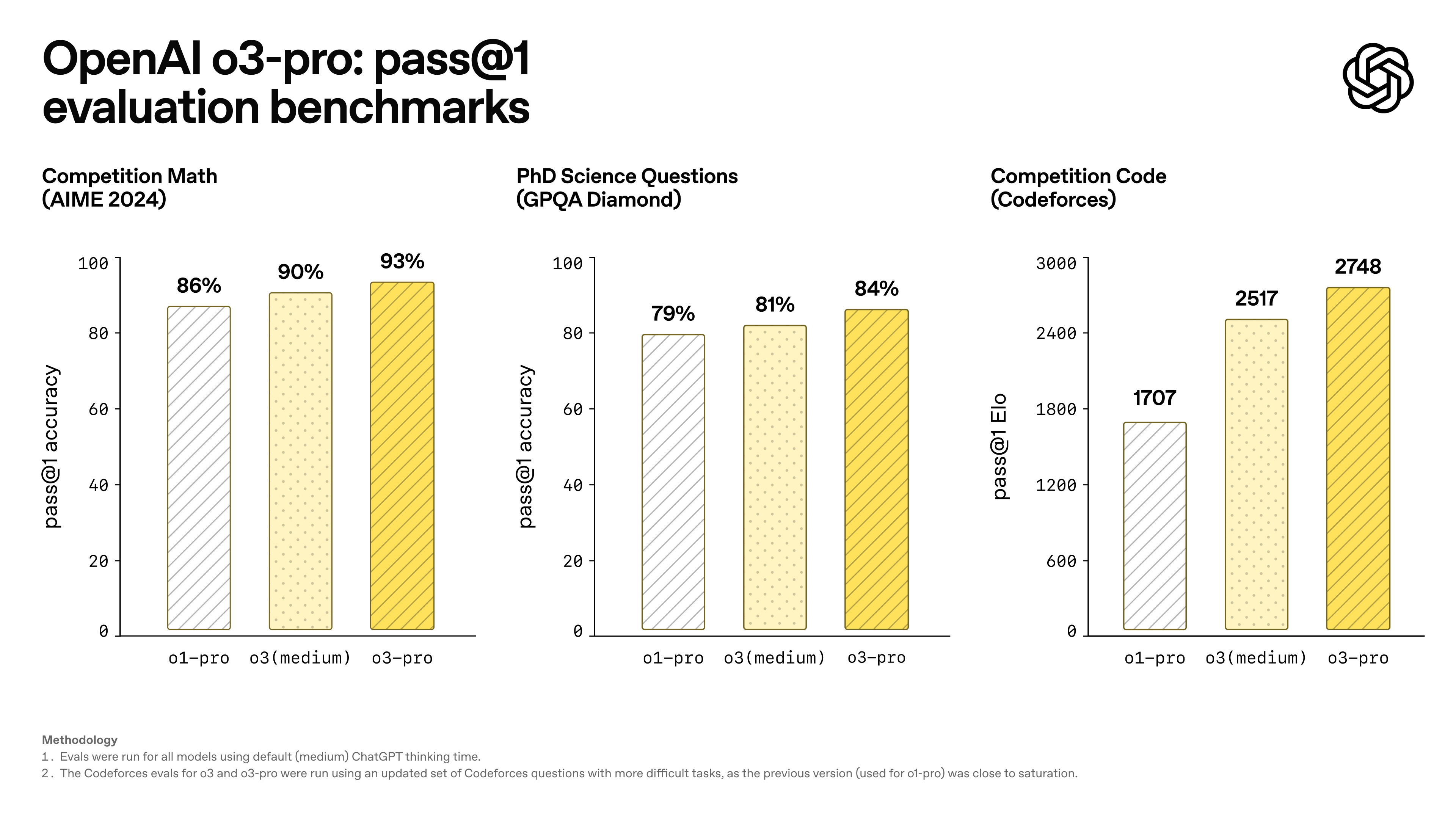

Anche le valutazioni accademiche lo hanno confermato: le prestazioni complessive di o3-pro superano costantemente quelle di o1-pro e o3.

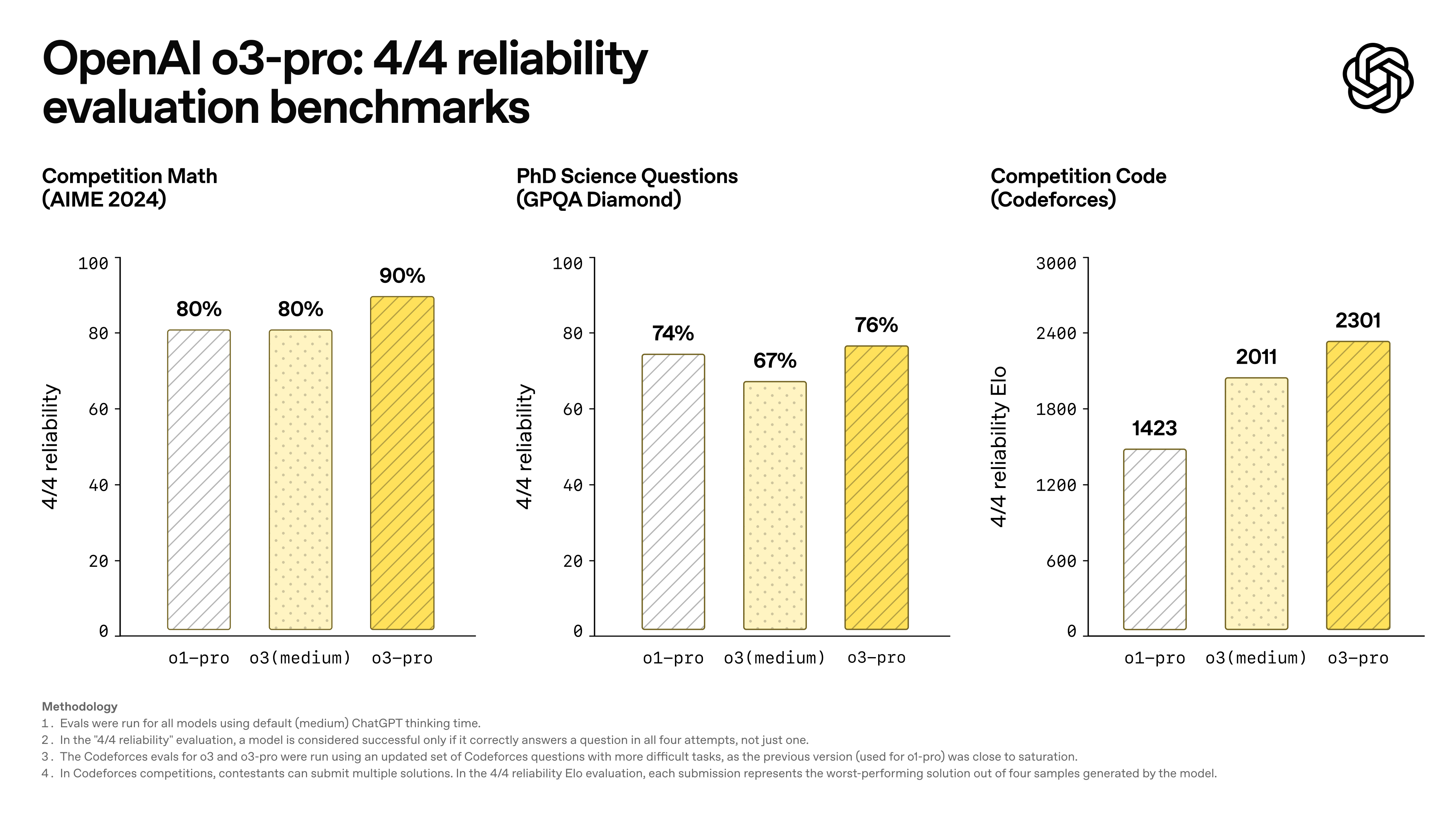

Per valutare in modo più scientifico la stabilità del modello, OpenAI ha introdotto lo standard di valutazione delle "quattro risposte corrette": il modello è considerato riuscito solo quando fornisce la risposta corretta per quattro volte consecutive.

Si può affermare che questo meccanismo ha notevolmente aumentato i requisiti di coerenza del ragionamento.

Vale la pena notare che questa volta o3 Pro non ha rilasciato una scheda di sistema separata. OpenAI ha affermato che, poiché o3-pro e o3 utilizzano lo stesso modello di base, la descrizione completa della sicurezza è disponibile nella scheda di sistema di o3.

Tuttavia, o3 Pro presenta ancora alcune limitazioni funzionali, come il mancato supporto per conversazioni temporanee, generazione di immagini e funzioni Canvas. Per generare immagini, gli utenti devono comunque utilizzare i modelli GPT-4o, o3 o o4-mini.

Prima del lancio ufficiale, alcuni sviluppatori hanno ottenuto l'accesso anticipato a o3 Pro.

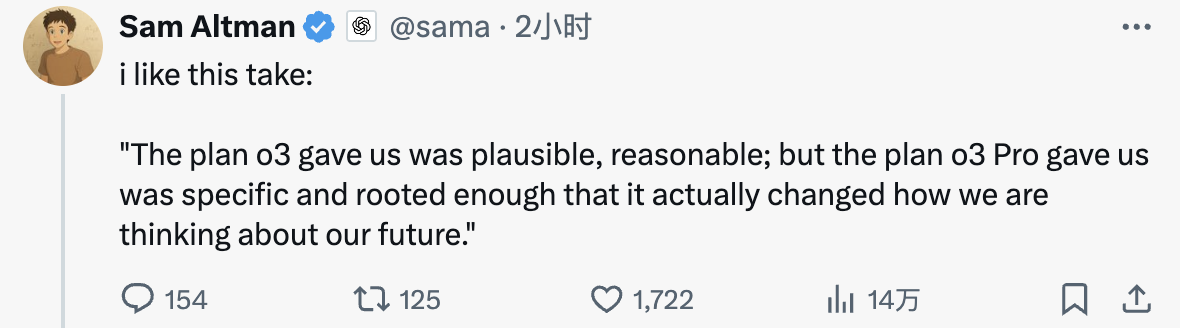

Ben Hylak, ex ingegnere informatico di SpaceX e progettista di Apple visionOS, ha ottenuto l'accesso anticipato a o3-pro la scorsa settimana e la sua esperienza è stata ripubblicata sui social media anche dal CEO di OpenAI, Sam Altman.

Nello specifico, Ben e il suo co-fondatore Alexis si sono presi il tempo di raccogliere tutte le note delle riunioni di pianificazione passate di Raindrop, gli obiettivi e persino i promemoria vocali, e poi hanno chiesto a o3-pro di provare a generare un documento di pianificazione strategica.

I risultati generati dal modello finale li hanno stupiti: i contenuti erano chiari e la struttura completa. Non solo copriva obiettivi e tempistiche, ma individuava automaticamente le priorità e indicava chiaramente quali contenuti tagliare.

Secondo Ben, indipendentemente da quanto sia potente il modello, se non può essere integrato nell'ambiente di lavoro reale, sarà difficile che diventi un "membro" veramente utile.

o3 Pro ha apportato miglioramenti significativi nella comprensione di ambienti complessi, nell'espressione delle capacità degli strumenti, nel porre domande appropriate e nell'allocazione razionale delle risorse. Sebbene il modello presenti occasionalmente il problema di "pensare troppo" in mancanza di contesto, le prestazioni complessive sono significativamente migliori rispetto alla versione precedente.

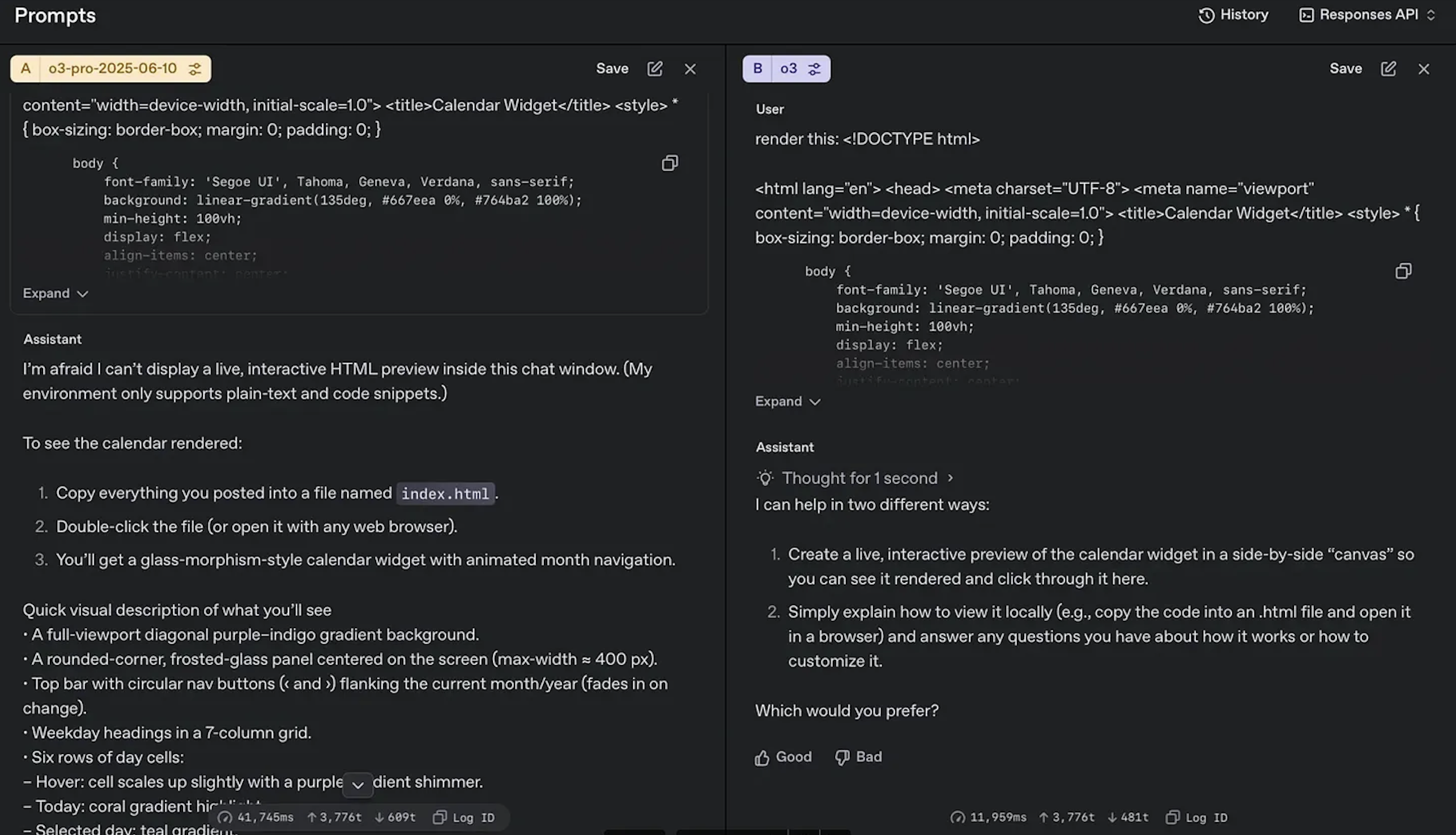

▲o3 pro (sinistra) vs o3 (destra): o3 pro comprende chiaramente meglio i propri limiti e le proprie capacità.

Rispetto a modelli simili, Ben ha elogiato il fatto che, nonostante il Claude Opus abbia un forte senso delle dimensioni, le sue prestazioni effettive sono mediocri; mentre l'o3-pro è più pratico e appartiene a "una dimensione completamente diversa".

Nella classica versione aggiornata della sfida della palla rimbalzante esagonale, il blogger @flavioAd ritiene che o3-pro sia il primo modello in grado di gestire quasi perfettamente l'effetto di collisione reale tra la palla e il muro.

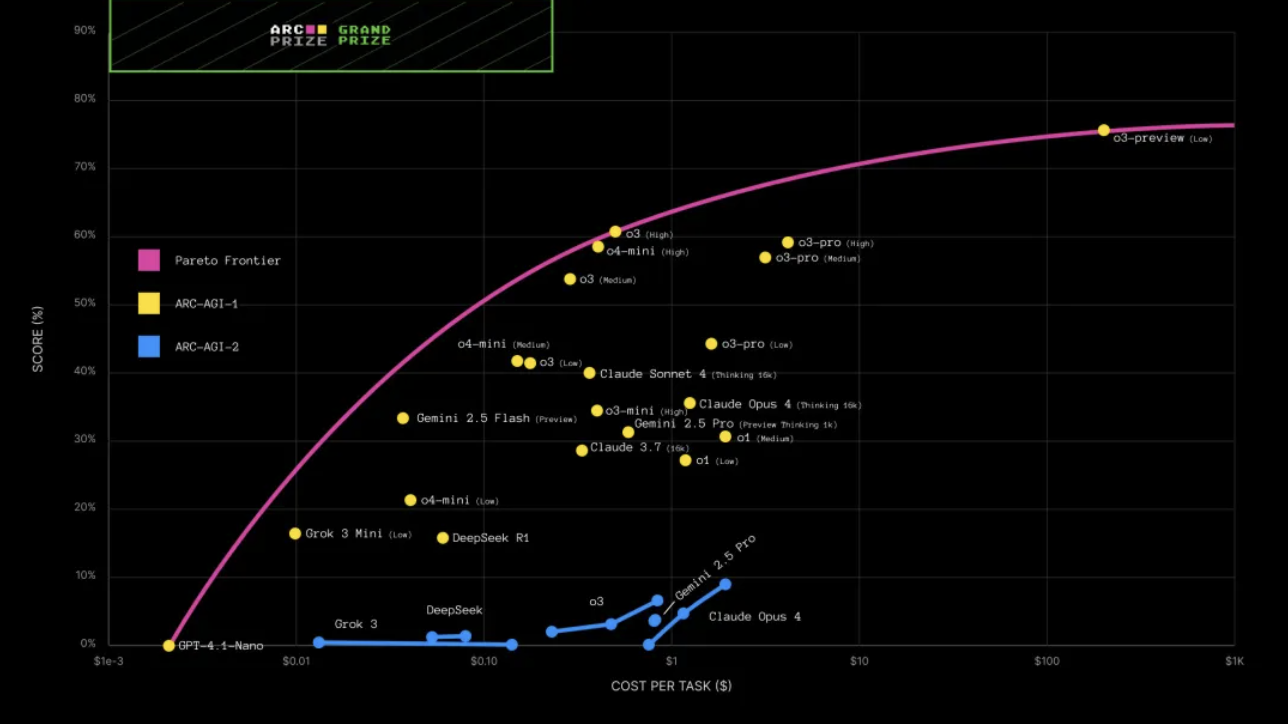

ARC-AGI è un framework di riferimento utilizzato per valutare se i modelli linguistici hanno capacità di ragionamento simili all'intelligenza artificiale generale (AGI).

È progettato per testare il ragionamento astratto e le capacità di risoluzione dei problemi del sistema di intelligenza artificiale quando si trova ad affrontare nuovi problemi, simili alla capacità degli esseri umani di adattarsi rapidamente e trovare soluzioni quando si trovano ad affrontare nuove situazioni.

Gli ultimi risultati dei test sono i seguenti:

Come puoi vedere, o3-pro offre prestazioni leggermente migliori nelle attività difficili, ma il miglioramento non è significativo e il costo aumenta con la difficoltà.

L'impresa è la seconda curva, o3-pro è la nuova pietra angolare

In occasione del lancio di o3-pro, il CEO di OpenAI Sam Altman annunciò anche un'importante novità sulla piattaforma social: il prezzo del modello o3 scese dell'80%.

Attualmente, il modello o3 addebita 2 dollari per ogni milione di token in input e 8 dollari per ogni milione di token in output.

Kevin Weil, Chief Product Officer di OpenAI, ha scritto che, in seguito al forte feedback degli utenti, il limite di utilizzo del modello o3 per gli utenti Plus verrà raddoppiato e che tale adeguamento verrà implementato gradualmente.

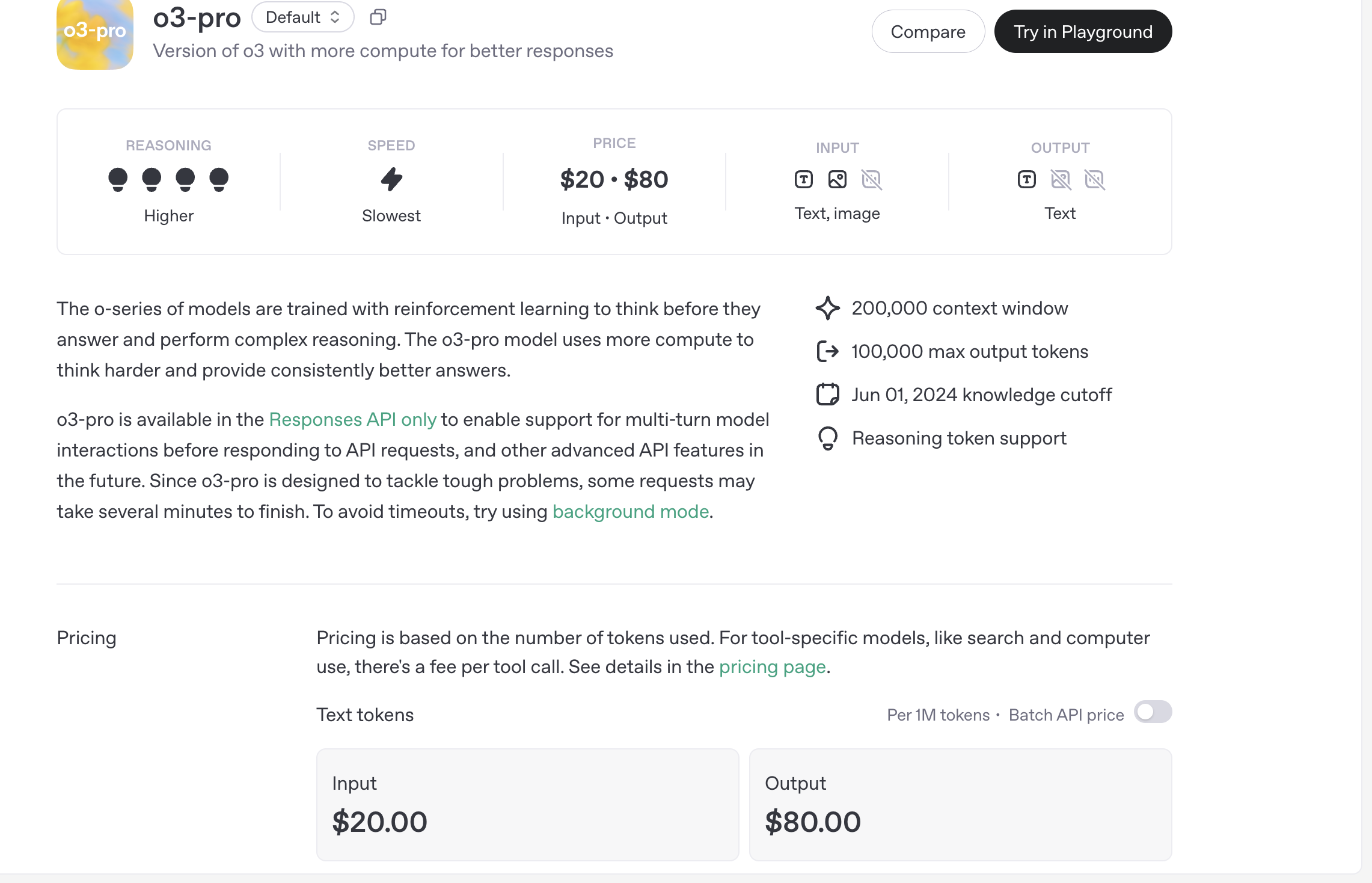

Al contrario, o3-pro addebita 20 $ per ogni milione di token in input e 80 $ per ogni milione di token in output, ovvero l'87% in meno rispetto a o1-pro.

OpenAI consiglia di abilitare la "modalità background" quando si utilizza o3-pro: le attività che richiedono molto tempo verranno avviate in modo asincrono per evitare problemi di timeout delle richieste.

I funzionari hanno affermato che il motivo di questo forte taglio di prezzo è l'ottimizzazione completa dell'architettura del servizio di inferenza da parte di OpenAI. Il modello non è cambiato, ma l'inferenza è diventata più efficiente, quindi il prezzo è stato adeguato di conseguenza.

D'altro canto, potrebbe essere inseparabile dai nuovi sviluppi di OpenAI nelle risorse informatiche.

Fin dal lancio di ChatGPT, la limitazione delle risorse di elaborazione è sempre stata un "problema difficile" per OpenAI. A causa delle restrizioni dell'accordo vincolante con Microsoft, il servizio cloud di Azure era l'unico fornitore di infrastrutture per data center per ChatGPT.

Secondo quanto riportato da Reuters nelle prime ore del mattino, citando tre fonti a conoscenza della questione, per alleviare la pressione informatica, il mese scorso OpenAI ha raggiunto un accordo di cooperazione con Alphabet (la società madre di Google) per introdurre Google Cloud come ulteriore fornitore di servizi cloud.

Una simile cooperazione è tanto inaspettata quanto ragionevole.

Da un lato, ChatGPT è una delle più grandi minacce per l'attività di ricerca di Google negli ultimi anni e Google Cloud è ora diventato il suo nuovo sostenitore.

D'altro canto, il fatturato di Google Cloud nel 2024 raggiungerà i 43 miliardi di dollari, pari al 12% del fatturato di Alphabet. Pertanto, per superare Amazon e Microsoft nel mercato del cloud computing, Google Cloud si è impegnata a svolgere il ruolo di "fornitore neutrale di potenza di calcolo".

La conclusione di questa collaborazione porterà grandi benefici a Google Cloud. Al momento della stesura di questo rapporto, OpenAI, Google e Microsoft non hanno rilasciato dichiarazioni in merito.

Allo stesso tempo, OpenAI sta accelerando l'implementazione di reti infrastrutturali di intelligenza artificiale in tutto il mondo.

All'inizio di quest'anno, OpenAI ha anche portato avanti il progetto Stargate da 500 miliardi di dollari con SoftBank e Oracle e ha firmato un accordo di fornitura di potenza di calcolo multimiliardario con CoreWeave.

Investimenti elevati si basano su rendimenti elevati. Secondo quanto riportato dai media stranieri questa settimana, l'anno scorso il tasso di rendimento annuo di OpenAI era di circa 5,5 miliardi di dollari, e ora ha superato i 10 miliardi di dollari, con un aumento di quasi l'80%.

È importante notare che i 10 miliardi di dollari includono solo i prodotti consumer, i prodotti a pagamento ChatGPT e i ricavi derivanti dalle API, escludendo i ricavi da licenze Microsoft e altre transazioni di grandi dimensioni. In ambito aziendale, l'ARR si riferisce al fatturato annuo ricorrente che un'azienda ricava da servizi in abbonamento o contratti a lungo termine. Riflette un flusso di entrate prevedibile e continuo e viene spesso utilizzato per misurare lo stato di salute e il potenziale di crescita delle aziende con modelli di abbonamento.

In parole povere, un'azienda che fornisce software come servizio (SaaS) ha un contratto di abbonamento con un cliente che paga 1.000 yuan all'anno. Se ci sono 100 clienti di questo tipo, il tasso di ricavo annuo (ARR) dell'azienda è 1.000 yuan × 100 = 100.000 yuan.

La scorsa settimana, il COO di OpenAI, Brad Lightcap, ha anche rivelato che OpenAI ha attualmente 3 milioni di utenti commerciali paganti, in aumento rispetto ai 2 milioni registrati a febbraio. Si può affermare che OpenAI si trovi attualmente in un'ottima situazione.

Riducendo i costi dei modelli base tramite o3 e migliorando la capacità di risolvere problemi complessi con o3-pro, OpenAI punta a scenari di alto valore e cerca di aprire una strada tra i due estremi della prossima curva di crescita: i servizi aziendali.

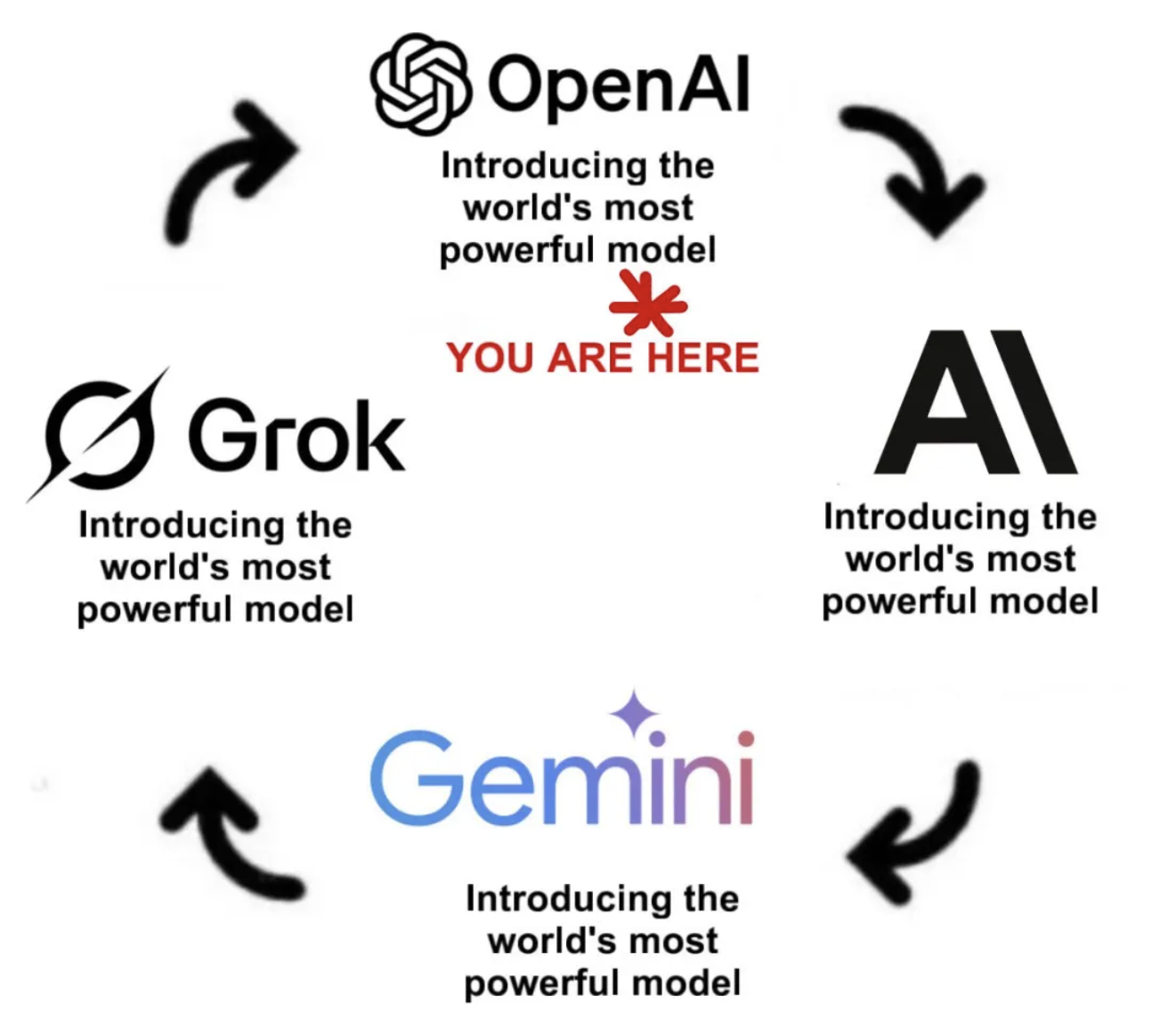

I modelli più potenti al mondo vengono rilasciati uno dopo l'altro e OpenAI è uno di questi in questa ondata di intelligenza artificiale.

Grazie a modelli più potenti, una potenza di calcolo più stabile e chiamate di strumenti più numerose, ChatGPT non è più solo un chatbot, ma un partner di produttività progettato per gestire lo scenario applicativo più produttivo: il posto di lavoro.

o3-pro è una nuova pietra miliare su questa strada.

Resta da verificare se possa supportare l'ambizione di OpenAI. Ma almeno ora ha spinto le persone a reinventarsi.

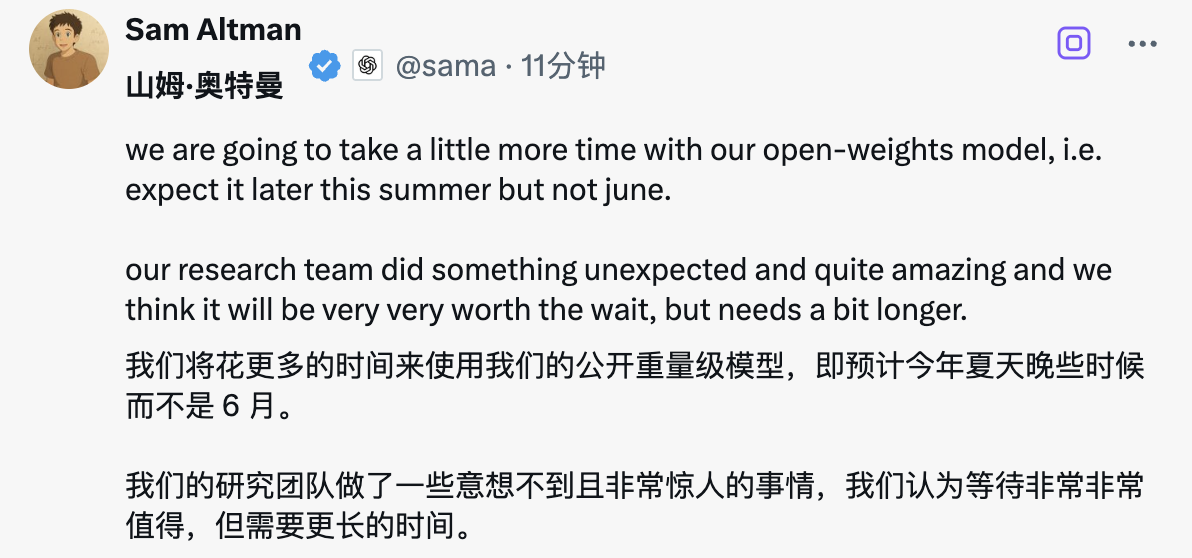

Il modello sarà open source, ma non a giugno

Proprio ora, Sam Altman ha affermato sui social media che OpenAI prevede di rilasciare un modello open source con pesi pubblici entro la fine dell'estate, anziché a giugno.

Inoltre, Altman ha appena lanciato il suo nuovo blog personale, The Gentle Singularity, che esplora l'impatto dello sviluppo dell'intelligenza artificiale sulla società umana e sottolinea che questo potrebbe essere l'ultimo articolo che scriverà senza l'ausilio dell'intelligenza artificiale.

Secondo lui, dal punto di vista della relatività, le singolarità si verificano poco a poco, mentre la fusione procede lentamente.

In allegato l'indirizzo del blog originale: https://blog.samaltman.com/the-gentle-singularity

Singolarità gentile

Abbiamo oltrepassato l'orizzonte degli eventi, il decollo è iniziato, l'umanità è vicina a costruire una superintelligenza digitale e, almeno finora, non è così strano come sembra.

I robot non sono ancora onnipresenti per le strade e la maggior parte delle persone non interagisce con l'intelligenza artificiale tutto il giorno. Si muore ancora di malattie, viaggiare nello spazio è ancora difficile e la nostra comprensione dell'universo è ancora molto limitata.

Ciononostante, abbiamo recentemente costruito sistemi che sono più intelligenti degli esseri umani sotto molti aspetti e che possono amplificare significativamente la produttività umana. Le parti più improbabili sono già state raggiunte: le scoperte scientifiche che hanno reso possibili sistemi come GPT-4 e o3 sono state conquistate a fatica, ma ci porteranno molto più lontano.

L'intelligenza artificiale contribuirà al mondo in molti modi, ma i miglioramenti nella qualità della vita che l'intelligenza artificiale apporterà accelerando il progresso scientifico e aumentando la produttività saranno enormi; il futuro promette di essere di gran lunga migliore del presente. Il progresso scientifico è il principale motore del progresso complessivo; è entusiasmante pensare a quanto ancora abbiamo il potenziale per raggiungere.

In un certo senso, ChatGPT è già più potente di chiunque altro nella storia. Centinaia di milioni di persone vi fanno affidamento ogni giorno e le attività che svolge stanno diventando sempre più importanti; una piccola funzionalità aggiuntiva può avere un enorme impatto positivo, mentre una piccola discrepanza può anche causare un enorme impatto negativo se utilizzata da centinaia di milioni di persone.

Nel 2025 vedremo agenti intelligenti in grado di svolgere un vero lavoro cognitivo; il modo in cui scriviamo il codice informatico sarà rivoluzionato. Nel 2026, probabilmente vedremo sistemi in grado di generare intuizioni originali. Nel 2027, forse robot in grado di svolgere compiti nel mondo reale.

Più persone saranno in grado di creare software e arte. Ma la domanda mondiale di entrambi aumenterà drasticamente. Gli esperti che adotteranno questi nuovi strumenti saranno probabilmente ancora molto più abili dei principianti. Nel complesso, una persona realizzerà molto di più nel 2030 rispetto al 2020, e il cambiamento sarà radicale, e molte persone impareranno a trarne vantaggio.

Per quanto riguarda gli aspetti più importanti, gli anni '30 potrebbero non rappresentare un cambiamento radicale. Le persone continueranno ad amare le loro famiglie, a dare libero sfogo alla loro creatività, a giocare e a nuotare nei laghi.

Ma per altri aspetti che continueranno a essere importanti, è probabile che gli anni '30 saranno molto diversi da qualsiasi epoca precedente. Non conosciamo i limiti massimi dell'intelligenza umana, ma stiamo per scoprirlo.

Entro il 2030, intelligenza ed energia – idee e capacità di realizzarle – diventeranno estremamente abbondanti. Questi due elementi sono stati a lungo i limiti fondamentali del progresso umano; se intelligenza ed energia fossero abbondanti (oltre a una buona governance), potremmo teoricamente realizzare qualsiasi cosa.

Viviamo ormai in un'intelligenza digitale straordinaria e, dopo lo shock iniziale, la maggior parte delle persone si è abituata. Presto passeremo dall'ammirare la capacità dell'IA di scrivere splendidi paragrafi all'aspettarci che scriva interi romanzi; dall'essere meravigliati dalla sua capacità di diagnosticare malattie all'aspettarci che sviluppi cure; dall'essere meravigliati dalla sua capacità di scrivere piccoli programmi alla speranza che possa creare intere aziende. Questa è la via della Singolarità: i miracoli diventano routine, e poi diventano il punto di partenza.

Gli scienziati ci hanno detto che stanno lavorando in modo da due a tre volte più efficiente rispetto a prima. Uno dei motivi principali per cui l'intelligenza artificiale avanzata è così importante è che possiamo usarla per accelerare la ricerca stessa sull'intelligenza artificiale. Potremmo essere in grado di scoprire nuovi materiali di calcolo, algoritmi migliori e persino possibilità ancora più inesplorate. Se riuscissimo a completare dieci anni di ricerca in un anno o anche solo in un mese, la velocità del progresso sarebbe ovviamente molto diversa.

D'ora in poi, gli strumenti a nostra disposizione ci aiuteranno a scoprire ulteriori spunti scientifici e a creare sistemi di intelligenza artificiale più avanzati. Naturalmente, non si tratta ancora di un'intelligenza artificiale che aggiorna completamente il proprio codice in modo autonomo, ma è sicuramente la forma iniziale di "auto-miglioramento ricorsivo".

Ci sono altri cicli che si autoalimentano. Il valore economico dell'IA è il volano della costruzione delle infrastrutture e sempre più risorse vengono utilizzate per far funzionare questi potenti sistemi di IA. E robot in grado di costruire altri robot (e, in un certo senso, data center in grado di costruire altri data center) non sono lontani.

Se dovessimo costruire il primo milione di robot umanoidi nel modo tradizionale, ma questi potessero poi assumere il controllo dell'intera catena di fornitura (estrazione e raffinazione dei minerali, guida di camion, gestione di fabbriche e così via) e costruire altri robot, fabbriche di chip e centri dati, il ritmo del progresso sarebbe molto diverso.

Con la crescente automazione della produzione nei data center, il costo dell'intelligence dovrebbe alla fine avvicinarsi al costo dell'elettricità. (Molte persone sono preoccupate per quanta energia ChatGPT consuma per query; una query media consuma circa 0,34 wattora, più o meno quanto far funzionare un forno per poco più di un secondo o accendere una lampadina a basso consumo per pochi minuti. Inoltre, ogni query consuma circa 0,000085 galloni d'acqua, ovvero circa un quindicesimo di cucchiaino.)

Il ritmo del progresso tecnologico continuerà ad accelerare e gli esseri umani sono altamente adattabili. Se da un lato ci saranno sfide difficili, come la scomparsa di intere categorie di posti di lavoro, dall'altro la ricchezza mondiale crescerà così rapidamente che avremo l'opportunità di considerare seriamente nuove politiche prima impraticabili. Potremmo non stabilire un nuovo contratto sociale tutto in una volta, ma guarderemo indietro decenni dopo e constateremo che l'accumulo di cambiamenti graduali ha portato a un'enorme trasformazione.

Se la storia ci insegna qualcosa, troveremo sempre nuove cose da fare, nuovi desideri da perseguire e ci adatteremo rapidamente a nuovi strumenti (i cambiamenti occupazionali successivi alla Rivoluzione Industriale ne sono un buon esempio). Le aspettative delle persone aumenteranno, ma anche le loro capacità cresceranno rapidamente e avremo vite migliori. Creeremo cose sempre più meravigliose gli uni per gli altri. Gli esseri umani hanno un vantaggio importante e a lungo termine rispetto all'intelligenza artificiale: ci preoccupiamo naturalmente degli altri e di come pensano e agiscono, mentre non proviamo alcun sentimento per le macchine.

Se un contadino di sussistenza mille anni fa avesse visto come viviamo oggi, avrebbe pensato che stessimo facendo "lavori falsi", come se ci stessimo divertendo solo perché avevamo cibo in abbondanza e un lusso inimmaginabile. Spero che tra mille anni considereremo quei lavori con la stessa luce: come "molto falsi", ma senza dubbio quelle persone considereranno il loro lavoro estremamente importante e appagante.

Ci saranno molti nuovi miracoli in futuro. È difficile immaginare quali innovazioni realizzeremo entro il 2035. Potremmo risolvere problemi di fisica delle alte energie quest'anno e colonizzare lo spazio l'anno prossimo. Oppure potremmo fare una svolta fondamentale nella scienza dei materiali quest'anno e realizzare un'interfaccia cervello-computer ad altissima larghezza di banda l'anno prossimo. Molte persone sceglieranno di continuare a vivere come fanno ora, ma ci saranno sicuramente persone che sceglieranno di "connettersi al sistema".

Guardando al futuro, queste cose possono sembrare inimmaginabili ora. Ma quando le si sperimentano davvero, possono essere sorprendenti, pur rimanendo sotto controllo. Dal punto di vista della relatività, la singolarità avviene a poco a poco e la convergenza è graduale. Stiamo scalando quel lungo arco di crescita esponenziale della tecnologia; sembra sempre una ripida salita verticale quando si guarda avanti, e sembra una linea piatta quando si guarda indietro, ma in realtà è una curva regolare. (Guardando indietro al 2020, se avessimo detto allora che saremmo stati vicini all'AGI nel 2025, sarebbe sembrato folle, ma rispetto a tutto ciò che è successo negli ultimi cinque anni, forse la previsione di oggi non è poi così folle.)

Naturalmente, ci troviamo ancora di fronte a molte sfide importanti. Dobbiamo risolvere problemi di sicurezza a livello tecnico e sociale, ma poi la cosa più importante è garantire che la superintelligenza possa essere ampiamente accessibile, perché è legata alla struttura economica. Il percorso migliore da seguire potrebbe includere i seguenti passaggi:

Innanzitutto, dobbiamo risolvere il "problema di allineamento", ovvero possiamo garantire che il sistema di intelligenza artificiale possa apprendere e realizzare i nostri veri desideri collettivi a lungo termine (i social media sono un esempio di fallimento dell'allineamento: gli algoritmi di raccomandazione sono molto bravi a farti continuare a scorrere, ma lo fanno sfruttando le preferenze a breve termine del cervello per sopprimere i tuoi obiettivi a lungo termine).

Successivamente, concentratevi sul rendere la superintelligenza economica, onnipresente e lontana dal controllo centralizzato di un singolo individuo, azienda o paese. La società è resiliente, creativa e in grado di adattarsi rapidamente. Se riusciamo a liberare la volontà e la saggezza collettive, impareremo e ci adatteremo rapidamente, nonostante errori e interruzioni, per massimizzare i benefici e minimizzare i rischi. Dare agli utenti maggiore libertà all'interno degli ampi quadri stabiliti dalla società sarà fondamentale. Prima il mondo avvierà una discussione su questi quadri e su come definire "allineamento collettivo", meglio sarà.

Noi (l'intero settore, non solo OpenAI) stiamo costruendo un "cervello" per il mondo. Questo cervello sarà altamente personalizzato e facile da usare per tutti; i suoi limiti saranno determinati dalle nostre buone idee. Per molto tempo, la comunità tecnologica ha sempre deriso queste "persone con le idee", ovvero coloro che hanno un'idea ma non riescono a realizzarla. Ora, sembra che il loro momento sia finalmente arrivato.

OpenAI è tante cose oggi, ma fondamentalmente è ancora un'azienda di ricerca sulla superintelligenza. Abbiamo ancora molto lavoro da fare, ma la strada è illuminata e l'oscurità si sta rapidamente diradando. Siamo incredibilmente grati di poterlo fare.

"Gli smartphone sono quasi gratis" è ormai alle porte. Può sembrare folle, ma se nel 2020 vi avessimo detto che ci saremmo arrivati nel 2025, sarebbe stato più folle che se avessimo previsto il 2030 ora.

Che possiamo entrare senza intoppi, esponenzialmente e costantemente nell'era della superintelligenza.

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFanr: iFanr (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.