Dialogo con Jiang Daxin, fondatore di Step Star: i modelli multimodali non hanno ancora raggiunto il momento GPT-4 e insistiamo nel perseguire il “limite superiore dell’intelligenza”

Se l’intelligenza artificiale riuscirà a raggiungere il secondo tempo può essere discutibile, ma è certo che i grandi modelli riusciranno ad arrivare alla fase a eliminazione diretta.

Dopo l’avvento di DeepSeek R1, la tendenza si è intensificata. Solo quest'anno OpenAI, Anthropic, Google, Meta e Grok hanno rilasciato almeno 8 nuovi modelli. Anche alcune tigri domestiche dell’IA hanno iniziato a rinunciare al pre-addestramento e hanno accantonato l’idealismo dell’AGI.

Tra questi, Step Star è un'azienda un po' speciale. Si parlava poco di finanziamenti prima della fine dello scorso anno, ma è diventato il "Re dei volumi" nei modelli multimodali. Ha rilasciato 22 modelli base auto-sviluppati nei suoi 2 anni di esistenza, diventando l'unicorno AI più discreto e misterioso.

Jiang Daxin, fondatore e CEO di Step Star, è di basso profilo come l'azienda e raramente appare nel vivace campo dell'opinione pubblica del settore dell'intelligenza artificiale.

Ieri Jiang Daxin ha tenuto un incontro di comunicazione approfondito con l'APPSO e altri media. Ha condiviso con noi le sue opinioni sui percorsi AGI, sui modelli multimodali e su altre tecnologie, nonché sui piani futuri di Step Star.

I modelli multimodali non sono ancora apparsi in GPT-4, perseguendo il "limite superiore dell'intelligenza"

L’attuale involuzione nel campo dei grandi modelli di intelligenza artificiale non ha fine e tra le aziende leader vengono costantemente inscenate feroci drammi di “rilasci ravvicinati”.

Tuttavia, Jiang Daxin crede ancora che " il perseguimento del limite superiore dell'intelligenza sia ancora al centro dell'attenzione dell'industria dell'intelligenza artificiale in questa fase". In altre parole, anche se ci sono molti modelli sul mercato ora, e sembrano tutti abbastanza capaci, sono ancora lontani dall'essere veramente "intelligenti".

Tutti si stanno affrettando a rilasciare nuovi modelli, e sembra vivace, ma se si armeggia solo con il livello attuale, sarà solo "involuzione" dello stare fermi.

Jiang Daxin ritiene che la cosa più importante ora sia trovare un modo per aumentare il "QI" dell'intelligenza artificiale, altrimenti sarà ancora lontana dall'AGI (intelligenza artificiale) a cui tutti pensano.

Dopo il lancio di DeepSeek R1 e l’ingresso di importanti produttori di alto profilo, molte start-up hanno iniziato ad abbandonare lo sviluppo di modelli base. Tuttavia, Jiang Daxin ha detto in un'intervista con APPSO:

La tecnologia nel settore dell’intelligenza artificiale si sta sviluppando molto rapidamente e si trova ancora in un intervallo molto ripido. Non vogliamo rinunciare alla crescita principale o alla tendenza futura in questo processo, quindi continueremo a concentrarci sulla ricerca e sullo sviluppo di modelli di base.

Allo stesso tempo, Jiang Daxin ha affermato che applicazioni e modelli si completano a vicenda. Il modello può determinare il limite superiore dell'applicazione e l'applicazione fornisce al modello scenari e dati applicativi specifici.

Quindi, come possiamo rendere l’intelligenza artificiale più intelligente? Un percorso chiave indicato da Jiang Daxin è: " La multimodalità è l'unico modo per raggiungere l'AGI".

Molte persone dicono che quest'anno è il primo anno di Agent. Jiang Daxin ritiene che l'epidemia dell'Agente richieda due condizioni necessarie, una è l'abilità multimodale e l'altra è la capacità di pensare lentamente .

La multimodalità, per dirla senza mezzi termini, significa che l’intelligenza artificiale non solo può comprendere il testo, ma anche vedere immagini, ascoltare suoni e comprendere video.

Se ci pensi, le persone hanno bisogno solo degli occhi, delle orecchie, della bocca e del naso per comprendere appieno il mondo. Anche l’intelligenza artificiale deve essere così, diventare un “tuttofare” in grado di ascoltare, vedere e parlare.

Step Star può essere definito il "re dei volumi" dei modelli multimodali. Quasi ogni mese rilascia un modello base di grandi dimensioni, inclusi 16 modelli multimodali. Copre la comprensione e la generazione di immagini, video, parlato e musica. Nelle parole di Jiang Daxin, aderisce al “concetto multimodale nativo”.

Tuttavia, Jiang Daxin è anche abbastanza onesto. Ha affermato francamente che " non c'è ancora stato un momento GPT-4 nel campo dei modelli multimodali. "

Sebbene la multimodalità sia ormai molto popolare e tutti la promuovano, non esiste ancora un prodotto di riferimento come GPT-4 nel campo dei testi. Quando uscirà, dirà "Wow" e farà pensare a tutti "Questo è tutto". Tecnicamente ci sono ancora molti ossi duri da rosicchiare.

Trilogia di combattimento di mostri migliorata dall'IA

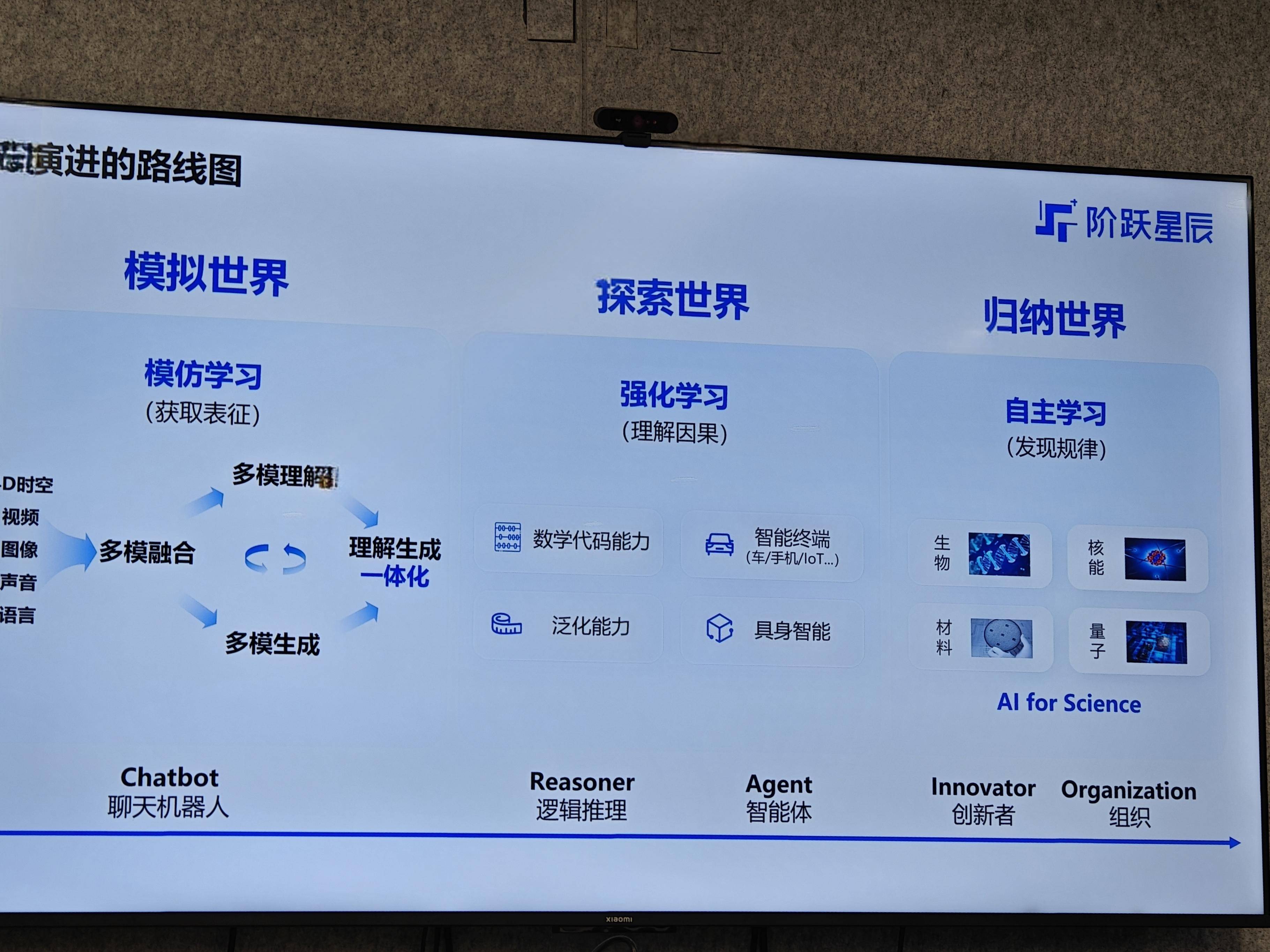

Per quanto riguarda il modo in cui il modello si avvicina passo dopo passo al limite superiore dell'intelligenza, Jiang Daxin ha tracciato una chiara tabella di marcia evolutiva della "trilogia". Si può anche dire che questa è la direzione evolutiva dell'AGI compresa da Step Star.

Mondo simulato (fase di apprendimento per imitazione) : l'IA in questa fase è come un bambino che ha appena imparato a parlare. Dategli una grande quantità di dati e imparerà. Il compito principale è "prevedere il token successivo" (prevedere la parola successiva) o "prevedere il fotogramma successivo" (prevedere il fotogramma successivo). Lo scopo è lasciare che l’IA impari prima come appare il mondo e quali caratteristiche hanno le varie cose.

Esplorare il mondo (fase di apprendimento rinforzato) : saper imitare non basta, è necessario sviluppare anche la capacità di risolvere problemi complessi. Ad esempio, risolvere un problema delle Olimpiadi di matematica o scrivere un codice complesso richiede un "pensiero lento". In questo momento è necessario l’apprendimento per rinforzo, in modo che l’IA possa imparare come risolvere il problema passo dopo passo attraverso continui tentativi ed errori.

Mondo induttivo (fase di apprendimento autonomo della macchina) : questo è lo stato più elevato. L’intelligenza artificiale non solo può risolvere problemi noti, ma anche scoprire da sola nuove leggi e creare innovazioni a cui gli esseri umani non hanno mai pensato. Ad esempio, nel campo della ricerca scientifica, aiutiamo gli scienziati a scoprire nuovi materiali, nuovi farmaci e così via.

Queste tre fasi coincidono con i concetti fondamentali dei cinque livelli AGI proposti da OpenAI. L’attuale sviluppo dell’intero settore dell’intelligenza artificiale procede sostanzialmente secondo questo copione.

Perché è così importante "comprendere l'integrazione delle generazioni"?

In termini di multimodalità, in particolare di immagini e video, Jiang Daxin ha sottolineato più volte una parola durante l'incontro di comunicazione: l'integrazione di comprensione e generazione.

Comprendere l’integrazione generativa è una questione fondamentale nel campo della visione artificiale ed è cruciale per realizzare l’AGI.

Per dirla senza mezzi termini, significa che il modello non solo può capire cosa significa un'immagine o un video, ma anche creare immagini e video nuovi e pertinenti basati su questa comprensione. Al giorno d'oggi, molte volte si tratta di "utilizzare il modello A per vedere le immagini e utilizzare il modello B per disegnare immagini", che è come due dipartimenti che non possono collaborare.

Ha fatto un esempio, come quello di un insegnante che scrive alla lavagna. Ora Sora può imitare i movimenti di scrittura dell'insegnante, ma ciò a cui l'insegnante sta pensando e ciò che scriverà dopo dipende dalla "comprensione". Se comprensione e generazione sono due sistemi, allora sarà difficile per il modello "capirti" veramente e anche il materiale generato potrebbe essere irrilevante.

Modelli linguistici come ChatGPT hanno fatto un buon lavoro in questo senso, ma in campo visivo i dati sono troppo complessi, quindi la questione non è stata ancora del tutto risolta. Step Star ha continuato a investire in questo e vuole superare questo collo di bottiglia tecnico.

Alla fine è necessario applicare potenti capacità del modello per incorporare valore. Step Star adotta la strategia del "super modello e super applicazione a due ruote motrici".

A livello applicativo, Step Star considera l'"agente terminale intelligente" come la sua direzione di sviluppo chiave. Jiang Daxin ritiene che i terminali intelligenti, siano essi telefoni cellulari nelle nostre tasche, automobili che guidiamo quotidianamente o robot che potrebbero essere popolari in futuro, non sono solo hardware freddo, ma anche "un'estensione della percezione e dell'esperienza dell'utente".

Ciò significa che se l’intelligenza artificiale può essere profondamente integrata con questi terminali, può “comprendere meglio le esigenze degli utenti e il contesto delle attività”.

Ad esempio, il fiore all'occhiello di OPPO Find X8 Ultra ha lanciato ufficialmente la sua prima funzione "memoria flash con un clic". L'intelligenza artificiale può identificare in modo intelligente il contenuto sullo schermo del telefono, generare riepiloghi per gli utenti e classificare informazioni frammentate in diverse raccolte di memoria.

Dietro questo c'è in realtà il modello multimodale Step Star, che può comprendere il contenuto visualizzato sullo schermo, sia che si tratti di immagini o testo, e gli utenti possono porre domande al riguardo. L’intelligenza artificiale non solo può rispondere, ma anche eseguire l’elaborazione delle immagini e persino aiutare gli utenti a completare alcune operazioni in-app, come passare direttamente alla pagina di prenotazione del volo e inserire le informazioni.

Questo tipo di cooperazione integra più profondamente le capacità di modelli e sistemi di grandi dimensioni e li incorpora negli scenari di utilizzo del telefono cellulare più frequenti da parte degli utenti. Il valore della scelta dei telefoni cellulari come punto di ingresso risiede nelle naturali proprietà di interazione multimodale dei telefoni cellulari e nell'enorme base di utenti, che fornisce ricchi dati reali e feedback istantaneo per l'iterazione del modello.

In generale, l'idea di Step Star è abbastanza chiara: mirare tecnicamente all'AGI e concentrarsi su questioni fondamentali come la multimodalità e l'integrazione di comprensione e generazione. In termini di applicazione, dobbiamo identificare il punto di svolta dei terminali intelligenti e collaborare con i produttori di hardware per comprendere a fondo lo scenario.

Questa strada non è facile da percorrere, ma Jiang Daxin e la sua squadra sembrano piuttosto determinati. Dopotutto, per utilizzare l’intelligenza artificiale per risolvere i problemi del mondo reale, è necessario prima ottenere il riconoscimento degli utenti sul mercato prima di avere l’opportunità di esplorare il limite dell’AGI. Vediamo quali novità può inventare il re multimodale di Step Stars.

# Benvenuti a seguire l'account pubblico WeChat ufficiale di Aifaner: Aifaner (ID WeChat: ifanr). Contenuti più interessanti ti verranno forniti il prima possibile.

Ai Faner | Link originale · Visualizza commenti · Sina Weibo