La capitalizzazione di mercato di Nvidia punta a raggiungere i cinque trilioni, con Blackwell in testa e Rubin che segue a ruota; l’infrastruttura di intelligenza artificiale è pronta per una crescita esponenziale della domanda.

Il dio della guerra vestito di pelle è tornato per "imbucarsi" di nuovo alla festa! All'evento autunnale del GTC 2025, appena conclusosi ieri, il discorso di Jensen Huang ha consolidato ancora una volta la posizione di Nvidia come produttore di chip numero uno. L'intera presentazione è stata una vera e propria raffica di attacchi.

La solidità e la comprovata esperienza del leader del settore dei chip sono verificabili.

NVIDIA ha fornito segnali di fatturato estremamente positivi alla conferenza, consolidando ulteriormente la sua posizione di leadership assoluta nel campo dell'intelligenza artificiale a livello globale. Tra questi, la piattaforma Blackwell è stata senza dubbio il fulcro assoluto di questo GTC, con la sua velocità di implementazione su larga scala senza precedenti.

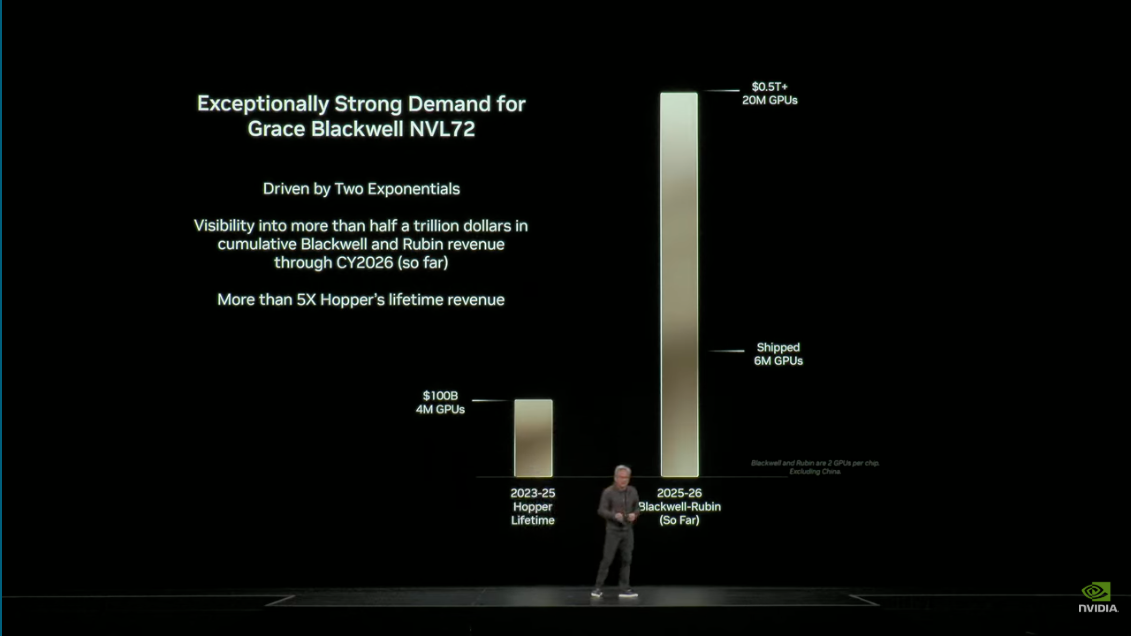

Jensen Huang ha rivelato che si prevede che la piattaforma Blackwell spedirà fino a 6 milioni di unità di elaborazione entro soli cinque trimestri dall'inizio della produzione, un tasso di crescita cinque volte superiore a quello della piattaforma Hopper di generazione precedente, segnando l'ingresso dell'implementazione dell'infrastruttura di intelligenza artificiale globale in un periodo di crescita ad altissima velocità.

Questo sorprendente volume di spedizioni riflette pienamente l'urgente necessità del mercato di elevate prestazioni ed efficienza energetica dell'architettura Blackwell, in particolare nell'addestramento di modelli da trilioni di parametri e applicazioni di inferenza su larga scala.

Secondo la dimostrazione, la piattaforma Blackwell ha raggiunto una velocità nove volte superiore rispetto a Hopper nell'esecuzione di modelli di inferenza. Questo balzo in avanti in termini di prestazioni riduce significativamente i tempi di risposta dei modelli linguistici di grandi dimensioni (LLM), migliorando notevolmente l'esperienza utente e liberando risorse di elaborazione.

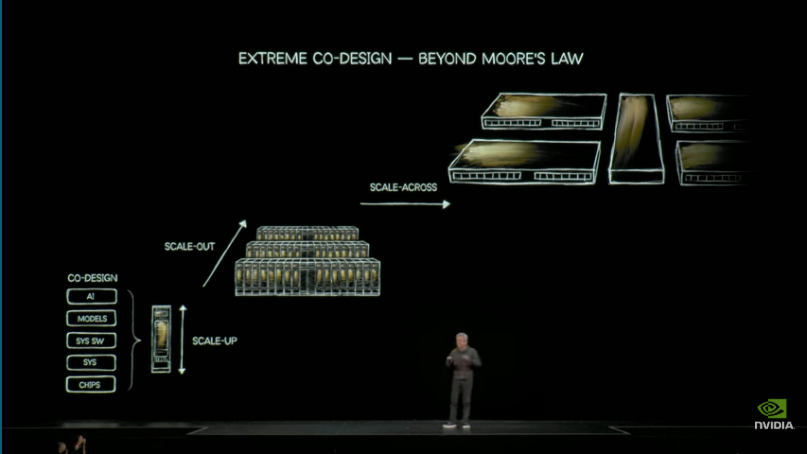

Per quanto riguarda i costi operativi delle applicazioni di intelligenza artificiale su larga scala, NVIDIA promette di ridurre significativamente i costi di generazione dei token di intelligenza artificiale attraverso un "co-design estremo", affrontando un punto critico operativo fondamentale nelle fabbriche di intelligenza artificiale. Attualmente, Grace Blackwell NVLink 72 vanta il costo di generazione dei token più basso a livello globale, offrendo un miglioramento delle prestazioni di 10 volte a fronte di una riduzione dei costi di 10 volte.

Sulla base dell'implementazione iniziale accelerata della piattaforma Blackwell e del suo successore, Rubin (piattaforma super chip Vera Rubin), Nvidia prevede che il fatturato combinato di queste due nuove piattaforme raggiungerà i 500 miliardi di dollari entro il 2026.

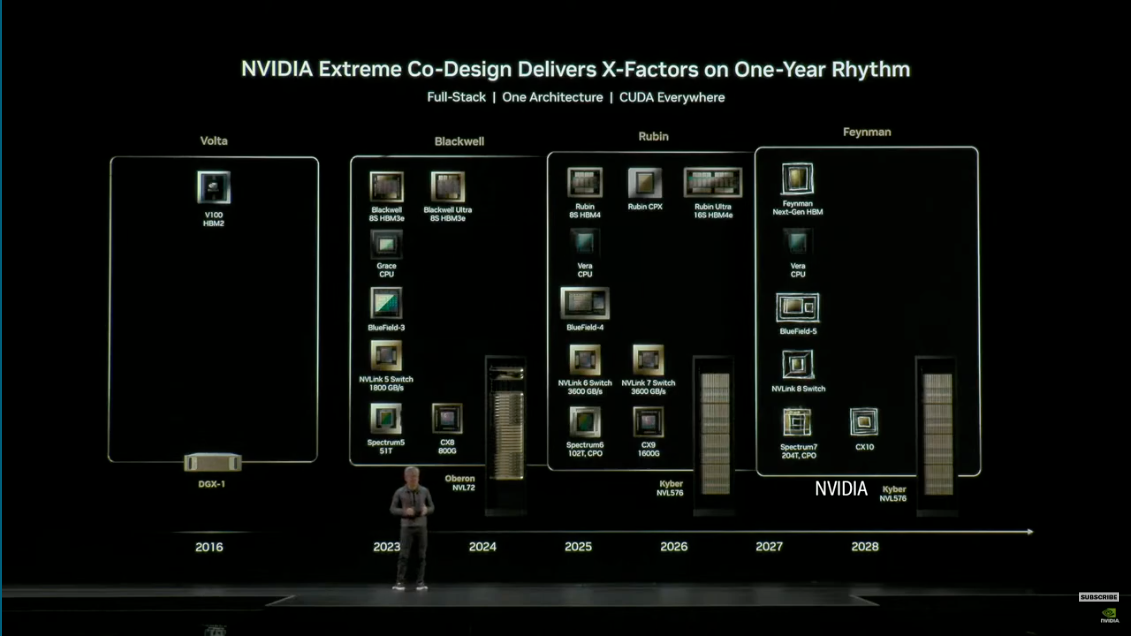

Obiettivi finanziari così ambiziosi sono supportati dalla strategia di aggiornamento annuale di NVIDIA per l'infrastruttura di intelligenza artificiale, che prevede il lancio di piattaforme di elaborazione al ritmo di una generazione all'anno per soddisfare la domanda del settore di formazione e inferenza di modelli di intelligenza artificiale su larga scala e con prestazioni più elevate.

Jensen Huang ha sottolineato che questa cifra di 500 miliardi di dollari non rappresenta solo le vendite di unità chip, ma riflette anche la trasformazione accelerata dell'infrastruttura informatica globale verso il modello di elaborazione accelerata di Nvidia, segnando l'arrivo di un punto di svolta informatico da mille miliardi di dollari.

Il futuro panorama informatico dei superchip

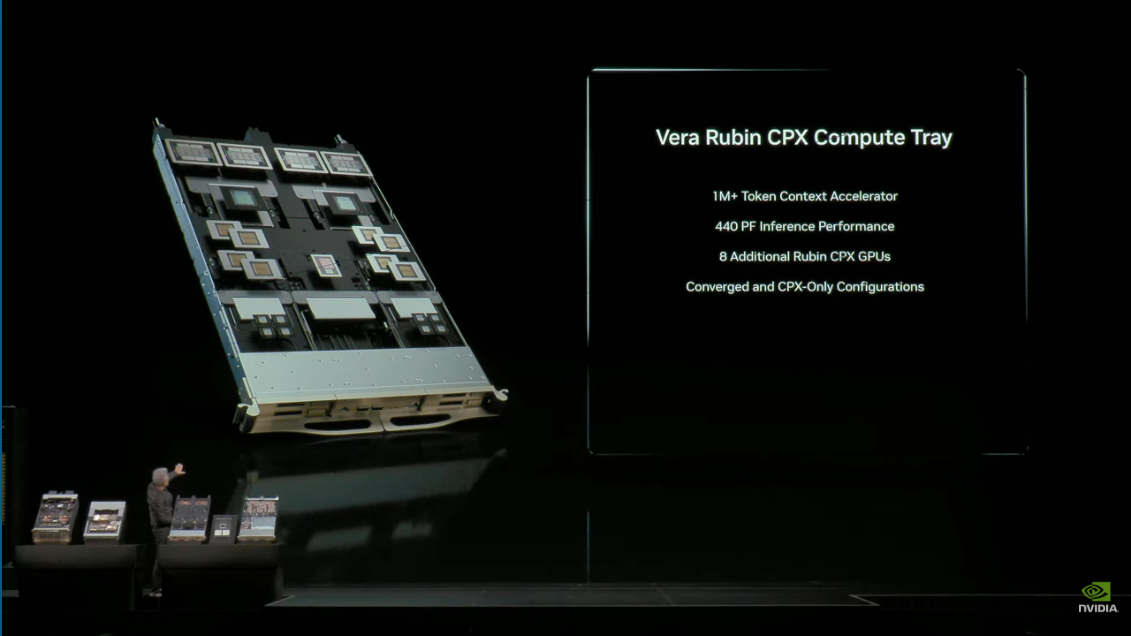

Da un lato, la piattaforma Blackwell sta guidando l'onda dell'intelligenza artificiale; dall'altro, Nvidia ha puntato a un futuro più lontano: il superchip Vera Rubin di prossima generazione è incluso nel suo portafoglio strategico.

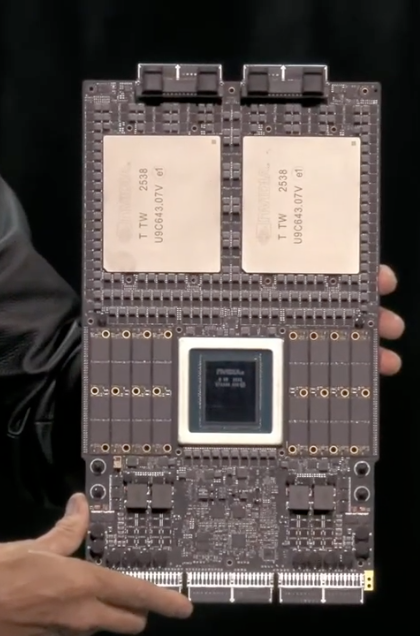

Il superchip Vera Rubin prosegue il concetto di progettazione dei superchip che prevede l'integrazione di CPU e GPU, con Vera che funge da CPU personalizzata e Rubin che funge da GPU di nuova generazione.

I dettagli tecnici rivelano che Vera Rubin offrirà un notevole balzo in avanti in termini di prestazioni: rispetto alla piattaforma Grace, i componenti Vera offriranno una capacità di memoria 4,2 volte maggiore e una larghezza di banda di memoria 2,4 volte maggiore.

Ospiterà 6 trilioni di transistor, offrendo fino a 100 petaflop (PF) di prestazioni di elaborazione AI, e sarà dotato di 2 TB di cache/memoria veloce. Queste specifiche chiave indicano che Vera Rubin raggiungerà un'efficienza e velocità ineguagliate dalla generazione Blackwell nell'elaborazione di modelli con trilioni di parametri e attività di inferenza AI su larga scala.

In qualità di successori di Blackwell, Vera Rubin e Blackwell insieme rappresenteranno un fatturato di Nvidia pari a circa 500 miliardi di dollari, a simboleggiare la continua iterazione e gli investimenti dell'azienda nelle future architetture informatiche.

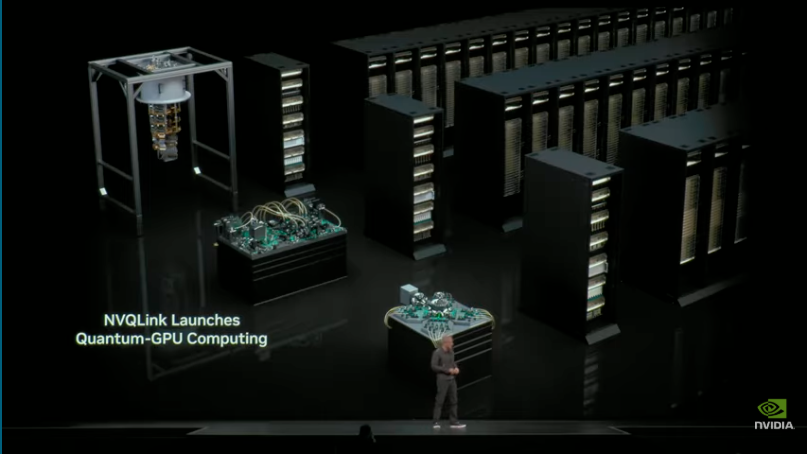

Nell'ambito di questa ambiziosa strategia di elaborazione, NVIDIA ha anche annunciato due importanti collaborazioni. In primo luogo, ha lanciato l'architettura di interconnessione NVQ Link, progettata per la simulazione ibrida ad alta velocità tra processori quantistici (QPU) e supercomputer GPU NVIDIA, raggiungendo una latenza computazionale nell'ordine dei microsecondi.

La tecnologia ha ottenuto il supporto di 17 aziende di informatica quantistica e di otto laboratori nazionali del Dipartimento dell'Energia degli Stati Uniti (DOE), segnando una profonda integrazione tra informatica quantistica e informatica AI classica.

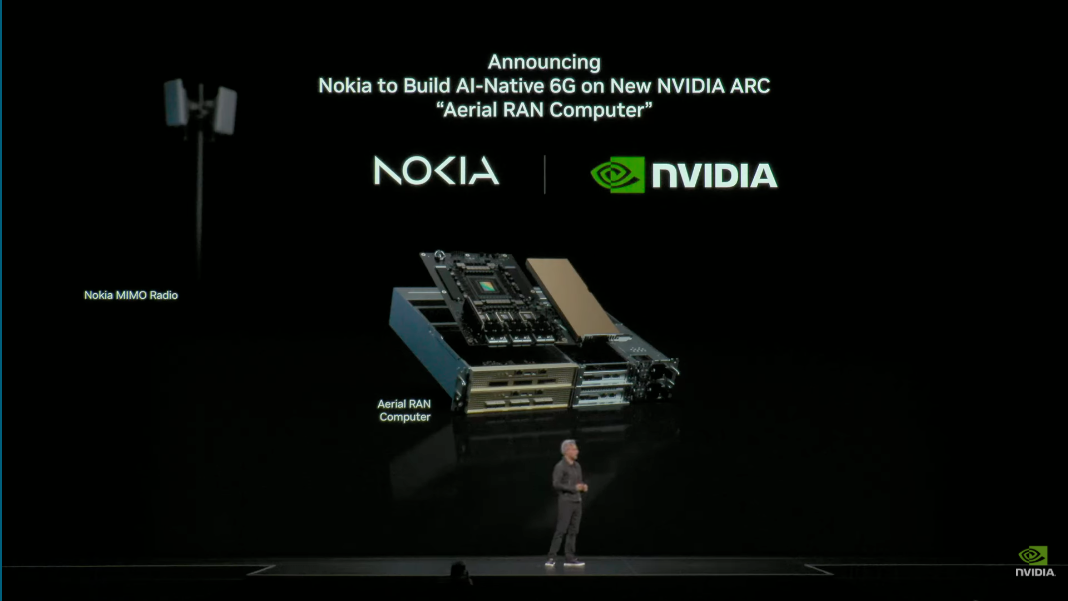

Il 6G sta arrivando? Rilancerà l'immagine di Nokia?

Un'altra importante collaborazione avviene nel settore delle infrastrutture di comunicazione: Nvidia ha annunciato una partnership strategica approfondita con il colosso delle telecomunicazioni Nokia per sviluppare congiuntamente la tecnologia 6G di prossima generazione.

In futuro, Nokia utilizzerà la piattaforma ARC di NVIDIA come nucleo delle sue stazioni base. Questa piattaforma è compatibile con le attuali stazioni base AirScale di Nokia, il che significa che milioni di stazioni base in tutto il mondo potranno essere aggiornate alle funzionalità 6G e AI tramite la tecnologia NVIDIA.

Questa collaborazione si concentra su due aree chiave: la prima è l'intelligenza artificiale per la RAN (rete di accesso radio abilitata all'intelligenza artificiale). Nokia, con 7.000 brevetti fondamentali 5G, sfrutterà la tecnologia di intelligenza artificiale di NVIDIA per utilizzare l'intelligenza artificiale e l'apprendimento per rinforzo per regolare il beamforming in tempo reale e ottimizzare l'efficienza dello spettro in diversi ambienti.

Considerando che le reti wireless consumano circa l'1,5-2% dell'elettricità mondiale, migliorare l'efficienza dello spettro non solo aumenta la capacità di trasmissione dei dati, ma rappresenta anche una misura fondamentale per il risparmio energetico.

Inoltre, l'intelligenza artificiale su RAN trasforma le reti wireless in un "cloud per robot industriali edge". Proprio come AWS è basato su Internet, Nvidia e Nokia stanno estendendo le capacità del cloud computing fino all'edge delle stazioni base, creando un ambiente di elaborazione completamente nuovo e a bassissima latenza. Questo è fondamentale per i robot industriali, i veicoli autonomi e le applicazioni di intelligenza artificiale edge che richiedono processi decisionali e risposte in tempo reale, aprendo un nuovo mercato potenzialmente enorme per l'edge computing.

L'intelligenza artificiale è la soluzione al problema: i tempi chiamano.

"Come l'elettricità e Internet, l'intelligenza artificiale è un'infrastruttura critica."

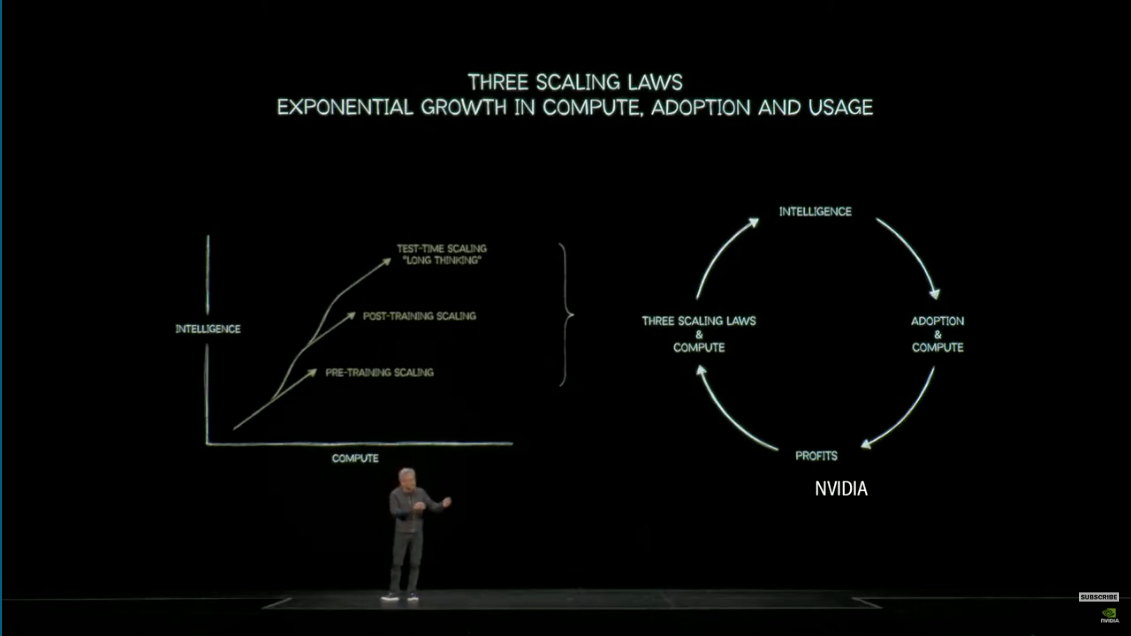

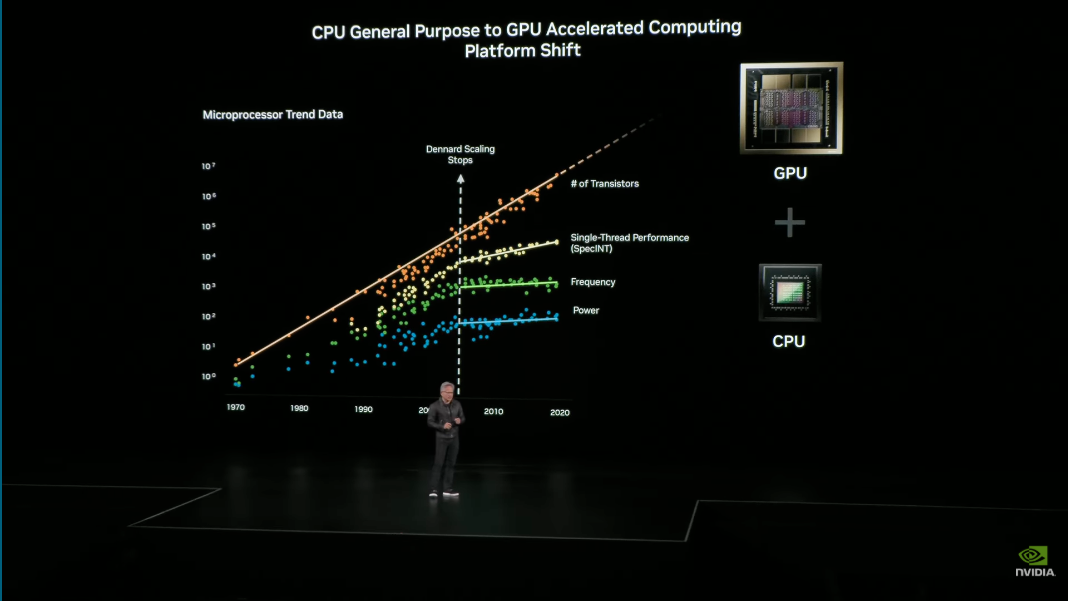

Questa idea non è nuova, ma Huang l'ha ribadita. Ha sottolineato che la trasformazione dell'era attuale è iniziata con un'osservazione chiave: la scalabilità di Dennard si è fermata da quasi un decennio e i guadagni in termini di prestazioni e consumo energetico dei transistor sono limitati dalle leggi della fisica, con i benefici della tradizionale Legge di Moore che stanno svanendo.

Questa realtà ha reso necessario il calcolo accelerato, un modello di elaborazione completamente nuovo. Sfrutta il numero sempre crescente di transistor tramite GPU e il modello di programmazione CUDA per ottenere il calcolo parallelo, superando il collo di bottiglia prestazionale delle CPU generiche. Jensen Huang ha sottolineato che il mantenimento della compatibilità con il modello di programmazione CUDA è il "tesoro" di NVIDIA, un risultato reso possibile dopo quasi trent'anni di sviluppo.

"L'intelligenza artificiale non è uno strumento. L'intelligenza artificiale è lavoro", ha affermato con coraggio Huang Renxun, sottintendendo che l'intelligenza artificiale si è evoluta in un fattore diretto di produttività ed è destinata a diventare la forza trainante della crescita economica e dell'innovazione.

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFaner: iFaner (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.