Dopo essere stato nominato da OpenAI, Zhipu ha appena rilasciato un nuovo modello open source: il motore di ricerca nazionale più versatile, creando un motore di ricerca in una frase

L'open source dei produttori nazionali di modelli su larga scala è in continua accelerazione.

Proprio ora, Zhipu ha rilasciato ufficialmente il suo ultimo modello di punta, il GLM-4.5. Secondo la dichiarazione ufficiale di Zhipu, si tratta di un "modello base progettato specificamente per le applicazioni Agent".

In linea con i nostri principi open source, questo modello è stato reso open source simultaneamente sulle piattaforme Hugging Face e ModelScope. I pesi del modello sono conformi alla licenza MIT e possono essere utilizzati commercialmente.

Versione a risparmio di flusso:

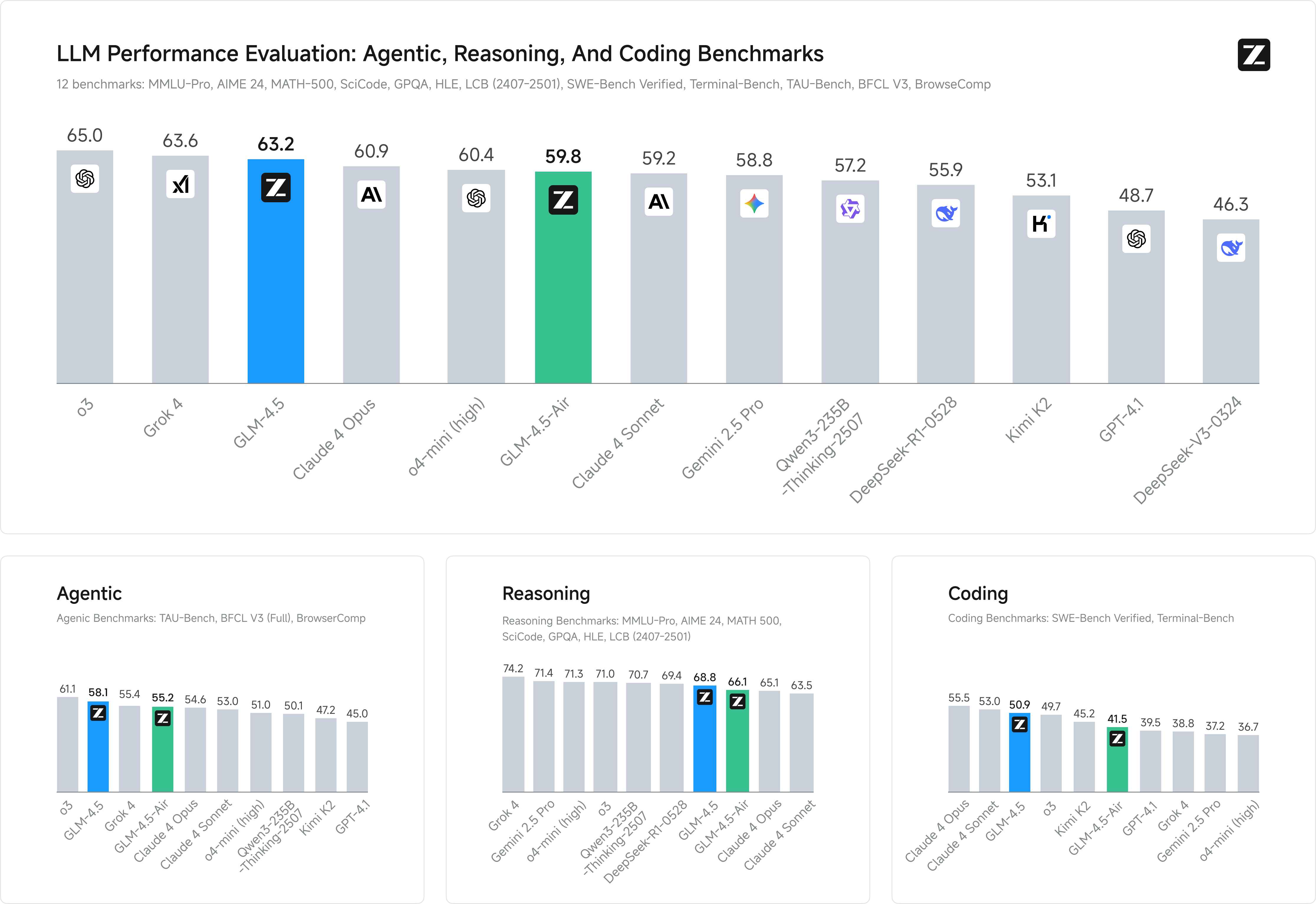

- GLM-4.5 ha raggiunto il livello più avanzato tra i modelli open source in termini di ragionamento, codice e capacità complete dell'agente.

- GLM-4.5 utilizza un'architettura mista di esperti (MoE), tra cui GLM-4.5: i parametri totali sono 355 miliardi, i parametri di attivazione sono 32 miliardi; GLM-4.5-Air: i parametri totali sono 106 miliardi, i parametri di attivazione sono 12 miliardi;

- Entrambe le versioni sono completamente open source e supportano la licenza MIT;

- Sia GLM-4.5 che GLM-4.5-Air supportano una modalità di ragionamento ibrida, che offre due modalità: una modalità di pensiero per ragionamenti complessi e utilizzo di strumenti e una modalità non di pensiero per una risposta immediata.

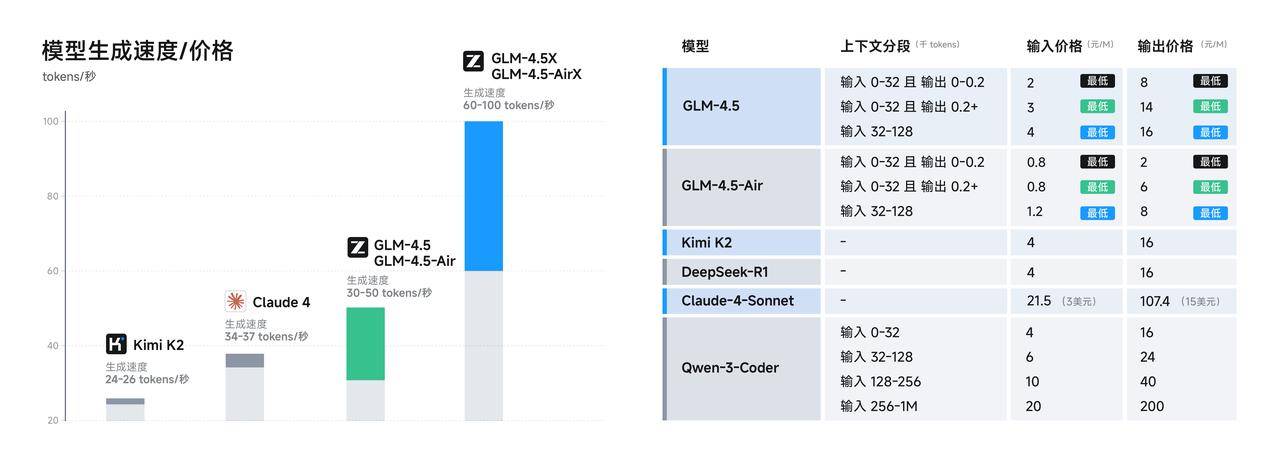

- Il prezzo della chiamata API è basso, pari a 0,8 yuan/milione di token per l'input e a 2 yuan/milione di token per l'output; la versione ad alta velocità può raggiungere fino a 100 token/secondo.

Un punto di forza tecnico fondamentale di GLM-4.5 è la sua prima integrazione nativa di capacità di ragionamento, codifica e agente in un unico modello. Mentre altri modelli eccellono nel ragionamento, nella codifica o nella funzione di assistente, GLM-4.5 vanta tutte queste capacità.

Come di consueto, diamo prima un'occhiata alla sezione "punteggio progressivo" del nuovo modello.

Zhipu ha selezionato 12 dei benchmark più rappresentativi per dimostrare le sue prestazioni, tra cui MMLU Pro, AIME 24, MATH 500, SciCode, GPQA e HLE, tutti a noi familiari. Il punteggio medio ha mostrato che GLM-4.5 si è classificato al secondo posto a livello globale, al primo tra i modelli nazionali e al primo tra i modelli open source.

Naturalmente, i punteggi correnti da soli sono inutili e i test più pratici sono più convincenti.

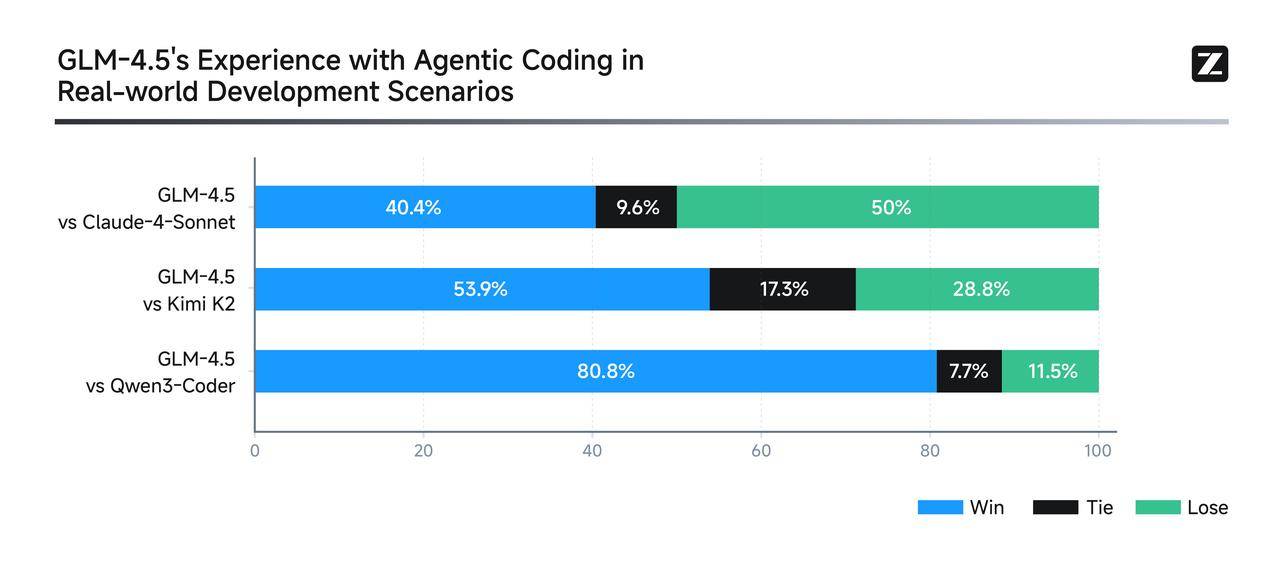

Per dimostrare la potenza di GLM-4.5 in scenari di Agent Coding reali, Zhipu lo ha integrato direttamente con Claude Code per competere con modelli quali Claude-4-Sonnet, Kimi-K2 e Qwen3-Coder.

Il piano di test era piuttosto rigoroso: un totale di 52 attività di sviluppo di programmazione, che coprivano sei aree di sviluppo principali, sono state testate in più round di test interattivi all'interno di ambienti container indipendenti, concentrandosi sull'esecuzione nel mondo reale. I risultati hanno mostrato che, sebbene ci fossero ancora ampi margini di miglioramento nell'utilizzo di Claude-4-Sonnet, GLM-4.5 ha comunque ottenuto ottimi risultati in termini di affidabilità delle chiamate degli strumenti e completamento delle attività.

Zhipu ha persino reso pubbliche tutte le domande dei test e le traiettorie degli agenti (https://huggingface.co/datasets/zai-org/CC-Bench-trajectories), il che mi ha dato la sensazione che accolgano con favore i colleghi per "combattere i falsi".

Diamo un'occhiata ad alcune demo più convincenti, che sono anche molto preziose.

Basta inserire il prompt "Crea un sito di ricerca Google" sul sito ufficiale di z.ai e GLM-4.5 genererà un motore di ricerca reale e utilizzabile in una sola frase.

La scatola delle funzioni quantistiche realizzata da GLM-4.5 è completamente funzionale e dimostra appieno le ampie capacità del modello.

Per una soluzione più complessa, è anche possibile generare una pagina con un globo 3D ingrandibile in cui gli utenti possono cliccare su una posizione per visualizzarne i dettagli, il tutto accompagnato da un'animazione di zoom fluida.

▲Suggerimenti: crea una pagina web utilizzando Three.js e JavaScript che crei un mondo 3D che mostri i luoghi che ho visitato, basandosi su un array. Cliccando sui marcatori sul globo 3D si attiverà un effetto zoom e si apriranno informazioni dettagliate sul viaggio con foto.

A differenza dei tradizionali strumenti di intelligenza artificiale per PowerPoint, che si basano su modelli per l'inserimento delle informazioni, GLM-4.5 ricerca autonomamente risorse e immagini, quindi crea presentazioni direttamente in HTML sulla base del materiale effettivamente disponibile. Oltre al formato standard 16:9, supporta in modo flessibile anche copertine per i social media, immagini lunghe, biglietti Xiaohongshu e persino curriculum personali.

Anche per quanto riguarda l'esperienza degli sviluppatori, i produttori cinesi stanno iniziando a migliorare. Ad esempio, GLM-4.5 è compatibile con le principali entità di code intelligence come Claude Code, Cline e Roo Code. Una guida utente completa è disponibile qui:

- Utenti domestici: https://docs.bigmodel.cn/cn/guide/develop/claude

- Utenti esteri: https://docs.z.ai/scenario-example/develop-tools/claude

Se quanto sopra è solo l'aspetto esteriore, allora il nucleo tecnico è il vero "interno" del GLM-4.5.

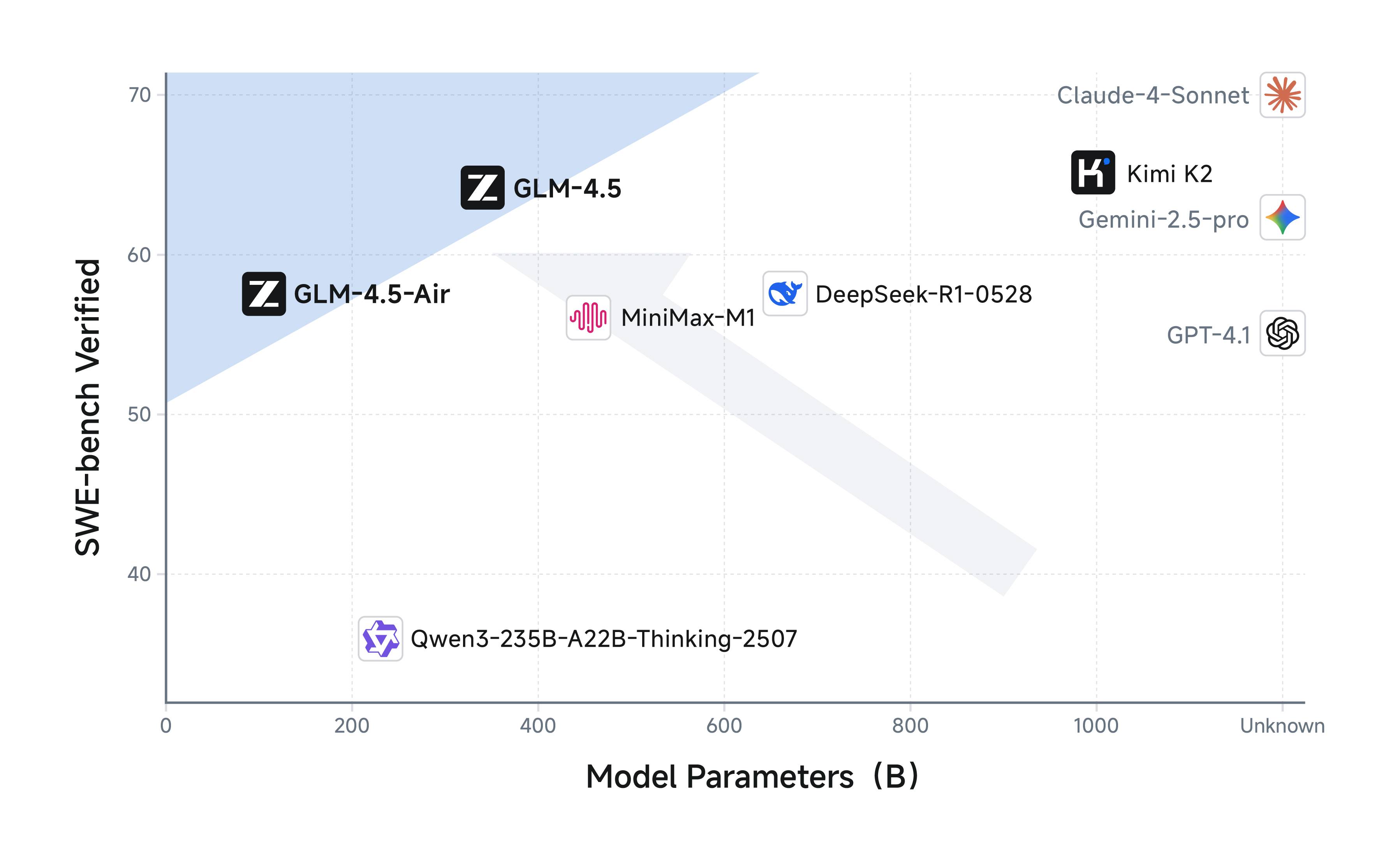

Un fatto poco noto è che il numero di parametri di GLM-4.5 è solo la metà di quello di DeepSeek-R1 e 1/3 di quello di Kimi-K2, ma le prestazioni non ne risultano compromesse. Ciò è dovuto alla maggiore efficienza dei parametri del modello GLM.

In particolare, il GLM-4.5-Air, con 106 miliardi di parametri totali e 12 miliardi di parametri di attivazione, ha già raggiunto le prestazioni di Gemini 2.5 Flash e Claude 4 Sonnet nei benchmark di inferenza. Si colloca inoltre alla frontiera di Pareto per il rapporto prestazioni/parametri nella lista SWE-bench Verified, ovvero offre un rapporto costo-prestazioni superiore con un ingombro ridotto.

Il miglioramento delle prestazioni è inscindibile dal "miracolo" del processo di allenamento.

GLM-4.5 e GLM-4.5-Air utilizzano un processo di addestramento simile: innanzitutto, eseguono un pre-addestramento su 15 trilioni di token di dati generali. Quindi, eseguono un addestramento mirato su 8 trilioni di token di dati in aree come codice, ragionamento e agenti. Infine, l'apprendimento per rinforzo viene utilizzato per migliorare ulteriormente le capacità del modello in termini di ragionamento, codice e agenti. Con denaro e risorse, si può davvero fare ciò che si vuole.

Inoltre, i progressi di GLM-4.5 in termini di costi ed efficienza potrebbero essere ancora più significativi. I prezzi delle chiamate API sono bassi, pari a soli 0,8 yuan per milione di token in input e 2 yuan per milione di token in output. Inoltre, la versione ad alta velocità può generare token a una velocità misurata fino a 100 token al secondo, supportando i requisiti di distribuzione a bassa latenza e alta concorrenza delle applicazioni reali. Ciò rappresenta davvero una significativa riduzione dei prezzi.

L'API è ora disponibile sulla piattaforma aperta BigModel.cn, con compatibilità one-click con il framework Claude Code. Gli utenti abituali possono anche sperimentare la versione completa di GLM-4.5 su Zhipu Qingyan (chatglm.cn) e Z.ai.

Vale la pena ricordare che il mese scorso OpenAI ha citato direttamente Zhipu in un rapporto pubblicato sul suo account Global Affairs, affermando che ha compiuto progressi significativi nella competizione globale dell'intelligenza artificiale. Il tono può essere definito raro e diretto.

Guardando indietro, Zhipu è stata un'azienda in crescita relativamente stabile, mantenendo un ritmo costante, rinnovando costantemente i modelli, liberalizzando le iniziative open source e mantenendo una chiara direzione. In quest'ottica, non sorprende che sia la prima delle "Sei Piccole Draghe" dell'IA a lanciare una IPO.

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFaner: iFaner (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.