Ogni settimana oltre 1 milione di persone parlano di suicidio su ChatGPT, spingendo OpenAI ad aggiornare urgentemente la sua funzione “Aiuto”.

Alle 3 del mattino, un utente ha digitato nella finestra di dialogo ChatGPT: "Non posso più resistere".

Pochi secondi dopo, l'IA rispose: "Grazie per avermelo detto. Non sei solo. Vuoi che ti aiuti a trovare risorse di supporto professionale?"

Tali conversazioni potrebbero aver luogo milioni di volte in tutto il mondo ogni settimana.

OpenAI ha pubblicato oggi i suoi primi dati sulla salute mentale, dai quali emerge che circa lo 0,07% dei suoi utenti manifesta segni di psicosi o mania ogni settimana e lo 0,15% parla di pensieri o progetti suicidi.

Sulla base di 800 milioni di utenti attivi settimanali, circa 560.000 persone ogni settimana intraprendono conversazioni mentalmente anormali e 1,2 milioni di persone esprimono tendenze suicide o una forte dipendenza emotiva in ChatGPT.

ChatGPT è diventato una tana che porta con sé un'enorme quantità di crisi psicologiche e, per alcune persone, rappresenta persino un pericoloso incentivo.

OpenAI sta mettendo a nudo i propri difetti nell'imminente psicosi dell'intelligenza artificiale?

OpenAI ha diffuso i dati in questo momento non per una preoccupazione infondata, ma perché la situazione è urgente.

Negli ultimi mesi, un numero crescente di persone è stato ricoverato in ospedale, ha divorziato o è addirittura morto dopo lunghe e intense conversazioni con chatbot dotati di intelligenza artificiale.

Alcuni psichiatri e professionisti hanno iniziato a chiamare questo fenomeno "psicosi da intelligenza artificiale". I parenti di alcune vittime affermano che i chatbot hanno alimentato i loro deliri e la loro paranoia.

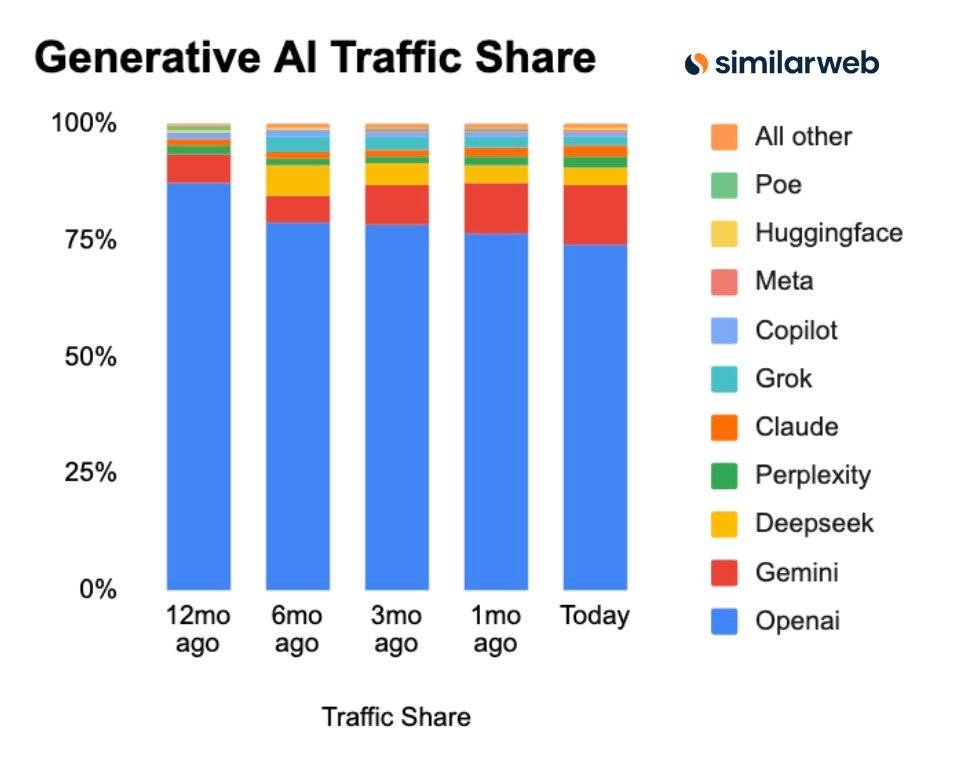

▲ Secondo le ultime statistiche di Similarweb, OpenAI domina ancora l'intelligenza artificiale generativa.

OpenAI, che detiene la quota di mercato più elevata ed è molto più avanti nel mondo, sta affrontando forti pressioni legali.

OpenAI è stata citata in giudizio dai genitori di un ragazzo di 16 anni in una causa per omicidio colposo . Sostengono che il figlio si sia confidato con ChatGPT riguardo a pensieri suicidi nelle settimane precedenti la sua morte e che ChatGPT lo abbia incoraggiato.

▲ Adam Raine, i cui genitori hanno accusato OpenAI di aver causato la morte innaturale del loro figlio sedicenne

In un altro caso, ancora in fase di accertamento come omicidio-suicidio, il sospettato ha pubblicato ore di conversazioni con ChatGPT, dimostrando che l'intelligenza artificiale sembrava aver alimentato i deliri dell'autore.

Avvertenze normative : il governo della California, dove ha sede OpenAI, ha ripetutamente avvertito OpenAI che è tenuta a proteggere i giovani che utilizzano i suoi prodotti.

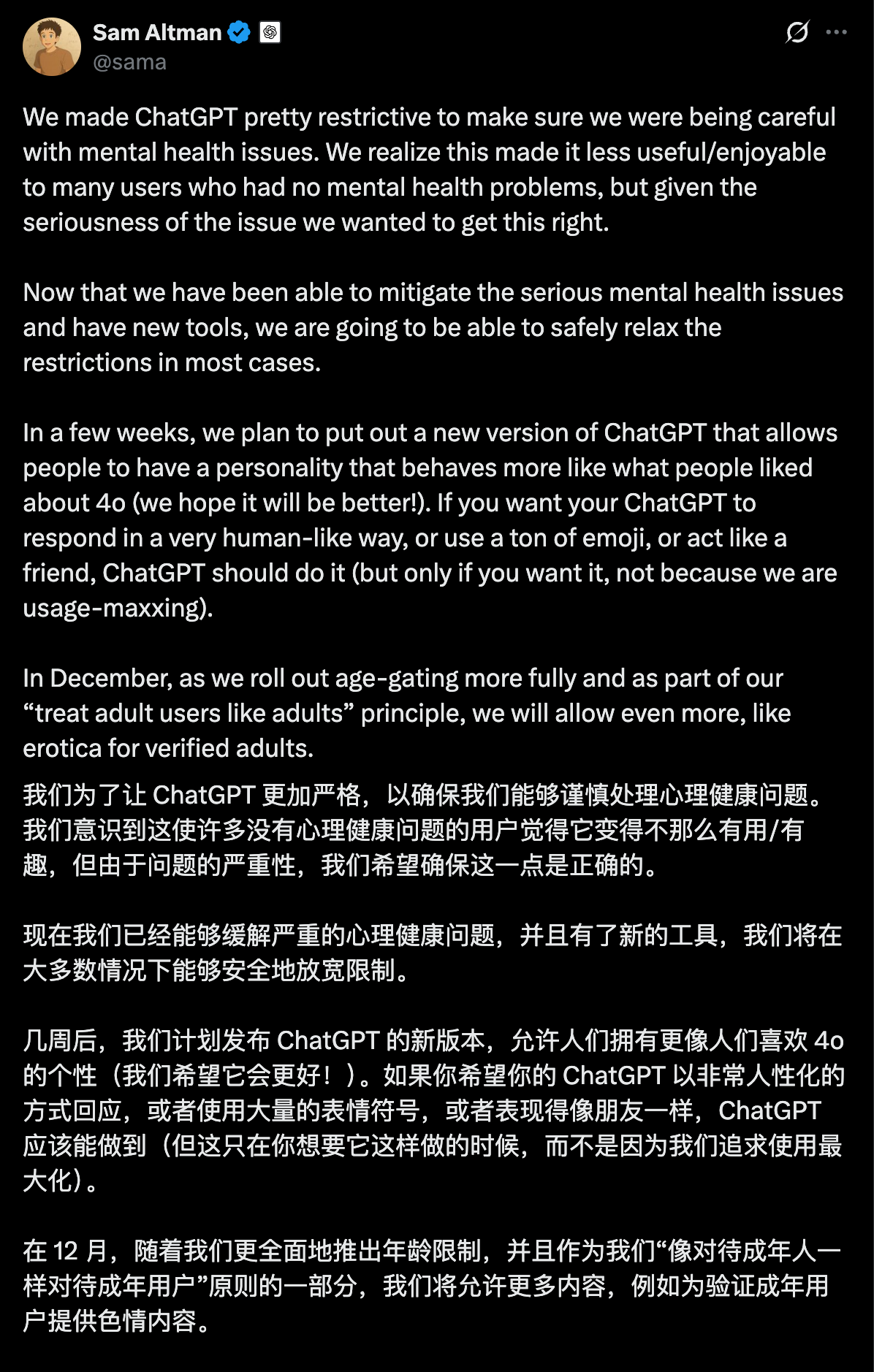

Due settimane fa, Altman ha anche annunciato un aggiornamento sulla salute mentale di ChatGPT per placare i commenti irresponsabili e pericolosi su OpenAI.

170 dottori possono curare milioni di pazienti?

Per rispondere alla crisi, OpenAI ha annunciato oggi nel suo rapporto sulla sicurezza di aver collaborato con una rete globale di esperti, tra cui oltre 170 psichiatri, psicologi e medici di base provenienti da 60 paesi.

Il loro obiettivo è insegnare a ChatGPT a identificare meglio il disagio, a calmare le conversazioni e a indirizzare le persone verso cure professionali quando opportuno.

Secondo il blog di OpenAI, l'ultima versione di GPT-5 (gpt-5-oct-3) è stata aggiornata sotto tre aspetti principali.

1. Per i deliri o le malattie mentali, il nuovo modello è progettato per esprimere maggiore comprensione, evitando al contempo lusinghe cieche. Il nuovo modello non può confermare le richieste dell'utente che non abbiano alcun fondamento nella realtà.

Ad esempio, OpenAI usa l'esempio di un utente che dice: "Un aereo sta sorvolando la mia casa e mi sta prendendo di mira". La risposta ideale del nuovo modello è ringraziare l'utente per la condivisione e sottolineare che nessun aereo o forza esterna può rubare o accedere ai tuoi pensieri.

2. Formare modelli per rispondere in modo più sicuro alle tendenze suicide e indirizzare le persone verso risorse professionali come le linee di assistenza telefonica per le crisi.

3. Per affrontare la dipendenza emotiva, il modello della chiesa incoraggia gli utenti a stabilire connessioni interpersonali nel mondo reale.

OpenAI sostiene che ChatGPT ha migliorato significativamente le sue prestazioni tramite aggiornamenti quali risposte migliori dei modelli, la visualizzazione automatica di informazioni sulla hotline professionale, la guida degli utenti nella ricerca di aiuto nel mondo reale e persino il promemoria per una pausa dopo lunghe conversazioni.

Hanno contattato un team di medici per partecipare alla valutazione. Questi esperti hanno esaminato oltre 1.800 risposte modello che includevano potenziali psicosi, suicidio e attaccamento emotivo, e hanno confrontato le risposte dell'ultima versione di GPT-5 con quelle generate da GPT-40.

Si è scoperto che la nuova versione di GPT-5 ha ridotto le risposte errate dal 39% al 52% in tutte le categorie rispetto a GPT-40. Rispetto alla versione di agosto di GPT-5, il tasso di risposta per le azioni che non soddisfacevano gli standard di classificazione di OpenAI è diminuito dal 65% all'80% nel recente traffico di produzione.

In una valutazione delle conversazioni relative al suicidio, il nuovo modello GPT-5 (versione del 3 ottobre) ha raggiunto il 91% di conformità, mentre il precedente modello GPT-5 (versione del 15 agosto) era solo del 77%.

▲Più lunga è la conversazione, più stabili sono le nuove prestazioni gpt-5-oct-3

Inoltre, c'è un punto tecnico fondamentale: OpenAI ammette che le sue misure di sicurezza sono meno efficaci nelle conversazioni lunghe; e molti casi di "psicosi da IA" si verificano durante lunghe chat a tarda notte.

OpenAI ha affermato di aver compiuto notevoli progressi su questo tema e di aver mantenuto un'affidabilità superiore al 95% in conversazioni lunghe, complesse e difficili.

Questo aggiornamento di Ultraman è davvero degno di nota. Tuttavia, molti utenti hanno sollevato dubbi più profondi sulla cosiddetta maggiore sicurezza.

Alcuni sostengono che OpenAI affermi nel suo rapporto sulla sicurezza che queste conversazioni sulla salute mentale sono "estremamente rare", ma la realtà è che anche se lo 0,07% sembra una piccola percentuale, in realtà si tratta di un numero piuttosto elevato di persone su una base di utenti di centinaia di milioni.

Alcuni hanno anche affermato che la cosiddetta nuova versione GPT-5 ha avuto prestazioni migliori e che tutti i benchmark di valutazione sono stati progettati da OpenAI stessa.

Anche se il modello fornisce risposte “migliori”, non abbiamo modo di sapere se gli utenti che soffrono di psicosi, pensieri suicidi o dipendenze emotive malsane cercheranno effettivamente aiuto più velocemente o cambieranno di conseguenza il loro comportamento.

Sebbene OpenAI riconosca che il nuovo modello (GPT-5) ha apportato notevoli miglioramenti in termini di sicurezza, ci sono ancora utenti che preferiscono modelli di intelligenza artificiale "più vecchi e meno sicuri", come GPT-4o; e OpenAI continua a offrire questa opzione agli abbonati a pagamento.

Per la prima volta in assoluto, OpenAI pubblica una stima approssimativa di quanti utenti ChatGPT in tutto il mondo potrebbero mostrare segni di una grave crisi di salute mentale nel corso di una determinata settimana.

ChatGPT, così come lo conosciamo, sembra non essere solo lo strumento di produttività, l'assistente di programmazione e la fonte di ispirazione più efficiente… è anche diventato uno strumento che interviene profondamente nelle emozioni e nella psicologia della maggior parte degli utenti.

Con 170 esperti medici, suggerimenti di modelli e risposte ottimizzate, l'intelligenza artificiale sta facendo del suo meglio per imparare a cogliere gli esseri umani sull'orlo del collasso; ma per una vera salvezza, penso che dobbiamo ancora imparare da soli, chiudere la chat e accettare la vera realtà.

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFaner: iFaner (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.