ChatGPT ha superato gli esami delle migliori università, ciò che dovrebbe essere fatto di più rispetto all’anti-AI è cambiare le domande d’esame

Quando gli studenti di giurisprudenza stavano provando a giocare a ChatGPT, non avrebbero mai dovuto pensare che si sarebbe voltato e sarebbe diventato un “compagno di classe” che ha sostenuto lo stesso esame con loro.

Lo scorso gennaio, rispettivamente, il professor Jon Choi della University of Minnesota School of Law e il professor Christian Terwiesch della Wharton School dell’Università della Pennsylvania hanno chiesto a ChatGPT di “fare” le domande d’esame finali dei loro corsi.

Di conseguenza, ChatGPT è davvero passato!

Ciò significa lasciare che ChatGPT si evolva ancora un po’ e non avremo bisogno di avvocati e amministratori umani in futuro?

O è questo un campanello d’allarme per gli educatori per smettere di insegnare agli umani a essere come l’IA?

Dietro il passo: l’insegnante “ha rilasciato l’acqua” e tutta la classe era in fondo

Nelle due major che sono state testate, i risultati di ChatGPT nella facoltà di giurisprudenza sono peggiori di quelli della scuola di economia: la prima ha un punteggio medio di C+ e la seconda può ottenere voti da B a B.

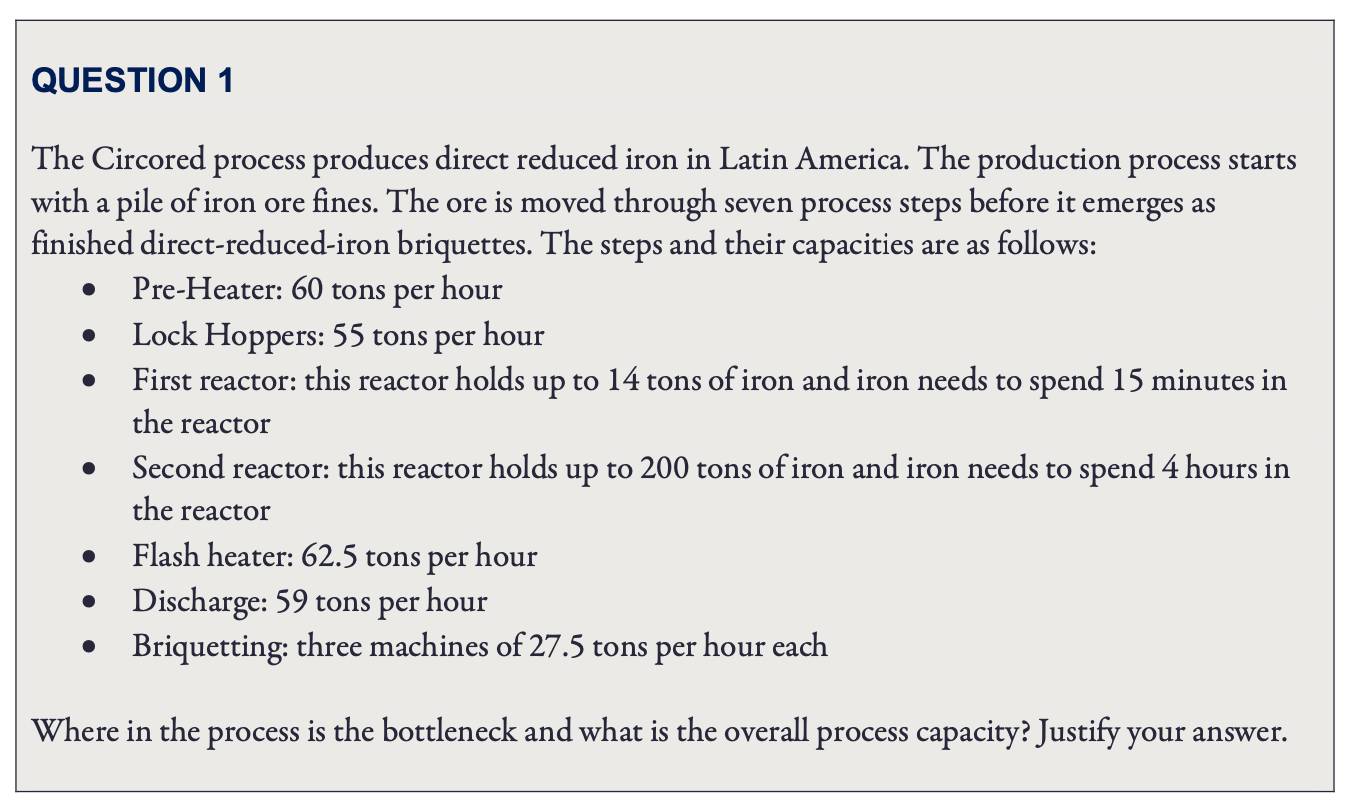

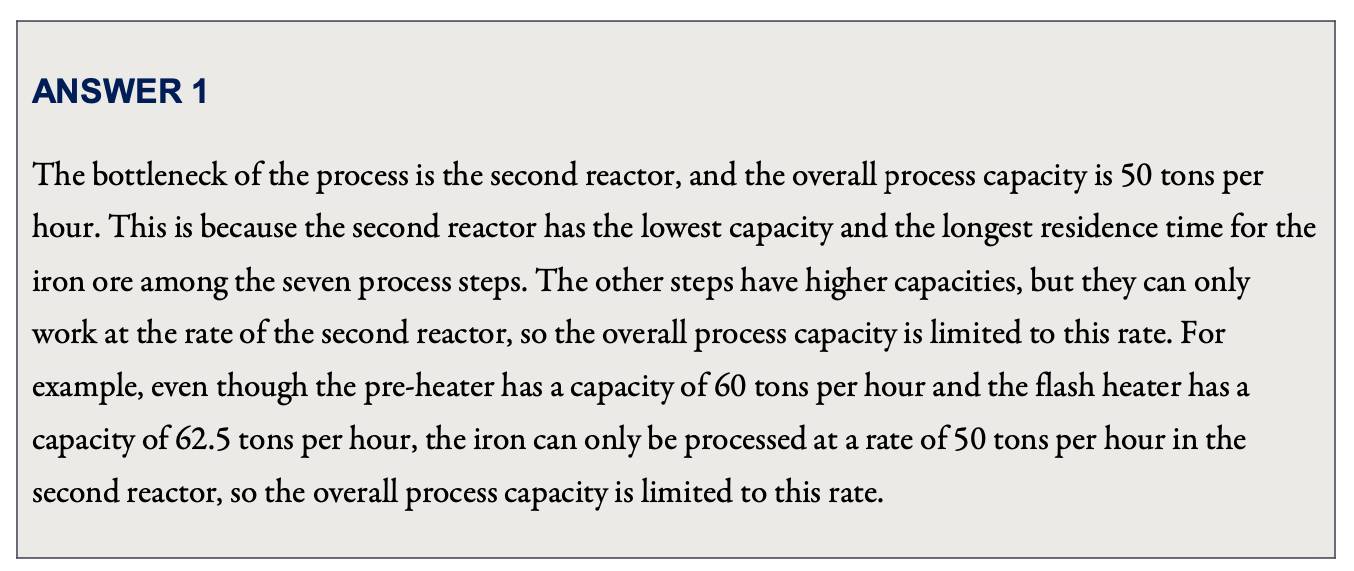

Nello specifico, ciò che ChatGPT ha completato a Wharton sono le domande di prova della materia “Gestione delle operazioni” dell’MBA (Master of Business Administration), e ogni domanda deve scrivere il “processo di deduzione”.

Durante il test, il professor Terwiesch ha inserito le domande originali dell’esame in ChatGPT e ha valutato le risposte generate da ChatGPT.

In generale, ChatGPT si comporta molto bene nel rispondere a domande di analisi di base; non è molto bravo in matematica e può improvvisamente calcolare male un calcolo difficile della scuola elementare; e domande di analisi relativamente complesse, ChatGPT è sostanzialmente incapace.

Ad esempio, la prima domanda verifica la comprensione del concetto di “collo di bottiglia gestionale” e confronta semplicemente quale fase del “processo di produzione” è la meno efficiente per scoprire il “collo di bottiglia”.

Il professore ha dato direttamente a questa domanda un A+.

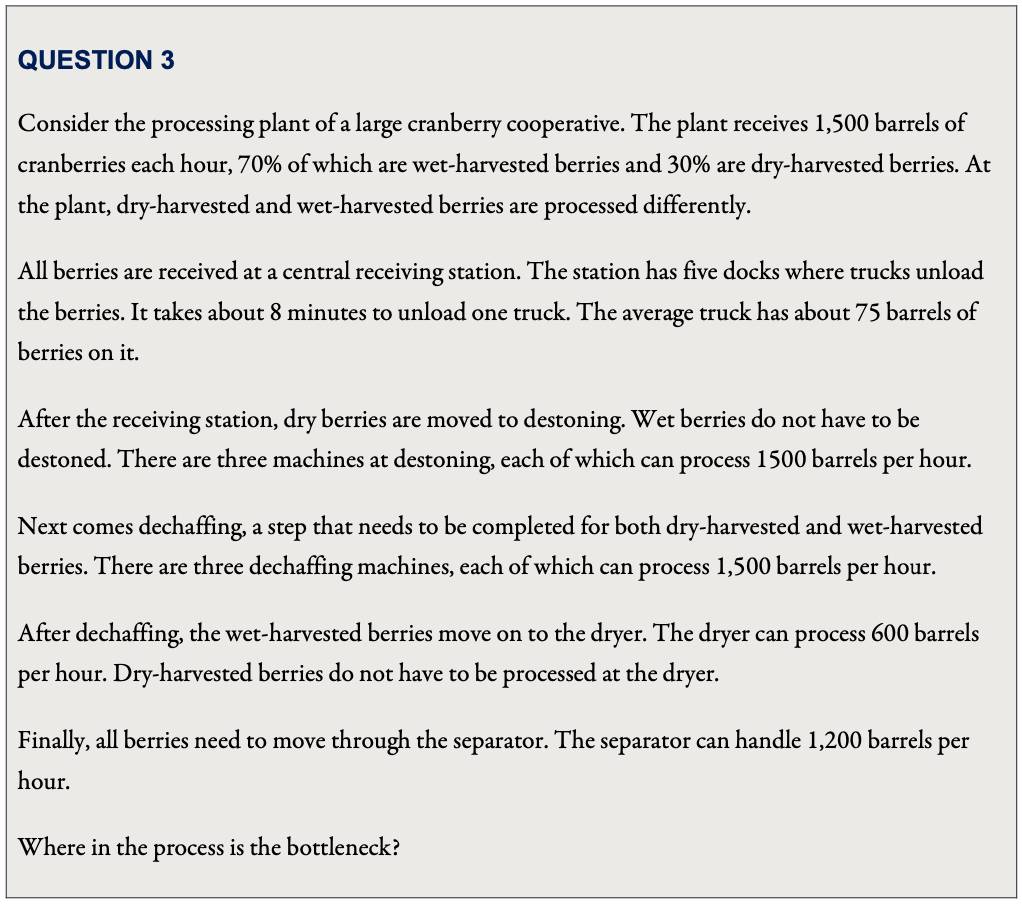

Tuttavia, quando il “processo di produzione” nelle domande del test diventa più complicato, è necessario elaborare più di una materia prima e le apparecchiature coinvolte sono diverse e si sovrappongono, ChatGPT non può essere considerato un “collo di bottiglia gestionale”.

Per questa domanda, sebbene il processo di deduzione di ChatGPT fosse sbagliato, ha “aggirato perfettamente” l’inferenza sbagliata e ha trovato la risposta.

Nel calcolare l’efficienza della “stazione ricevente”, ChatGPT ha dato un risultato di “300 barili all’ora”.

Sebbene questo numero sia sbagliato, in termini di questo numero, è davvero la parte meno efficiente del processo di analisi.

Chi avrebbe pensato che ChatGPT “non credo in me stesso” e non ha selezionato questo collegamento come “collo di bottiglia”, ma ha scelto il collegamento “essiccatore” con un’efficienza calcolata di “600 barili all’ora” come “collo di bottiglia” —Scegli una risposta corretta.

Tuttavia, sebbene il professor Terwiesch abbia finalmente assegnato a ChatGPT un punteggio di livello B, è stato anche un po’ “acquoso”.

Quando c’è un errore nella risposta di ChatGPT, Terwiesch fornirà un promemoria mirato a ChatGPT, quindi lascerà che emetta una risposta e utilizzerà questo risultato “ottimizzato” per segnare.

Per quanto riguarda gli esami di giurisprudenza, ChatGPT ha risposto alle domande dell’esame finale per quattro corsi: diritto costituzionale, diritto dei benefici ai dipendenti, diritto tributario e diritto della responsabilità civile.

Il professor Jon Choi, che ha guidato il test, ha affermato che in caso di “correzione alla cieca”, tutti e quattro i soggetti di ChatGPT sono passati, ma i risultati sono stati sostanzialmente gli ultimi della classe.

Sebbene le domande a risposta breve di ChatGPT siano migliori delle domande a scelta multipla, la qualità delle domande a risposta breve è estremamente instabile: a volte la risposta può essere migliore di quella degli studenti ordinari (principalmente testi legali e rivisitazione dei casi), ma un errore ( Di solito è una domanda che richiede agli studenti di utilizzare teorie specifiche per analizzare i casi) e i punteggi sono solitamente “sbagliati a un nuovo minimo”:

ChatGPT si è comportato male anche sulle domande più basilari dell’esame di giurisprudenza, come l’identificazione di potenziali problemi legali e l’analisi approfondita e l’applicazione del testo legale in un caso.

Lo stile di risposta di ChatGPT “non chiedere comprensione, solo approvazione” può anche superare l’esame professionale con punteggi bassi. Mostra che le domande del test dipendono ancora troppo dalla “memorizzazione meccanica”. Le prestazioni di ChatGPT non sono ovviamente in grado di sostituire gli avvocati e dirigenti.

Tuttavia, se anche gli studenti umani sono a questo livello, hanno anche superato l’esame e si esercitano anche dopo la laurea, è più problematico?

ChatGPT può imporre modifiche dopo aver criticato l’esame di “approvazione” per molti anni?

Prima dello straordinario debutto di ChatGPT, il professore della Carnegie Mellon University Danny Oppenheimer si era già chiesto : nell’era della ricerca su Google, perché gli esami universitari si concentrano solo sulla riaffermazione dei fatti da parte degli studenti?

Oppenheimer ha sottolineato che sebbene alcuni educatori ribattano che quando spiegano informazioni fattuali in classe, analizzeranno anche il significato, l’argomento e l’applicazione delle informazioni, ma quando si tratta del test, tornano immediatamente a “l’approvazione è sufficiente “:

Molti corsi sono costruiti sulla premessa che gli studenti svilupperanno questa abilità in modo naturale osservando i loro insegnanti dare l’esempio nell’analizzare, espandere e applicare i fatti – un presupposto molto discutibile.

Pertanto, Oppenheimer ha suggerito che il curriculum dovrebbe riflettere direttamente le abilità che gli educatori sperano che gli studenti alla fine apprendano, ed è anche necessario combinare nuove tecnologie, come “fare apprezzamento letterario con l’assistenza del computer” e “come essere civilizzati con persone che non sono d’accordo con te”. comunicare”.

Gli esami possono includere informazioni fattuali, ma dovrebbero concentrarsi sulle capacità analitiche e applicative degli studenti.

Inoltre, lasciare che gli studenti “prevedano in anteprima” gli scenari che incontreranno in futuro è anche un modo diretto per mettere in pratica le abilità.Ad esempio, lascia che gli studenti che studiano il cambiamento climatico curino una mostra sul clima per il pubblico.

Ora, nell’era di ChatGPT, questo cambiamento è naturalmente più urgente, perché è più efficiente dei motori di ricerca, ma anche più confuso.

Oltre a far risparmiare agli studenti il tempo di sfogliare una pagina dopo l’altra dei risultati di ricerca, ChatGPT genera anche passaggi fluenti con una struttura linguistica sufficiente, anche se l’accuratezza fattuale è molto dubbia.

È interessante notare che ChatGPT funge anche da specchio.

Da un lato, ricorda la composizione e le domande a risposta breve nell’istruzione orientata agli esami, che sono sempre come infinite “imitazioni”, riempiendo il paradigma standard, proprio come ChatGPT.

D’altra parte, cresciuto “mangiando” big data e “insegnando/istruendo” da feedback umani reali , anche il contenuto delle “gravi sciocchezze” di ChatGPT è molto simile alla quotidianità che incontriamo nelle nostre vite.

Tanto che il professor Terwiesch della Wharton School of Business è rimasto molto sorpreso e ha ritenuto che ChatGPT potesse portare eccellenti materiali didattici ai futuri manager——

Il mondo degli affari è già pieno di serie sciocchezze, come dice ChatGPT, e gli studenti di economia possono semplicemente usarlo per fare esercizi di identificazione!

Sappiamo entrambi che non sono solo gli studenti delle scuole di economia a dover imparare questa abilità.

Tuttavia, da quando il motore di ricerca è diventato popolare nel settore dell’istruzione superiore americana, ci sono state discussioni sulla riforma, ma i progressi sono ancora limitati oggi.La nascita di ChatGPT può costringerlo a funzionare più velocemente? Possiamo solo continuare ad osservare.

umano, umanoide

Penso sempre che ogni volta che gli esseri umani cercano di “ricreare” qualcosa, espone sempre i nostri limiti cognitivi delle cose e allo stesso tempo ci aiuta a capire noi stessi.

Nel tentativo di “ricreare” il cibo nello spazio , i ricercatori hanno scoperto che il cibo non può davvero essere ridotto a solo “nutriente”.

Per mantenere la salute fisica e mentale degli astronauti, il colore, l’olfatto, il gusto e il suono influenzano tutti la percezione, l’ambiente deve essere particolare e anche le persone che mangiano insieme sono molto importanti.

Quando abbiamo un ChatGPT che può “parlare fluentemente in modo umano”, le persone iniziano anche a scoprire che il linguaggio umano non riguarda solo il “testo”.

Un sistema addestrato solo sul materiale linguistico non si avvicinerà mai all’intelligenza umana, anche se inizia ad allenarsi ora, finché l’universo non sarà distrutto.

Jacob Browning, che studia la filosofia dell’intelligenza artificiale, e Yann Le Cun, vincitore del premio Turing, sottolineano in un articolo congiunto .

Credono che, in quanto simbolo astratto altamente condensato, la base per la comprensione umana risieda nel nostro ricco consenso non linguistico e nella nostra esperienza personale. Ciò significa anche che le parole sono sempre soggette a interpretazioni errate e ambiguità.

La lingua è il nostro strumento di comunicazione, ma la comprensione e la valutazione degli studenti da parte degli educatori non dovrebbe essere limitata ai documenti.

Lavorare con modelli linguistici di grandi dimensioni all’avanguardia mostra quanto possiamo essere limitati dal solo linguaggio.

#Benvenuti a prestare attenzione all’account pubblico WeChat ufficiale di Aifaner: Aifaner (ID WeChat: ifanr), altri contenuti interessanti ti verranno presentati il prima possibile.

Ai Faner | Link originale · Visualizza i commenti · Sina Weibo