Perché le fotocamere Android sono riluttanti a utilizzare la suola? | Filosofia dura

Il livello inferiore schiaccia le persone a morte.La “regola d’oro” nella bocca di questo vecchio mago sembra essere scaduta sugli smartphone.

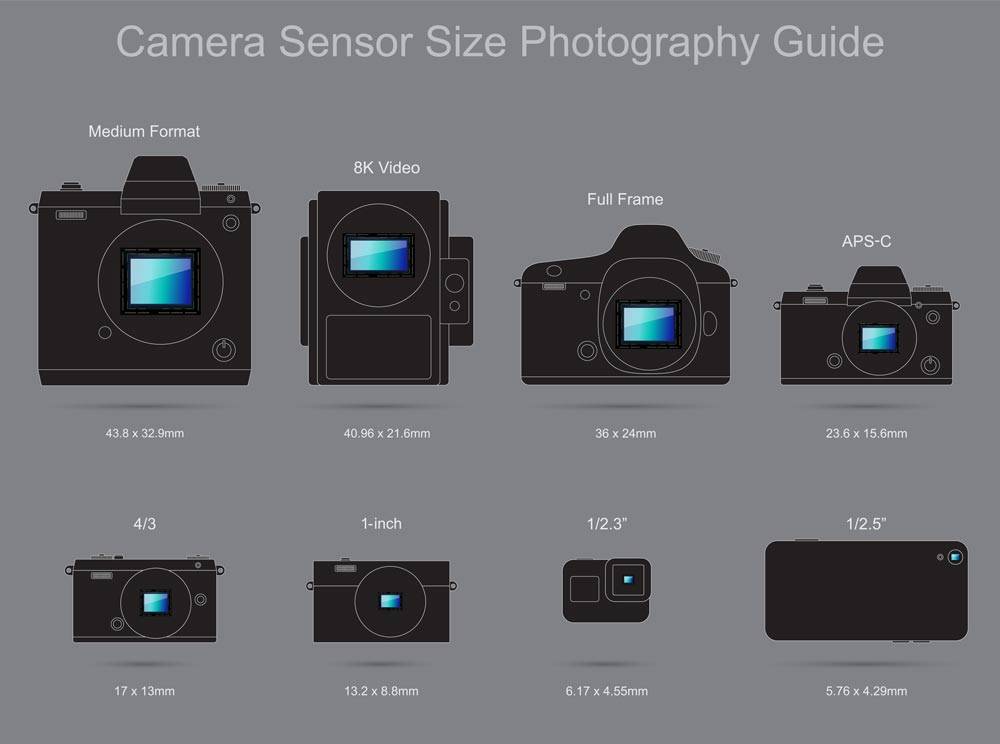

▲ Diverse “telecamere” sono dotate di sensori di diverse dimensioni Immagine da: henrys.com

Nonostante il “fondo” della fotocamera dello smartphone sia diventato via via più grande, non ha ancora superato la soglia di un pollice, il che significa che il cellulare è ancora inferiore alla scheda nera entry-level in termini di parametri fisici.

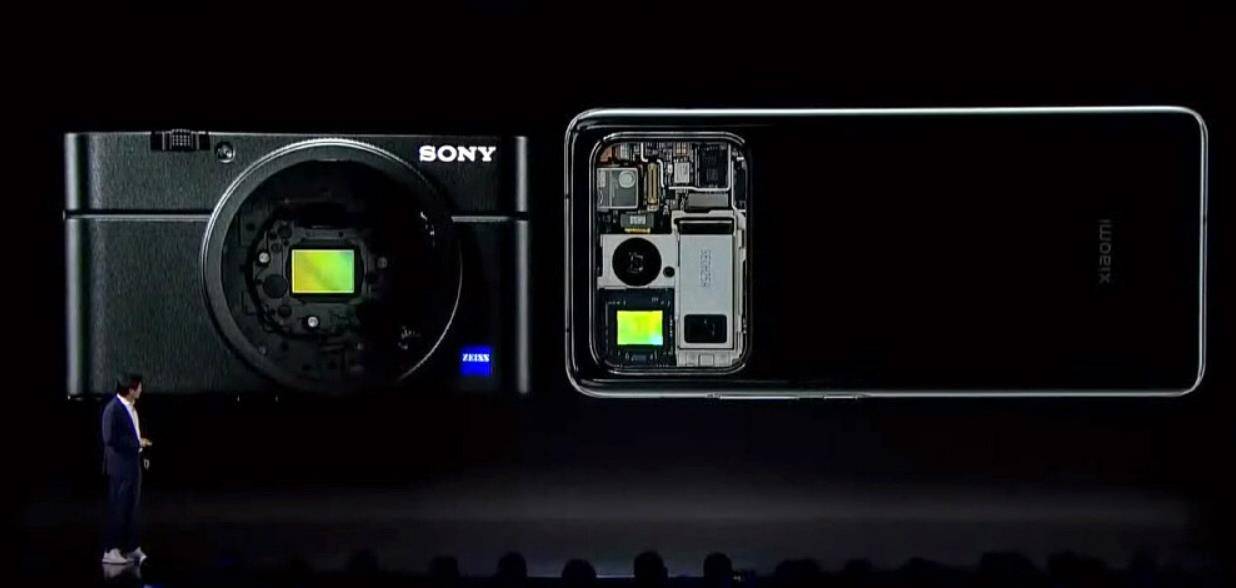

▲ Sony RX100 Black Card vs Xiaomi Mi 11 Ultra. Immagine da: dpreview

Anche in conferenza stampa, lo Xiaomi Mi 11 Ultra, che punta sull’”immagine”, e la fotocamera principale Samsung GN2 da 1/1.12 pollici di dimensioni fisiche ancora leggermente diverse da 1 pollice.

La dimensione dell’IMX707 personalizzata con Sony sullo Xiaomi Mi 12 è di soli 1/1,28 pollici, la dimensione della fotocamera principale iQOO 9 Pro GN5 nello stesso periodo è di 1/1,57 pollici e la dimensione della fotocamera principale Realme GT2 Pro IMX766 è 1/1,56 pollici.

▲ Realme GT2 Pro con fotocamera principale IMX766.

Guardando in questo modo, con la dimensione fisica CMOS come standard, nella prima ondata del nuovo Snapdragon 8 Gen1, Xiaomi Mi 12 e 12 Pro sono ancora i prodotti più preferiti. La dimensione della dimensione del CMOS non è più il criterio principale per misurare il sistema di imaging del telefono cellulare.

In questo modo, sembra che la ricerca della fotocamera principale “super-bottom” sia diventata un ricordo del passato.

Cosa significa “schiacciare le persone a morte”?

In altre parole, quali vantaggi può apportare la suola?

In poche parole, un sensore più grande si tradurrà in foto più pulite, migliori prestazioni in condizioni di scarsa illuminazione e un migliore “bokeh”.

Ottenere gli stessi risultati con sensori più piccoli richiede ISO inferiori, tempi di posa più lunghi e aperture maggiori.

▲ “Grande” ha grossi problemi, “piccolo” ha piccoli vantaggi. Immagine da: dpreview

In termini di risultati di imaging, i sensori di grandi dimensioni hanno il vantaggio di schiacciare, ma pagano anche un prezzo.

Per adattarsi a sensori di dimensioni maggiori, anche le dimensioni delle fotocamere e degli obiettivi sono cresciute in modo esponenziale. Per diffondere la luce in modo uniforme sul sensore, il complesso design ottico raddoppierà il peso dell’obiettivo. E con questo arriva il costo, che è denaro.

▲ Un confronto intuitivo tra le dimensioni del sistema full frame e del sistema M43 Immagine da: Wildshots

Il sensore di piccole dimensioni è esattamente l’opposto e anche il volume, il peso e il costo sono ridotti.

A rigor di termini, la dimensione del sensore è proporzionale alla qualità dell’immagine, nonché al peso del volume e al prezzo.

Ci sarà sempre un “punto debole” tra di loro, nei sistemi di fotocamere, full frame e negli smartphone, potrebbe essere il pollice che ogni produttore si sforza di raggiungere.

Fino all’avvento della “fotografia computazionale”.

La svolta della “fotografia computazionale”

Che si tratti di una fotocamera o di uno smartphone, il principio dell’immagine non è altro che l’obiettivo che controlla la luce per entrare nel CMOS, il CMOS esegue la conversione fotoelettrica e quindi il sensore di immagine la ripristina in un’immagine.

A giudicare dal processo di cui sopra, non c’è alcuna possibilità che il telefono cellulare batta la fotocamera, a meno che la “spada non vada di lato”.

Rispetto ai potenti attributi delle fotocamere, gli smartphone sono in realtà più inclini ai “risultati”. Il pubblico in generale utilizza i telefoni cellulari per registrare in modo più casuale e raramente passa al post-editing, concentrandosi sul “trading one-shot”.

▲ iPhone 13 Pro vs Pixel 6 Pro. Immagine da: cnet

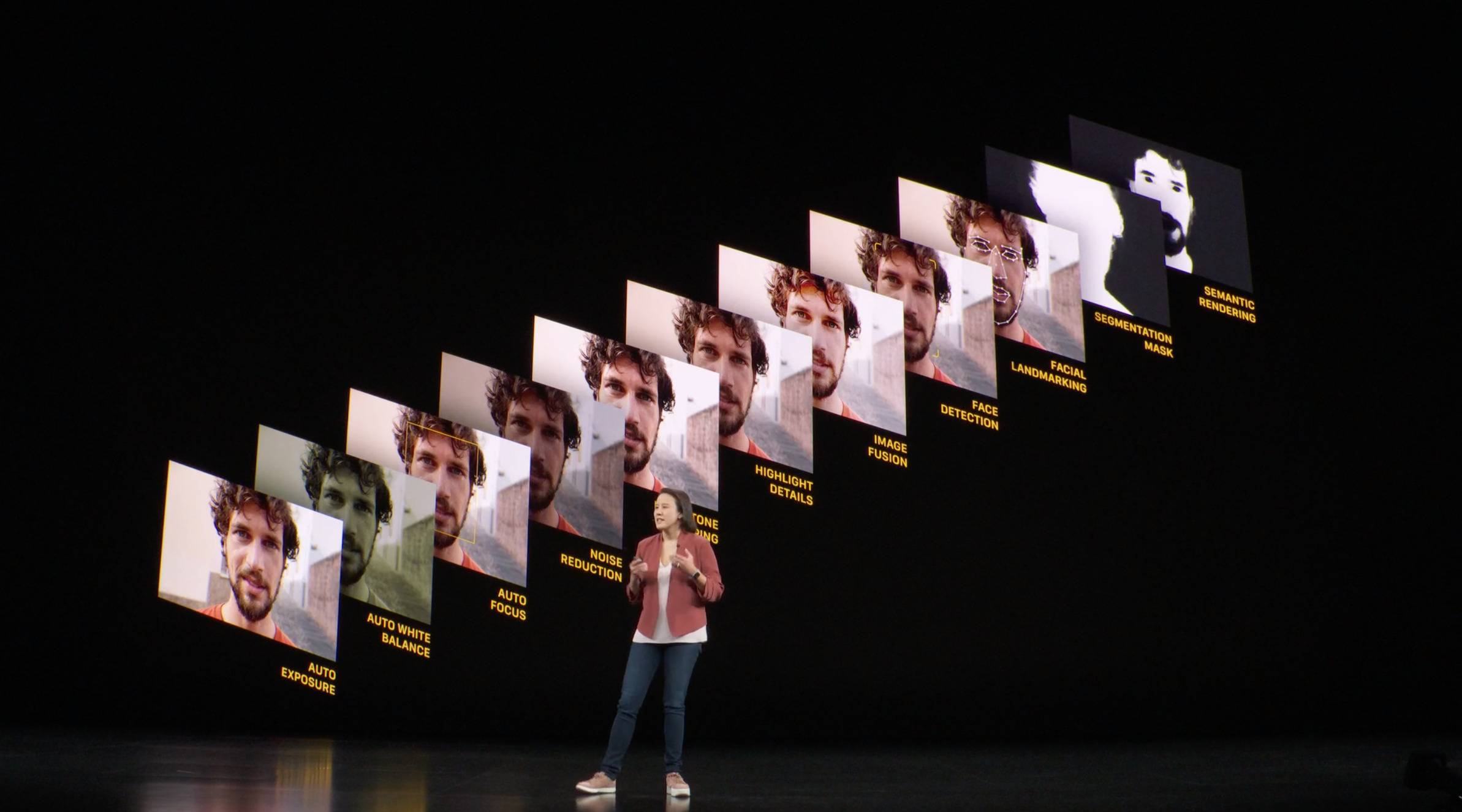

Con l’aumento della potenza di calcolo dell’IA nei SoC dei telefoni cellulari, la fotografia dei telefoni cellulari si è gradualmente sviluppata da semplice HDR e sintesi multi-frame di scene notturne a HDR in tempo reale, simulazione ad ampia apertura e complesse modalità “scena notturna”.

Attraverso il sostanziale miglioramento della potenza di calcolo dell’IA e la raffinata corrispondenza di diversi algoritmi di immagine, il processo di imaging dello smartphone non è più tradizionale, ma ha aggiunto molti componenti di “calcolo”.

In passato, quando si scattava con una macchina fotografica, era spesso necessario pianificare e scegliere in anticipo i progetti di ripresa, che hanno dato vita anche ad alcune esperienze classiche come la Sedicesima Regola del Sole.

Gli smartphone sono nati per essere “taglia unica” e qualsiasi scena, soggetto e luce devono essere gestiti con facilità. Il tradizionale processo di registrazione di acquisizione, elaborazione e ripristino non è adatto al sistema di imaging del telefono cellulare: dopo il calcolo e la regolazione dell’IA, l’output è più in linea con i risultati desiderati dagli utenti di telefoni cellulari.

Poiché la fotografia computazionale diventa gradualmente mainstream, le specifiche hardware della fotocamera non sono più l’unica misura della potenza dell’immagine. La potenza dell’immagine è diventata gradualmente una manifestazione di forza globale, che include non solo un hardware migliore, ma anche algoritmi di intelligenza artificiale migliori.

Le prestazioni più potenti dell’ISP e dell’IA nel SoC influiscono anche sulla potenza di imaging del telefono cellulare insieme al CMOS e all’obiettivo.

L’ascesa dei chip auto-sviluppati

Che si tratti dei chip della serie A di Apple o dei chip della serie 8 di Qualcomm, nelle recenti iterazioni di aggiornamento, rispetto al piccolo miglioramento delle prestazioni di CPU e GPU, che si tratti del numero di core o del numero di transistor, il motore di calcolo neurale ha più volte o anche una dozzina di volte miglioramento.

▲ L’A15 può eseguire 15,8 trilioni di calcoli IA al secondo Immagine da: Apple

Questi miglioramenti vengono utilizzati in tutti gli aspetti del prodotto e la fotografia computazionale basata sul machine deep learning è uno di questi.

Anche se la potenza di calcolo dell’IA sul SoC è stata notevolmente migliorata, è ancora una soluzione generale e c’è poca differenza nelle prestazioni della presentazione di immagini personalizzate e negli effetti fotografici computazionali tra piattaforme diverse.

Per i produttori di telefoni cellulari che perseguono costantemente la differenziazione, questo è tutt’altro che sufficiente, quindi i chip “extra” nei telefoni cellulari per la differenziazione dell’immagine sono molto comuni.

▲ vivo X70 Pro+ con ISP auto-sviluppato vivo V1 integrato.

Ad esempio, il Surging C1 sullo Xiaomi MIX FOLD, il V1 sulla serie vivo X70 e il chip Mariana X che apparirà presto sulla serie Find X5 avranno tutte le loro caratteristiche nell’immagine.

Ricordo che quando ho provato vivo X70 Pro+, sono rimasto profondamente colpito dai toni unici e dalle ottime prestazioni in condizioni di scarsa illuminazione. E quando l’immagine viene “calcolata” fotogramma per fotogramma, il chip aggiuntivo è più efficiente dal punto di vista energetico di quanto non sia e consente anche di risparmiare energia.

▲ La NPU Mariana X auto-sviluppata OPPO con grandi speranze Foto da: OPPO

Il chip Mariana X di OPPO risolve anche il problema della maggiore potenza di calcolo e dell’elevato rapporto di efficienza energetica per le immagini.

Con il miglioramento della potenza di calcolo del chip e il miglioramento degli algoritmi, in termini di effetto finale delle immagini dei telefoni cellulari, la fotografia computazionale, il machine deep learning e gli algoritmi di intelligenza artificiale porteranno cambiamenti più evidenti agli utenti ordinari.

▲ Sony Xperia Pro-I con sensore di immagine da un pollice integrato. Immagine da: Petapixel

Da 1/2,8 pollici a 1/1,12 pollici, o anche 1 pollice, in molte scene girate da telefoni cellulari, è difficile rilevare le modifiche senza un attento confronto.

Se si cambia il fotogramma di riferimento, è difficile per la gente comune distinguere la differenza tra le foto ottenute dalla fotocamera full frame e la fotocamera con cornice APS-C nella stessa scena con lo stesso obiettivo.

Il cosiddetto “la cosa più importante in fotografia è la testa dietro” probabilmente significa la stessa cosa.

Un chip ISP (o image NPU) indipendente e auto-sviluppato, o fotografia computazionale, risolve il problema della “testa sul retro”.

In questo momento in cui l’intelligenza artificiale è popolare, le specifiche hardware tradizionali sono più vicine alle “materie prime” di un piatto, mentre la fotografia computazionale è più simile a uno chef che può cucinare cinque cucine principali e cucinare in base alla stagione e all’umore. L’importanza non può essere sopravvalutata.

Vuoi padroneggiare la tecnologia di base

L’anno scorso è stato ufficialmente presentato il nuovo MacBook Pro dotato di chip auto-sviluppati M1 Pro e M1 Max, e anche il Google Pixel 6 Pro era dotato di un chip Tensor “auto-sviluppato”, mentre vivo V1, Surge P1, Mariana X anche lasciare vivo, Xiaomi, OPPO è stato coinvolto per la prima volta nella realizzazione di core.

▲ Tensore di Google.

Il movimento “core making” è diventato il tema principale dell’industria dell’elettronica di consumo nel 2021.

I chip della serie M di Apple sono noti per i loro elevati rapporti di efficienza energetica e si adattano bene all’hardware, formando una barriera ecologica con altri prodotti. Il Tensor del Pixel 6 Pro è anche legato in una certa misura ad Android 12, ma non ha ancora costituito una barriera.

▲ Il Tensor personalizzato di Google, combinato con Android 12, rende la serie Pixel 6 “il telefono Pixel più intelligente”.

Per quanto riguarda l’ISP personalizzato e la NPU dei produttori nazionali, sebbene il chip sia piccolo, è sufficiente per apportare alcuni vantaggi all’immagine e non esclude nemmeno la formazione finale delle barriere dei marchi.

Fin dall’apparizione della fotocamera sul cellulare, il suo sviluppo è esattamente lo stesso di quello dei tradizionali produttori di immagini.Base più grande, pixel più alti e apertura maggiore sono sempre stati il tema principale.Per questo motivo, la fotocamera è rialzata e occupa uno spazio considerevole nella macchina.

▲ Leitz Phone 1 con sensore di immagine da un pollice Immagine da: leica

Tuttavia, man mano che ci si avvicina al limite superiore, l’effetto marginale diventa sempre più evidente e il miglioramento dell’effetto di imaging non è più significativo.

Fino all’emergere della “fotografia computazionale” e dei chip ISP auto-sviluppati, la direzione dello sviluppo dell’imaging dei telefoni cellulari è stata completamente invertita e la fotografia computazionale guidata da algoritmi e apprendimento automatico sta diventando il principale campo di battaglia.

▲ Xiaomi 11 Ultra, Leitz Phone 1, iPhone 12 Pro Max. Immagine da: XDA

Il sensore della suola con volume e costo maggiori non è più la prima scelta dei produttori di telefoni cellulari, ma predilige il “tuning” del sensore, ovvero l’ottimizzazione dell’algoritmo basato su hardware maturo, e l’uso di chip di immagine indipendenti (ISP, NPU ) Crea barriere di immagine uniche.

È prevedibile che quando le leggi della fisica e dell’ottica non verranno infrante, quando il nuovo telefono verrà rilasciato nei prossimi anni, il focus dell’immagine sarà attorno all’intelligenza artificiale, all’apprendimento automatico, ai toni unici, alla messa a fuoco a velocità estrema e altro ” calcoli”. Le dimensioni e il modello diventeranno sempre più in diminuzione.

#Benvenuto a prestare attenzione all’account WeChat ufficiale di Aifaner: Aifaner (WeChat: ifanr), contenuti più interessanti ti verranno forniti il prima possibile.

Love Faner | Link originale · Visualizza commenti · Sina Weibo